Настройка смежных сервисов для работы с Archiving#

Настройка взаимодействия Archiving и АС Фоновые процессы (BGP)#

Для корректной работы Archiving, а именно - организации инициирующей выгрузки данных из БД прикладной фабрики в КАП, необходимо настроить взаимодействие с АС Фоновые процессы.

Для настройки необходимо в ТС SPAS контура добавить ТУЗ и ролевую модель, под которыми будет работать определенный адаптер Archiving, а также произвести настройку фоновых задач, в рамках которых будет производиться выгрузка.

Настройка ТУЗ и ролевых моделей для модулей BGP#

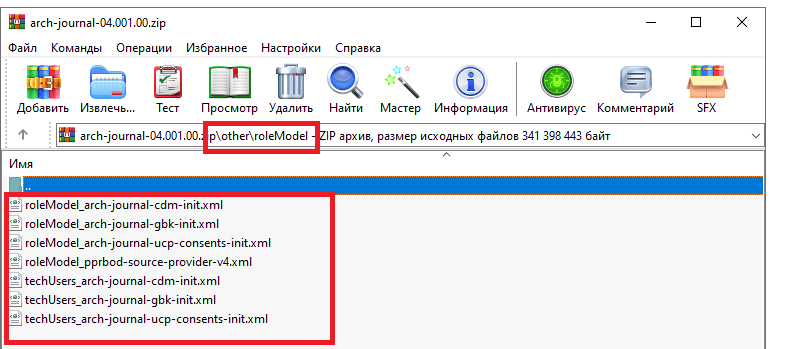

Файлы с настройками ТУЗ и ролевой модели для адаптеров Archiving размещены в каталоге other/roleModel дистрибутива Archiving.

Их необходимо импортировать в SPAS по инструкции, представленной далее.

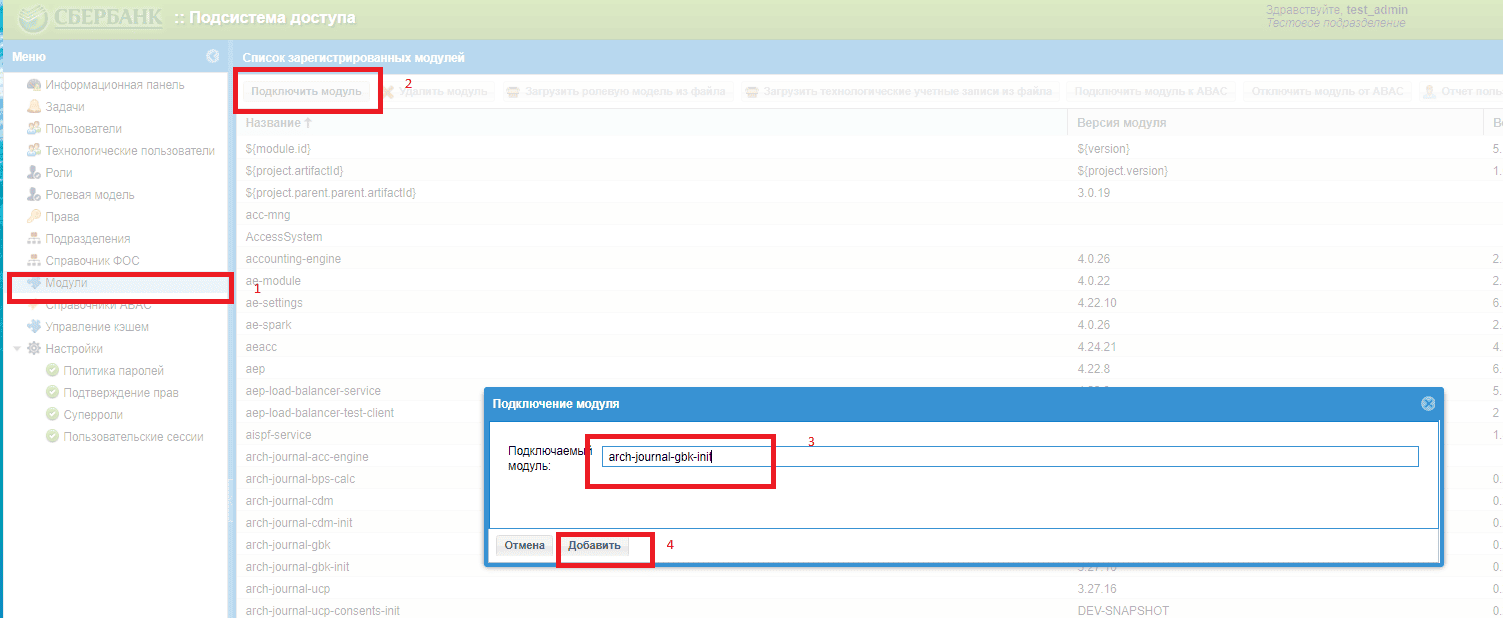

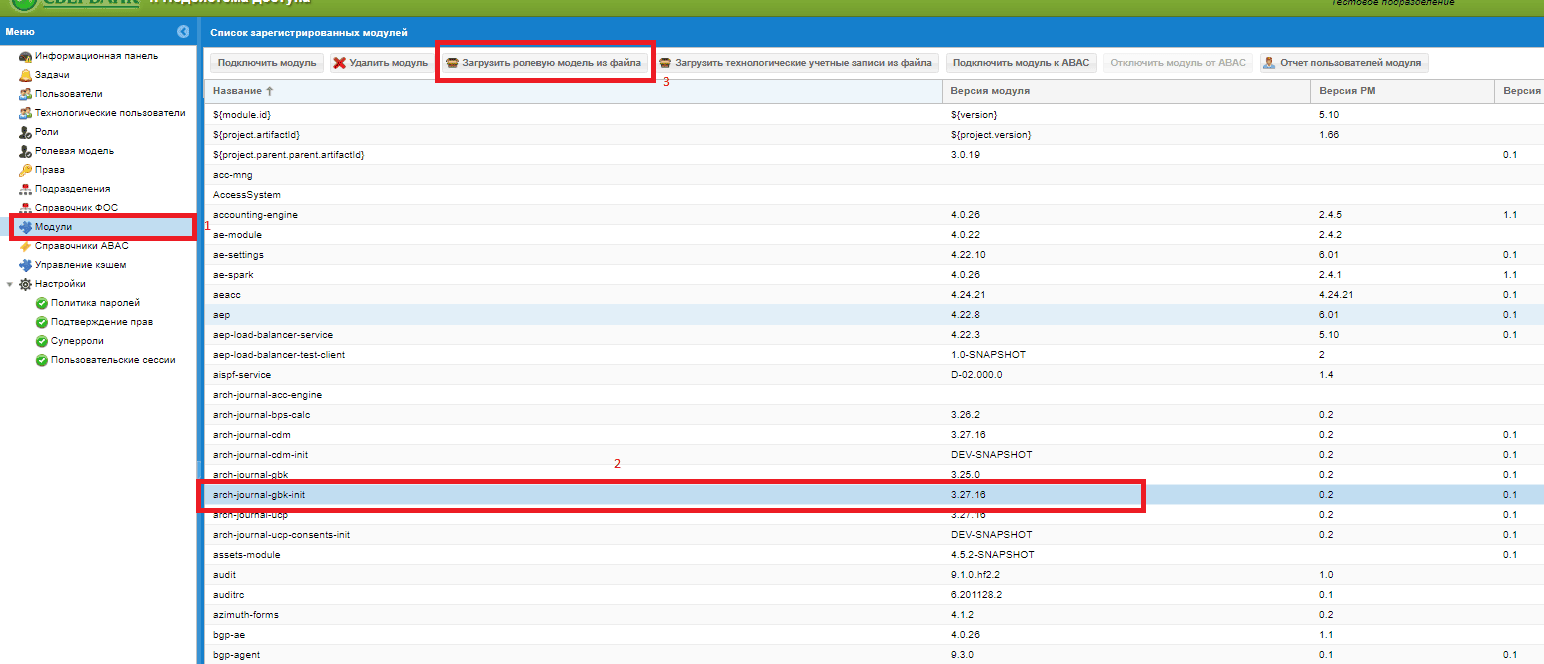

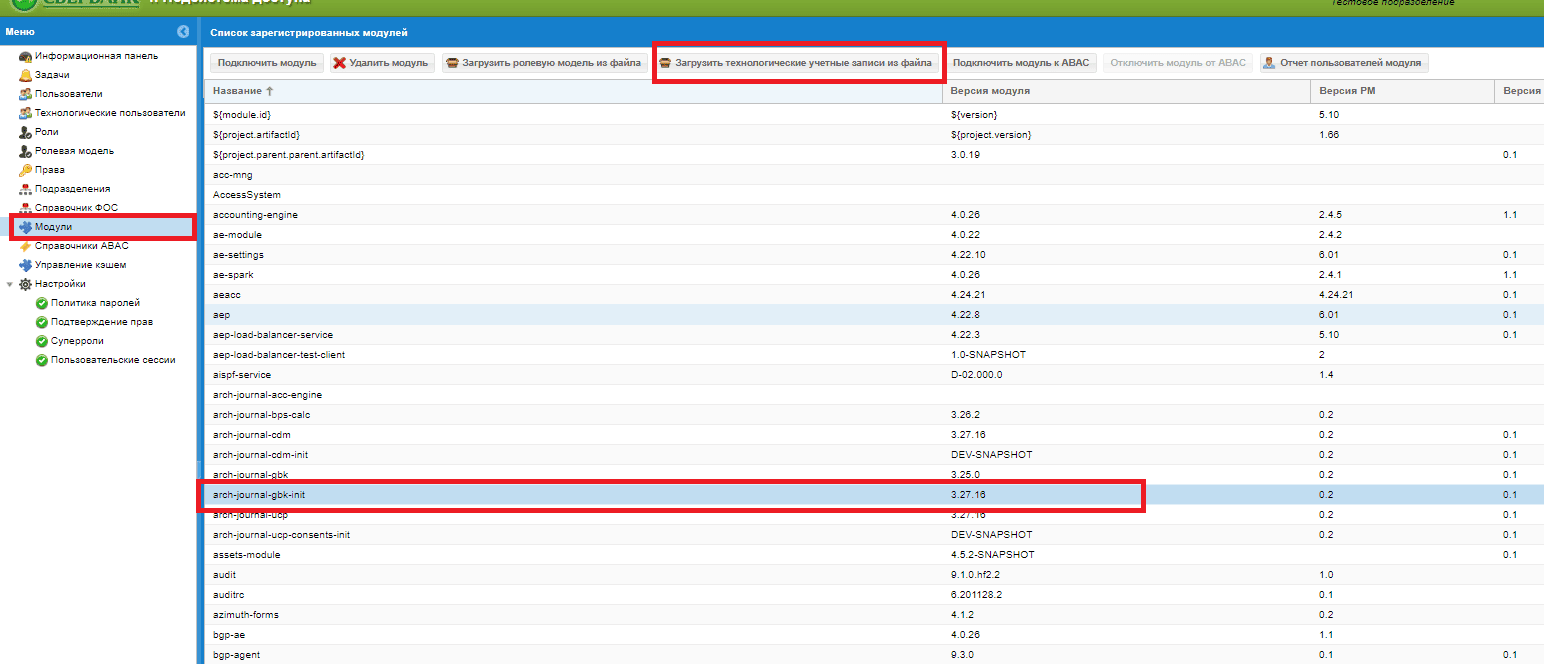

Настройка показана на примере адаптера arch-journal-gbk-init (адаптеры arch-journal-ucp-consents-init и arch-journal-cdm-init настраиваются аналогично).

Порядок настройки:

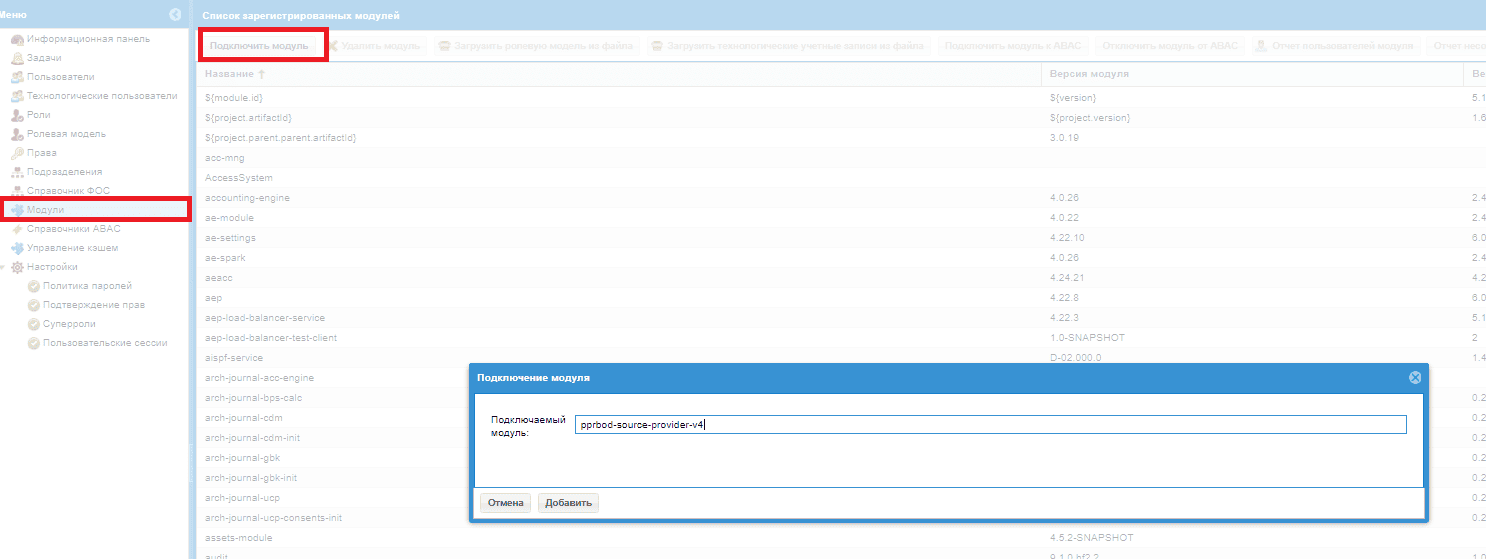

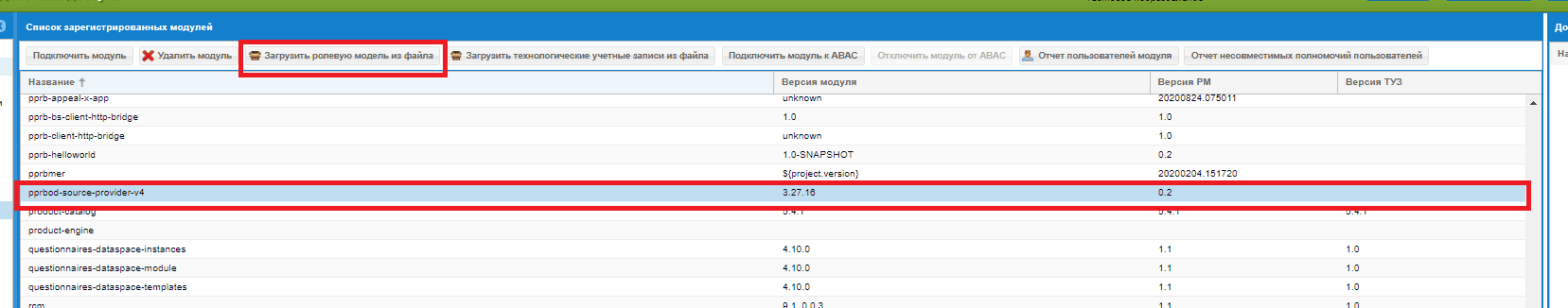

Добавьте модуль требуемого адаптера Archiving в SPAS.

Загрузите для него ролевую модель и список ТУЗов:

Пользователю, под которым будет осуществляться логин в UI ФП, добавьте 2 роли модуля bgp-master:

bgp-master_defaultBgpRole;bgp-master_<moduleId адаптера Archiving\>_bgp_access.

В данном примере — роль

bgp-master_arch-journal-gbk-init_bgp_access.То же самое выполните для:

arch-journal-cdm-init;arch-journal-ucp-consents-init;arch-journal-dataspace-init.

Настройка Фоновых процессов#

Чтобы пользователи имели возможность создавать Фоновые процессы (ФП) выгрузки данных, необходимо в АС Фоновые процессы добавить модули:

arch-journal-gbk-init,arch-journal-cdm-init,arch-journal-ucp-consents-init,arch-journal-dataspace-init.

В UI АС Фоновые процессы добавьте новый модуль:

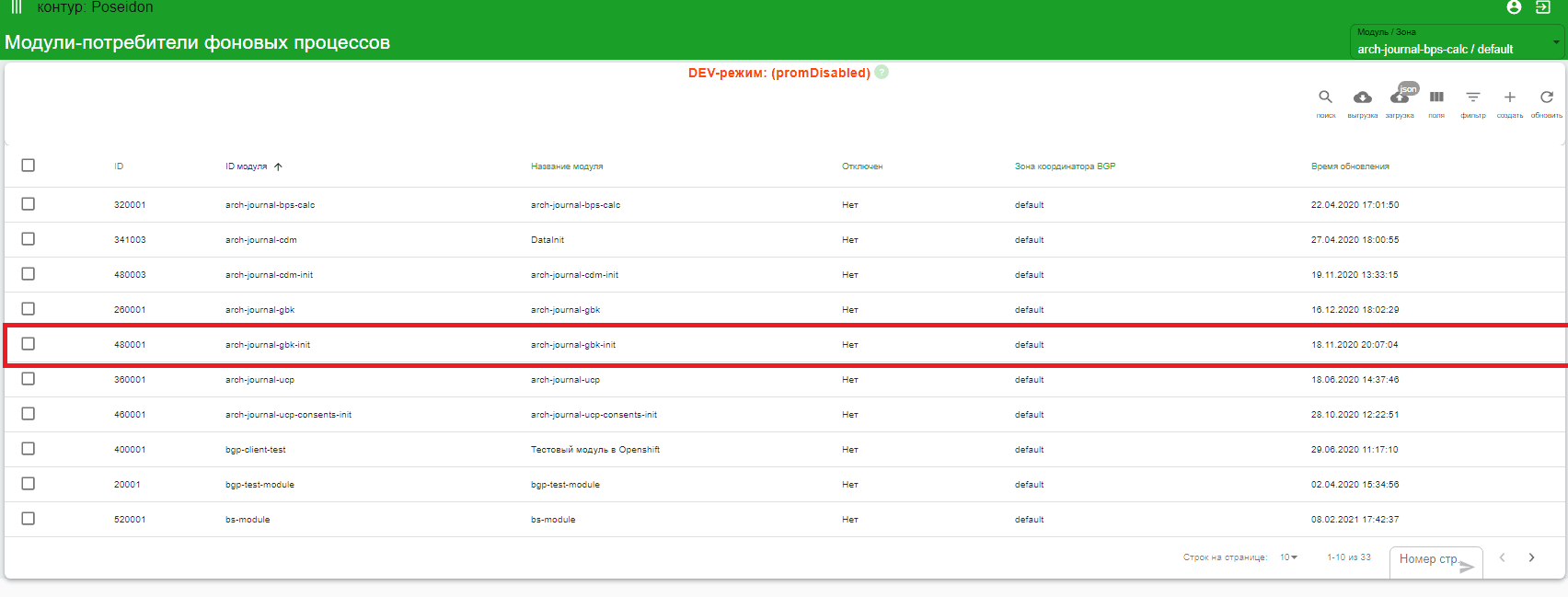

Авторизируйтесь в UI ФП и перейдите в меню Список модулей ФП. На экране будет отображен список существующих процессов.

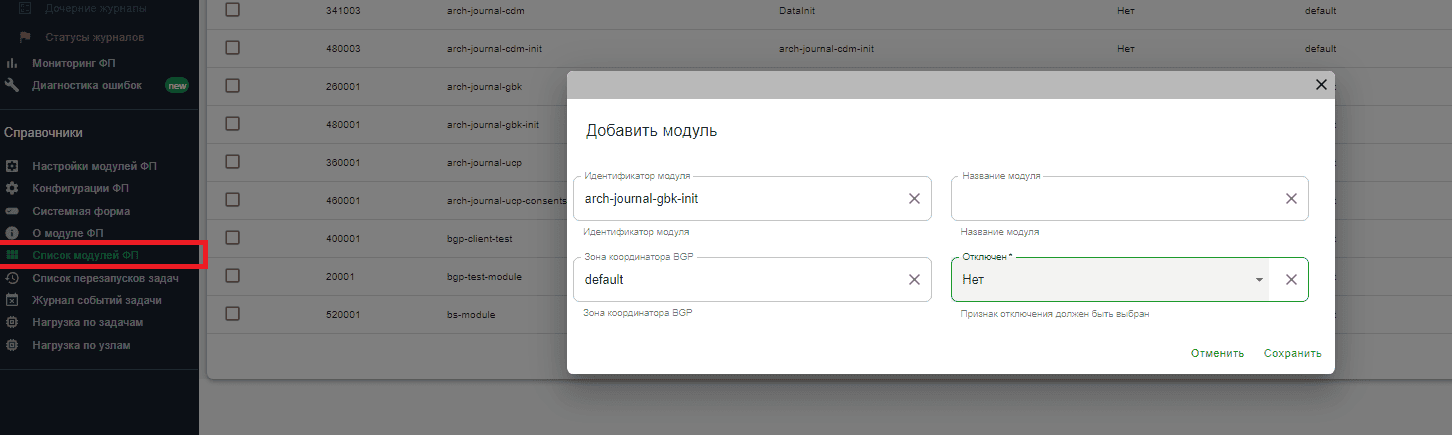

В верхнем меню нажмите Создать. Откроется окно Добавить модуль.

В поле Идентификатор модуля введите полное название модуля (

arch-journal-gbk-init/arch-journal-cdm-init/arch-journal-ucp-consents-init/arch-journal-dataspace-init).В поле Зона координатора BGP введите

default.В поле Отключен выберите

Нет.

Поле Название модуля можно оставить пустым или продублировать идентификатор модуля.

После ввода данных нажать Сохранить. В списке Модули-потребители фоновых процессов должен появиться новый модуль.

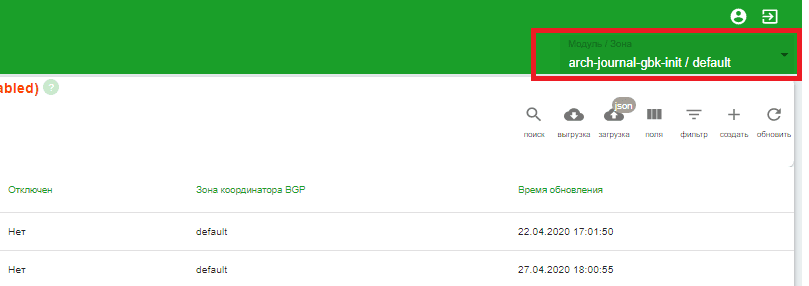

Подождите 5 минут (происходит синхронизация), затем авторизируйтесь заново в UI ФП. В выпадающем списке Модуль / Зона должен появится созданный ранее модуль.

Внимание!

Следующий пункт выполняется только для модулей, обслуживающих источники на БПС.Сделки (mega-bas). В составе Archiving это

arch-journal-cdm-init.

Если модуль используется для выгрузки данных источника, выгружающего данные через БПС.Сделки (mega-bas), необходимо провести дополнительную настройку:

Выполните (или убедитесь, что выполнены) все пункты из инструкции «Подготовка стенда для запуска фоновых процессов в модуле mega-bas».

Для начальной отправки данных источника через Archiving 4-й версии (вызов метода loadBatchAsync) загрузите на сервер BGP-задачу

LoadBatchAsyncReplication.json. Настройки задачи переопределять в общем случае не требуется. Все необходимые параметры передаются динамически.Для вызова функции обработки запроса ключей через Archiving 4-й версии (вызов метода getQualitySample) загрузите на сервер BGP-задачу:

getQualitySampleCloudReplication.json. Настройки задачи переопределять в общем случае не требуется. Все необходимые параметры передаются динамически.Для вызова функции обработки запроса сэмпла объектов через Archiving 4-й версии (вызов метода getQualityBatch) загрузите на сервер следующую BGP-задачу

getQualityBatchCloudReplication.json. Настройки задачи переопределять в общем случае не требуется. Все необходимые параметры передаются динамически

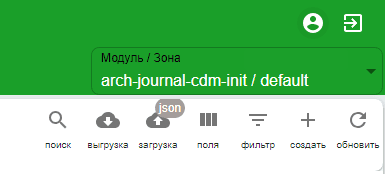

Наверху справа в выпадающем списке выберите необходимый модуль (в данном примере arch-journal-cdm-init):

Нажмите Загрузка и выберите один из необходимых шаблонов:

loadPartition.json;loadByKeys.json;loadRandom.json;LoadBatchAsyncReplication.json;getQualitySampleCloudReplication.json;getQualityBatchCloudReplication.json.

Конфигурация АС Фоновые процессы для взаимодействия с Archiving окончена. Дальнейшие настройки осуществляются под конкретную прикладную фабрику ее командой сопровождения.

Настройка DevOps конвеера#

Загрузите в SPAS ролевую модель

pprbod-source-provider-v4(входит в состав дистрибутива,other/roleModel/roleModel_pprbod-source-provider-v4.xml).Присвойте роль

source_creator_roleтем ТУЗ, под которыми будет выполняться конвейер Devops.

Получите доступ к проектной области в Jenkins (пример заявки ЗНО0122556821).

Закажите репозиторий для jsl библиотеки (пример запроса в СберДруг SD0152906511).

Получите доступ к этому репозиторию (пример запроса в СберДруг SD0153046000).

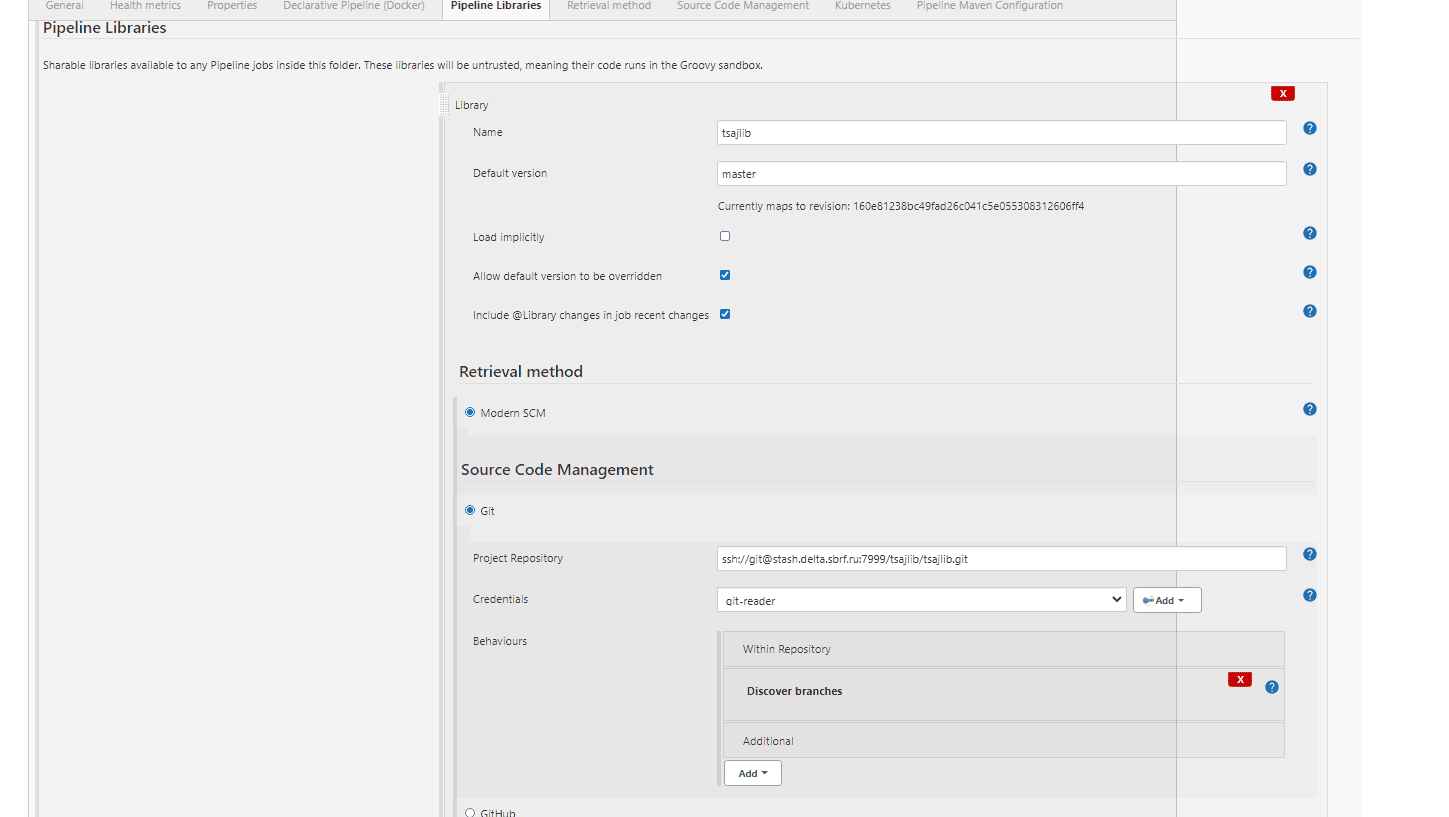

Выполните

pushв этот репозиторий код библиотеки tsajlib из нужной ветки.Настроить в полученной проектной области библиотеку tsajlib.

Создайте job в этой проектной области. Можно экспортировать как xml и импортировать.

Настройка логирования в Платформенном логере#

Рекомендуемые настройки логирования для Archiving 4 версии по умолчанию:

Категория |

console |

kafka |

rolling_file |

|---|---|---|---|

com.sbt.pprbod |

WARN |

WARN |

WARN |

com.sbt.pprbod.data |

INFO |

INFO |

INFO |

com.sbt.pprbod.raw |

INFO |

INFO |

INFO |

com.sbt.pprbod.transport_kafka |

INFO |

INFO |

INFO |

com.sbt.pprbod.dtoprovider |

INFO |

INFO |

INFO |

com.sbt.pprbod.offdq |

INFO |

INFO |

INFO |

com.sbt.pprbod.kafka |

INFO |

INFO |

INFO |

com.sbt.pprbod.journal |

INFO |

INFO |

INFO |

com.sbt.pprbod.exchange |

INFO |

INFO |

INFO |

Настройки логирования при диагностике функционала Archiving:

Вид диагностики |

Категория |

console |

kafka |

rolling_file |

|---|---|---|---|---|

Диагностика инициализирующей выгрузки |

com.sbt.pprbod.data |

DEBUG |

DEBUG |

INFO |

Для диагностики работы процессинга сырого топика |

com.sbt.pprbod.raw |

DEBUG |

DEBUG |

INFO |

Для диагностики протокола 4-3 |

com.sbt.pprbod.transport_kafka com.sbt.pprbod.exchange |

DEBUG |

DEBUG |

INFO |

Для диагностики DevOps и pprbod-source-provider-v4 |

com.sbt.pprbod.dtoprovider |

DEBUG |

DEBUG |

INFO |

Для диагностики работы оффлайн |

com.sbt.pprbod.offdq |

DEBUG |

DEBUG |

INFO |

Для диагностики работы с Kafka |

com.sbt.pprbod.kafka |

DEBUG |

DEBUG |

INFO |

Диагностика работы потока ПЖ |

com.sbt.pprbod.journal |

DEBUG |

DEBUG |

INFO |

После успешного выполнения всех шагов Archiving и его окружение готовы к работе.

Интеграция с СУДИР#

Интеграция с СУДИР осуществляется через HttpBridge, на который отправляются запросы, а он, в свою очередь, перенаправляет их на СУДИР.