Часто встречающиеся проблемы и пути их устранения#

Примечание

Для анализа проблем используются логи и метрики, полученные через JMX.

Анализ производительности в DataGrid#

Возможные причины проблем с производительностью:

Настройки операционной системы.

Настройки DataGrid или работа с данными.

Настройки JVM.

Иные причины во время эксплуатации (оборудование и прочее).

Аппаратные настройки.

При поиске проблем с производительностью стоит начать с первых трех пунктов.

Внимание

Настройки DataGrid для кластеров in-memory и persistence могут отличаться.

Шаг 1. Проверьте настройки ОС#

Цель: достичь максимальной производительности ОС.

Скорректируйте количество открытых файлов.

Это важно, так как если используется native persistence, каждая партиция является отдельным файлом на диске, и из-за установленного back-up фактора для кеша количество файлов партиций кратно увеличивается в DataGrid, поэтому на каком-то из узлов возникнет ошибка «Too many files».

Узнать количество открытых файлов на данный момент можно следующим образом:

cat /proc/sys/fs/file-nrВнимание

Не используйте команду

lsof | ws I, так как это завысит количество открытых файлов в данный момент и включит другие файлы, используемые другими процессами. Команду можно использовать только при постановке фильтрации по дубликатам.Ограничьте время использования сервера одним пользователем.

Для этого измените ограничение

open files (-n)в файле/etc/security/limits.conf;Запретите использование swap (подкачки) на узлах кластера, так как это приведет к ухудшению общей производительности системы.

В файле

etc/sysctl.confустановите параметрvm.swappiness=0.Примеры проверки использования swap:

free -h— наличие ненулевых значений говорит об использовании подкачки.swapon –show— наличие подкачки и ее характеристики.

Примечание

При отключении swap (подкачки) использование swapping для in-memory кластера DataGrid станет невозможным.

Примечание

Отключение swapping не используется по следующим причинам:

Нет сохранности данных между рестартами узла.

Низкая производительность.

Отключите transparent huge pages, SELinux, zeroconf, увеличьте до максимума значения буферов

rxиtxсетевых адаптеров, укажите в файле/etc/hostsIP-адреса и имена всех узлов кластера, чтобы исключить проблемы с DNS.

Для выдачи действующих параметров sysctl используйте команду:

sudo sysctl -a

Шаг 2. Проверьте работу DataGrid и работу с данными#

Проверьте выбранные таймауты, так как даже при небольших задержках они могут привести к проблемам, например, неправильная настройка

failureDetectionTimeoutможет привести к определению узла кластера какFAILED.Проверьте, используется ли Affinity Colocation там, где он может.

При активной работе с кешами Native Persistence (этот режим создавался для ситуаций, когда размер данных на узлах больше доступного объема ОЗУ) может возникать Page Replacement (вытеснение неиспользуемых страниц из ОЗУ и погрузка страниц с нужными данными с диска), что приводим к дополнительным накладным расходам.

Продукт использует сложную систему инициализации узлов кластера. Это означает, что настройки собираются из разных файлов и после обновлений механизм может перестать отлаженно работать, а узел - получить неправильные настройки.

Текущие настройки DataGrid видны в файле

ignite.logпри запуске узла:IgniteConfiguration,Data RegionsпослеTopology Snapshot.

Шаг 3. Проверьте настройки JVM#

Текущие настройки JVM видны в файле ignite.log при запуске узла: VM arguments на момент запуска. Можно искать JVM-опции в CommandLine flags в файле gc_server_memory.log, но вывод может быть неполным.

Шаг 4. Воспользуйтесь инструментами мониторинга#

Подробное описание метрик вы можете найти в разделе «События мониторинга» документа «Руководство по системному администрированию».

Zabbix

Система мониторинга статусов разнообразных сервисов компьютерной сети, серверов и сетевого оборудования. Осуществляет проверку доступности, производительности и сбор желаемых данных с использованием пользовательских интервалов. Поддерживает мониторинг с использованием SNMP, IPMI, JMX, VMware и пользовательских настроек.

Grafana

Open-source-система визуализации данных, направленная на данные систем ИТ-мониторинга. Позволяет исследовать метрики независимо от места их хранения. Zabbix может быть источником данных для Grafana, поэтому проблемы с Zabbix напрямую связаны отображением графиков и метрик в Grafana.

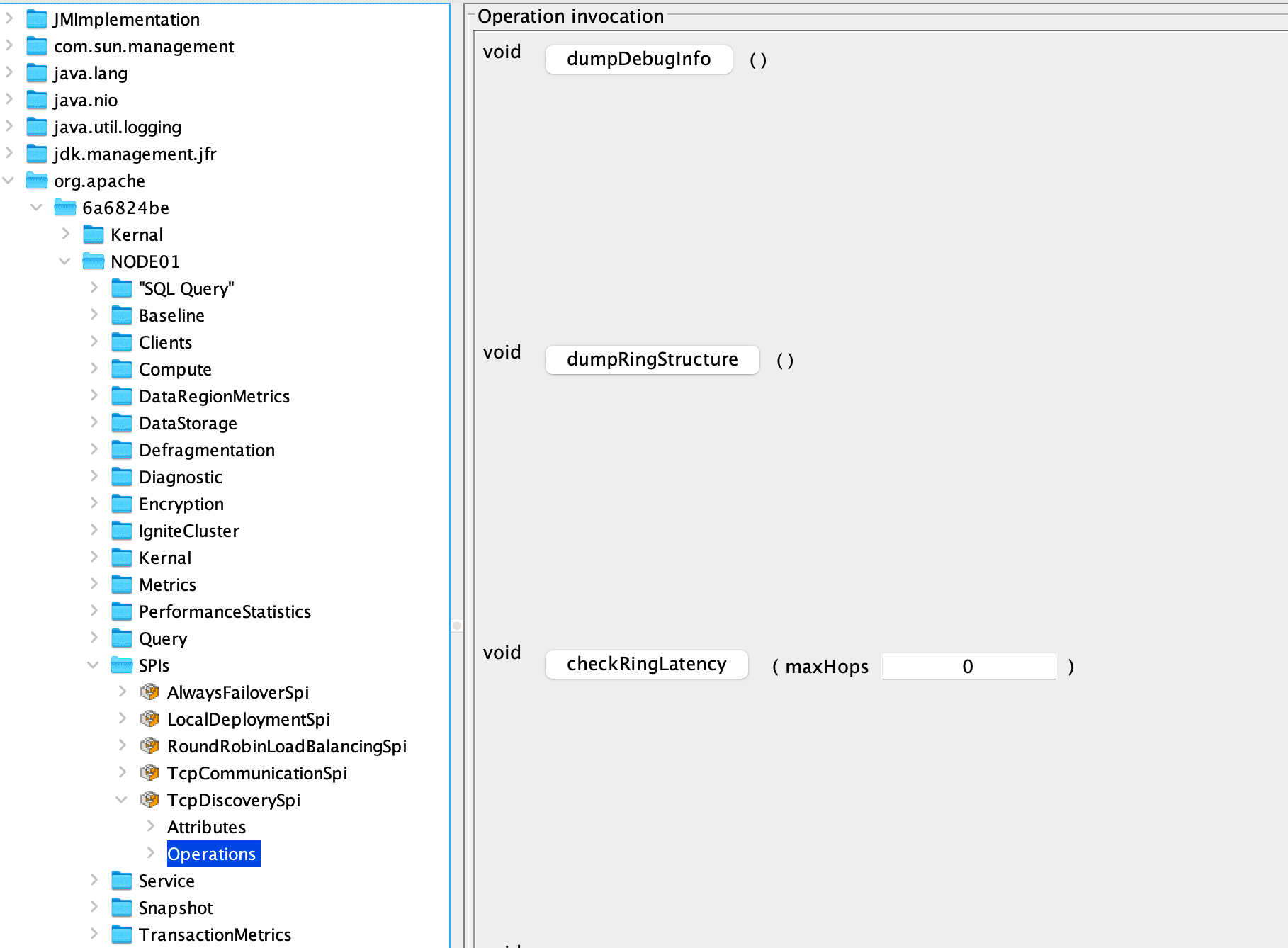

JMX

Метрики Java management extensions (JMX) — это технология мониторинга и управления Java-приложениями. Работает через объекты MBeans (Managed Beans). Использование JMX для больших экземпляров JIRA Server и JIRA Data Center позволит легко контролировать потребление ресурсов приложений. Мониторинг JMX-метрик может вестись через JConsole, Hyperic, Zabbix (с версии 2.0), GridGain Web Console, тд.

Подробнее о JMX метриках в Apache Ignite и о метриках через Zabbix. C версии Zabbix 2.0 был выпущен Java Zabbix demon. Когда сервер Zabbix захочет узнать значение конкретного счетчика JMX на узле, он спросит Zabbix Java gateway, который использует API управление JMX, запросить интересующее приложение удаленно.

jconsole

Инструмент с графическим интерфейсом для управления и мониторинга JVM (локальными и удаленными) и приложениями. Для получения подробной информации о графическом интерфейсе jconsole обратитесь к документации Oracle.

Context Switches per Second

Процесс прекращения выполнения процессором одной задачи (процесса, потока, нити) с сохранением всей необходимой информации и состояния, необходимых для последующего продолжения с прерванного места, восстановления и загрузки состояния задачи, к выполнению которой переходит процессор.

Единица измерения — количество переключений контекста в секунду.

В процедуру переключения контекста входит планирование задачи (какой задаче передать управление) и следующие аппаратные действия:

очистка конвейера команд и данных процессора;

очищается TLB, отвечающий за страничное отображение адресов на физические.

На состояние системы влияет содержимое кеша, особенно первого уровня, так как заточено под один поток и часто неприменимо к новому потоку, на который происходит переключение. При использовании swap (подкачки) при переключении контекста неиспользуемый процесс многих страниц может не находится в ОЗУ, что приводит к подкачке вытесненных страниц с диска.

Таким образом, переключение контекста очень ресурсоемко. При изучении метрик Context switches per second на графике обратите внимание на рост или резкое падение метрики:

рост — начало ресурсоемких операций на кластере (исполняющаяся задача на гриде, процедура ребалансировки, снятия снепшота, возросшая нагрузка в другом приложении в этом узле и прочее);

резкое падение — завершение тех или иных процессов.

Context switches говорит о росте нагрузки или увеличении числа активных потоков, но не говорит о корневых причинах, например, о процессах внутри приложения DataGrid или любого другого приложения на узле.

CheckPoint-операция, CheckPoint Time, CheckPoint Pages

CheckPoint-операция — сброс измененных страниц из памяти на диск.

CheckPoint Time — время выполнения операций CheckPoint для Native Persistence-кешей. Причины роста метрики:

рост количества записанных страниц при создании контрольной точки (CheckPoint);

повышенная нагрузка на диск;

проблемы с диском.

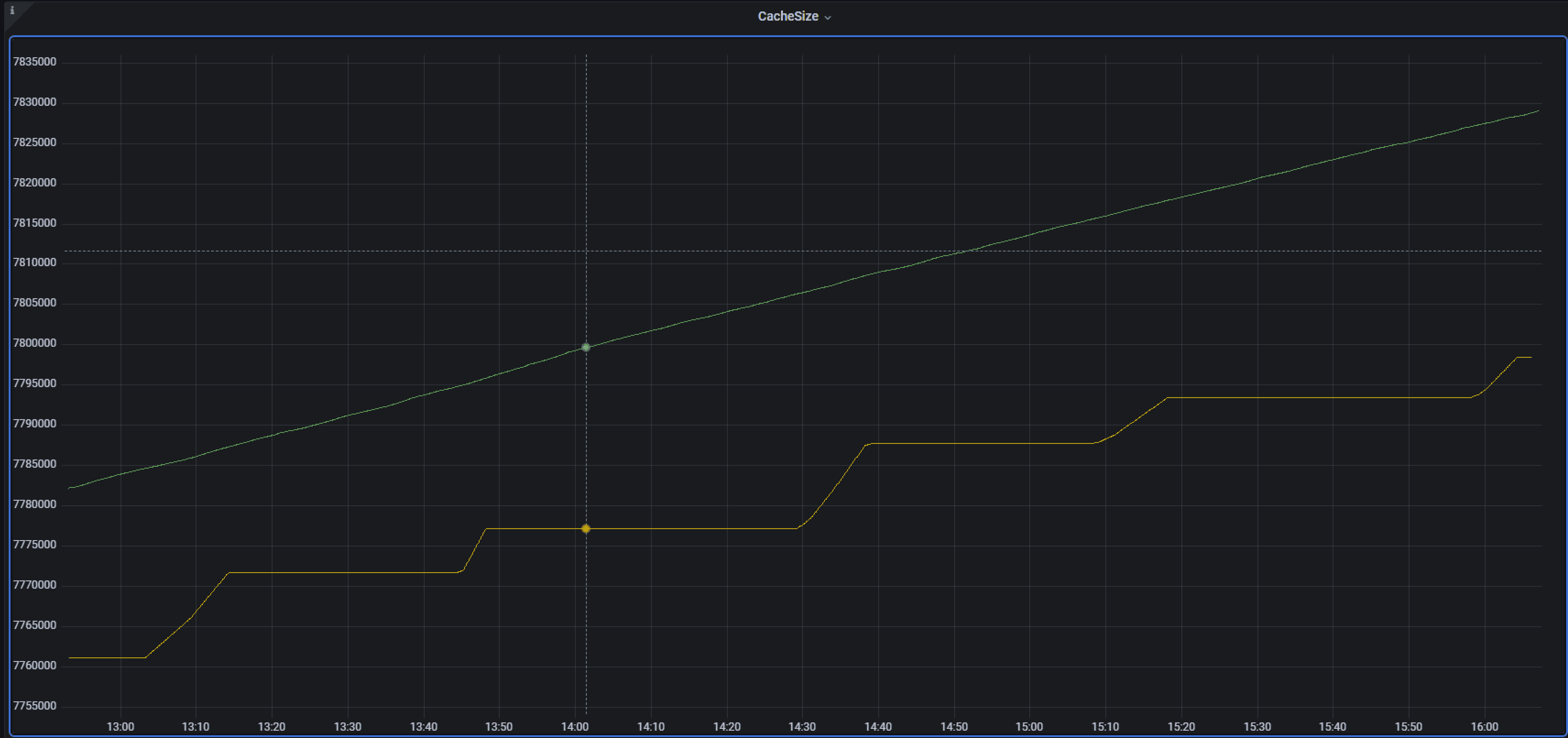

CheckPoint Pages — количество измененных страниц, требующих сохранения на диск. Перекос на графике показывает неравномерность распределения данных по серверным узлам, что означает наличие ошибок проектирования структуры данных, либо неправильное их распределение, например, проблема с пользовательской Affinity Function. Рост показателя или заметный перекос означает:

рост нагрузки на кластер по модификации данных;

ошибки проектирования структуры данных;

неправильное распределение структуры данных.

Чаще всего между CheckPoint Time и CheckPoint Pages есть связь, так как нужно больше времени для записи на диск большего числа страниц.

LRT (Long Running Transactions)

LRT — долго выполняющиеся в кластере транзакции. Они часто являются следствием проблем, вызванных следующими причинами:

повышенная загруженность узлов;

наличие сетевых проблем, приводящих к деградации вычислений;

прочие причины:

длительные GC-паузы на узлах;

неоптимальный код;

падение узлов.

JVM-опция IGNITE_LONG_OPERATIONS_DUMP_TIMEOUT отвечает за порог срабатывания для отпечатывания сообщения о наличии LRT в лог. Значение по умолчанию — 1 секунда.

Stop-the-World (STW)

Stop-the-World (STW) — период времени, в течение которого простаивают все процессы в JVM, кроме GC (очистки мусора). Это позволяет безопасно провести очистку мусора. STW используется для дефрагментации памяти и иных процессов. STW представляет собой GC-паузу, и приложение в эти моменты простаивает.

В HotSpot JVM механизмы паузы STW называются безопасной точкой, или Safepoint. Во время Safepoint все потоки, выполняющие код Java, приостановлены. Потоки, выполняющие собственный код, могут продолжать работать, пока они не взаимодействуют с JVM, так как попытка получить доступ к Java-объектам через JNI, вызвать java-метод или вернуться из собственного в java, приостановит поток до конца безопасной точки.

Проблема GC в ее длительности, которая может быть разной. Если длительность GC-пауз равна или превышает таймауты в настройках, то они ведут к возникновению дополнительных проблем. Например, превышение GC-паузой failureDetectionTimeout на одном из узлов приведет к потере этого узла в топологии, что сопоставимо с проблемой сетевой недоступности данного узла. Если DataGrid подвиснет снизит скорость работы на GC-паузе, он не сможет отвечать на запросы других узлов, что для них равно потере коммуникации с этим узлом.

При проблемах с производительностью в JVM стоит найти ту фазу GC, которая занимает большее время, и сопоставить эту информацию с целями анализа и конкретной ситуацией.

Внимание

Проблемы с длительностью GC-пауз часто встречаются при наличии большого heap.

Striped Executor Pool

Пул потоков executor, помогающий ускорить основные операции кеширования и транзакции, распределяя выполнение операций по не конкурирующим за ресурсы потокам. Размер пула равен max(8, общее количество ядер). Его можно изменять через IgniteConfiguration.setQueryThreadPoolSize(..).

Скачки на графике Striped Executor говорят об успешном обслуживании резко накопившейся очереди. Линейные графики с резким ростом, долгим линейным падением, линейным долгим ростом означают проблемы, так как очередь накапливается быстро, но не успевает быть быстро обслужена.

PME

PME (Partition Map Exchange) — процесс обмена информацией между узлами об актуальном состоянии партиций. Цель — установить актуальное состояние партиций для всех узлов кластера.

Exchange-процесс:

Узлы кластера отправляют свою локальную информацию узлу-координатору -

GridDhtPartitionsSingleMessage.Узел-координатор объединяет информацию о локальном разделе.

Узел-координатор строит карту партиций и отправляет ее остальным узлам, чтобы они знали, где искать ключи.

PME требуется при распределении партиций для любых изменений кеша, например:

создание индекса;

добавление новых узлов в топологию;

покидание топологии старыми узлами (запроса пользователя или сбой).

События топологии:

Обнаружение нового узла в топологии.

Внимание

Событие не запускает PME, если толстый клиент подключает кластер в версиях от 2.8 и выше;

Узел выбыл из топологии.

Внимание

Событие не запускает PME с версии 2.8 и позже, если узел покидает текущую топологию.

Node.FAILED— обнаружен не реагирующий узел.

Пользовательские события:

GlobalStateMessage— активация или деактивация базовой топологии;DynamicCacheChangeBatch— запуск или остановка динамического кеширования;SnapshotDiscoveryMessage— создание или восстановление снепшотов;WalStateAbstractMessage— включение или отключение global WAL;CacheAffinityChangeMessage— Late affinity assignment.

При запуске процесса PME кластер ожидает завершения выполнения всех транзакций и только потом начинает PME. Новые транзакции откладываются и ждут завершения PME.

Процесс PME работает следующим образом:

Узел-координатор запрашивает со всех узлов информацию о партициях, которыми они владеют.

Каждый узел отправляет эту информацию координатору.

При получении сообщений от всех узлов, узел-координатор объединяет информацию в полную карту партиций и отправляет ее на все узлы.

Когда узел-координатор получил подтверждающие сообщения от всех узлов, PME считается завершенным.

Длительность PME можно найти через Zabbix, записи о PME содержаться в классе GridMetricManager.

Query Execution

Если время фиксации проблемы слишком большое, то это может быть причиной или следствием проблем с производительностью. Часто такими проблемами являются FULL SCAN-запросы без использования индекса. Можно посмотреть в плане запроса.

TCPCommunicationSPI

SPI — Service Provider Interface — OutboundMessagesQueueSize — размер очереди исходящих сообщений с коммуникационными сообщениями, ожидающими отправки на другие узлы. Рост размера очереди TCPCommunicationSPI может говорить о проблеме. Одиночные пики проблемой не являются.

Bash (Bourne again shell) — прямой заход на узлы кластеров и выполнение нужных команд невозможно, поэтому информация по логам доступна по запросу с открытого тикета. Если логов много, хранить их в виде текстовых файлов неудобно, для их обработки и удобного вывода лучше использовать стек программ.

dmesg -T

dmesg — команда UNIX-подобных ОС для вывода буфера сообщений ядра в стандартный поток вывода, начиная с сообщения о загрузке ядра ОС в память компьютера, загрузке драйверов и так далее. Уровень детализации сообщений регулируется через параметры загрузчика. После полной загрузки сообщений в логи могут записываться дополнительные сообщения по диагностике, например, об ошибках I/O или при подключении устройств.

dmesg -T — выводит время в человекочитаемом формате;

dmesg –decode — выводит категорию и уровень журналирования в удобном для чтения формате, преобразуя числовое значение уровней загрузки и параметры операции в понятные текстовые примечания.

Изучая логи, смотрите на ошибки во время работы системы. При блокировке процесса выясните тип паузы, JVM или GC. Проверьте, есть ли аварийное завершение процесса по обрыву логов без видимой причины. Если да, найдите записи об OOM Error: kill process. Логи dmesg могут подсказать, где произведен запуск: на физическом сервере или на VM. Для этого найдите DMI, например, VMware Inc.

Java Flight Recorder (JFR)

Java Flight Recorder — файл с информацией по потокам, GC-паузам для дальнейшего анализа через JMC (Java Mission Control — подробно описано ниже). Подробнее о JFR читайте в документации Oracle.

JFR обязателен при принятии стенда на поддержку. Если со стороны DataGrid не снимается JFR, при повторных ситуациях снимите jstack последовательно со всех серверных узлов около 3 раз и включите эту информацию в тикет.

Чтобы использовать JFR для записи событий о работе Java в непрерывном режиме нужно указать в VM options XX:+UnlockCommercialFeatures и XX:+FlightRecorder.

Приложение pGraph позволяет представлять статистику nmon на графике по разрезам.

JFR управляется через jcmd. Он дублирует функционал других команд JDK и применим для запуска, остановки или сброса записей на диск. Он распечатывает текущие метрики, публикуемые в .jstat.

Дополнительную информацию вы можете найти в разделе TroubleShooting and Debugging официальной документации Apache Ignite.

Начните с General секции в JMC. Если есть данные о конкурирующих процессах или I/O предупреждениях, смотрите их позже, так как там содержится общая информация.

Получите сведения о системе через команды

dstatилиvmstat:dstat -ta --top-cpu --top-mem -m -s.vmstat -t 1.Проверьте загрузку процессора. Для этого воспользуйтесь командами

sysctl. Командаsysctl vmвыведет информацию только по VM.Проверьте swap настройки. Сверьте их с конфигурационными и рекомендуемыми настройками.

JCMD

JCMD — утилита, отправляющая запросы диагностических команд на работающую JVM. JCMD должен использоваться на той же машине, на которой работает JVM.

Java Mission Control (JMC)

Открывает .jfr-файлы, имеет шкалу времени для выбора периода визуализации и секции General, Memory, Code, Threads, I/O, System, Events.

General – overview: Heap Usage, CPU Usage, GC Pause Time – avg и max.

General – JVM: JVM start, JVM version, cmd lines аргументы JVM, JVM flags. До .jfr информация видна в ignite.log.

Memory – overview: Memory Usage с разбивкой по Memory (Physical, Used) и Heap (Commited, Reserved), GC configs, GC stats, Memory Allocation Summary.

Memory – GC: наличие и длительность GC-пауз, Heap (Commited, Used). Тип, GC Reason, GC ID, время начала и окончания, фазы GC, размер Heap до и после GC.

Memory – GC Times: длительность GC-пауз (время возникновения, длина). Pause Stats Info (avg, max, total), generation stats – young и old collection time.

Code – overview: общая информация по коду, сортировка по частоте использования в коде пакетов и классов – Hot Packages, Hot Classes.

Code – Hot Methods: дерево с указанием частоты использования методов. Полезно для поиска аномалии, зацикливаний в коде через время выполнения методов либо частоту использования.

Threads – overview: общая информация по потокам: CPU Usage, Thread Count, полезно для оценки загрузки процессора с Active Threads, Daemon Threads.

Threads – Hot Threads: часто используемая информация, показывает Java Thread ID, OS Thread Id – количество и процент использования, связь с Hot Methods.

Threads – Thread Dumps: полезно, если нет информации по TD.logs, можно получить расширенную информацию по Thread Dump, но нельзя копировать Thread, так как текстовый поиск отсутствует.

Threads – Lock Instances: полезна при поиске аномальной длительности блокировок (более часа), чтобы выяснить источники аномалий.

I/O: редко используется, так как редко где настроена, содержит статическую информацию по Input/Output.

System: редко используется, dmesg вывод, nmon — в логах, данные о системе, CPU, количестве ядер, о потоках, сокетах, размере физической памяти, ОС.

Events: почти не используется в анализе.

Sysstat

Пакет инструментов мониторинга производительности для Unix-подобных операционных систем. Логи хранятся в каталоге /var/log/sysstat/.

sar — сбор информации об активности системы, читает данные в формате saXX, получаемое от sa1.

iostat — отчеты об использовании CPU и статистика по I/O.

mpstat — глобальная статистика и отчеты по каждому процессу.

pidstat — отчеты по процессам в Linux.

sadf — генерирует отчеты от sar в различных форматах и визуализирует log.

nfsiostat — статистика I/O для сетевых файловых систем.

sadc — утилита сбора данных об активности системы, сохраняет их в файле в двоичном формате, по одному файлу каждые 24 часа, но можно настроить более частую периодичность, является надстройкой над sar.

sa1 — утилита по сбору, обработке и сохранению статистики в двоичном формате данных, использует sadc для этой цели, запускается через cron. На выходе имеем бинарный файл saXX, где XX — номер дня в месяце, что делает удобным поиск лога по нужной дате. Sar читает данные в формате saXX.

sa2 — утилита по сбору, обработке и сохранению статистики в текстовом формате, использует sadc для этой цели, запускается через cron. На выходе имеет текстовый файл в формате sarXX, который сохранен по тому же пути, что и saXX.

cifsiostat — отображает статистику операций чтения и записи в файловых системах CIFS.

Базовые проверки, нужные для выполнения#

Первые шаги#

Соберите подробную информацию о среде развертывания.

Проанализируйте возможную конкуренцию с другими VM за CPU и память, так как она может привести к падению производительности.

Уточните:

Размер кластера. Он должен быть больше одного узла и система должна быть распределенной.

Конкуренция за ресурсы отсутствует.

Количество узлов на физическую машину. В идеале DataGrid должен владеть всеми ресурсами, иначе нужно настроить высокую доступность и убедиться в тос, что нет копий (первичных и резервных) разделов на одних и тех же физических машинах. Производительность заранее проверяется при тестировании.

Количество процессоров.

Размер ОЗУ компьютера.

Диски. При включенном Native Persistence следует предпочесть SSD накопители вместо жестких дисков. Подробнее в разделе Настройка памяти и JVM официальной документации Apache Ignite.

Измерьте производительность, пропускную способность и выясните:

Операции, используемые потоками.

Информацию по типу кеша.

Информацию по JDBC, тонким и толстым клиентам.

Количество потоков, выполняющих операции.

Показатели, используемые для измерения производительности.

Выясните конфигурацию DataGrid, сравните все настройки использования. Обратитесь к архитектору решения, если нужно.

Запросите логи.

Изучите настройки JVM и запросите журналы GC для серверных и клиентских узлов.

Изучите план запросов при использовании SQL (Explain Analyze).

Если не получается найти узкое место при анализе информации выше, нужно переходить к поиску через другие диагностические инструменты, например, Java Flight Recorder (JFR). Подробное описание JFR содержится в соответствующем подразделе выше.

Анализ через диагностические инструменты#

Возможные источники проблем с производительностью делятся на три категории:

Проблемы с системой:

центральный процессор;

сеть;

диск;

системные ошибки;

ошибки с ОС.

Проблемы с JVM (GC и JVM паузы).

Проблемы продукта DataGrid:

ошибки в логах;

deadlock;

LRT;

checkpoints;

долго исполняющиеся scan-запросы;

исчерпание пулов.

Проблемы с системой

В первую очередь локализуйте проблему — удостоверьтесь, что проблема именно на стороне DataGrid, а не на стороне ОС или аппаратной части.

Например: узел выпал из топологии, появились LRT — причиной этого может быть проблема на аппаратном уровне, а не в DataGrid.

Внимание

Следует обращать внимание на Heap Utilization, Memory Utilization и CPU Utilization метрики. Максимальные значения представлены в Grafana в дашборде All Stands. При их завышении найдите выбивающийся узел через дашборд. Остальные метрики вы можете найти в Zabbix.

Heap Utilization — это процент использования heap, который, при прочих равных, составляет 35%. Процент использования heap выше 35% говорит о создании большого числа объектов, что может привести к росту GC-пауз, длительность которых напрямую зависит от процента использования heap (чем больше heap используется, тем дольше GC-паузы). Ситуация постепенно может привести к ошибке OOM (Out-Of-Memory Error) из-за нехватки Heap с одновременной невозможностью очистки через GC. Возможным выходом будет только перезапуск узла кластера. Heap Utilization можно найти через Zabbix, JFR, JMX (jconsole).

Внимание

Утилизация heap, которая не приводит к ошибке

OutOfMemoryError, и проблемой, по сути, не является. Утилизация выше 80% — нормальная ситуация, на некоторые стенды триггеры отключаются администраторами на 80%. Стоит пересмотреть конфигурацию мониторинга в 80%**.

Memory Utilization — процент использования памяти вне heap, или Off-Heap. GC не работает в Off-Heap, поэтому длительность GC-пауз на эту область не влияет. При работе в native persistence размер кеша может превысить выделенный размер ОЗУ и память уже заполнена LFS (large file storage). Тогда при запросе данных, которых нет в Off-Heap, они будут прочитаны с диска, что приведет к дополнительным накладным расходам, так как дисковая система работает сильно медленнее, чем ОЗУ, поэтому при Page Replacement дополнительные накладные расходы будут выше, если запрос на Page Replacement будет идти чаще.

CPU Utilization — процент использования ЦП. При прочих равных, он равен 6-7%. Если ЦП используется более, чем на 20%, то это говорит о большой нагрузке на сеть данных, возможно из-за снятия снепшотов, либо других операций в сети данных, либо из-за работы каких-либо процессов, не связанных с сетью, но происходящих в ОС узла. В этом случае, необходимо понимать, какое приложение приводит к увеличению процента использования ЦП.

ps aux— текущее состояние процессов выполнения их системы;ps aux --sort -pcpu— текущее состояние с sort по использованию ЦП;ps aux --sort -rss— текущее состояние с sort по резидентной памяти;ps aux --sort -vsz— текущее состояние с sort по виртуальной памяти;ps aux --sort -pmem— текущее состояние с sort по использованию ОЗУ.

Будет полезно воспользоваться командой top. Эта команда в реальном времени выводит информацию об использовании ЦП. Если просуммировать все значения, то итоговое значение будет равно 100%. Информация из top сортируема. Для сортировке используйте команды:

M — по потреблению памяти;

P — по потреблению ресурсов процессора;

T — по времени активности;

O — для фильтрации данных.

Если работа узла нестабильна:

система начинает неожиданно зависать;

при запуске нескольких программ, некоторые из них падают с Error;

файл или архив то успешно открывается, то указывается, что он поврежден;

при виртуализации проблема происходит с одним из контейнеров.

Проблемы могут быть вызваны планкой памяти, что сложно узнать из анализа логов. Проверен запуск memtest86+ для подробной проверки ячеек памяти. Проверка идет оффлайн и долго, планка памяти должна быть заменена при наличии хотя бы одной ошибки.

Свободное место на диске, или free disk space, можно увидеть в Zabbix, Grafana, в выводе df -h (свободное место на диске) и df -ih (количество оставшихся inode). Если inode нет, то это как нехватка места на диске, то есть система не может записать на диск. Возможно, что места под файлы достаточно, что покажет df -h, как свободное место на диске, но для записи новых файлов свободных дескрипторов файловой системы нет.

Примечание

Чаще всего это может происходить из-за разрастающихся логов, поэтому нужно удалять устаревшие.

inode – структура данных, хранящая данные о файле или каталоге в файловой системе.

Падение производительности может быть связано с Disk utilization. Напрямую через Grafana и Zabbix это не увидеть, но можно предположить по косвенным признакам: рост CheckPoint Time при тех же CheckPoint Pages. Альтернативой Zabbix будет запрос sar-файлов и, при возможности, запустить iostat -xz для отображения статистики по дисковой подсистеме.

Кроме этого, падение производительности может быть вызвано и ошибками дисковой подсистемы. Внесение обновлений в ядро может привести к ошибкам с XFS (высокопроизводительной журналируемой файловой системой). Тогда узлы кластера могут покидать топологию, так как на уровне ОС произошла потеря диски с XFS. Чтобы убедиться, что проблема с оборудованием, нужно искать ошибки в выводе команды dmesg -T.

Проверка фактов разрыва соединения сетевых интерфейсов может производиться через dmesg -T. Факт разрыва соединения проявится в выводе.

Ошибки на интерфейсах можно найти через команду ip -s addr или ip -a -d -s link.

Для проверки наличия сетевых проблем обратитесь к сетевым инженерам, которые проверят ошибки и разрывы соединения на портах коммутатора. Они могут быть вызваны проблемами с DNS серверами, если в hosts не прописаны узлы кластера.

Проблемы с JVM (GC и JVM паузы)

Рост показателя Heap Utilization % приводит к учащению GC и увеличению GC-пауз. JVM-паузы происходят, когда JVM ожидает от ОС завершения процессов, например, при работе с файлами JVM в случае высокой нагрузки на диск, происходят сбои диска. Они приводят к задержке I/O операций, возникновению проблем с сетью и так далее. Для мониторинга этого показателя используйте Zabbix, Grafana, а также файл ignite.log.

Для выявления типа паузы (GC- или JVM-пауза) используйте файл gc.log. В этом файле необходимо смотреть записи real= в реальном времени, отвечающие за длительность паузы соответствующего узла. Если поиск не выдаст результатов или если время записи в лог не совпадает с Possible too long JVM pause из файла ignite.log, то это JVM-пауза. Чтобы в этом убедиться, стоит запросить и изучить JFR c узла. Если в них за период возникновения записей по логу ignite.log не будет сведений и все графики — прямая от точки начала паузы до ее конца, то это подтвердит наличие JVM паузы.

Если же и в gc.log, и в ignite.log есть записи о паузе, то это GC-пауза. Для поиска причин следует изучить JFR с узла и смотрим на threads, memory usage, stacktrace.

Внимание

Часто выявляется проблема больших GC при большом Disk Utilization, например, при запуске снятия снепшота. Причина: неоптимальная конфигурация дисковой подсистемы. Разделы в массиве дисков используются одновременно для операций random write при запуске снепшота и для работы тома с ОС, там же происходят и множество I/O операций, кроме этого туда записывает свое состояние JVM (GC, Safepoint и прочие).

Рекомендуется разделять том ОС и том для снепшотов на разные массивы дисков и использовать tmpfs для информации с JVM.

Проблемы с продуктом DataGrid

Возможны следующие проблемы, связанные с продуктом:

ошибки в логах;

deadlock;

LRT;

checkpoints;

долго исполняющиеся scan-запросы;

исчерпание пулов.

Описание и методы устранения приводятся ниже.

Используемая фактура#

Для анализа проблемы используются логи и метрики, отдаваемые через JMX (описание метрик приводится в разделе «События мониторинга» настоящего документа).

Сбор фактуры#

При эксплуатации DataGrid может сложиться ситуация, когда будет необходим доступ к отладочной информации (отладка в dev-средах, сбои при введении в промышленную эксплуатацию и так далее). В настоящем разделе описано, где можно искать различную отладочную информацию, как настроить сбор этой информации или собрать ее вручную. Также коротко описано, для чего собирается тот или иной тип отладочной информации.

Корректный сбор log-файлов#

Время, потраченное на анализ проблемы, и результат этого анализа напрямую зависят от полноты log-файлов. Проверьте, что log-файлы собраны:

со всех узлов кластера — серверных и клиентских. Это требование связано с особенностями распределенной системы DataGrid, в которой для анализа проблемы недостаточно собрать log-файлы только с проблемного узла;

с момента старта узла и до момента воспроизведения проблемы. Это позволит включить в выборку предупреждения, предшествовавшие возникновению проблемы, а также дополнительную информацию о конфигурации узла.

Местоположение основных log-файлов DataGrid настраивается через переменную окружения IGNITE_LOG_DIR. По умолчанию log-файлы располагаются в $IGNITE_HOME/work/log.

В DataGrid по умолчанию включен режим IGNITE_QUIET, который сообщает о минимуме событий. Для расширенного логирования используйте JVM-опцию IGNITE_QUIET=false.

Основные log-файлы

log-файл |

Как настроить |

Где находится |

|---|---|---|

|

Не требуют настройки |

|

|

Используйте переменную окружения |

В |

|

Используйте JVM-опции: |

Путь к JVM-опциям: |

|

Используйте JVM-опции: |

Путь указан в JVM-опциях |

|

Используйте JVM-опции: |

Путь указан в JVM-опциях |

|

Дефолтный log-файл на linux-системах; не требует настройки |

|

|

Не требует настройки |

|

|

Для настройки частоты сбора статистики используйте утилиту |

|

|

Используйте утилиту jmap: |

Укажите путь для сохранения log-файла внутри атрибута |

|

Вручную с помощью утилиты |

— |

|

Не требует настройки |

|

|

Создается автоматически, если указана JVM-опция |

— |

Log-файлы console.out и console.err#

Текстовые файлы, обычно небольшого объема. В файлы console.out и console.err перенаправляются потоки stdout и stderr до того момента, пока DataGrid не запустит logger, настроенный в конфигурации продукта. Сюда попадает отладочная информация до запуска DataGrid, например, информация о причине падения JVM и о неполадках в момент запуска DataGrid, например, ошибки чтения конфигурации продукта.

Файлы console.out и console.err генерируются автоматически, дополнительная настройка не требуется.

Log-файл ignite.log#

Основной log-файл приложения DataGrid для первичного анализа проблем и поиска причин их возникновения. Формат файла — текстовый, часто довольно объемный. Содержит отладочную информацию о работе DataGrid с момента запуска logger и до момента остановки/прерывания работы узла. Анализ любых проблем стоит начинать именно с файла ignite.log.

Где находятся

По умолчанию log-файлы ignite.log располагаются в $IGNITE_HOME/work/log.

Как настроить ignite.log

За настройку отвечает отдельный logger, который записывает данные в ignite.log.

Как настроить logger

В конфигурации DataGrid можно настроить logger, который будет использоваться для записи и ротации log-файлов. Рекомендуется использовать файл log4j2 (см. пример файла). Для его включения в конфигурацию DataGrid нужно добавить bean:

<bean class="org.apache.ignite.configuration.IgniteConfiguration" id="ignite.cfg">

<property name="gridLogger">

<bean class="org.apache.ignite.logger.log4j2.Log4J2Logger">

<!-- log4j2 configuration file -->

<constructor-arg type="java.lang.String" value="log4j2-config.xml"/>

</bean>

</property>

<!-- other properties -->

</bean>

В примере выше log4j2-config.xml — файл конфигурации logger log4j2. Пример конфигурации log4j2 можно найти в каталоге $IGNITE_HOME/config/, который поставляется с продуктом.

Как настроить debug level

По умолчанию в log-файл попадают сообщения уровня WARN и ERROR, но иногда требуется включить сообщения DEBUG на том или ином пакете. Если используется log4j2, в секцию Loggers конфигурации log4j2 можно добавить следующую строку:

<Logger name="org.apache.ignite.internal.processors.odbc" level="DEBUG"/>

В примере выше в переменную name передается имя пакета, для которого требуется включить расширенное логирование.

Как настроить debug SSL

Включение отладочной информации для SSL полезно для установления причины сбоя. Для этого при запуске узла нужно добавить jvm-опцию:

-Djavax.net.debug=ssl,handshake

Log-файл gc.log#

Файл gc.log содержит информацию о работе Garbage Collector. Информация полезна при анализе проблем, связанных с утечками памяти, долгими GC-паузами и проблемами производительности.

В частности, файл gc.log позволяет определять долгие GC-паузы и время их возникновения. Пример команды для определения пауз длиной от 1 секунды:

`grep -P 'real=[1-9]+' имя_gc-лога'

Формат файла — текстовый, часто довольно объемный. Для анализа gc.log существуют специализированные утилиты и сервисы.

Как настроить

GC-логирование настраивается через JVM-опции. Для разных версий Java набор опций будет разным.

Параметры Oracle/Openjdk Java 8

Параметр |

Описание |

|---|---|

|

Вывод гистограммы классов перед Full GC |

|

Вывод гистограммы классов после Full GC |

|

Вывод log-файла GC |

|

Вывод подробной информации о GC-log |

|

Вывод даты в GC-log |

|

Вывод времени в GC-log |

|

Количество времени, в течение которого приложение было остановлено в safepoint |

|

Включение ротации GC-logs |

|

Вывод распределения объектов по возрасту |

|

Путь до GC-logs |

|

Количество GC-logs в ротации |

|

Размер GC-log, после достижения которого будет происходить ротация |

|

Установка уровня логирования G1 |

|

Логирование выделения памяти под Humongous-объекты |

|

Вывод подробностей о Humongous-объектах во время GC |

|

Вывод статистики по safepoint |

|

Количество записей в последнем отчете safepoint |

Параметры Openjdk Java 11

Параметр |

Описание |

|---|---|

|

Настройка GC-log, детализация, ротация |

|

Настройка safepoint-log, детализация |

Log-файл safepoint.log#

Формат файла — текстовый, часто довольно объемный. Содержит информацию об аргументах JVM safepoint, глобальных флагах и потоках, которая может быть полезна при анализе проблем, связанных с долгими GC-паузами.

Как настроить

Настройки для safepoint.log (Oracle/Openjdk Java 8 и Openjdk Java 11) перечислены в таблице «Основные log-файлы».

Log-файл JFR#

Log-файл генерируется при помощи Java Flight Recorder — механизма легковесного профилирования Java-приложения. Имеет собственный формат. Для просмотра и анализа используется Java Mission Control.

Механизм JFR позволяет записывать и впоследствии анализировать огромное количество метрик и событий, происходящих внутри JVM, что значительно облегчает анализ различных проблем. Что именно окажется в файле, зависит от настроек JFR в каждом конкретном случае.

Как настроить

Запись JFR настраивается через jvm-опции. Для разных версий Java набор опций будет разным.

Настройка JFR с помощью параметров Oracle

Параметр |

Описание |

|---|---|

|

Включение коммерческой функциональности |

|

Разрешение на использование JFR |

|

JFR при запуске JVM будут записываться на диск. Параметрами можно регулировать глубину хранения и детализацию JFR |

Настройка JFR с помощью параметров Openjdk

Параметр |

Описание |

|---|---|

|

Активирует JFR и определяет основные параметры его работы |

|

Задает дополнительные параметры работы |

Log-файл /var/log/dmesg#

Дефолтный log-файл на linux-системах. Для корректного просмотра /var/log/dmesg используйте утилиту dmesg -T. Флаг -T включает удобочитаемый формат времени при выводе log-файла.

Log-файл nmon#

Отображает статистику производительности (использование ЦП и памяти, состояние ядра, очередь выполнения и так далее) на экране либо в файле данных значений для последующего поиска узких мест.

Для просмотра nmon-файлов используйте утилиту NMONVisualizer.

Log-файл heap dump#

Бинарный файл, размер которого примерно соответствует размеру heap на момент снятия heap dump. Файл содержит моментальный снимок java heap. Такой снимок содержит низкоуровневую информацию о Java-объектах и классах, размещенных в java heap. Для анализа heap dump используйте утилиты jhat или mat.

Log-файл heap dump необходимо снимать вручную. Самый распространенный способ — при помощи утилиты jmap:

jmap -dump:format=b,file=filename <pid>

В атрибуте file=filename <pid> укажите нужный путь для сохранения log-файла.

Примечание

Эта команда ресурсозатратна и может приводить к негативным эффектам при выполнении на работающем под нагрузкой кластере.

Log-файл thread dump#

Формат файла — текстовый. Содержит информацию о потоках внутри jvm.

Как настроить

Собирается вручную:

jstack -l <pid> > thread_dump.txt

Log-файл sar#

Входит в sysstat — пакет инструментов мониторинга производительности для unix-систем. Log-файл sar отвечает за сбор информации об активности системы и читает данные в формате saXX, получаемые от sa1.

WAL и WAL-архив#

Дополнительно для анализа проблем в случае сбоев могут пригодиться следующие каталоги: WAL и WAL-архив. По умолчанию эти каталоги создаются автоматически.

Проблемы и их решения#

Лишние узлы в топологии#

При использовании поискового механизма Multicast в топологии могут быть обнаружены лишние узлы. Проблема возникает:

при запуске нового кластера, в котором версия топологии отличается от «1»;

при добавлении в топологию новых узлов; для решения этой проблемы сконфигурируйте Security Plugin (рекомендованный способ) или воспользуйтесь SSL-протоколом (в случае, если невозможна настройка через Security Plugin).

Проверить количество узлов в топологии можно двумя способами:

через heartbeat-сообщение в log-файле

ignite.log, в котором записывается количество узлов (hosts).Пример heartbeat-сообщения:

Cluster [hosts=6, CPUs=9, servers=1, clients=5, topVer=10, minorTopVer=0];через консоль control.sh с помощью команды

--baseline; выполнение команды вернетconsistency idузлов в топологии, по которым можно обнаружить лишний узел.

Для решения проблемы сконфигурируйте класс TcpDiscoveryVmIpFinder в конфигурационном файле DataGrid:

```xml

<bean class="org.apache.ignite.spi.discovery.tcp.ipfinder.vm.TcpDiscoveryVmIpFinder">

<property name="addresses">

<list>

<value>127.0.0.1:47500..47509</value>

</list>

</property>

</bean>

```

Долгий запуск первого узла в топологии#

При данной проблеме:

время запуска первого узла критически увеличено;

после запуска узла дальнейших проблем не наблюдается.

Проблема возникает при большом количестве адресов, так как DataGrid сканирует все заданные порты. При включенной защите от port scanning может не приходить сообщение

Connection refused.Время открытия одного порта по умолчанию составляет 10 секунд. Если у вас 3 адреса и по 10 портов на один адрес, как в примере ниже, время запуска составит 5 минут:

<bean class="org.apache.ignite.spi.discovery.tcp.ipfinder.vm.TcpDiscoveryVmIpFinder"> <property name="addresses"> <list> <value>ignite1.local.net:47500..47509</value> <value>ignite2.local.net:47500..47509</value> <value>ignite3.local.net:47500..47509</value> </list> </property> </bean>DataGrid сканирует все заданные порты:

connection refused может не прийти (защита от port scanning);

ожидание открытия порта по умолчанию - 10 секунд;

3 адреса * 10 портов * 10 секунд = 5 минут.

Высокое значение

IgniteConfiguration.failureDetectionTimeout.Для решения этой проблемы не прописывайте лишние порты, укажите только те порты и адреса, которые вы используете. Дополнительно можно отключить защиту от port scanning во внутренней сети.

Стоит снизить значение

failureDetectionTimeout, чтобы сканирование через IP Finder происходило быстрее.

Проблемы при использовании IPv6#

По умолчанию, решения DataGrid тестируются с использованием четвертой версии интернет-протокола IPv4. При передаче данных с использованием шестой версии интернет-протокола IPv6 (Internet Protocol version 6) могут возникать сетевые ошибки, о которых свидетельствуют сообщения в log-файлах:

Failed to connect to address;Node SEGMENTED;Failed to send message to remote node.

Помимо указанных выше ошибок, могут возникать другие симптомы проблемы, связанной с невозможностью передачи данных. Эта проблема может быть вызвана смешанным окружением IPv4 и IPv6, когда начинает использоваться шестая версия интернет-протокола вместо четвертой.

Для решения конфликта между версиями установите значение true для параметра -Djava.net.preferIPv4Stack в конфигурационном файле Ignite-SE-15.0.0/config/jvm.opts .

Проблемы с маршалингом или сериализацией#

При взаимодействии продуктового кода с кодом DataGrid происходит сериализация. Это процесс, при котором продуктовый код преобразуется в формат, пригодный для хранения или передачи. Подробнее о сериализации см. в разделе «Термины и определения»

При записи данных в память для их дальнейшего использования DataGrid производит сериализацию объектов с помощью трех механизмов:

JDK Marshaller— обычная Java-сериализация;Optimized Marshaller— оптимизированная Java-сериализация, при которой используются те же механизмы, что и в случаеJDK Marshaller; этот механизм обеспечивает обратную совместимость с Ignite 1.9;Binary Marshaller— сериализация, созданная специально для Apache Ignite, используемая в DataGrid по умолчанию; это — наиболее быстрый вариант, который позволяет избегать дополнительной сериализации или десериализации, а также работать с объектом напрямую в binary-формате.

При взаимодействии с кодом DataGrid и последующей сериализации могут возникать проблемы (WARN), о которых свидетельствуют сообщения вида Some classes in query configuration cannot be written in binary format... или Class FooBar cannot be serialized using BinaryMarshaller.

Проблемы с сериализацией классов также могут возникать при использовании кастомной реализации методов readObject() и writeObject() с помощью интерфейса Externalizable. В этом случае невозможна сериализация по механизму BinaryMarshaller, реализованном в продукте по умолчанию, так как BinaryMarshaller сериализует объекты с помощью обычной записи полей и простых методов. В случае кастомной сериализации DataGrid переключится на механизм OptimizedMarshaller, что может привести к падению производительности.

В случае возникновения проблем с сериализацией кастомных методов readObject() и writeObject(), которые по умолчанию реализуются с помощью механизма Binary Marshaller, для классов, в которых возникли проблемы, реализуйте интерфейс Binarylizable.

Рассмотрим процесс реализации Binarylizable на примере стандартного TreeMap:

private void writeObject(java.io.ObjectOutputStream s)

throws java.io.IOException {

// Write out the Comparator and any hidden stuff

s.defaultWriteObject();

// Write out size (number of Mappings)

s.writeInt(size);

// Write out keys and values (alternating)

for (Iterator<Map.Entry<K,V>> i = entrySet().iterator(); i.hasNext(); ) {

Map.Entry<K,V> e = i.next();

s.writeObject(e.getKey());

s.writeObject(e.getValue());

}

}

Классы writeBinary() и readBinary() в интерфейсе Binarylizable работают аналогично: BinaryTreeMap «оборачивается» в обычный TreeMap и записывается в OutputStream.

Пример реализации BinaryTreeMap.writeBinary():

public void writeBinary(BinaryWriter writer) throws BinaryObjectException {

BinaryRawWriter rewriter = writer. rewrite ();

rawWriter.writeObject(map.comparator());

int size = map.size();

rawWriter.writeInt(size);

for (Map.Entry<Object, Object> entry : ((TreeMap<Object, Object>)map).entrySet()) {

rawWriter.writeObject(entry.getKey());

rawWriter.writeObject(entry.getValue());

}

}

Узел не включается в топологию#

Причина 1. Maintenance Mode режим узла

Серверный узел может не войти в топологию, если находится в Maintenance Mode режиме.

В следующих двух примерах следует обратить внимание на разницу в CPU, Heap, Local node address.

Серверный узел из топологии:

>>> Ignite ver. 2.12.0-p7#20220526-sha1:543651d5886a61d93d7f3381d3bacc10dcee3c17

>>> OS name: Linux 3.10.0-1160.59.1.el7.x86_64 amd64

>>> CPU(s): 16

>>> Heap: 15.0GB

>>> VM name: 1532437@tvldd-pprb00615

>>> Local node[ID=1A60DC51-1655-4527-96B6-2D1D27E033F8, order=2, clientMode=false]

>>> Local node addresses:[hostname, /127.0.0.1]

>>> Local ports: TCP:8080 TCP:10800 TCP:11211 TCP:47100 TCP:4750

Серверный узел, не вошедший в топологию:

>>> Ignite ver. 2.12.0-p7#20220526-sha1:543651d5886a61d93d7f3381d3bacc10dcee3c17

>>> --------------------------------------------------------------------------

>>> OS name: Linux 3.10.0-1160.59.1.el7.x86_64 amd64

>>> CPU(s): -1

>>> Heap: 0.1GB

>>> VM name: 1963884@tvldd-pprb00614

>>> Local node [ID=6D7810F8-C65A-42A8-AA78-35D4FDA29BD6, order=1, clientMode=false]

>>> Local node addresses: [localhost/127.0.0.1]

>>> Local ports: TCP:8080 TCP:10800 TCP:11211 TCP:47100

Сообщение в логах о нахождении узла в состоянии maintenance mode:

[INFO ][main][org.apache.ignite.internal.IgniteKernal] Node is being started in maintenance mode. Starting IsolatedDiscoverySpi instead of configured discovery SPI.

В отдельных случаях необходимо особое состояние узла кластера, при котором узел принимает поступающие команды через скрипты или JMX API, но не присоединяется к кластеру.

Другими словами, нужно, чтобы узел кластера мог войти в maintenance режим, например, когда выполняются действия по техническому обслуживанию.

Возможные причины перехода в режим maintenance:

очистка поврежденных PDS файлов;

Native persistence дефрагментация;

Corrupted cash data files.

Причина перехода в maintenance mode указана в логе:

[INFO ][main][org.apache.ignite.internal.maintenance.MaintenanceProcessor] Node requires maintenance, non-empty set of maintenance tasks is found: [*corrupted-cache-data-files-task*]

Пример 1. Очистка потенциально поврежденных PDS файлов:

Случай включает автоматическое создание Maintenance Task - специальный маркер технического обслуживания, при котором узел решает переключиться на maintenance mode при запуске.

Maintenance Task состоит из уникального ID, user-readable описания и, при необходимости, аргументов для завершения действий по техническому обслуживанию.

Узел падает в середине checkpoint, когда WAL архив отключен для одного или нескольких кешей.

При следующем перезапуске узел обнаруживает, что файлы данных кеша могут быть повреждены, создает Maintenance Task и отключается.

На следующем перезапуске узел входит в maintenance mode и ожидает, что пользователь решит проблему вместо ожидания нового сбоя.

В управляемых средах, таких как Kubernetes, это означает, что узел не будет автоматически перезапущен и пользователь сможет найти возможные поврежденные файлы и удалять их.

Когда файлы удаляются через ручное действие, пользователь удаляет Maintenance Task из регистра и перезапускает узел.

Узел запускается в нормальном режиме и присоединяется к кластеру.

Пример 2. Native persistence дефрагментация:

Пользователь через скрипт control.sh или через другие API запросы создает Maintenance Task для дефрагментации native persistence на узле или определенных кешах.

Maintenance Task создан и сохранен на диске;

Пользователь перезапускает узел, узел входит в maintenance режим, находит Maintenance Task о дефрагментации и начинает работать над задачей.

Когда дефрагментация выполнена, Maintenance Task автоматически удаляется. При следующем перезапуске узел с дефрагментированными PDS присоединяется к обычным операциям.

Maintenance режим применим только тогда, когда включена persistence дата регионов и хранение доступно.

В maintenance режиме узел не присоединяется к кластеру, но принимает команды пользователя и/или выполняет другие действия, необходимые для обслуживания.

Узел остается изолированным пока maintenance работы не закончены или отменены по запросу пользователя.

После этого необходимо установить причину попадания узла в maintenance режим, устранить причину и перезапустить узел еще один раз: узел выйдет из maintenance режима и присоединиться к кластеру.

Устранение причины попадания в данный режим возможно через ручное вмешательство пользователя либо через выполнение автоматических действий запрошенного компонента Maintenance Mode.

Подробнее указано в разделе Persistence Defragmentation.

Потеря данных в persistence-кластерах#

Происходит потеря данных в кластерах, использующих режим Native Persistence.

Проблема появляется, если:

Запустить один узел.

Активировать кластер.

Запустить еще несколько узлов.

Остановить первый узел.

Причиной данной проблемы является запуск узлов после активации кластера. В данном случае эти узлы находятся вне базовой топологии (baseline) и не хранят persistent-данные.

Baseline topology — множество узлов, которые хранят на себе persistent-данные. Во всех остальных узлах persistent данных содержаться не будет (все остальные данные будут, но не persistent). Baseline topology в первый раз определяется в момент первой активации. После того, как вы добавили несколько узлов, во множество baseline они не попали, и в baseline у вас находится один первый узел.

Базовое правило — сначала запустите все узлы, а потом активируйте кластер.

Если добавляете или убираете узлы на длительное время, с помощью скрипта control.sh вы можете проверить, что у вас находится в baseline. Этот же скрипт поможет вам обновить baseline до текущего состояния.

Узлы, стартовавшие после активации, находятся вне baseline и не хранят persistent данные.

Для решения проблемы:

обязательно обновляйте baseline при смене топологии;

активируйте кластер только после запуска всех серверных узлов.

Потеря primary-партиций после перезапуска кластера#

При данной проблеме в логах появляется сообщение следующего вида:

[2022-03-09 15:30:43,662][WARN ]sys-#60%gridCommandHandlerTest0%[GridDhtPartitionTopologyImpl] Detected lost partitions [grp=default, parts=[3, 7, 13], topVer=AffinityTopologyVersion [topVer=6, minorTopVer=0]]

Данная проблема приводит к потере primary-партиций после перезапуска кластера, но данные все еще можно загрузить с диска.

Для решения проблемы выполните следующие действия:

запустите команду

control.sh --cache reset_lost_partitions cacheName1,cacheName2,...;запустите команду

control.sh --cache idle_verify.

Выполнение JOIN#

Выполнение JOIN по умолчанию приводит к объединению данных, лежащих на одном узле. Такое поведение было выбрано потому, что объединение данных на одном узле выполняется быстрее, чем объединение данных на разных узлах. Сбор данных со всего кластера тормозит работу всей системы.

Чтобы минимизировать потери, связанные с объединением данных на разных узлах, можно на этапе проектирования модели данных коллоцировать те данные, которые наиболее часто будут использоваться совместно. Для этого воcпользуйтесь одним из возможных вариантов решения:

Задайте affinity-ключ с помощью

AffinityKeyMapped, чтобы связать данные. Подробнее читайте в разделе «Настройка с помощью affinity-ключа».Используйте реплицированные таблицы.

Установите

setDistributedJoins(true)илиdistributedJoins=trueбез коллокации данных. Данное решение подходит в том случае, когда коллокацию невозможно реализовать или когда уже используется модель без реализованной коллокации данных. При выборе такого решения объединение данных будет проходить с накладными расходами.

Настройка с помощью affinity-ключа#

Affinity-ключ определяет, в какой партиции будет находиться значение по заданному ключу. Если объявить конкретный атрибут (например, столбец с ID организации) affinity-ключом, то все записи для этого атрибута (например, сотрудники с таким же значением ID организации) будут находиться в одной партиции, а партиция будет находиться на одном узле. Важно знать характер данных и подбирать affinity-ключ в соответствии с ними. Например, при создании чата сохраните диалог между двумя пользователями на одном узле кластера, а пользовательские данные — на другом узле; нужные данные извлекайте с помощью команды JOIN.

Для корректной настройки важно разобраться во взаимодействии между affinity-ключами и данными (ID, атрибутами, полями таблицы). Например, если в базе данных хранится информация о 10 организациях, она будет собрана в 10 неделимых партиций, которым соответствуют 10 affinity-ключей. В случае, если из этих 10 организаций одна большая (с большим количеством сотрудников), а остальные девять — маленькие, то партиции тоже будут неравномерными.

По умолчанию DataGrid не выравнивает данные и не распределяет их равнозначно их содержимому. В нашем примере все данные будут распределены на две группы с неравномерным соотношением организаций и числом сотрудников, например, «5—5», «7—3», «6—4». Если вам важно распределить данные равномерно — например, в соотношении «1—9», чтобы первой партиции соответствовали данные для самой большой организации с наибольшим количеством сотрудников, а второй партиции — все остальные небольшие организации, создайте гораздо большее количество affinity-ключей, чем партиций в выборке. Для выравнивания распределения также можно использовать алгоритм RendezvousAffinityFunction, который, однако не обеспечивает полностью равномерного распределения: погрешность составляет ±5–10% между узлами.

Таймауты записи на клиентских узлах#

При данной проблеме при подключениях клиентских узлов и попытках записи на них TcpCommunicationSpi перестает работать по таймаутам:

021-11-17 17:23:40:275 [WARN ] [org.apache.ignite.spi.communication.tcp.TcpCommunicationSpi] [grid-timeout-worker-#118%DPL_GRID%DplGridNodeName%] - Handshake timed out (will stop attempts to perform the handshake) [node=5b89fd66-11e5-4775-900a-64a1f2fb32f6, connTimeoutStrategy=ExponentialBackoffTimeoutStrategy [maxTimeout=600000, totalTimeout=30000, startNanos=1625306659621898, currTimeout=600000], err=Operation timed out [timeoutStrategy= ExponentialBackoffTimeoutStrategy [maxTimeout=600000, totalTimeout=30000, startNanos=1625306659621898, currTimeout=600000]], addr=/192.168.122.1:47100, failureDetectionTimeoutEnabled=true, timeout=0]

В логах сервера при данной проблеме присутствует множество попыток входящих соединений:

2021-11-17 17:24:29.141 [INFO ][grid-nio-worker-tcp-comm-10-#129%TcpCommunicationSpi%][org.apache.ignite.spi.communication.tcp.TcpCommunicationSpi] Accepted incoming communication connection [locAddr=/192.168.122.1:47100, rmtAddr=/192.168.122.1:42776]

В целях диагностики обратите внимание:

на IP-адрес, по которому происходит time out handshake;

на IP-адрес, с которым запущен кластер.

Проблема появляется, когда при наличии нескольких интерфейсов TcpCommunicationSpi запускается на интерфейсе, отличном от того, на котором работает кластер:

2021-11-17 00:00:10.362 [INFO ][grid-timeout-worker-#118][org.apache.ignite.internal.IgniteKernal]

Metrics for local node (to disable set 'metricsLogFrequency' to 0)

^-- Node [id=7eace3d5, uptime=1 day, 05:29:46.136]

^-- Cluster [hosts=32, CPUs=1792, servers=32, clients=9, topVer=53, minorTopVer=0]

^-- Network [addrs=[10.127.119.237, 127.0.0.1, 192.168.122.1], discoPort=47500, commPort=47100]

^-- CPU [CPUs=56, curLoad=0.03%, avgLoad=0.05%, GC=0%]

^-- Heap [used=10953MB, free=65.49%, comm=31744MB]

^-- Off-heap memory [used=132MB, free=99.98%, allocated=592071MB]

^-- Page memory [pages=33435]

^-- sysMemPlc region [type=internal, persistence=true, lazyAlloc=false,

... initCfg=40MB, maxCfg=100MB, usedRam=0MB, freeRam=99.99%, allocRam=99MB, allocTotal=0MB]

^-- default region [type=default, persistence=true, lazyAlloc=true,

... initCfg=256MB, maxCfg=591872MB, usedRam=130MB, freeRam=99.98%, allocRam=591871MB, allocTotal=129MB]

^-- metastoreMemPlc region [type=internal, persistence=true, lazyAlloc=false,

... initCfg=40MB, maxCfg=100MB, usedRam=2MB, freeRam=97.99%, allocRam=0MB, allocTotal=2MB]

^-- TxLog region [type=internal, persistence=true, lazyAlloc=false,

... initCfg=40MB, maxCfg=100MB, usedRam=0MB, freeRam=100%, allocRam=99MB, allocTotal=0MB]

^-- volatileDsMemPlc region [type=user, persistence=false, lazyAlloc=true,

... initCfg=40MB, maxCfg=100MB, usedRam=0MB, freeRam=100%, allocRam=0MB]

^-- Ignite persistence [used=131MB]

^-- Outbound messages queue [size=0]

^-- Public thread pool [active=0, idle=0, qSize=0]

^-- System thread pool [active=0, idle=7, qSize=0]

Для решения проблемы необходимо указать в bean TcpCommunicationSpi следующее свойство с локальным IP-адресом, на котором запущен кластер (TcpDiscoveryVmIpFinder):

<property name="localAddress" value="1.2.3.4"/>

Внимание

Данная опция включается автоматически в развертываниях через роль с версии v4.2110.1.

Проблемы с таймаутами подключения узлов#

Существуют два параметра (property), определяющих таймауты подключения, в течение которых происходит ожидание ответа от удаленного узла:

IgniteConfiguration.failureDetectionTimeout— таймаут для ожидания ответа от серверных узлов в процессе выполнения сетевых операций; значение таймаута по умолчанию составляет 10 000 мс;IgniteConfiguration.clientFailureDetectionTimeout— таймаут для ожидания ответа от клиентских узлов в процессе выполнения сетевых операций; значение таймаута по умолчанию составляет 30 000 мс.

Таймауты подключений работают только для установленного соединения в процессе ожидания ответа от узла. Если соединение разорвалось по какой-либо причине, отсчет таймаута прекращается.

Значения таймаутов по умолчанию позволяют discovery SPI надежно работать в большинстве развертываний (on-premise and containerized deployments). Однако можно самостоятельно установить значение таймаута в конфигурации узла. Например, увеличение времени ожидания имеет смысл в кластере, где присутствуют длинные GC-паузы или медленная нестабильная сеть — это поможет справляться с более долгими паузами между ответами в рамках сессии, что, в свою очередь, позволит не исключать медленно отвечающий узел из топологии.

Пример XML-конфигурации:

<beans xmlns="http://www.springframework.org/schema/beans" xmlns:util="http://www.springframework.org/schema/util" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation=" http://www.springframework.org/schema/beans http://www.springframework.org/schema/beans/spring-beans.xsd http://www.springframework.org/schema/util http://www.springframework.org/schema/util/spring-util.xsd">

<bean class="org.apache.ignite.configuration.IgniteConfiguration">

<property name="failureDetectionTimeout" value="5000"/>

<property name="clientFailureDetectionTimeout" value="10000"/>

</bean>

</beans>

Увеличение времени проведения транзакций и LRT#

Некоторые события кластера запускают процесс обмена данными и их ребалансировку, чтобы обеспечить равномерное распределение данных по всему кластеру. Примеры таких событий — изменение топологии при подключении нового или отключении уже существующего узла, создание новых кешей или SQL-таблиц.

При возникновении подобных событий в DataGrid может увеличиваться порог времени проведения транзакций, который по умолчанию составляет 60 секунд. Проблема часто связана с появлением LRT — длительных транзакций, которые долго выполняются в кластере. Незавершенные транзакции препятствуют обмену данными, блокируя операции кластера, например, процесс подключения нового узла.

Диагностировать проблему можно по следующим признакам:

сработала метрика LRT

Found long running transaction NEWв Grafana;log-файл

ignite.logсодержит сообщения следующего вида:[2021-10-06 11:41:53,530][WARN ][sys-#206%client%][root] First 10 long running transactions [total=10] [2021-10-06 11:41:53,530][WARN ][sys-#206%client%][root] >>> Transaction [startTime=11:41:52.961, curTime=11:41:53.518, systemTime=0, userTime=557, tx=GridNearTxLocal [mappings=IgniteTxMappingsImpl [], nearLocallyMapped=false, colocatedLocallyMapped=false, needCheckBackup=null, hasRemoteLocks=false, trackTimeout=false, systemTime=0, systemStartTime=0, prepareStartTime=0, prepareTime=0, commitOrRollbackStartTime=0, commitOrRollbackTime=0, lb=null, mvccOp=null, qryId=-1, crdVer=0, thread=async-tx-with-delay-#240%testscope%, mappings=IgniteTxMappingsImpl [], super=GridDhtTxLocalAdapter [nearOnOriginatingNode=false, span=o.a.i.i.processors.tracing.NoopSpan@60d3a365, nearNodes=KeySetView [], dhtNodes=KeySetView [], explicitLock=false, super=IgniteTxLocalAdapter [completedBase=null, sndTransformedVals=false, depEnabled=false, txState=IgniteTxStateImpl [activeCacheIds=[], recovery=null, mvccEnabled=null, mvccCachingCacheIds=[], txMap=EmptySet []], super=IgniteTxAdapter [xidVer=GridCacheVersion [topVer=244989714, order=1633509712519, nodeOrder=3], writeVer=null, implicit=false, loc=true, threadId=264, startTime=1633509712961, nodeId=390487f0-99c2-4890-992c-c9c3ac93d505, isolation=REPEATABLE_READ, concurrency=PESSIMISTIC, timeout=0, sysInvalidate=false, sys=false, plc=2, commitVer=null, finalizing=NONE, invalidParts=null, state=ACTIVE, timedOut=false, topVer=AffinityTopologyVersion [topVer=-1, minorTopVer=0], mvccSnapshot=null, skipCompletedVers=false, parentTx=null, duration=557ms, onePhaseCommit=false], size=0]]]] ...

Для решения проблемы проанализируйте содержимое log-файла DataGrid, в котором присутствуют сообщения вида Found long running transaction NEW. Возможные причины увеличения длительности транзакции:

длительная работа прикладного кода. Об этой проблеме свидетельствует наличие транзакции в активном статусе:

status=active;неисправное состояние кластера, при котором транзакции перестали выполняться — например, при отказе дисков.

Обратите внимание: при первом сообщении о появлении LRT будет получен дамп потока, запустившего LRT на узле-координаторе транзакции. Часто такой узел является клиентским узлом, а следовательно, дамп потока тразакции также будет получен с клиентского узла. Дамп показывает тип выполняемой операции (бизнес-операция или взаимодействие с DataGrid). Следующие признаки, присутствующие в дампах транзакций, свидетельствуют о наличии задержек:

атрибуты

TransactionProxyImpl.commit,TransactionProxyImpl.rollback,TransactionProxyImpl.prepareсвидетельствуют о задержках работы сети или GC-задержках (очистка мусора);бизнес-коды, кеш-операции и другие параметры промежуточного состояния свидетельствуют о задержках в работе прикладного кода или о низких таймаутах транзакций.

Пример записи в log-файле:

2022-07-06 05:31:08.093 [WARN ][sys-#112111][org.apache.ignite.internal.diagnostic] Dumping the near node thread that started transaction [xidVer=GridCacheVersion [topVer=267985566, order=1658822904791, nodeOrder=29, dataCenterId=0], nodeId=b1076c6d-e26d-44ff-bd30-af41845a42ed]

Stack trace of the transaction owner thread:

Thread [name="se-53", id=1353, state=WAITING, blockCnt=1, waitCnt=1788]

Lock [object=java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject@a19d495, ownerName=null, ownerId=-1]

at sun.misc.Unsafe.park(Native Method)

at java.util.concurrent.locks.LockSupport.park(LockSupport.java:175)

at java.util.concurrent.locks.AbstractQueuedSynchronizer$ConditionObject.await(AbstractQueuedSynchronizer.java:2039)

at java.util.concurrent.ArrayBlockingQueue.take(ArrayBlockingQueue.java:403)

at java.util.concurrent.ThreadPoolExecutor.getTask(ThreadPoolExecutor.java:1074)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1134)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at java.lang.Thread.run(Thread.java:748)

LRT-транзакции часто возникают в результате следующих причин:

повышенной загрузки узлов кластера;

наличия сетевых проблем, приводящих к деградации вычислений;

системных проблем: длительные GC-паузы на узлах, неоптимальный код, падение узлов кластера.

Чтобы настроить время срабатывания для вывода сообщений о наличии LTR-транзакций, воспользуйтесь JVM-опцией IGNITE_LONG_OPERATIONS_DUMP_TIMEOUT. По умолчанию время вывода сообщений — 1 секунда.

Чтобы установить максимальное время, разрешенное для длительных транзакций, используйте метод TransactionConfiguration.setTxTimeoutOnPartitionMapExchange(...). После срабатывания таймаута происходит откат всех незавершенных транзакций, после чего продолжается процесс обмена данными в кластере.

Пример xml-файла для конфигурации времени таймаута:

<bean class="org.apache.ignite.configuration.IgniteConfiguration">

<property name="transactionConfiguration">

<bean class="org.apache.ignite.configuration.TransactionConfiguration">

<!--Установите таймаут на 20 секунд.-->

<property name="TxTimeoutOnPartitionMapExchange" value="20000"/>

</bean>

</property>

</bean>

Чек-лист вопросов для анализа LRT-транзакций:

в чем причина возникновения LRT;

какой способ возможен для восстановления LRT — автоматически или вручную;

что необходимо сделать, чтобы снизить вероятность повторения сбоя в дальнейшем;

как повлияла LRT-транзакция на grid-данные и дальнейшую работу.

Долгий PME#

PME (partition map exchange) — процесс обмена информацией о партициях между узлами кластера. Цель - установить актуальное состояние партиций для всех узлов кластера.

От чего зависит: длительность PME зависит от количества партиций, от длины транзакций.

Пороговые значения: комфортная длительность PME для клиентов составляет меньше 1 секунды. Для PME нужно дождаться окончания всех транзакций и не запускать новые, поэтому при общей комфортной длительности нагрузки при запуске PME в 60 сек сама длительность PME должна составлять меньше 1 секунды. Чем меньше длительность PME, тем лучше.

Начиная с версии 2.8 функция IGNITE_PME_FREE_SWITCH_DISABLED стала деактивируемой.

К симптомам относится срабатывание метрик по LRT, например, Found Long Running Transactions NEW.

Симптомы вызваны следующими проблемами:

создание транзакций без таймаутов или с большими таймаутами;

наличие дефектов.

Есть вероятность, что транзакция никогда не будет завершена. Например, если пользователь запустил pessimistic транзакции и выполнил cache put, вызывающий блокировку и настройку версии топологии транзакций. Для этого случая вводится timeout транзакции на PME. Если транзакция не может быть завершена в рамках timeout, указанного транзакцией, она будет принудительно выполнена во время выпуска партиций.

Установите время в setTxTimeoutOnPartitionMapExchange(long txTimeoutOnPartitionMapExchange) — устанавливает временное ограничение на PME в партициях при выполнении транзакции. Если оно будет превышено, выполнение транзакции будет прервано.

Реакция на долгие PME: чаще всего причина в зависшей транзакции либо в результате дефектов. Если дело в транзакции, то возможно, что разработка не поставила таймаут на длительность выполнения транзакции. Следовательно, нужно найти транзакцию и прервать ее.

Поломка h2-индексов#

При данной проблеме узлы завершают работу с ошибками вида Critical system error detected. Will be handled accordingly to configured handler. Поломка индексов выявляется в результате выполнения команды control.sh --cache validate_indexes <optional arguments>. Подробнее об индексах читайте в разделе «Управление индексами» документа «Руководство по системному администрированию».

Пример сообщения об ошибке:

2021-11-22 17:33:43.466 [ERROR][sys-stripe-9-#10][] Critical system error detected. Will be handled accordingly to configured handler [hnd=StopNodeOrHaltFailureHandler [tryStop=false, timeout=0, super=AbstractFailureHandler [ignoredFailureTy

pes=UnmodifiableSet [SYSTEM_WORKER_BLOCKED, SYSTEM_CRITICAL_OPERATION_TIMEOUT]]], failureCtx=FailureContext [type=CRITICAL_ERROR, err=class o.a.i.i.processors.cache.persistence.tree.CorruptedTreeException: B+Tree is corrupted [pages(groupId,

pageId)=[IgniteBiTuple [val1=544320549, val2=844420635174666]], cacheId=-227153373, cacheName=APPLY_ERROR_V1, indexName=_key_PK, msg=Runtime failure on row: Row@4118366a[ key: BinaryObject [idHash=974233043, hash=1604362618], val: Data hidd

en due to IGNITE_TO_STRING_INCLUDE_SENSITIVE flag. ][ data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden ]]]]

org.apache.ignite.internal.processors.cache.persistence.tree.CorruptedTreeException: B+Tree is corrupted [pages(groupId, pageId)=[IgniteBiTuple [val1=544320549, val2=844420635174666]], cacheId=-227153373, cacheName=APPLY_ERROR_V1, indexName=

_key_PK, msg=Runtime failure on row: Row@4118366a[ key: BinaryObject [idHash=974233043, hash=1604362618], val: Data hidden due to IGNITE_TO_STRING_INCLUDE_SENSITIVE flag. ][ data hidden, data hidden, data hidden, data hidden, data hidden, da

ta hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden, data hidden ]]

Поломка h2-индексов — дефект, о котором необходимо сообщить в службу поддержки DataGrid и передать фактуру для анализа: log-файлы DataGrid, хронологию событий, PDS (достаточно index.bin).

В качестве временного решения проблемы перестройте индексы:

Остановите проблемные узлы.

Удалите проблемный файл

index.bin.Запустите узлы.

Выполните процесс перестройки всех индексов с помощью команды

control.sh --cache indexes_force_rebuild --node-ids nodeId1,...nodeIdN|--all-nodes --cache-names cacheName1,...cacheNameN|--group-names groupName1,...groupNameN.Дождитесь завершения процесса перестроения индексов.

Переполнение региона данных (data region)#

Регион данных (data region) — логическая расширяемая область в RAM, где находятся кешированные данные. Пользователи могут настраивать начальный и максимальный размер автоматически создаваемого региона данных, создавать дополнительные регионы данных, а также контролировать persistence-параметры для кеша.

По умолчанию при старте DataGrid создается один регион данных с автоматически заданными начальным и максимальным размерами. Начальный размер составляет 256 Mб, максимальный — 20% от доступной узлу RAM. Все создаваемые пользователем кеши хранятся в этом регионе данных. Пользователи могут настраивать начальный и максимальный размеры автоматически создаваемого региона данных по своему усмотрению.

Помимо автоматически создаваемого, пользователи могут добавлять дополнительные регионы данных. Размеры регионов данных либо задаются пользователем в конфигурации, либо устанавливаются автоматически. При автоматической установке максимальный размер региона данных также будет выставлен в пределах от 256 Mб до 20% от доступной оперативной памяти. При ручной установке настройки региона данных необходимо задать до старта узла; эти настройки нельзя будет изменить динамически, без остановки узла. Заполнение памяти для регионов данных отображается в log-файлах каждого узла.

При добавлении дополнительных регионов данных объем памяти, заданный автоматически или вручную, будет использован для хранения кешей, которые используют этот регион данных.

Количество дополнительных регионов данных не ограничено; главное — не превышать размер доступной оперативной памяти. Расчет размера регионов данных должен определяться исходя из размера доступной памяти на серверном узле. В случае переполнения доступной памяти узел будет аварийно остановлен.

Ситуации, в которых оправданно добавление дополнительных регионов данных:

для настройки объема памяти, доступной для одного кеша, или для группы кешей, использующих один регион данных;

для конфигурирования способа хранения данных — только в памяти (in-memory), или и в памяти, и на диске (persistence). Способ хранения конфигурируется на уровне настроек региона данных, следовательно, этот способ является единым для всех кешей, использующих один регион данных; в этом случае настройте два или более региона данных с разными persistence-параметрами: один для кешей в памяти, другой — для persistence-кешей. По умолчанию данные кешей не записываются на диск и хранятся только в оперативной памяти;

для настройки политики хранения данных, например, политики вытеснения данных (

eviction policy). Политики хранения памяти настраиваются отдельно для каждого региона данных.

В случае переполнения и/или недостаточного размера региона данных появляется сообщение в Zabbix и Grafana: IgniteOutOfMemoryException: Out of memory in data region.

Для решения проблемы:

увеличьте DataRegionConfiguration.maxSize;

включите режим Native Persistence (подробнее см. в разделе «Включение Persistence-хранилища данных» документа «Руководство по системному администрированию»). При включении Native Persistence данные, которые больше не помещаются в регион данных, вытесняются из оперативной памяти на диск. В этом случае операции чтения и записи занимают больше времени, однако объем памяти больше не ограничивается размером региона данных. Также включенный режим Native Persistence позволяет восстановить данные из кеша после перезапуска кластера;

установите значение атрибута DataRegionConfiguration.pageEvictionMode=RANDOM_2_LRU. Важно: включение

eviction policy— аварийный механизм сохранения данных. При работеeviction policyданные могут вытесняться из оперативной памяти неконсистентно, что потенциально приводит к расхождениям по узлам. В случае систематического переполнения региона данных и запускаeviction policyрекомендуется увеличить объем региона данных или включить режим Native Persistence;используйте политику истечения срока действия.

Подключение другой версии клиента#

Симптом проблемы – сообщение в log-файлах о том, что клиент не подключается.

При возникновении проблемы с толстым клиентом обратитесь к группе разработки.

При использовании тонкого клиента проблемы с подключением возникают только при наличии дефектов. Чтобы передать фактуру для анализа в группу разработки, соберите следующие метрики:

название affinity-функции, при использовании которой возникают ошибки, и параметры функции;

распределение партиций (primary, backup) по узлам;

распределение ключей по партициям.

Неравномерная загрузка узлов#

Некорректное распределение данных и ошибки кода могут приводить к скоплению запросов на одном узле. Из-за этого возникает неравномерная загрузка остальных узлов:

на уровне аппаратных и/или физических ресурсов, к которым относятся CPU, SSD, RAM, LAN, аппаратные ресурсы узлов кластера;

на уровне неаппаратных ресурсов, к которым относятся системные потоки кластера (thread pools), все виды памяти в ОС, партиции и т.д.

Каждый вид ресурсов может утилизироваться преимущественно на одном из узлов, из-за чего кластер не сможет отрабатывать запросы с требуемой SLA скоростью или развалится.

Мониторинг симптомов возможен с помощью сбора фактуры ignite.log, метрик DataGrid, метрик ОС.

Возможные причины проблемы:

некорректная конфигурация, например, указан только один IP-адрес;

ошибки в коде, из-за чего данные и запросы направляются на один узел.

Для решения проблемы установите причину концентрации данных. Если причина в некорректной конфигурации, настройте ее. Если проблема в коде, найдите ошибки, чтобы решить проблему с ключами, разнесением данных по узлам и по партициям.

Неравномерное распределение данных#

DataGrid: равномерное распределение данных по партициями и по узлам, минимизация трафика при балансировке (изменениях в топологии).