Руководство по системному администрированию#

Термины и определения#

Термин/Аббревиатура |

Определение |

|---|---|

JDBC |

Java Database Connectivity, платформенно независимый промышленный стандарт взаимодействия Java-приложений с различными СУБД |

JDK |

Java Development Kit, комплект разработчика приложений на языке Java |

JMX |

Java Management Extensions, управленческие расширения Java |

JVM |

Java Virtual Machine, виртуальная машина Java |

LFS |

Local File System, локальная файловая система |

PDS |

Persistent Data Store, постоянное хранилище данных |

SPI |

Service Programming Interface, программный интерфейс сервиса |

LFS |

Local File System, локальная файловая система |

WAL |

Write-Ahead Logging, журнал предзаписи |

КУ |

Клиентский узел |

ОС |

Операционная система |

СУ |

Серверный узел |

УЗ |

Учетная запись |

УЦ |

Удостоверяющий центр |

WAL (Write-Ahead Logging) — журнал предзаписи.

Сценарии администрирования#

Резервное копирование и восстановление в Platform V DataGrid#

Существующие ограничения#

С существующими ограничениями можно ознакомиться в подразделе «Ограничения» раздела «Безопасность данных» документа «Руководство по безопасному использованию».

Создание полной резервной копии (снепшота)#

Благодаря использованию Persistence, Platform V DataGrid позволяет создавать резервные копии (снепшоты). Резервная копия Ignite включает в себя согласованную копию всех данных кластера, сохраненных на диске.

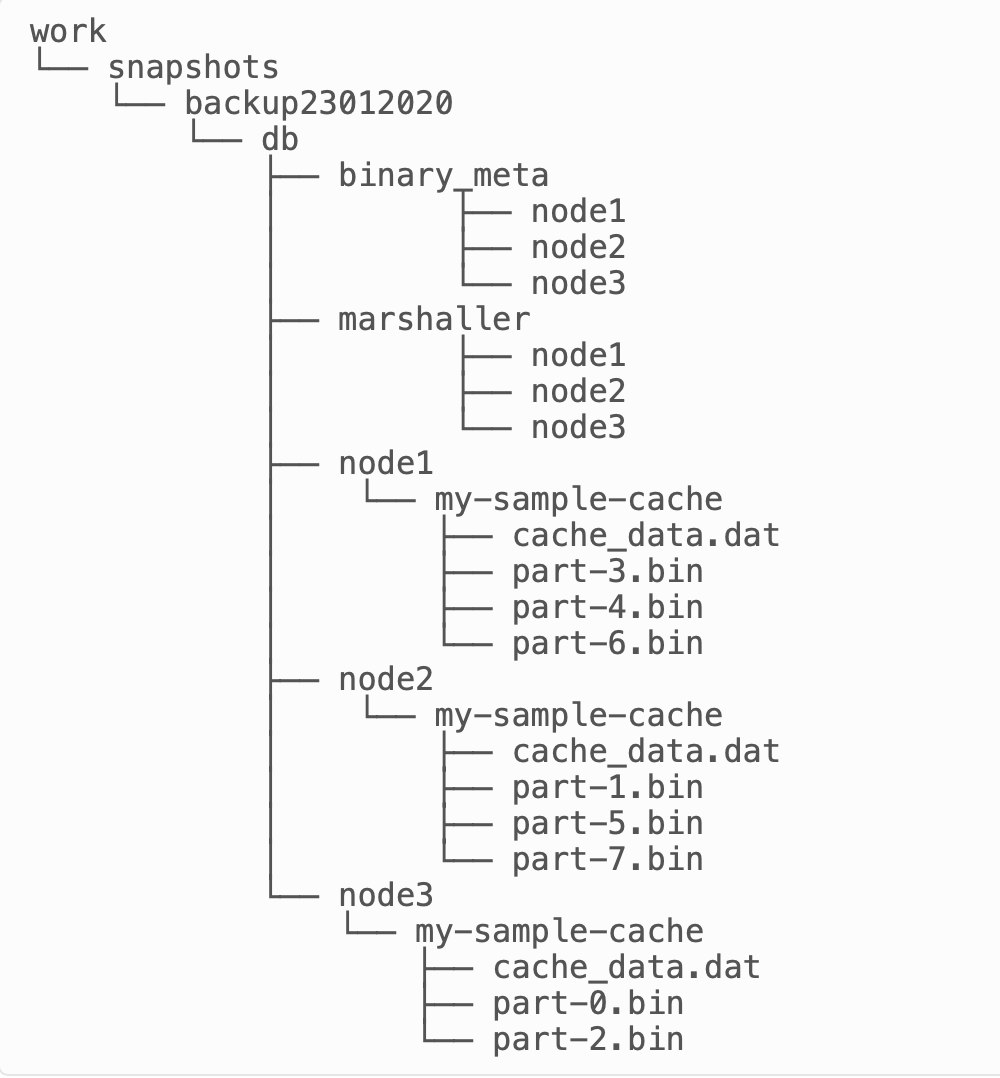

Структура резервной копии схожа со структурой директории постоянного хранилища с некоторыми исключениями. На рисунке ниже приведен пример такой структуры:

снепшот находится в директории

work\snapshotsи называетсяbackup23012020, гдеwork– рабочая директория Ignite;снепшот создается для кластера с тремя узлами. При этом, все узлы запускаются на одной машине. В данном примере узлы называются

node1,node2иnode3, однако на практике названия узлов эквивалентны согласованным ID узлов;снепшот содержит в себе копию кеша

my-sample-cache;в файлах

part-N.binиcache_data.datдиректорииdbсодержится копия записей данных. Процессы упреждающей журнализации и создания контрольных точек не включены в снепшот, поскольку это не требуется для корректной работы имеющейся процедуры восстановления;директории

binary_metaиmarshallerхранят информацию, относящуюся к метаданным и marshaller.

Внимание

Создаваемый снепшот должен иметь уникальное имя. В случае попытки создания снепшота с именем, которое уже использовалось ранее, Ignite выдаст следующую ошибку:

Cluster-wide snapshot operation failed: class org.apache.ignite.IgniteException: Create snapshot request has been rejected. Snapshot with given name already exists on local node.

Конфигурация директории хранения резервной копии (снепшота)#

По умолчанию, сегмент снепшота сохраняется в рабочей директории соответствующего узла Platform V DataGrid и использует то же пространство, в котором хранятся данные, индексы, WAL-журнал и другие файлы Persistence.

Примечание

Поскольку снепшот может потреблять столько же пространства на диске, сколько занимают файлы Ignite Persistence, и снижать производительность приложения за счет использования I/O жесткого диска совместно с рутинными задачами Ignite Persistence, рекомендуется хранить снепшот и файлы Persistence на разных дисках.

Чтобы избежать неравномерного распределения нагрузки между Persistence и механизмом резервного копирования (создания снепшотов), необходимо либо изменить директорию для файлов Persistence, либо сконфигурировать директорию хранения резервной копии (снепшота), как показано ниже:

XML

<bean class="org.apache.ignite.configuration.IgniteConfiguration">

<!--

Sets a path to the root directory where snapshot files will be persisted.

By default, the `snapshots` directory is placed under the `IGNITE_HOME/db`.

-->

<property name="snapshotPath" value="/snapshots"/>

<property name="cacheConfiguration">

<bean class="org.apache.ignite.configuration.CacheConfiguration">

<property name="name" value="snapshot-cache"/>

</bean>

</property>

</bean>

Java

IgniteConfiguration cfg = new IgniteConfiguration();

File exSnpDir = U.resolveWorkDirectory(U.defaultWorkDirectory(), "ex_snapshots", true);

cfg.setSnapshotPath(exSnpDir.getAbsolutePath());

Создание резервной копии (снепшота)#

Для создания резервных копий в поставку Platform V DataGrid входят следующие интерфейсы:

утилита

control.sh;JMX;

Java API.

При создании снепшота, в директории $IGNITE_HOME/work/db/.../snp создаются файлы партиций с грязными страницами. Каждый такой файл партиции будет иметь расширение .delta.

Пример

part-467.bin.delta

После успешного завершения операции по созданию снепшота данные файлы будут автоматически применены к созданному снепшоту и удалены.

Отображение начала и окончания процесса создания снепшота в логах Platform V DataGrid#

В момент запуска операции создания снепшота в журналах Platform V DataGrid появляется следующая запись:

[IgniteSnapshotManager] Cluster-wide snapshot operation started [snpName=MySnapshot, grps=[1794698200]]

где:

snpName– имя снепшота;grps– список кеш-групп в снепшоте.

Когда операция создания снепшота завершается, в логах появляется следующая запись:

[IgniteSnapshotManager] Cluster-wide snapshot operation finished successfully: SnapshotOperationRequest [rqId=1a24fa7d-4e50-4714-ae68-959892c6d5a3, srcNodeId=b7b71afb-32c5-4730-b0dc-5090920cf4f0, snpName=MySnapshot, grpIds=ArrayList [1794698200], bltNodes=HashSet [b7b71afb-32c5-4730-b0dc-5090920cf4f0], err=null]

Использование утилиты control.sh#

Утилита администрирования control.sh поддерживает следующие команды для управления резервными копиями (снепшотами):

#Create a cluster snapshot:

control.(sh|bat) --snapshot create snapshot_name

#Cancel a running snapshot:

control.(sh|bat) --snapshot cancel snapshot_name

#Kill a running snapshot:

control.(sh|bat) --kill SNAPSHOT snapshot_name

Примечание:

Команды

--snapshot cancelи--kill SNAPSHOTничем не отличаются и используют один и тот же API.

Использование интерфейса JMX#

Для проведения операций, связанных с созданием резервных копий через интерфейс JMX, используйте SnapshotMXBean:

Метод |

Описание |

|---|---|

|

Создать снепшот |

|

Отменить создание снепшота на узле-инициаторе этой операции |

Использование Java API#

Создать снепшот также можно и из кода, используя Java API:

CacheConfiguration<Long, String> ccfg = new CacheConfiguration<Long, String>("snapshot-cache");

try (IgniteCache<Long, String> cache = ignite.getOrCreateCache(ccfg)) {

cache.put(1, "Maxim");

// Start snapshot operation.

ignite.snapshot().createSnapshot("snapshot_02092020").get();

}

finally {

ignite.destroyCache(ccfg);

}

Восстановление из резервной копии (снепшота)#

Восстановление из снепшота происходит на остановленном кластере и состоит из копирования на каждом узле кластера данных из директории снепшота в рабочую директорию. Текущие данные при этом удаляются или копируются в резервную директорию.

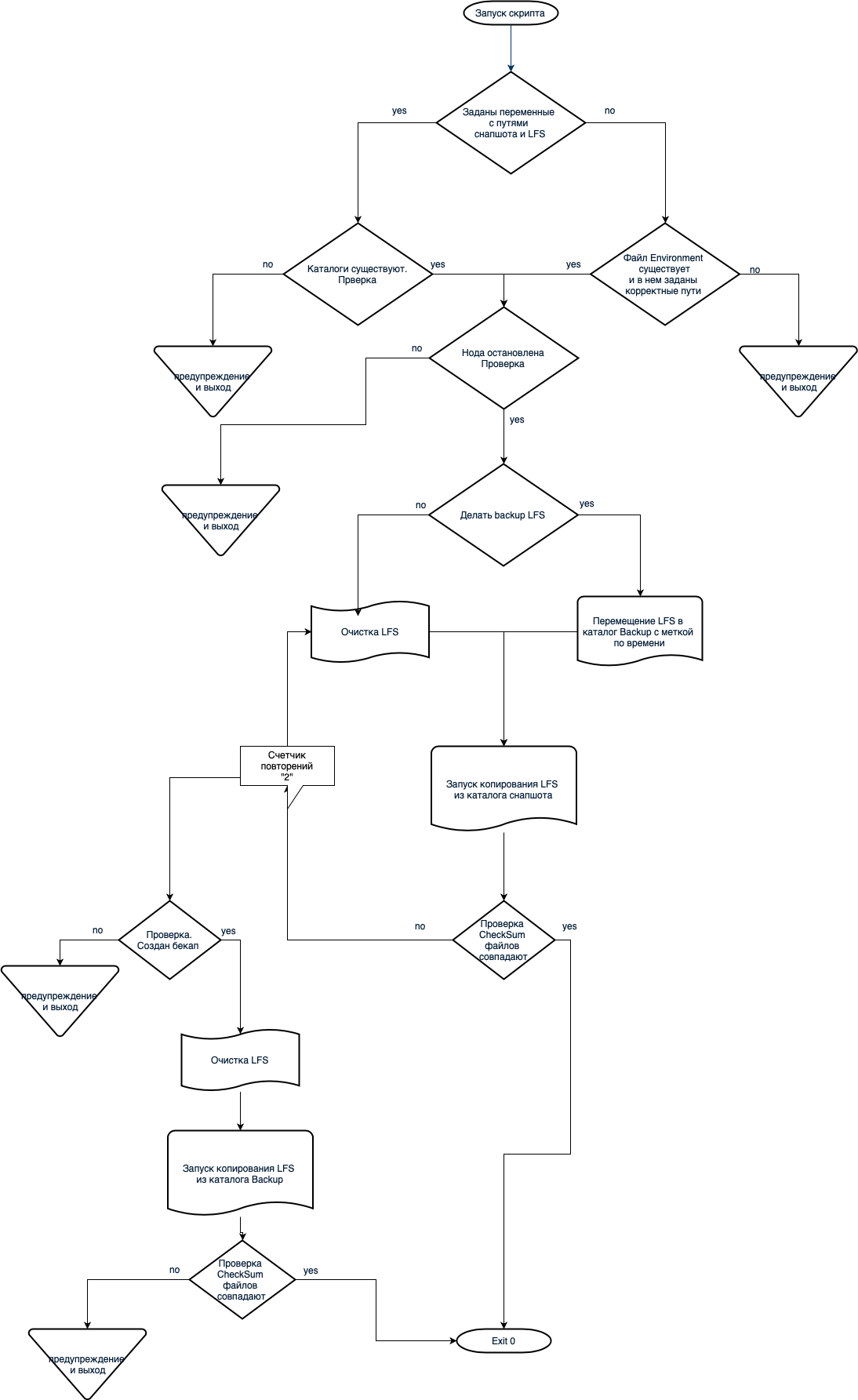

На схеме ниже продемонстрирован алгоритм работы процесса восстановления из снепшота:

Примечание

Скрипт запуска восстановления и набор скриптов (playbook), позволяющий управлять процедурой восстановления, находятся на каждом узле и поставляются с релизом.

Ручное восстановление из снепшота#

Для ручного восстановления из снепшота выполните следующие действия:

Остановите работу кластера, который нужно восстановить.

Удалите все данные из директории контрольной точки

$IGNITE_HOME/work/cp(данные Persistence и прочие данные).На каждом узле выполните следующие действия:

удалите все файлы, относящиеся к

{nodeId}из директории$IGNITE_HOME/work/db/binary_meta.удалите все файлы, относящиеся к

{node_id}из директории$IGNITE_HOME/work/db/marshaller.удалите все файлы и субдиректории, принадлежащие к узлу с

{nodeId}в директории$IGNITE_HOME/work/db. Очистите директориюdb/{nodeId}отдельно, если она отсутствует в директорииwork.скопируйте файлы, относящиеся к узлу с

{node_id}, из снепшота в директорию$IGNITE_HOME/work/. Если директорияdb/{node_id}не находится в директорииwork, скопируйте файлы с данными туда.

Перезапустите кластер.

Восстановление кластера из снепшота кластера с другой топологией#

При возникновении ситуации неожиданного выхода кластера из строя (например, при сбоях) может потребоваться его восстановление. Однако топологии кластеров могут отличаться, равно как и топологии снепшотов этих кластеров. Таблица ниже описывает ситуации, когда нужно создать снепшот кластера с количеством узлов N и восстановить кластер с количеством узлов M:

Условие |

Описание |

|---|---|

N == M |

Рекомендованный случай. Создание и использование снепшота на кластерах с похожей топологией |

N < M |

Запуск первых N узлов кластера с M узлов и применение снепшота. Далее необходимо добавить остальные узлы кластера с M узлов в топологию и дождаться окончания ребалансировки данных и обновления индексов |

N > M |

Не поддерживается |

Восстановление кластера Ignite из резервной копии с использованием скрипта восстановления snapshot_restore.sh#

Для запуска процесса восстановления кластера из резервной копии используйте скрипт snapshot_restore.sh. Он использует следующие переменные:

storagePath– путь к каталогу с данными на хосте;snapshotName– имя снепшота;snapshotPath– путь к каталогу, в котором хранится снепшот.

Ниже приведен пример запуска скрипта восстановления:

$ snapshot_restore.sh --workPath="/ignite/server/work" --storagePath="/ignite/server/data"--snapshotName="snapshot_simple_1" --snapshotPath="/ignite/server/work/snapshots"

Перед запуском скрипта необходимо задать переменные с путем к каталогу, в котором хранится снепшот, а также с путем к LFS.

Примечание

Вы также можете передавать переменные скрипту при запуске с помощью следующих аргументов:

snapname– имя снепшота;

snapfullpath– путь к каталогу, в котором хранится снепшот;

IGNITE_DATA;

IGNITE_WORK;

IGNITE_HOME.

Playbook для управления процессом восстановления#

Playbook — это набор скриптов для управления восстановлением из резервной копии. В playbook также содержатся метаданные, необходимые для его исполнения.

Для запуска playbook предварительно заполните файл hosts, в котором заданы хосты кластера.

hosts

[srv_hosts]

1.1.1.1

2.2.2.2

3.3.3.3

....

n.n.n.n

Для запуска передайте следующие переменные:

Имя переменной |

Описание |

|---|---|

|

|

|

(опция) Если LFS вынесен из db |

|

|

|

Имя снепшота для восстановления |

|

(опция) По умолчанию определяется как |

|

(опция) если требуется сохранять LFS перед восстановлением из снепшота |

|

(опция) По умолчанию пишется в |

Переменные передаются как extravars:

$ ansible-playbook playbooks/restore_snapshots.yml -i ./hosts -e "run_on=srv_hosts ignite_se_instance_home='/ignite/server/' ignite_se_data_dir='/ignite/server/data' ignite_se_work_dir='/ignite/server/work' ignite_se_snapshot_dir='/ignite/server/work/snapshots' ignite_se_snapshot_name='snapshot_simple_1'"

Постоянное хранилище данных (Persistent Data Store)#

Подробную информацию о постоянном хранилище данных можно найти в документе «Детальная архитектура». В настоящем документе приводится описание включения и конфигурации хранилища.

Включение постоянного хранилища данных#

Native Persistence конфигурируется отдельно для каждого региона данных.

Чтобы включить постоянное хранилище данных, установите значение true для свойства persistenceEnabled в файле конфигурации региона данных.

Примечание

Регионы данных могут одновременно храниться и в ОЗУ (in-memory data regions), и в постоянном хранилище (data regions with persistence).

Пример ниже показывает, как можно включить постоянное хранилище для стандартного региона данных.

XML

<bean class="org.apache.ignite.configuration.IgniteConfiguration">

<property name="dataStorageConfiguration">

<bean class="org.apache.ignite.configuration.DataStorageConfiguration">

<property name="defaultDataRegionConfiguration">

<bean class="org.apache.ignite.configuration.DataRegionConfiguration">

<property name="persistenceEnabled" value="true"/>

</bean>

</property>

</bean>

</property>

</bean>

Java

IgniteConfiguration cfg = new IgniteConfiguration();

//data storage configuration

DataStorageConfiguration storageCfg = new DataStorageConfiguration();

storageCfg.getDefaultDataRegionConfiguration().setPersistenceEnabled(true);

cfg.setDataStorageConfiguration(storageCfg);

Ignite ignite = Ignition.start(cfg);

C#/.NET

var cfg = new IgniteConfiguration

{

DataStorageConfiguration = new DataStorageConfiguration

{

DefaultDataRegionConfiguration = new DataRegionConfiguration

{

Name = "Default_Region",

PersistenceEnabled = true

}

}

};

Ignition.Start(cfg);

Конфигурация директории постоянного хранилища данных#

При включенном Persistence узел сохраняет данные пользователей, индексы и WAL-файлы в директории {IGNITE_WORK_DIR}/db. Данная директория считается директорией хранилища. Ее можно изменить, установив свойство storagePath объекта DataStorageConfiguration, как показано ниже.

Каждый узел обслуживает следующие субдиректории хранилища, в котором будут храниться кешированные данные, WAL-файлы, а также файлы архива WAL:

Субдиректория |

Описание |

|---|---|

|

Данная директория содержит кешированные данные и индексы |

|

Данная директория содержит WAL-файлы |

|

Данная директория содержит файлы архива WAL |

nodeId здесь — это либо согласованный ID узла (consistent node ID), если он определен конфигурацией узла, либо автоматически сгенерированный ID узла. Он используется для обеспечения уникальности директорий для узла.

Примечание

Если несколько узлов используют одну директорию, то в ней создаются субдиректории для каждого из узлов.

Если рабочая директория содержит файлы постоянного хранения для нескольких узлов (т. е. существует несколько субдиректорий {nodeId} с разными ID узлов), то узел выбирает первую неиспользуемую субдиректорию.

Внимание

Чтобы убедиться в том, что узел всегда использует определенную субдиректорию и, следовательно, определенные партиции данных даже после его перезагрузки, установите в конфигурации узла уникальное для кластера значение метода

IgniteConfiguration.setConsistentId.

Директорию можно изменить следующим образом:

XML

<bean class="org.apache.ignite.configuration.IgniteConfiguration">

<property name="dataStorageConfiguration">

<bean class="org.apache.ignite.configuration.DataStorageConfiguration">

<property name="defaultDataRegionConfiguration">

<bean class="org.apache.ignite.configuration.DataRegionConfiguration">

<property name="persistenceEnabled" value="true"/>

</bean>

</property>

<property name="storagePath" value="/opt/storage"/>

</bean>

</property>

</bean>

Java

IgniteConfiguration cfg = new IgniteConfiguration();

//data storage configuration

DataStorageConfiguration storageCfg = new DataStorageConfiguration();

storageCfg.getDefaultDataRegionConfiguration().setPersistenceEnabled(true);

storageCfg.setStoragePath("/opt/storage");

cfg.setDataStorageConfiguration(storageCfg);

Ignite ignite = Ignition.start(cfg);

C#/.NET

var cfg = new IgniteConfiguration

{

DataStorageConfiguration = new DataStorageConfiguration

{

StoragePath = "/ssd/storage",

DefaultDataRegionConfiguration = new DataRegionConfiguration

{

Name = "Default_Region",

PersistenceEnabled = true

}

}

};

Ignition.Start(cfg);

Конфигурация#

В таблице ниже перечислены некоторые свойства класса DataStorageConfiguration.

Свойство |

Описание |

Значение по умолчанию |

|---|---|---|

|

Максимальный размер архива WAL-журнала в файловой системе в байтах |

Размер буфера контрольных точек (checkpointing buffer) * 4 |

|

Для включения Native Persistence установите значение true |

false |

|

Путь, по которому хранятся данные |

|

|

Путь к архиву WAL-журнала |

|

|

Для включения сжатия архива WAL-журнала установите значение |

|

|

Уровень сжатия архива WAL-журнала. 1 — самое быстрое сжатие, 9 — лучшее сжатие |

1 |

|

Режим работы WAL-журнала |

|

|

Путь к директории, в которой хранятся активные сегменты WAL-журнала |

|

|

Размер файла сегмента WAL-журнала в байтах |

64MB |

WAL-журнал#

Подробнее о WAL-журнале вы можете прочитать в документе «Детальная архитектура». В этом документе приведены только примеры конфигурации.

Изменение размера сегмента WAL-журнала#

Для изменения размера сегмента WAL-журнала выполните следующий код:

XML

<bean class="org.apache.ignite.configuration.IgniteConfiguration" id="ignite.cfg">

<property name="dataStorageConfiguration">

<bean class="org.apache.ignite.configuration.DataStorageConfiguration">

<!-- set the size of wal segments to 128MB -->

<property name="walSegmentSize" value="#{128 * 1024 * 1024}"/>

<property name="defaultDataRegionConfiguration">

<bean class="org.apache.ignite.configuration.DataRegionConfiguration">

<property name="persistenceEnabled" value="true"/>

</bean>

</property>

</bean>

</property>

</bean>

Java

IgniteConfiguration cfg = new IgniteConfiguration();

DataStorageConfiguration storageCfg = new DataStorageConfiguration();

storageCfg.getDefaultDataRegionConfiguration().setPersistenceEnabled(true);

storageCfg.setWalSegmentSize(128 * 1024 * 1024);

cfg.setDataStorageConfiguration(storageCfg);

Ignite ignite = Ignition.start(cfg);

Отключение WAL-журнала#

Java

IgniteConfiguration cfg = new IgniteConfiguration();

DataStorageConfiguration storageCfg = new DataStorageConfiguration();

storageCfg.getDefaultDataRegionConfiguration().setPersistenceEnabled(true);

cfg.setDataStorageConfiguration(storageCfg);

Ignite ignite = Ignition.start(cfg);

ignite.cluster().state(ClusterState.ACTIVE);

String cacheName = "myCache";

ignite.getOrCreateCache(cacheName);

ignite.cluster().disableWal(cacheName);

//load data

ignite.cluster().enableWal(cacheName);

C#/.NET

var cacheName = "myCache";

var ignite = Ignition.Start();

ignite.GetCluster().DisableWal(cacheName);

//load data

ignite.GetCluster().EnableWal(cacheName);

SQL

ALTER TABLE Person NOLOGGING

//...

ALTER TABLE Person LOGGING

Сжатие записей WAL-журнала#

Java

IgniteConfiguration cfg = new IgniteConfiguration();

DataStorageConfiguration dsCfg = new DataStorageConfiguration();

dsCfg.getDefaultDataRegionConfiguration().setPersistenceEnabled(true);

//WAL page compression parameters

dsCfg.setWalPageCompression(DiskPageCompression.LZ4);

dsCfg.setWalPageCompressionLevel(8);

cfg.setDataStorageConfiguration(dsCfg);

Ignite ignite = Ignition.start(cfg);

Отключение архива WAL-журнала#

Для отключения архивирования укажите одно и то же значение как для walPath, так и для walArchivePath. В этом случае Platform V DataGrid не копирует сегменты в архив. Вместо этого он создает новые сегменты в папке WAL-журнала, а старые сегменты удаляются по мере роста самого WAL-журнала. Этот рост зависит от настроек размера архива WAL-журнала.

Безопасность и аудит#

Плагин безопасности для Platform V DataGrid#

Сокращения#

КУ — клиентский узел кластера Platform V DataGrid;

СУ — серверный узел кластера Platform V DataGrid;

ТК — тонкий клиент Platform V DataGrid;

УЗ — учетная запись;

ИБ — информационная безопасность.

Подготовка сертификатов пользователей#

Описание сертификатов пользователей содержится в разделе «Управление ключами и сертификатами» документа «Руководство по безопасному использованию». Этапы создания сертификата перечислены ниже.

Генерация сертификата#

При генерации сертификата укажите уникальный пароль, удовлетворяющий требованиям ИБ к его составу.

keytool -genkey \

-alias <Alias> \

-keystore <FileName>-keystore.jks \

-keyalg RSA \

-keysize 2048 \

-dname "CN=<CN>, OU=00CA, O=Savings Bank of the Russian Federation, C=RU"

где:

Alias— псевдоним сертификата вjks-файле;FileName— имя файла сертификата;CN— ЗначениеCommon Name.

Пример:

keytool -genkey \

-alias ntsecuritySgg_server \

-keystore ntsecuritySgg_server-keystore.jks \

-keyalg RSA \

-keysize 2048 \

-dname "CN=00CA0000Sgg_server@snnode.nt.security.sbrf.ru, OU=00CA, O=Savings Bank of the Russian Federation, C=RU"

Создание запроса на подпись сертификата#

keytool -keystore <FileName>-keystore.jks \

-alias <Alias> \

-certreq \

-file <FileName>-certreq.csr \

-ext ExtendedkeyUsage=serverAuth,clientAuth

Пример:

keytool -keystore ntsecuritySgg_server-keystore.jks \

-alias ntsecuritySgg_server \

-certreq \

-file ntsecuritySgg_server-certreq.csr \

-ext ExtendedkeyUsage=serverAuth,clientAuth

Дальнейшие действия совпадают с вышеописанными пунктами.

Создание запроса на подпись сертификата#

Администратор создает запрос на подпись сертификата и прикладывает к нему файл с расширением .csr.

Импорт сертификатов УЦ#

Импортируйте сертификаты УЦ в JKS-хранилище. Этими сертификатами подписаны сертификаты на шаге создания запроса на подпись сретификата (см. раздел "Создание запроса на подпись сертификата). Этот шаг является необходимым для последующего импорта подписанного сертификата, поскольку при импорте keytool проверяет корректность всей цепочки сертификации.

Пример:

keytool -keystore <FileName>-keystore.jks \

-alias "Test Root CA 2" \

-import \

-file "Test Root CA 2.cer"

keytool -keystore <FileName>-keystore.jks \

-alias "Company Test Issuing CA 2" \

-import \

-file "Company Test Issuing CA 2.cer"

Примечание

Сертификаты УЦ обычно приложены к запросу на подпись сертификата.

Импорт подписанного сертификата#

Импортируйте подписанный сертификат в JKS-хранилище:

keytool -keystore <FileName>-keystore.jks \

-alias <Alias> \

-import \

-file <FileName>-certreq.csr_cert.cer

Удаление сертификатов УЦ#

Удалите из jks-хранилища сертификаты УЦ, добавленные при импорте подписанных сертификатов (см. раздел "Импорт подписанного сертификата"). Это необходимо, поскольку текущая реализация менеджера ключей в Platform V DataGrid и плагине использует первый встретившийся сертификат, поэтому он должен быть один.

keytool -keystore <FileName>-keystore.jks \

-alias "Test Root CA 2" \

-delete

keytool -keystore <FileName>-keystore.jks \

-alias "Company Test Issuing CA 2" \

–delete

Генерация truststore, содержащего сертификаты УЦ#

keytool -keystore truststore.jks \

-alias "Test Root CA 2" \

-import \

-file "Test Root CA 2.cer"

keytool -keystore truststore.jks \

-alias "Company Test Issuing CA 2" \

-import \

-file "Company Test Issuing CA 2.cer"

Проверка корректности созданных сертификатов#

keytool -v --list --keystore <FileName>-keystore.jks | awk '/Owner:|Issuer:|Your keystore contains|Certificate chain length/'

Пример вывода:

Your keystore contains 1 entry

Certificate chain length: 3

Owner: CN=00CA0000Sgg_server@snnode.nt.security.sbrf.ru, OU=00CA, O=Company, C=RU

Issuer: CN=Company Test Issuing CA 2, DC=ca, DC=sbrf, DC=ru

Owner: CN=Company Test Issuing CA 2, DC=ca, DC=sbrf, DC=ru

Issuer: CN=Test Root CA 2

Owner: CN=Test Root CA 2

Issuer: CN=Test Root CA 2

Вывод должен содержать следующую информацию:

Your keystore contains 1 entry;Certificate chain length: 3;Issuer:— УЦ компании.

Подготовка сертификатов для утилиты управления пользователями#

Для работы утилиты сгенерируйте сертификат узла, на котором будет запускаться утилита. Данный сертификат имеет следующие особенности:

в нем должно быть указано соответствующее DNS-имя данного узла (браузер проверяет FQDN);

в

CNуказывается имя сервера.

В примерах ниже используется сервер grid785.

Генерация сертификата#

keytool -genkey \

-alias grid785 \

-keystore grid785-keystore.jks \

-keyalg RSA \

-keysize 2048 \

-dname "CN=grid785.delta.sbrf.ru, OU=00CA, O=Savings Bank of the Russian Federation, C=RU"

Создание запроса на подпись сертификата#

keytool -keystore \

grid785-keystore.jks \

-alias grid785 \

-certreq \

-file grid785-certreq.csr \

-ext SAN="dns:grid785.delta.sbrf.ru,dns:grid785" \

-ext ExtendedkeyUsage=serverAuth

Дальнейшие этапы совпадают с вышеописанными пунктами.

Утилита управления использует аутентификацию клиентов, поэтому создайте копию keystore в формате PKCS12 и импортируйте ее в браузер:

keytool -importkeystore \

-srckeystore petrov-keystore.jks \

-destkeystore petrov-keystore.p12 \

-srcstoretype JKS \

-deststoretype PKCS12

Импорт копии keystore в браузер выполняется стандартными средствами ОС. Например, для Windows — через контекстное меню файла *.p12.

Конфигурирование серверного узла#

Включение Persistence#

Внимание

Текущая реализация не поддерживает кластеры, хранящие данные только в памяти. В следующих версиях это ограничение может быть снято.

Убедитесь, что режим persistence включен:

<bean id="ignite.cfg" class="org.apache.ignite.configuration.IgniteConfiguration" primary="true">

...

<property name="dataStorageConfiguration" ref="dataStorage"/>

...

</bean>

...

<bean id="dataStorage" class="org.apache.ignite.configuration.DataStorageConfiguration">

<property name="defaultDataRegionConfiguration">

<bean class="org.apache.ignite.configuration.DataRegionConfiguration">

<property name="persistenceEnabled" value="true"/>

</bean>

</property>

</bean>

Конфигурирование плагина безопасности#

<bean id="ignite.cfg" class="org.apache.ignite.configuration.IgniteConfiguration" primary="true">

...

<property name="pluginProviders">

<list>

<ref bean="securityPlugin"/>

</list>

</property>

...

</bean>

...

<bean id="creds" class="org.apache.ignite.plugin.security.SecurityCredentials">

<!-- При наличии интеграции с Конфигуратором использовать value="${SecurityPluginConfiguration.nodeLogin}" -->

<constructor-arg value="serverNode"/>

<!-- При наличии интеграции с Конфигуратором использовать value="${SecurityPluginConfiguration.nodePassword}" -->

<constructor-arg value="default-password"/>

</bean>

<bean id="credentialsProvider" class="org.apache.ignite.plugin.security.SecurityCredentialsBasicProvider">

<constructor-arg ref="creds"/>

</bean>

<bean id="dataProvider" class="com.sbt.security.ignite.core.storage.metastorage.MetaStorageSecurityDataProvider">

<constructor-arg>

<bean class="com.sbt.security.ignite.core.storage.metastorage.DefaultSecurityDataSupplierImpl">

<constructor-arg ref="credentialsProvider"/>

<constructor-arg>

<bean class="com.sbt.security.ignite.core.storage.metastorage.JsonSecurityDataSupplierImpl"/>

</constructor-arg>

</bean>

</constructor-arg>

</bean>

<bean id="evtRecorder" class="com.sbt.security.ignite.core.events.EventRecorderImpl" />

<util:list id="components" value-type="SecurityLifecycleAware">

<ref bean="evtRecorder"/>

. . .

</util:list>

<bean id="securityPluginConfiguration" class="com.sbt.security.ignite.core.SecurityPluginConfiguration">

<property name="securityDataProvider" ref="dataProvider"/>

<property name="authenticator">

<bean class="com.sbt.security.ignite.core.authenticator.TwoFactorSecurityAuthenticatorImpl">

<constructor-arg ref="dataProvider"/>

</bean>

</property>

<property name="authorizer">

<bean class="com.sbt.security.ignite.core.authorizer.SecurityAuthorizerImpl">

<constructor-arg ref="dataProvider"/>

</bean>

</property>

<property name="securityCredentialsProvider" ref="credentialsProvider"/>

<property name="selfKeyStorePath" value="/path/to/serverNode-key-and-certificate.jks"/>

<!-- При наличии интеграции с Конфигуратором необходимо использовать value="${SecurityPluginConfiguration.selfKeyStorePwd}" -->

<property name="selfKeyStorePassword" value="123456"/>

<property name="components" ref="components"/>

</bean>

<bean id="securityPlugin" class="com.sbt.security.ignite.core.SecurityPluginProvider">

<constructor-arg ref="securityPluginConfiguration"/>

</bean>

Настройка TLS#

Для протоколов, по которым узлы Platform V DataGrid обмениваются данными между собой (discovery, communication), используется TLS без шифрования. Соответствующие наборы шифров (в названиях присутствует фрагмент WITH_NULL) по умолчанию отключены в JVM. Чтобы избежать плохо диагностируемых ошибок при TLS handshake, включите эти шифры явно: уберите значение NULL из параметра jdk.tls.disabledAlgorithms файла lib/security/java.security в JRE. Переход на TLS с шифрованием возможен, но повлечет существенное падение производительности, что в большинстве случаев неприемлемо.

<bean id="ignite.cfg" class="org.apache.ignite.configuration.IgniteConfiguration" primary="true">

...

<property name="sslContextFactory" ref="nullSslContextFactory"/>

<property name="connectorConfiguration" ref="connectorConfiguration"/>

<property name="clientConnectorConfiguration" ref="clientConnectorConfiguration"/>

...

</bean>

...

<!-- Настройка подключений GridClient -->

<bean id="connectorConfiguration" class="org.apache.ignite.configuration.ConnectorConfiguration">

<property name="idleTimeout" value="180000"/>

<property name="sslEnabled" value="true"/>

<property name="sslClientAuth" value="true"/>

<property name="sslFactory" ref="sslContextFactory"/>

</bean>

<!-- Настройка подключений IgniteClient и JDBC -->

<bean id="clientConnectorConfiguration" class="org.apache.ignite.configuration.ClientConnectorConfiguration">

<property name="useIgniteSslContextFactory" value="false"/>

<property name="sslEnabled" value="true"/>

<property name="sslClientAuth" value="true"/>

<property name="sslContextFactory" ref="sslContextFactory"/>

</bean>

<!-- TLS без шифрования -->

<bean id="nullSslContextFactory" class="org.apache.ignite.ssl.SslContextFactory">

<property name="keyStoreFilePath" value="/path/to/serverNode-key-and-certificate.jks"/>

<!-- При наличии интеграции с Конфигуратором использовать value="${SslContextFactory.keyStorePassword}" -->

<property name="keyStorePassword" value="123456"/>

<property name="trustStoreFilePath" value="/path/to/Sberbank-CA-truststore.jks"/>

<!-- При наличии интеграции с Конфигуратором использовать value="${SslContextFactory.trustStorePassword}" -->

<property name="trustStorePassword" value="123456"/>

<property name="cipherSuites"

value="TLS_RSA_WITH_NULL_SHA256, TLS_ECDHE_ECDSA_WITH_NULL_SHA, TLS_ECDH_RSA_WITH_NULL_SHA"/>

</bean>

<!-- TLS с шифрованием -->

<bean id="sslContextFactory" class="org.apache.ignite.ssl.SslContextFactory">

<property name="keyStoreFilePath" value="/path/to/serverNode-key-and-certificate.jks"/>

<!-- При наличии интеграции с Конфигуратором использовать value="${SslContextFactory.keyStorePassword}" -->

<property name="keyStorePassword" value="123456"/>

<property name="trustStoreFilePath" value="/path/to/Sberbank-CA-truststore.jks"/>

<!-- При наличии интеграции с Конфигуратором использовать value="${SslContextFactory.trustStorePassword}" -->

<property name="trustStorePassword" value="123456"/>

<property name="trustManagers" ref="trustManager"/>

</bean>

<!-- Расширенный trust manager -->

<bean id="trustManager" class="com.sbt.security.ignite.core.ssl.ExtendedX509TrustManagerImpl">

<constructor-arg index="0" ref="evtRecorder"/>

<constructor-arg index="1" value="/path/to/Sberbank-CA-truststore.jks"/>

<!-- При наличии интеграции с Конфигуратором использовать value="${SslContextFactory.trustStorePassword}" -->

<constructor-arg index="2" value="123456"/>

<constructor-arg index="3" value="JKS"/>

<constructor-arg index="4" value="PKIX"/>

</bean>

Настройка отправки событий ИБ в систему аудита#

При использовании конфигуратора для системы аудита проверьте актуальность версий библиотек Технологического Ядра. В classpath не должны попадать одинаковые библиотеки разных версий.

С событиями ИБ, отправляемыми в систему аудита, вы можете ознакомиться в соответствующей таблице в разделе «Аудит» документа «Руководство по безопасному использованию».

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xmlns:util="http://www.springframework.org/schema/util" xsi:schemaLocation="

http://www.springframework.org/schema/beans http://www.springframework.org/schema/beans/spring-beans.xsd

http://www.springframework.org/schema/util http://www.springframework.org/schema/util/spring-util.xsd">

<bean id="ignite.cfg" class="org.apache.ignite.configuration.IgniteConfiguration" primary="true">

...

<property name="includeEventTypes" ref="eventTypes"/>

<property name="localEventListeners" ref="eventListeners"/>

...

<property name="pluginProviders">

<list>

...

<ref bean="restProcessorPluginProvider"/>

</list>

</property>

...

<property name="eventStorageSpi" ref="eventStorageSpi"/>

</bean>

...

<util:list id="eventTypes" value-type="java.lang.Integer">

<util:constant static-field="org.apache.ignite.events.EventType.EVT_NODE_JOINED"/>

<util:constant static-field="org.apache.ignite.events.EventType.EVT_NODE_LEFT"/>

<util:constant static-field="org.apache.ignite.events.EventType.EVT_NODE_FAILED"/>

<util:constant static-field="org.apache.ignite.events.EventType.EVT_NODE_VALIDATION_FAILED"/>

<util:constant static-field="org.apache.ignite.events.EventType.EVT_CACHE_STARTED"/>

<util:constant static-field="org.apache.ignite.events.EventType.EVT_CACHE_STOPPED"/>

<util:constant static-field="org.apache.ignite.events.EventType.EVT_CACHE_QUERY_EXECUTED"/>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_AUTHORIZATION_SUCCEEDED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_AUTHORIZATION_FAILED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_AUTHENTICATION_SUCCEEDED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_AUTHENTICATION_FAILED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_CERTIFICATE_EXPIRED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_SECURITY_SUBJECT_CREATED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_SECURITY_SUBJECT_REMOVED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_SECURITY_SUBJECT_OPERATION_UNSUPPORTED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_USER_ROLES_GRANTED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_USER_ROLES_REVOKED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_USER_PASSWORD_UPDATED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_CACHE_PERMISSIONS_GRANTED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_CACHE_PERMISSIONS_REVOKED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_TASK_PERMISSIONS_GRANTED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_TASK_PERMISSIONS_REVOKED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_SERVICE_PERMISSIONS_GRANTED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_SERVICE_PERMISSIONS_REVOKED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_SYSTEM_PERMISSIONS_GRANTED.eventCode()}</value>

<value>#{T(com.sbt.security.ignite.core.events.SecurityEventType).EVT_SYSTEM_PERMISSIONS_REVOKED.eventCode()}</value>

<util:constant static-field="com.sbt.security.ignite.integration.audit.EventType.EVT_REST_REQ_SUCCEEDED"/>

<util:constant static-field="com.sbt.security.ignite.integration.audit.EventType.EVT_REST_REQ_FAILED"/>

<util:constant static-field="com.sbt.security.ignite.integration.audit.EventType.EVT_REST_REQ_AUTHENTICATION_FAILED"/>

<util:constant static-field="com.sbt.security.ignite.integration.audit.EventType.EVT_REST_REQ_AUTHORIZATION_FAILED"/>

<util:constant static-field="com.sbt.security.ignite.integration.audit.EventType.EVT_REST_REQ_ILLEGAL_ARGUMENT"/>

<util:constant static-field="com.sbt.security.ignite.integration.audit.EventType.EVT_UNEXPECTED_REST_REQ_EXECUTION_STATUS"/>

</util:list>

<bean id="auditEventListener" class="com.sbt.security.ignite.integration.audit.AuditEventListenerImpl" >

<constructor-arg ref="dataProvider"/>

<!-- Ссылка на существующую в контексте Spring реализацию com.sbt.audit2.AuditClientFactory. -->

<constructor-arg ref="auditClientFactory"/>

</bean>

<util:map id="eventListeners"

map-class="java.util.HashMap"

key-type="org.apache.ignite.lang.IgnitePredicate"

value-type="java.lang.Integer[]">

<entry key-ref="auditEventListener" value-ref="eventTypes"/>

</util:map>

<!-- Ниже - настройка обработки событий от GridClient-подключений. -->

<util:list id="cmdEventIgnoreList" value-type="java.lang.String">

<!--Имена команд org.apache.ignite.internal.processors.rest.GridRestCommand,

запись в аудит для которых вестись не будет -->

<value>NOOP</value>

</util:list>

<bean id="restProcessorConfiguration" class="com.sbt.security.ignite.integration.audit.rest.RestProcessorPluginConfiguration">

<property name="commandEventIgnoreList" ref="cmdEventIgnoreList"/>

</bean>

<bean id="restProcessorPluginProvider" class="com.sbt.security.ignite.integration.audit.rest.RestProcessorPluginProvider">

<property name="configuration" ref="restProcessorConfiguration"/>

</bean>

<bean id="eventsFilter" class="com.sbt.security.ignite.core.events.IgnoreEventsFilter">

<constructor-arg>

<list>

<util:constant static-field="org.apache.ignite.events.EventType.EVT_CACHE_QUERY_EXECUTED"/>

<util:constant static-field="org.apache.ignite.events.EventType.EVT_QUERY_EXECUTION"/>

</list>

</constructor-arg>

</bean>

<bean id="eventStorageSpi" class="org.apache.ignite.spi.eventstorage.memory.MemoryEventStorageSpi">

<property name="filter" ref="eventsFilter"/>

</bean>

...

</beans>

Отключение возможности подключений IgniteClient и JDBC#

Требуется только если кластер не должен принимать подключения IgniteClient или JDBC.

Оба вида клиентских подключений используют одно и то же свойство IgniteConfiguration — clientConnectorConfiguration или его устаревший аналог sqlConnectorConfiguration. Для отключения возможности подключений установите оба параметра в null:

<bean id="ignite.cfg" class="org.apache.ignite.configuration.IgniteConfiguration" primary="true">

...

<property name="clientConnectorConfiguration">

<null/>

</property>

<property name="sqlConnectorConfiguration">

<null/>

</property>

...

</bean>

Системные свойства JVM#

На СУ обязательно установите следующие системные свойства:

Свойство |

Описание |

|---|---|

|

Тип кластера. Должен быть одинаковым на всех узлах. Этот же тип кластера должен использоваться в |

|

Имя кластера. Должно быть одинаковым на всех узлах. Это же имя кластера должно использоваться в |

|

Отключает регистрацию Ignite JMX management beans, если их использование не планируется |

Помимо соблюдения структуры CN плагин выполняет следующие проверки имени и типа кластера:

При попытке входа клиентского или серверного узла Platform V DataGrid в кластер значение

cluster_nameв его сертификате должно быть равным значению системного свойстваIGNITE_CLUSTER_NAMEаутентифицирующего узла (следовательно, это свойство обязательно должно быть установлено для успешного запуска плагина).При любой аутентификации значение

cluster_typeиз сертификата аутентифицируемого узла должно быть равным системному свойствуIGNITE_CLUSTER_TYPEаутентифицирующего узла. Для сертификатов администраторов эксплуатации (тип ключа — 'A') эту проверку можно отключить отдельным системным свойством:-DSKIP_A_CERT_CLUSTER_TYPE_CHECK=false, чтобы упростить проведение работ на тестовых стендах.

Конфигурирование клиентского узла#

Конфигурирование плагина безопасности#

<bean id="ignite.cfg" class="org.apache.ignite.configuration.IgniteConfiguration" primary="true"> ... <property name="pluginProviders"> <list> <ref bean="securityPlugin"/> </list> </property> ...</bean>...<bean id="creds" class="org.apache.ignite.plugin.security.SecurityCredentials"> <!-- При наличии интеграции с Конфигуратором необходимо использовать value="${SecurityPluginConfiguration.nodeLogin}" --> <constructor-arg value="clientNode"/> <!-- При наличии интеграции с Конфигуратором необходимо использовать value="${SecurityPluginConfiguration.nodePassword}" --> <constructor-arg value="default-password"/></bean>

<bean id="credentialsProvider" class="org.apache.ignite.plugin.security.SecurityCredentialsBasicProvider"> <constructor-arg ref="creds"/></bean>

<bean id="dataProvider" class="com.sbt.security.ignite.core.storage.metastorage.MetaStorageSecurityDataProvider"/>

<bean id="securityPluginConfiguration" class="com.sbt.security.ignite.core.SecurityPluginConfiguration"> <property name="securityDataProvider" ref="dataProvider"/>

<property name="authenticator"> <bean class="com.sbt.security.ignite.core.authenticator.TwoFactorSecurityAuthenticatorImpl"> <constructor-arg ref="dataProvider"/> </bean> </property>

<property name="authorizer"> <bean class="com.sbt.security.ignite.core.authorizer.SecurityAuthorizerImpl"> <constructor-arg ref="dataProvider"/> </bean> </property>

<property name="securityCredentialsProvider" ref="credentialsProvider"/>

<property name="selfKeyStorePath" value="/path/to/clientNode-key-and-certificate.jks"/>

<!-- При наличии интеграции с Конфигуратором необходимо использовать value="${SecurityPluginConfiguration.selfKeyStorePwd}" --> <property name="selfKeyStorePassword" value="123456"/>

</bean>

<bean id="evtRecorder" class="com.sbt.security.ignite.core.events.EventRecorderImpl" />

<bean id="securityPlugin" class="com.sbt.security.ignite.core.SecurityPluginProvider"> <constructor-arg ref="securityPluginConfiguration"/> <constructor-arg ref="evtRecorder"/></bean>

Настройка TLS#

В отличие от СУ, на КУ коннекторы для клиентских подключений не используются. Сведения из пункта о включении/отключении шифрования актуальны и для КУ.

<bean id="ignite.cfg" class="org.apache.ignite.configuration.IgniteConfiguration" primary="true">

...

<property name="sslContextFactory" ref="nullSslContextFactory"/>

...

</bean>

...

<!-- TLS без шифрования -->

<bean id="nullSslContextFactory" class="org.apache.ignite.ssl.SslContextFactory">

<property name="keyStoreFilePath" value="/path/to/clientNode-key-and-certificate.jks"/>

<!-- При наличии интеграции с Конфигуратором использовать value="${SslContextFactory.keyStorePassword}" -->

<property name="keyStorePassword" value="123456"/>

<property name="trustStoreFilePath" value="/path/to/Sberbank-CA-truststore.jks"/>

<!-- При наличии интеграции с Конфигуратором использовать value="${SslContextFactory.trustStorePassword}" -->

<property name="trustStorePassword" value="123456"/>

<property name="cipherSuites"

value="TLS_RSA_WITH_NULL_SHA256, TLS_ECDHE_ECDSA_WITH_NULL_SHA, TLS_ECDH_RSA_WITH_NULL_SHA"/>

</bean>

Конфигурирование безопасных клиентских подключений#

В плагине безопасности реализована поддержка следующих типов клиентских подключений:

Тонкий клиент, реализация для Java

IgniteClient client = Ignition.startClient(configuration);.Platform V DataGrid JDBC-driver.

GridClient. Он используется для выполнения задач map-reduce, и не имеет прямого доступа к данным кешей.

Для успешного подключения на серверных узлах кластера должны быть настроены коннекторы:

ClientConnectorConfiguration— для тонких клиентов и JDBC;ConnectorConfiguration— дляGridClient. Подробности настройки содержатся в п. 4.3.

Конфигурирование IgniteClient#

Логин и пароль устанавливаются в ClientConfiguration:

ClientConfiguration cfg = new ClientConfiguration()

.setUserName("myLogin")

.setUserPassword("myPassword")

...

Конфигурирование GridClient#

Логин и пароль устанавливаются в GridClientConfiguration:

GridClientConfiguration cfg = new GridClientConfiguration()

.setSecurityCredentialsProvider(() -> new SecurityCredentials("myLogin", "myPassword"))

...

Конфигурирование JDBC#

Пример создания подключения:

// Register JDBC driver.

Class.forName("org.apache.ignite.IgniteJdbcDriver");

Connection conn = DriverManager.getConnection("jdbc:ignite:thin://127.0.0.1/?"

+ "sslMode=require"

+ "&user=" + login

+ "&password=" + pwd

+ "&sslClientCertificateKeyStoreUrl=" + keyStorePath

+ "&sslClientCertificateKeyStorePassword=" + keyStorePassword

+ "&sslClientCertificateKeyStoreType=" + "JKS"

+ "&sslTrustCertificateKeyStoreUrl=" + trustStorePath

+ "&sslTrustCertificateKeyStorePassword=" + trustStorePassword

+ "&sslTrustCertificateKeyStoreType=" + "JKS");

Конфигурирование JMX#

Плагин позволяет создать защищенный JMX-сервер. Для подключающегося пользователя компонентами плагина выполняется аутентификация с использованием логина, пароля и клиентского сертификата и авторизация разрешения org.apache.ignite.plugin.security.SecurityPermission.ADMIN_OPS (проверка, является ли он администратором эксплуатации). Если используется защищенный сервер, то следует запретить возможность незащищенного подключения:

если для запуска узла используется

control.sh, то укажите параметр-nojmx;если узел запускается из Java-кода, то не устанавливайте свойство

com.sun.management.jmxremote.

Защита JMX-подключений реализована с использованием JAAS Login Modules, поэтому создайте файл конфигурации, содержащий описание модуля, и задействуйте этот файл с помощью системного свойства java.security.auth.login.config.

Файл конфигурации JAAS Login Modules#

Пример файла (my.login.modules.config):

JmxModule {

com.sbt.security.ignite.core.jmx.JmxLoginModule required igniteInstanceName="serverNode";

};

где:

JmxModule— имя модуля;igniteInstanceName— имя узла Platform V DataGrid. Оно должно соответствовать параметруIgniteConfiguration.igniteInstanceName.

Если в приложении создается несколько узлов, то для каждого узла, предполагающего возможность защищенного JMX-подключения, в файл конфигурации добавьте описание отдельного модуля с уникальным именем.

Файл из примера выше указывается при запуске JVM с помощью -Djava.security.auth.login.config=my.login.modules.config. Более подробную информацию о структуре файла вы можете найти в документации Oracle.

Дополнения в конфигурации серверного узла#

Для настройки защищенного JMX-сервера в конфигурации плагина используются следующие свойства:

...

<bean id="securityPluginConfiguration" class="com.sbt.security.ignite.core.SecurityPluginConfiguration">

...

<property name="selfKeyStorePath" value="/path/to/serverNode-key-and-certificate.jks"/>

<property name="selfKeyStorePassword" value="123456"/>

<property name="jmxPort" value="3000"/>

<property name="jmxTrustStorePath" value="/path/to/Sberbank-CA-truststore.jks"/>

<property name="jmxTrustStorePassword" value="123456"/>

<!-- Имя модуля из файла конфигурации JAAS Login Modules. -->

<property name="jmxLoginModuleName" value="JmxModule"/>

...

</bean>

...

Если свойство jmxPort не указано, то сервер не будет создан.

Подключение к JMX-коннектору при помощи внешнего Java-клиента#

Пример создания и использования javax.management.remote.JMXConnector:

import java.util.HashMap;

import java.util.Map;

import javax.management.remote.JMXConnector;

import javax.management.remote.JMXConnectorFactory;

import javax.management.remote.JMXServiceURL;

...

System.setProperty("javax.net.ssl.keyStore", "/path/to/admin/keystore.jks");

System.setProperty("javax.net.ssl.keyStorePassword", "123456");

System.setProperty("javax.net.ssl.trustStore", "/path/to/Sberbank-CA-truststore.jks");

System.setProperty("javax.net.ssl.trustStorePassword", "123456");

String jmxHost = "localhost";

int jmxPort = 3000;

JMXServiceURL url = new JMXServiceURL(String.format("service:jmx:rmi:///jndi/rmi://%s:%d/jmxrmi", jmxHost, jmxPort));

Map<String, Object> jmxEnv = new HashMap<>();

jmxEnv.put(JMXConnector.CREDENTIALS, new String[] { "admin", "passw0rd" });

try (JMXConnector jmxc = JMXConnectorFactory.connect(url, jmxEnv)) {

jmxc.getMBeanServerConnection().invoke(...);

...

}

Подключение к JMX-коннектору с помощью JConsole#

Для запуска jconsole выполните:

jconsole \

-J-Djavax.net.ssl.keyStore=/path/to/admin/keystore.jks \

-J-Djavax.net.ssl.keyStorePassword=123456 \

-J-Djavax.net.ssl.trustStore=/path/to/Sberbank-CA-truststore.jks \

-J-Djavax.net.ssl.trustStorePassword=123456

Затем заполните поля Remote Process (="host:port"), Username, Password и подключитесь.

Поддержка InMemory кластера, обновление файла с пользователями и ролями#

Для настройки выполните следующие шаги:

Создайте bean

dataFileProviderSupplierвJsonSecurityDataSupplierImpl, указав в конструкторе путь до файла.Создайте bean

metaStorageListenerвSecurityDataListener, указав в конструктореdataFileProviderSupplier.Добавьте bean

metaStorageListenerвSecurityPluginConfiguration.

Пример:

<bean id="dataFileProviderSupplier" class="com.sbt.security.ignite.core.storage.metastorage.JsonSecurityDataSupplierImpl">

<constructor-arg value="path/to/security-data.json"/>

</bean>

<bean id="metaStorageListener" class="com.sbt.security.ignite.core.storage.metastorage.SecurityDataListener">

<constructor-arg ref="dataFileProviderSupplier"/>

</bean>

<util:list id="components" value-type="SecurityLifecycleAware">

<ref bean="evtRecorder"/>

<ref bean="metaStorageListener"/>

. . .

</util:list>

<bean id="securityPluginConfiguration" class="com.sbt.security.ignite.core.SecurityPluginConfiguration">

<property name="components" ref="components"/>

. . .

</bean>

Примечание

Обновление файла будет происходить при каждой записи в MetaStorage.

Утилита для генерации Salt и Salted-хеша пароля#

Пример запуска:

# java -jar security-core.jar --hash

PBKDF2 hash calculator

Password:

Once again:

Salt: A2DA8C5E73C7D90853E41514A5EA99BF119F91698A49FDDD97B68E844C146699

Salted hash: AECA32F27FD4AC0147547CC7632025504151462B5615AD7DE71895843E48F43630D8D19A002DC8B6088751D5881F4861B39230AED3429A1967DB09726DC447E3

Использование консольной утилиты управления пользователями#

Утилита управления используется как скрипт на технологическом сервере:

ise-user-control.sh connection_parameters command command_parameters

где:

connection_parameters— параметры для созданияGridClient-подключения, такие как: имя пользователя, путь к хранилищу сертификатов, наборы шифрования;command— команда администрирования;command_parameters— параметры команды администрирования;ise-user-control.sh --help— для получения справки об используемых командах. §

Проверка используемых сертификатов#

Проверка сертификатов выполняется путем подключения к JVM по JMX по адресу:

org.apache.<process_id>.<consistent_id>.Security.com.sbt.security.ignite.core.expiration.CertificateMBeanImpl.Attributes

Список атрибутов:

DistinguishedName— имя сертификата.Fingerprint— отпечаток пальца.ExpirationDate— дата окончания действия.ExpirationTimestamp— дата окончания срока действия в формате UNIX timestamp.

Примечание:

Сертификат выпускается и подписывается по запросу на обслуживание для соответствующего доменного имени технологического сервера (оно различно для ПСИ- и ПРОМ-контуров). Пользователи консоли управления будут подключаться из браузера, используя это имя.

Если порт 443 занят, то следует выбрать другой свободный порт и далее в браузере обращаться по нему.

В браузере пользовательский интерфейс утилиты управления доступен по адресу:

https://<IP-адрес технологического узла>:443/

При первом запуске кластера с плагином безопасности создается учетная запись администратора безопасности root с паролем changeit. Для успешного входа в утилиту управления потребуется сертификат категории «администратор безопасности», созданный по правилам, описанным в п. 2. Сертификат должен присутствовать в каталоге, заданном в --certificates.dir.path. Далее будет использоваться следующий стандартный алгоритм действий:

Администратор доступа устанавливает себе стойкий пароль (см. «Руководство по безопасности»).

Используя интерфейс утилиты управления, администратор доступа создает необходимые роли и учетные записи, в том числе УЗ администраторов эксплуатации.

Каждый администратор эксплуатации, используя интерфейс утилиты управления, должен сменить свой пароль (до этого никакие его действия не будут авторизованы).

Кроме root первоначально создается УЗ серверного узла, а ее логин и пароль берутся из сконфигурированного на СУ security credentials provider.

Быстрое развертывание в тестовых средах#

Для быстрого запуска Platform V DataGrid с настроенным SSL и плагином безопасности существуют:

config/serverExampleConfig.xml— конфигурации серверного узла;config/clientExampleConfig.xml— конфигурации клиентского узла;config/default-security-data.json— файл с начальными пользователями;config/certs/— сертификаты для SSL.

Установка переменной IGNITE_HOME#

$ export IGNITE_HOME=/path/to/Platform-V-Data-Grid-<version>

Редактирование JVM-опции для тестовых сертификатов#

Добавляем JVM_OPTS="$JVM_OPTS -DREQUIRE_AUDIT=false -DIGNITE_CLUSTER_TYPE=prom -DIGNITE_CLUSTER_NAME=mycluster" в $IGNITE_HOME/bin/ignite.sh

Запуск серверного узла#

$ $IGNITE_HOME/bin/ignite.sh $IGNITE_HOME/config/serverExampleConfig.xml

Запуск клиентского узла#

$ $IGNITE_HOME/bin/ignite.sh $IGNITE_HOME/config/clientExampleConfig.xml

Активация кластера#

$ $IGNITE_HOME/bin/control.sh --activate --host localhost --user operationAdmin --password default-password --keystore $IGNITE_HOME/config/certs/operationAdmin.jks --keystore-password 123456 --truststore $IGNITE_HOME/config/certs/truststore.jks --truststore-password 123456

Запуск утилиты управления пользователями#

$ java -jar $IGNITE_HOME/libs/security-plugins/ui-\<version\>.jar --server.port=8990 --ssl.disabled=true --certificates.dir.path=$IGNITE_HOME/config/certs

Подключение к кластеру через браузер#

В браузере перейдите по адресу

http://localhost:8990/.Затем заполните поля в окне авторизации:

Поле |

Значение |

|---|---|

Хост |

|

Порт |

|

Логин |

|

Пароль |

|

Протокол |

|

Алгоритм |

|

Шифр |

Оставьте поле пустым |

Key store |

|

Trust store |

|

Пароль к обоим хранилищам |

|

Начальные пароли и пользователи#

Логин |

Пароль |

Права |

|---|---|---|

|

|

Серверный узел |

|

|

Клиентский узел |

|

|

Администратор пользователей |

|

|

Администратор эксплуатации |

|

|

Администратор эксплуатации с ограниченными правами до изменения собственного пароля |

Аудит#

Аудит описывается в документе «Руководство по безопасному использованию». В настоящем руководстве приводится лишь конфигурация REST-интерфейса.

Описание REST API для внешнего аудита#

REST-интерфейс аудита#

Слушатель событий

com.sbt.security.ignite.integration.audit.rest.AuditEventListenerImplпри запуске узла регистрирует метамодель событий, отправляя ее на веб-страницуAUDIT_URL/metamodel.События, которые необходимо записывать в аудит, отправляются на веб-страницу

AUDIT_URL/event.Содержимое запросов описывается в файле

audit-client-openapi.yml.

Конфигурация для интеграции с подсистемой аудита#

Добавление в конфигурацию Ignite beans обработчика аудита событий и списка событий, необходимых для отправки в аудит#

<!-- Следующий bean содержит описание метамодели данных, которые отправляются в подсистему аудита. -->

<bean id="auditMetamodelProvider" class="com.sbt.security.ignite.integrationaudit.rest.AuditMetamodelProvider">

<!-- Наименование системы, которая записывает метамодели в аудит. -->

<constructor-arg>MODULE_ID</constructor-arg>

</bean>

<!-- Следующий bean отвечает за отправку данных в подсистему аудита. -->

<bean id="auditSender" class="com.sbt.security.ignite.integration.audit.restAuditSender">

<!-- URL, на который отправляются данные. -->

<constructor-arg>AUDIT_URL</constructor-arg>

</bean>

<bean id="auditEventListener" class="com.sbt.security.ignite.integration.auditrest.AuditEventListenerImpl">

<constructor-arg ref="auditMetamodelProvider"/>

<constructor-arg ref="auditSender"/>

</bean>

<util:list id="eventTypes" value-type="java.lang.Integer">

<!-- Коды событий, необходимые для отправки в аудит (см. пункт 3.4). -->

<value>2010</value>

<value>2011</value>

</util:list>

<util:map id="eventListeners"

map-class="java.util.HashMap"

key-type="org.apache.ignite.lang.IgnitePredicate"

value-type="java.lang.Integer[]">

<entry key-ref="auditEventListener" value-ref="eventTypes"/>

</util:map>

Добавление свойства org.apache.ignite.configuration.IgniteConfiguration в bean класса#

<property name="localEventListeners" ref="eventListeners"/>

Регистрация в подсистеме аудита событий, связанных с выполнением REST-запросов#

Добавление соответствующих beans в конфигурацию Platform V DataGrid#

<util:list id="cmdEventIgnoreList" value-type="java.lang.String">

<!-- Имена REST-команд, по которым запись в аудит вестись не будет. -->

<value>NOOP</value>

</util:list>

<bean id="restProcessorConfiguration" class="com.sbt.security.ignite.integration.audit.rest.RestProcessorPluginConfiguration">

<property name="commandEventIgnoreList" ref="cmdEventIgnoreList"/>

</bean>

<bean id="restProcessorPluginProvider" class="com.sbt.security.ignite.integration.audit.rest.RestProcessorPluginProvider">

<property name="configuration" ref="restProcessorConfiguration"/>

</bean>

Добавление свойства org.apache.ignite.configuration.IgniteConfiguration в bean класса#

<property name="pluginProviders">

<list>

<ref bean="restProcessorPluginProvider"/>

</list>

</property>

Механизм Change Data Capture (CDC) и межкластерная репликация#

Введение#

Change Data Capture (CDC) — это сценарий обработки данных, использующийся для асинхронного получения данных, измененных на локальном узле. При этом, получение записей происходит таким образом, чтобы затем с ними можно было совершать какие-либо действия.

CDC используется в следующих сценариях:

потоковая передача изменений в Хранилище;

обновление поисковых индексов;

аудит логов;

асинхронное взаимодействие со внешней системой (модерирование, запуск бизнес-процессов и прочее).

Именно на механизме CDC основывается процесс межкластерной репликации в Platform V Data Grid. CDC здесь обрабатывает сегменты WAL-журнала, а затем доставляет локальные изменения до потребителей. Информация о межкластерной репликации в Platform V Data Grid находится в разделе "Межкластерная репликация и CDC в Platform V Data Grid" ниже.

CDC запускается на всех серверных узлах кластера Platform V Data Grid в отдельной JVM, что исключает прямое влияние на основной функционал грида.

CDC в своей работе использует подход fail-fast. Это означает, что в случае неисправности CDC просто прекращает работу без автоматического восстановления.

Алгоритм работы механизма CDC#

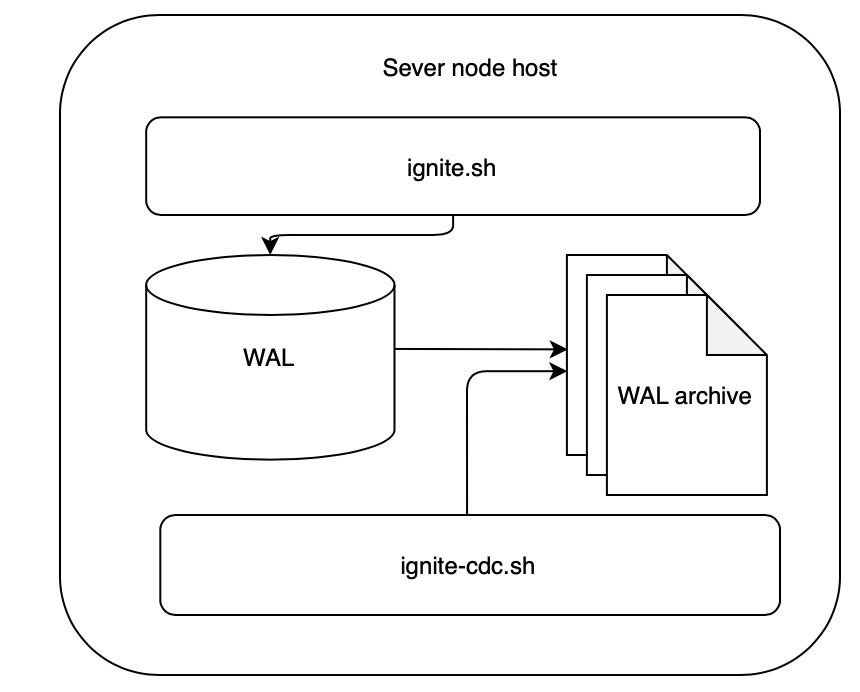

Схема работы механизма:

При включенном механизме CDC серверный узел Platform V Data Grid создает в специальной директории

db/cdc/{consistent_id}(значение по умолчанию) жесткую ссылку на каждый сегмент архива WAL-журнала.Затем, приложение

ignite-cdc.shзапускается на отдельной JVM и обрабатывает сегменты WAL-журнала, которые были перенесены в архив совсем недавно.После обработки сегмента приложением, он удаляется. Само дисковое пространство освобождается при удалении обеих ссылок (в архиве WAL-журнала и в директории CDC).

Конфигурация#

Параметры конфигурации#

Параметры конфигурации узла Platform V Data Grid#

Имя |

Описание |

Значение по умолчанию |

|---|---|---|

|

Свойство включает CDC на серверном узле |

false |

|

Путь к директории CDC |

"db/wal/cdc" |

|

Таймаут для принудительной отправки сегмента WAL-журнала в архив (даже если обработка сегмента не завершена). |

-1 (disabled) |

Параметры конфигурации приложения CDC#

Имя |

Описание |

Значение по умолчанию |

|---|---|---|

|

Таймаут для ожидания блокировки. При запуске CDC устанавливает блокировку на директорию во избежание параллельной обработки этой директории параллельно работающим приложением |

1000 мс |

|

Время между последовательными проверками, в течение которого приложение находится в спящем режиме, если новые файлы отсутствуют |

1000 мс |

|

Свойство, определяющее, должны ли ключ и значение измененных записей быть предоставлены в бинарном формате |

true |

|

Реализация |

null |

|

Ряд интерфейсов, предназначенных для экспорта метрик CDC. Для получения более подробной информации, перейдите в раздел "Метрики" данного раздела |

null |

Описание CDC API#

org.apache.ignite.cdc.CdcEvent

Имя |

Описание |

|---|---|

|

Ключ измененной записи |

|

Значение измененной записи. Метод вернет |

|

ID кеша, на котором происходит изменение. Значение метода равно значению параметра |

|

Партиция измененной записи. Возвращает номер партиции. Platform V Data Grid разбивает набор данных на более мелкие части для их распределения по кластеру. Реализации |

|

Свойство, определяющее, на каком узле происходит операция — на основном или резервном. Возвращает |

|

|

org.apache.ignite.cdc.CdcConsumer

org.apache.ignite.cdc.CdcConsumer — это потребитель событий-изменений. Потребитель может быть реализован пользователем самостоятельно. Кроме того, в дистрибутиве поставляется две реализации CDC: Platform V Data Grid to Platform V Data Grid, Platform V Data Grid to Platform V Corax to Platform V Data Grid.

Имя |

Описание |

|---|---|

|

Вызывается один раз при запуске приложения CDC. Реестр |

|

Основной метод обработки изменений. Когда данный метод возвращает |

|

Вызывается один раз при остановке приложения CDC |

CacheEntryVersion

Имя |

Описание |

|---|---|

|

Версия записи |

|

ID кеша |

|

Порядок события записи. Два параллельных обновления одной и той же записи могут быть расположены в порядке, основанном на сравнении |

|

Порядок обновления. Значение — суммирующий счетчик. Область действия счетчика — узел. Возвращает порядок версии |

|

Возвращает порядок (номер) узла, в котором была назначена данная версия |

|

ID кластера — это значение, которое определяет наличие обновлений в случае, если пользователь хочет собрать и рассортировать обновления от нескольких кластером Platform V Data Grid. |

|

Возвращает версию топологии плюс число секунд со времени запуска первого узла в кластере |

|

Если источником обновления является "локальный" кластер, то возвращается |

Межкластерная репликация и CDC в Platform V Data Grid#

Механизм межкластерной репликации основан на механизме CDC, описанном выше.

Механизм репликации асинхронный.

В зависимости от архитектуры сети и требований безопасности доступны две схемы межкластерной репликации:

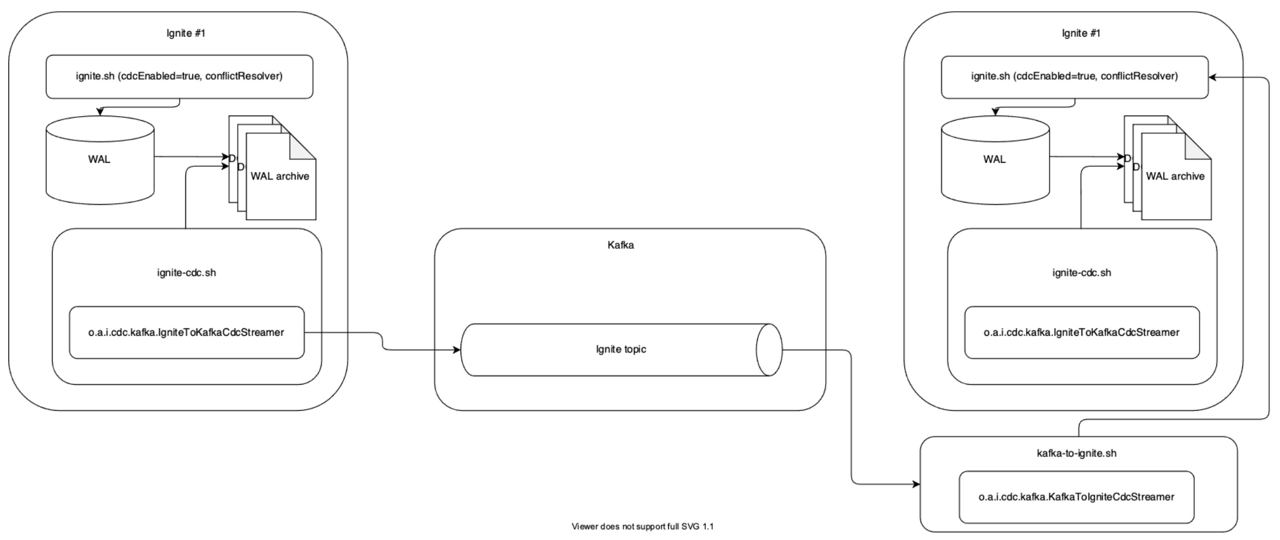

Репликация Platform V Data Grid to Platform V Data Grid.

Рекликация Platform V Data Grid to Kafka to Platform V Data Grid.

Для разрешения возможных конфликтов изменения данных при использовании Active-Active режима репликации необходимо настраивать модуль ConflictResolver для обеих схем межкластерной репликации. Подробное описание этого модуля содержится в следующем разделе.

Описание и настройка модуля conflictResolver#

В случае одновременного изменения данных на обоих кластерах (режим Active-Active), для корректного применения событий репликации необходимо настраивать модуль ConflictResolver. Этот модуль может быть разработан пользователем самостоятельно и подключен к Platform V Data Grid в виде плагина. В состав дистрибутива Platform V Data Grid включен плагин с CacheVersionConflictResolver, который позволяет разрешать конфликты на основании идентификатора кластера (clusterId), версии записи и на основании специального поля, по которому производится сравнение в случае применения конфликтующих событий репликации с разных кластеров. Данное поле должно задаваться бизнес-логикой пользователя и изменяться прикладным кодом в объектах, вставляемых в кеши, которые реплицируются посредством CDC.

Механизм работы модуля#

Алгоритм применения изменений основывается на трех принципах:

При отсутствии пересечений данные отправляются на запись.

При наличии конфликта в зависимости от настройки принимается решение о его разрешении в порядке убывания приоритета:

Если изменение локальное, т.е.

clusterIdсоответствует текущему кластеру, то оно приоритетнее любого удалённого.Если изменение удалённое, то предпочтение отдаётся изменению с большей версией (

CacheEntryVersion).На основании сравнения по пользовательскому полю (

conflictResolveField). Поле должно быть добавлено в пользовательские объекты, хранимые в реплицируемых кешах, его значение должно обновляться посредством пользовательского кода. Так как решение принимается на основании значения поля (применятся изменение с большим значением поля), поле должно реализовывать интерфейсСomparable.

При невозможности разрешить конфликт изменение отбрасывается, что приводит к потере консистентности между кластерами.

Примечание

Для обеспечения максимальной производительности и во избежание ситуации, описанной в пункте 3, рекомендуется избегать пересечений по ключам при проектировании, а при наличии пересечений обоснованно выбирать поля для сравнения изменений.

Пример настройки плагина CacheVersionConflictResolver#

<property name="pluginProviders">

<list>

<bean class="org.apache.ignite.cdc.conflictresolve.CacheVersionConflictResolverPluginProvider">

<property name="clusterId" value="1"/>

<property name="caches">

<set>

<value>terminator</value>

</set>

</property>

<property name="conflictResolveField" value="modificationDate"/>

</bean>

</list>

</property>

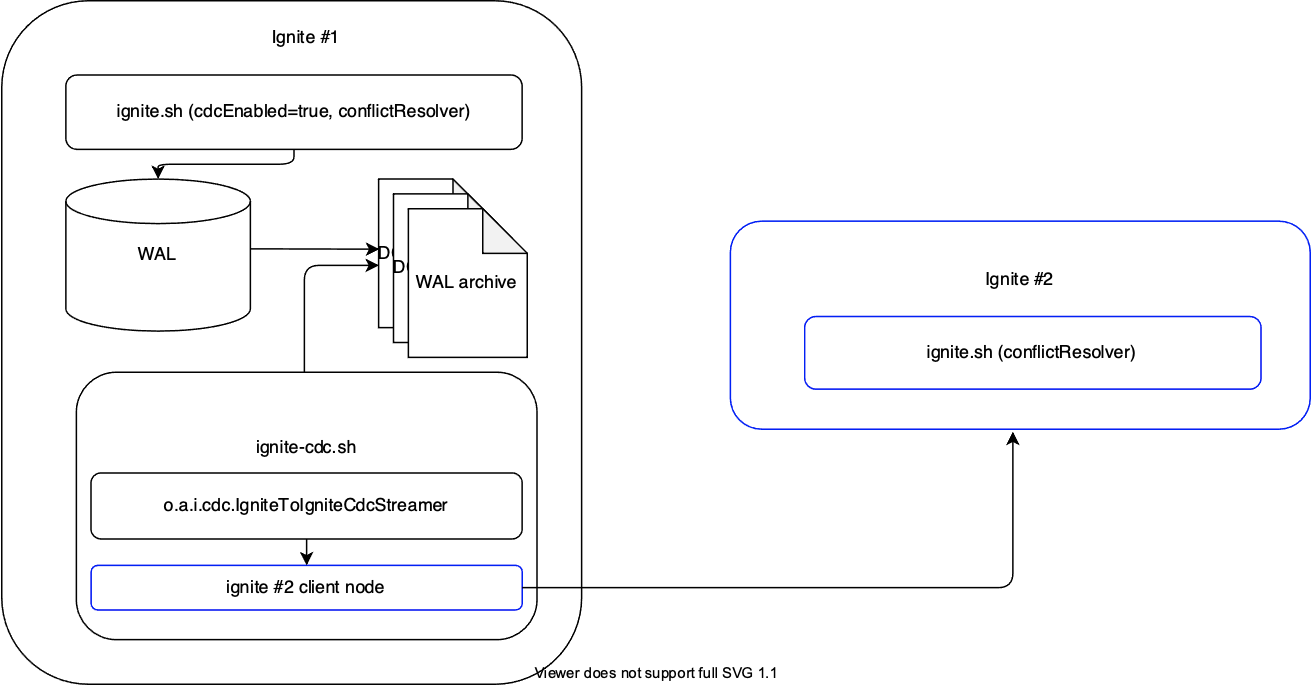

Репликация Platform V Data Grid to Platform V Data Grid#

Данная схема репликации требует возможности организации прямого соединения между двумя кластерами Platform V Data Grid.

Примечание

На текущий момент данная схема позволяет обеспечить репликацию только между двумя кластерами. Для соединения более двух кластером можно воспользоваться схемой Platform V Data Grid to Platform V Corax to Plstform V Data grid.

Основным элементом схемы является приложение IgniteToIgniteCDCStreamer. Это приложение захватывает и передает изменения записей из WAL-журнала на сторонний узел. Приложение содержит клиентский узел Platform V Data Grid, подключающийся к узлу в кластере назначения (на схеме — Ignite#2).

Пример и описание конфигурации#

Примечание

Данная конфигурация предназначена для локального развертывания (на localhost). Настройки указаны для примера.

Конфигурация кластера-источника:

Имя файла: ignite-1984.xml

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xmlns:util="http://www.springframework.org/schema/util"

xsi:schemaLocation="

http://www.springframework.org/schema/beans http://www.springframework.org/schema/beans/spring-beans.xsd

http://www.springframework.org/schema/util http://www.springframework.org/schema/util/spring-util.xsd">

<bean id="grid.cfg" class="org.apache.ignite.configuration.IgniteConfiguration">

<property name="igniteInstanceName" value="ignite-1984-server" />

<property name="consistentId" value="ignite-1984-server" />

<property name="peerClassLoadingEnabled" value="true" />

<property name="localHost" value="127.0.0.1" />

<property name="discoverySpi">

<bean class="org.apache.ignite.spi.discovery.tcp.TcpDiscoverySpi">

<property name="localPort" value="47500" />

<property name="ipFinder">

<bean class="org.apache.ignite.spi.discovery.tcp.ipfinder.vm.TcpDiscoveryVmIpFinder">

<property name="addresses"

value="127.0.0.1:47500..47510" />

</bean>

</property>

<property name="joinTimeout" value="10000" />

</bean>

</property>

<property name="dataStorageConfiguration">

<bean class="org.apache.ignite.configuration.DataStorageConfiguration">

<property name="defaultDataRegionConfiguration">

<bean class="org.apache.ignite.configuration.DataRegionConfiguration">

<property name="persistenceEnabled" value="true" />

</bean>

</property>

<property name="cdcEnabled" value="true" />

<!--Свойство cdcEnabled выше включает функционал CDC.-->

<property name="walForceArchiveTimeout" value="5000"/>

<!--При данном значении свойства walForceArchiveTimeout выше каждый сегмент WAL-журнала будет доступен для обработки через 5 секунд после перенесения его в архив-->

</bean>

</property>

<!--Ниже необходимо указать конфигурацию модуля conflictResolver-->

<property name="pluginProviders">

<bean class="org.apache.ignite.cdc.conflictresolve.CacheVersionConflictResolverPluginProvider">

<property name="clusterId" value="1" />

<!--clusterId (выше) должен быть разным для каждого кластера-->

<!--Ниже необходимо сконфигурировать кeши, для которых будет срабатывать conflictResolver-->

<property name="caches">

<util:list>

<bean class="java.lang.String">

<constructor-arg type="String" value="terminator" />

<property name="conflictResolveField" value="modificationDate"/>

</bean>

</util:list>

</property>

</bean>

</property>

<property name="cacheConfiguration">

<list>

<bean class="org.apache.ignite.configuration.CacheConfiguration">

<property name="atomicityMode" value="ATOMIC"/>

<property name="name" value="terminator"/>

</bean>

</list>

</property>

</bean>

<!--Ниже указывается конфигурация механизма CDC. Утилита ignite-cdc.sh должна запускаться на всех серверных узлах кластера Platform V Data Grid, поэтому конфигурация CDC хранится в том же файле, в котором хранится конфигурация серверного узла.-->

<bean id="cdc.cfg" class="org.apache.ignite.cdc.CdcConfiguration">

<!--Конфигурация здесь отличается от конфигурации по умолчанию только свойством consumer (потребитель). Здесь оно имеет класс `IgniteToIgniteCdcStreamer`-->

<property name="consumer" ref="cdc.streamer" />

</bean>

<!--Внутри класса передается конфигурация клиентского узла, который будет подключаться к кластеру-получателю данных.-->

<bean id="cdc.streamer" class="org.apache.ignite.cdc.IgniteToIgniteCdcStreamer">

<constructor-arg index="0">

<!--0 здесь означает параметр destIgniteCfg — конфигурацию узла-получателя-->

<bean class="org.apache.ignite.configuration.IgniteConfiguration">

<property name="igniteInstanceName" value="ignite-2029-cdc-client" />

<property name="clientMode" value="true" />

<property name="peerClassLoadingEnabled" value="true" />

<property name="localHost" value="127.0.0.1" />

<property name="discoverySpi">

<bean class="org.apache.ignite.spi.discovery.tcp.TcpDiscoverySpi">

<property name="localPort" value="47600" />

<property name="ipFinder">

<bean class="org.apache.ignite.spi.discovery.tcp.ipfinder.vm.TcpDiscoveryVmIpFinder">

<!--В свойстве ниже указываются адреса кластера-получателя-->

<property name="addresses"

value="127.0.0.1:47600..47610" />

</bean>

</property>

<property name="joinTimeout" value="10000" />

</bean>

</property>

</bean>

</constructor-arg>

<!--1 ниже обозначает свойство onlyPrimary — оно отвечает за то, какие партиции будут реплицироваться: либо только primary-партиции, либо все, чтобы в случае выхода primary-партиции из строя изменения поступили от backup-партиций-->

<constructor-arg index="1" value="false" />

<!--2 ниже означает параметр caches — список реплицируемых кешей.-->

<constructor-arg index="2">

<util:list>

<bean class="java.lang.String">

<constructor-arg type="String" value="terminator" />

</bean>

</util:list>

</constructor-arg>

<!--3 ниже обозначает параметр maxBatchSize — максимальный размер пакета изменений, которые необходимо применить-->

<constructor-arg index="3" value="256" />

</bean>

</beans>

Конфигурация кластера-получателя:

Примечание

Представленная ниже конфигурация актуальна для режима репликации Active-Active. При использовании режима Active-Passive на кластере-получателе

org.apache.ignite.cdc.CdcConfigurationне настраивается. Также при Active-Passive на обоих кластерах не потребуется настройкаconflictResolver. Для получения более подробной информации о режимах репликации, перейдите к разделу "Режимы репликации" ниже.

Имя файла: ignite-2029.xml

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xmlns:util="http://www.springframework.org/schema/util"

xsi:schemaLocation="

http://www.springframework.org/schema/beans http://www.springframework.org/schema/beans/spring-beans.xsd

http://www.springframework.org/schema/util http://www.springframework.org/schema/util/spring-util.xsd">

<bean id="grid.cfg" class="org.apache.ignite.configuration.IgniteConfiguration">

<property name="igniteInstanceName" value="ignite-2029" />

<property name="consistentId" value="ignite-2029" />

<property name="peerClassLoadingEnabled" value="true" />

<property name="localHost" value="127.0.0.1" />

<property name="discoverySpi">

<bean class="org.apache.ignite.spi.discovery.tcp.TcpDiscoverySpi">

<property name="localPort" value="47600" />

<property name="ipFinder">

<bean class="org.apache.ignite.spi.discovery.tcp.ipfinder.vm.TcpDiscoveryVmIpFinder">

<property name="addresses"

value="127.0.0.1:47600..47610" />

</bean>

</property>

<property name="joinTimeout" value="10000" />

</bean>

</property>

<property name="dataStorageConfiguration">

<bean class="org.apache.ignite.configuration.DataStorageConfiguration">

<property name="defaultDataRegionConfiguration">

<bean class="org.apache.ignite.configuration.DataRegionConfiguration">

<property name="persistenceEnabled" value="true" />

</bean>

</property>

<property name="cdcEnabled" value="true" />

<property name="walForceArchiveTimeout" value="5000"/>

</bean>

</property>

<property name="pluginProviders">

<bean class="org.apache.ignite.cdc.conflictresolve.CacheVersionConflictResolverPluginProvider">