Руководство по установке#

О документе#

Настоящий документ предназначен для описания процесса установки продукта Platform V Index Search (IXS).

Основные понятия#

В таблице приведены основные аббревиатуры, сокращения и термины:

Термин |

Описание |

|---|---|

Продукт |

Platform V Index Search (IXS) |

API |

Application programming interface. Интерфейс прикладного программирования |

ETL |

Extract, Transform, Load. Компонент продукта Platform V Index Search, основанный на данном принципе управления хранилищем данных |

KFKA |

Компонент Kafka SE (KAFKA) продукта Platform V Corax (KFK) |

MQ |

Messages queue |

POD, под |

Plain old data. Абстрактный объект, набор контейнеров в архитектуре Kubernetes |

SSL |

Secure Sockets Layer. Криптографический протокол, который подразумевает более безопасную связь |

URL |

Uniform Resource Locator. Унифицированный указатель ресурса |

GitLab (CE),Git |

Веб-сервис для проектов и их совместной разработки |

CPU |

Central Processing Unit, центральный процессор |

Jenkins/JOB |

Продукт, распространяемый под лицензией Apache 2.0. Программная система с открытым исходным кодом на Java, предназначенная для обеспечения процесса непрерывной интеграции программного обеспечения; джоба Jenkins |

Istio |

Настраиваемая сервисная сеть (service mesh) с открытым исходным кодом, служащая для взаимодействия, мониторинга и обеспечения безопасности контейнеров в кластере Kubernetes. Platform V Synapse Service Mesh или istio |

ОТТ |

Platform V One-Time-Token. Сервис для выпуска и подтверждения валидности выпущенных токенов. Компонент One-Time Password (OTTS) продукта Platform V One-Time-Token (ОТТ) входит в состав bundle Platform V Backend |

АС |

Автоматизированная система |

ЗНО |

Запрос на обслуживание |

ОС |

Операционная система |

Среда контейнеризации |

Kubernetes или Red Hat OpenShift 4+ (опционально) |

ТУЗ |

Техническая учетная запись |

УЦ |

Удостоверяющий центр |

Common-репозиторий |

Репозиторий глобальных параметров среды/полигона/стенда. Репозиторий с общими настройками Pipeline, при условии использования опционально компонента Deploy Tools (CDJE), входящего в состав продукта Platform V DevOps Tools (DOT), продукт входит в состав bundle Platform V Backend |

Системные требования#

В данном разделе перечислены пре-реквизиты и требования к окружению для установки программного продукта, в том числе рекомендуемые настройки безопасности окружения. Также представлен перечень внешних продуктов, используемых для установки, настройки и контроля с указанием выполняемых ими функций.

Здесь и далее поддерживаемой системой приложений-контейнеров является Kubernetes (использование OpenShift – опционально), в именах и параметрах системы могут встречаться названия систем контейнеризации, в этом случае они одинаковы и применимы для обоих сред контейнеризации.

Операционная система

Наименование |

Версия |

Применение |

|---|---|---|

ОС Альт 8 СП |

10.0 и выше |

Рекомендовано |

Red Hat Enterprise Linux |

3.10 и выше |

Опционально |

Среда контейнеризации

Необходимое окружение для разворачивания компонента: Kubernetes — версии 1.0 и выше или OpenShift версии 4.2 и выше (далее — среда контейнеризации).

Наименование |

Версия |

Применение |

|---|---|---|

Kubernetes |

1.0 и выше |

Рекомендовано |

Red Hat OpenShift |

4.2 и выше |

Опционально |

Java-машина

Наименование |

Версия |

Применение |

|---|---|---|

OpenJDK |

1.8 и выше |

Рекомендовано |

OracleJDK |

1.8 и выше |

Опционально |

Поисковая система

Наименование |

Версия |

Применение |

|---|---|---|

ElasticSearch |

7.10.2 |

Рекомендовано |

kibana |

7.10.2 |

Опционально |

Браузер

Наименование |

Версия |

Применение |

|---|---|---|

Яндекс |

любая актуальная версия |

Рекомендовано |

Google Chrome |

любая актуальная версия |

Опционально |

Брокер сообщений

Наименование |

Версия |

Применение |

|---|---|---|

Kafka |

2.7.0 и выше |

Рекомендовано Platform V Corax |

Инструмент управления проектом

Наименование |

Версия |

Применение |

|---|---|---|

Apache Maven |

любая актуальная версия |

Рекомендовано |

Сервис централизованного хранения репозиториев артефактов (хранилище артефактов)

Наименование |

Версия |

Применение |

|---|---|---|

Nexus-Public |

2.5.1 и выше |

Рекомендовано |

Nexus Repository Manager PRO |

любая актуальная версия |

Опционально |

Nexus Repository Manager OSS |

любая актуальная версия |

Опционально |

Сервис централизованного хранения репозиториев исходного кода

Наименование |

Версия |

Применение |

|---|---|---|

GitLab |

15.0 и выше |

Рекомендовано |

Bitbucket |

7.6 и выше |

Опционально |

Система мониторинга сборки

Наименование |

Версия |

Применение |

Комментарий |

|---|---|---|---|

Prometheus |

2.31 и выше |

Рекомендовано |

Программное обеспечение для анализа численных метрик работы сценария. Интеграция и настройка описаны в официальной документации Prometheus |

Grafana |

2.5.0 и выше |

Рекомендовано |

Программное обеспечение для визуализации численных метрик работы сценария (предоставленных, например, Prometheus). Интеграция и настройка описаны в официальной документации Prometheus |

Платформенные зависимости

Для настройки, контроля и функционирования компонента реализована интеграция с программными продуктами, правообладателем которых является АО «СберТех»:

Наименование продукта |

Код |

Версия |

Код и наименование компонента |

Обязательность установки |

Описание |

|---|---|---|---|---|---|

Platform V IAM SE |

IAM |

- |

AUTH IAM Proxy |

Опционально |

IDP - провайдер, выполняющий функции управления доступа пользователей/клиентов (приложений), а также функции аутентификации/авторизации с помощью различных протоколов, таких как OAuth2.0, OIDC, SCIM |

Platform V Frontend Std |

#FS |

- |

*ATZE Авторизация |

Опционально |

Сервис авторизации пользователя |

Platform V Frontend Std |

#FS |

3.27.11 |

*LOGE Журналирование |

Опционально |

Сервис для хранения лог-файлов |

Platform V Frontend Std |

#FS |

- |

*MONE Компонент Прикладной мониторинг продукта Platform V Frontend Std |

Опционально |

Сбор метрик производительности работы продукта |

Platform V Backend |

#BD |

1.8.0-4.1.21 |

OTTS One-Time Password |

Опционально |

Сервис для аутентификации и авторизации межсервисных взаимодействий |

Platform V Frontend Std |

#FS |

- |

*CFGE Компонент Управления параметрами продукта Platform V Frontend Std |

Опционально |

Сервис обеспечивает хранение, управление и предоставление по запросу параметров конфигурации библиотек, сервисов Платформы и прикладных приложений, разработанных на Платформе |

Platform V Dictionaries |

SDT |

- |

NSIE Справочники |

Опционально |

Сервис предоставления справочных данных |

Platform V Audit SE |

AUD |

- |

*AUDE Аудит |

Опционально |

Контроль за работой пользователя с продуктом |

*Примечание: может потребоваться для обеспечения обратной совместимости

Обязательными условиями для установки продукта являются:

для продукта выделены области в среде контейнеризации;

развернута система полнотекстового поиска ElasticSearch OSS;

установлен плагин Security OpenDistro for ElasticSearch;

выделенные области включены под управление service mesh (istio). Для подключения проекта к istio воспользуйтесь документацией продукта Platform V Synapse Service Mesh;

jenkins с заведенными секретами для доступа к Git, Хранилищу артефактов и Докеру Хранилища;

в проекте среды контейнеризации присутствует секрет для доступа к приватному хранилищу контейнеров (docker-regestry);

в проекте среды контейнеризации присутствует сервисный аккаунт (Service Account) и созданы роли для разворачивания в namespaces (project) приложения (типовые роли Deploy или Jenkins cd).

Требования

Для пространства среды контейнеризации необходим проект с характеристиками 16 CPU и 32 GB memory.

Используемые внешние продукты

Внешний продукт |

Назначение |

|---|---|

Jenkins |

Запускает и выполняет процедуру установки |

Git хранилище |

Репозиторий для хранения скрипта процедуры установки, секретов среды контейнеризации Kubernetes или Red Hat OpenShift 4+ (опционально), параметров установки, хранилищ сертификатов, ключей, паролей к ним для тестов и процесса обновления структуры базы данных |

Nexus-Public |

Хранение дистрибутивов продукта |

Command line tool (kubectl) |

Клиент среды контейнеризации Kubernetes или Red Hat OpenShift 4+ (опционально) для выполнения команд по созданию, модификации, получению, удалению ресурсов среды контейнеризации Kubernetes или Red Hat OpenShift 4+ (опционально) |

Дистрибутив

Дистрибутив представляет собой zip-файл, опубликованный в хранилище. Дистрибутив содержит разделенный целевой дистрибутив Party-distrib.zip. Включает набор библиотек и зависимостей, распространяющихся свободно. Owned-distrib.zip – содержит основной код продукта.

Установка#

Для установки продукта Platform V IndexSearch используется ручной способ, который является целевым.

Ручная установка#

Текущий тип установки является целевым (основным) вариантом установки.

Для ручной установки: выполните установку ElasticSearch OSS. Кластер должен состоять минимум из трех машин. На каждой машине необходимо выполнить следующие действия:

Установите два пакета elasticsearch-oss-7.10.2-x86_64.rpm opendistroforelasticsearch-kibana-1.13.2-linux-x64.rpm

или

Скачать и скомпилировать из источника.

Перейдите на сайт https://github.com/elastic/elasticsearch/releases/tag/v7.10.2.

Выберите Source code (zip).

Выполните разархивацию.

Выполнить команду

gradlew :distribution:archives:linux-tar:assemble

Скопируйте на сервер distributions/archives

opendistro-alerting-1.13.1.0.rpm opendistro-anomaly-detection-1.13.0.0.rpm opendistro-asynchronous-search-1.13.0.1.rpm opendistro-index-management-1.13.2.0.rpm opendistro-job-scheduler-1.13.0.0.rpm opendistro-performance-analyzer-1.13.0.0.rpm opendistro-reports-scheduler-1.13.0.0.rpm opendistro-security-1.13.1.0.rpm opendistro-sql-1.13.2.0.rpm

После обновления выполните следующие настройки:

Автостарт сервисов elasticsearch, kibana после перезагрузки включен по умолчанию.

В /etc/sysctl.conf задайте параметры ядра vm.max_map_count=262144 vm.swappiness=0

Создайте пользователя elk:elk. Создайте группу elk-oss, добавьте пользователей elasticsearch, kibana, elk в группу elk-oss. Пользователя elk включите в группы elasticsearch, kibana

Дать права пользователю elk выполнять команды без ввода пароля:

sudo systemctl (start,stop,restart,disable,enable) elasticsearch sudo systemctl (start,stop,restart,disable,enable) elasticsearch.service sudo systemctl (start,stop,restart,disable,enable) kibana sudo systemctl (start,stop,restart,disable,enable) kibana.service sudo update-ca-trust extractРаспределение прав: создайте отсутствующие папки, назначьте права

sudo chown -R elasticsearch:elk-oss /etc/elasticsearch sudo chown -R kibana:elk-oss /etc/kibana sudo chown elk:elk-oss /ELK sudo chmod 775 /etc/elasticsearch sudo chmod 775 /etc/kibana sudo chown -R elasticsearch:elk-oss /ELK/logs/elasticsearch sudo chown -R kibana:elk-oss /ELK/logs/kibana sudo chown -R elasticsearch:elk-oss /ELK/store/elasticsearch sudo chown -R kibana:elk-oss /ELK/store/kibana sudo chown -R elasticsearch:elk-oss /usr/share/elasticsearch sudo chown -R kibana:elk-oss /usr/share/kibana sudo chmod 775 /ELK/logs/elasticsearch sudo chmod 775 /ELK/logs/kibana sudo chmod 774 /ELK/store/elasticsearch sudo chmod 775 /ELK/store/kibana sudo chmod 775 /usr/share/elasticsearch sudo chmod 775 /usr/share/kibana sudo chown elasticsearch:elk-oss /etc/sysconfig/elasticsearch sudo chmod o+w /etc/pki/ca-trust/source/anchors/ sudo chmod o+w /etc/pki/ca-trust/extracted/java/cacerts sudo usermod -aG elk-oss elasticsearch sudo usermod -aG elk-oss kibana sudo usermod -aG elk-oss elk sudo usermod -aG elasticsearch elk sudo usermod -aG kibana elk sudo usermod -aG elk elasticsearch sudo usermod -aG elk kibana

Необходимы права для УЗ: "elk" на запуск команд из под sudo на выданных linux серверах:

sudo /usr/share/elasticsearch/bin/elasticsearch-node detach-cluster sudo /usr/share/elasticsearch/bin/elasticsearch-node unsafe-bootstrap

Перенесите файл - /usr/lib/systemd/system/elasticsearch.service

В /etc/systemd/system

Добавьте в файл elasticsearch.service

в секции [Service] строку LimitMEMLOCK=infinity

Выполните systemctl daemon-reload

/etc/sysctl.conf vm.max_map_count=262144 vm.swappiness=0

Опциональная установка плагина Аудит в Elasticsearch#

Скопируйте два файла:

Файл c Java-кодом audit-plugin-1.0.0.jar должен быть скопирован в <Путь до директории с установленным Elasticsearch>/plugins/opendistro_security/audit-plugin-1.0.0.jar.

Файл с настройками platformv-gudron.properties, использующимися для работы Java-кода, должен быть скопирован в <Путь до директории с установленным Elasticsearch>/config/platformv-gudron.properties. Перезапустите Elasticsearch

Выполните установку приложений ufs-index-search-proxy и ufs-index-search-indexer в k8s/openshift (опционально).

Перейдите в webUI OKD или воспользуйтесь kubectl для установки манифестов.

Установите секрет docker-registry для скачивания из repository.

Установите конфигурационные файлы:

kind: ConfigMap

apiVersion: v1

metadata:

name: ufs-index-search-proxy

namespace: tribe-pf-dev-idxs-k8s

uid: a81ad03c-9eff-47d3-a10d-d4b5452f85f6

resourceVersion: '72932620'

creationTimestamp: '2022-07-25T21:13:12Z'

managedFields:

- manager: Mozilla

operation: Update

apiVersion: v1

time: '2022-07-25T21:13:12Z'

fieldsType: FieldsV1

fieldsV1:

'f:data':

.: {}

'f:ufs-index-search-proxy..json': {}

data:

ufs-index-search-proxy..json: |

{ "version": "1.0","parameters": [{

"name": "ufs.tenant.code",

"description": "TENANT CODE",

"isList": false,

"type": "STRING",

"bundle": [

{

"path": [],

"values": [

"@ufs.tenant.code@"

]

}

]

},

{

"name": "ufs.baseurl.elastic.indexer",

"description": "URL elasticsearch",

"isList": false,

"type": "STRING",

"bundle": [

{

"path": [],

"values": [

"@elastic.protocol@://@elastic.host@:@elastic.port@"

]

}

]

},

{

"name": "ufs.httpclient.time-out.request.milliseconds.elastic.indexer",

"description": "Таймаут запроса в миллисекундах; значение по умолчанию - 10000, где 0 - бесконечный таймаут",

"isList": false,

"type": "LONG",

"bundle": [

{

"path": [],

"values": [

10000

]

}

]

},

{

"name": "bfs.index.indexer.domain.lock.time",

"description": "Максимальное время валидности lock-а",

"isList": false,

"type": "LONG",

"bundle": [

{

"path": [],

"values": [

10000

]

}

]}]}

kind: ConfigMap

apiVersion: v1

metadata:

name: ufs-index-search-indexer

namespace: tribe-pf-dev-idxs-k8s

uid: d401b89a-8173-4906-a3c0-0101c254a370

resourceVersion: '70393721'

creationTimestamp: '2022-07-21T09:01:17Z'

managedFields:

- manager: Mozilla

operation: Update

apiVersion: v1

time: '2022-07-21T10:42:24Z'

fieldsType: FieldsV1

fieldsV1:

'f:data':

.: {}

'f:ufs-index-search-indexer..json': {}

data:

ufs-index-search-indexer..json: |

{ "version": "1.0","parameters": [{

"name": "ufs.tenant.code",

"description": "TENANT CODE",

"isList": false,

"type": "STRING",

"bundle": [

{

"path": [],

"values": [

"@ufs.tenant.code@"

]

}

]

},

{

"name": "ufs.baseurl.elastic.indexer",

"description": "URL elasticsearch",

"isList": false,

"type": "STRING",

"bundle": [

{

"path": [],

"values": [

"@elastic.protocol@://@elastic.host@:@elastic.port@"

]

}

]

},

{

"name": "ufs.httpclient.time-out.request.milliseconds.elastic.indexer",

"description": "Таймаут запроса в миллисекундах; значение по умолчанию - 10000, где 0 - бесконечный таймаут",

"isList": false,

"type": "LONG",

"bundle": [

{

"path": [],

"values": [

10000

]

}

]

},

{

"name": "bfs.index.indexer.domain.lock.time",

"description": "Максимальное время валидности lock-а",

"isList": false,

"type": "LONG",

"bundle": [

{

"path": [],

"values": [

10000

]

}

]}]}

Установка в среду контейнеризации Kubernetes (основная):

kind: Deployment

apiVersion: apps/v1

metadata:

name: ufs-index-search-proxy

namespace: tribe-pf-dev-idxs-k8s

labels:

app: ufs-index-search-proxy

annotations:

deployment.kubernetes.io/revision: '1'

spec:

replicas: 1

selector:

matchLabels:

app: proxy

template:

metadata:

creationTimestamp: null

labels:

app: proxy

spec:

imagePullSecrets:

- name: docker-dp-pull

containers:

- name: ufs-index-search-proxy

image: >-

xxx.sw.sbc.space/public/efs/ci00982654_bfs_oseo/ufs-index-search-proxy@sha256:e57ce8a40cd3c0025f9418f449c7c28b8de8e15aa7c3bce895f5651e73887466

ports:

- containerPort: 8080

protocol: TCP

resources:

limits:

cpu: '1'

memory: 2Gi

requests:

cpu: '1'

memory: 2Gi

terminationMessagePath: /dev/termination-log

terminationMessagePolicy: File

imagePullPolicy: IfNotPresent

env:

- name: ufs.tenant.code

value: 'DICT'

- name: ufs.platform.config.directory

value: /opt/conf/index-search/proxy/config

- name: idxs.elasticsearch.urls

value: 'http://srv-32-27.pf.dev.xxx:9200'

- name: spring.profiles.active

value: 'DEV,stubMode'

- name: STAND_TYPE

value: DEV

- name: USER_INSTALL_ROOT

value: /opt/conf

- name: jaas.ufs-index-search-proxy.user

value: elastic

- name: jaas.ufs-index-search-proxy.password

value: Elastic_pass1

volumeMounts:

- name: ufsparams-config-volume

mountPath: /opt/conf/ufsparams/config

- name: config

mountPath: /tmp/ufsparams/config

- name: config-proxy

mountPath: /opt/conf/index-search/proxy/config

volumes:

- name: config

configMap:

name: configtmp

defaultMode: 288

- name: ufsparams-config-volume

emtyDir: { }

- name: config-proxy

configMap:

name: ufs-index-search-proxy

defaultMode: 288

restartPolicy: Always

terminationGracePeriodSeconds: 30

dnsPolicy: ClusterFirst

securityContext: { }

schedulerName: default-scheduler

strategy:

type: RollingUpdate

rollingUpdate:

maxUnavailable: 25%

maxSurge: 25%

revisionHistoryLimit: 10

progressDeadlineSeconds: 600

kind: Deployment

apiVersion: apps/v1

metadata:

name: ufs-index-search-indexer

namespace: tribe-pf-dev-idxs-k8s

labels:

app: ufs-index-search-indexer

uid: b1ebeab9-1393-469b-9a5a-4dac3e7e03e3

resourceVersion: '69812785'

generation: 1

creationTimestamp: '2022-07-20T10:33:53Z'

annotations:

deployment.kubernetes.io/revision: '1'

spec:

replicas: 1

selector:

matchLabels:

app: idx

template:

metadata:

creationTimestamp: null

labels:

app: idx

spec:

imagePullSecrets:

- name: docker-dp-pull

containers:

- name: ufs-index-search-indexer

image: >-

xxx.sw.sbc.space/public/efs/ci00982654_bfs_oseo/ufs-index-search-indexer@sha256:32f5af2e7b94af5eebe558ce2e8ad703fa345a14ba35e157a70932c96fd448b2

ports:

- containerPort: 8080

protocol: TCP

resources:

limits:

cpu: '1'

memory: 2Gi

requests:

cpu: '1'

memory: 2Gi

terminationMessagePath: /dev/termination-log

terminationMessagePolicy: File

imagePullPolicy: IfNotPresent

env:

- name: ufs.tenant.code

value: 'DICT'

- name: ufs.platform.config.directory

value: /opt/conf/index-search/indexer/config

- name: idxs.elasticsearch.urls

value: 'http://srv-32-27.pf.dev.xxx:9200'

- name: spring.profiles.active

value: 'DEV,stubMode'

- name: STAND_TYPE

value: DEV

- name: USER_INSTALL_ROOT

value: /opt/conf

- name: jaas.ufs-index-search-etl.user

value: elastic

- name: jaas.ufs-index-search-etl.password

value: Elastic_pass1

volumeMounts:

- name: ufsparams-config-volume

mountPath: /opt/conf/ufsparams/config

- name: config

mountPath: /tmp/ufsparams/config

- name: config-indexer

mountPath: /opt/conf/index-search/indexer/config

volumes:

- name: config

configMap:

name: configtmp

defaultMode: 288

- name: ufsparams-config-volume

emtyDir: {}

- name: config-indexer

configMap:

name: ufs-index-search-indexer

defaultMode: 288

restartPolicy: Always

terminationGracePeriodSeconds: 30

dnsPolicy: ClusterFirst

securityContext: {}

schedulerName: default-scheduler

strategy:

type: RollingUpdate

rollingUpdate:

maxUnavailable: 25%

maxSurge: 25%

revisionHistoryLimit: 10

progressDeadlineSeconds: 600

Установка Services:

kind: Service

apiVersion: v1

metadata:

name: idx

namespace: tribe-pf-dev-idxs-k8s

uid: a393d364-5a81-480e-ab31-c36dddb65944

resourceVersion: '70931309'

creationTimestamp: '2022-07-22T09:02:17Z'

managedFields:

- manager: Mozilla

operation: Update

apiVersion: v1

time: '2022-07-22T09:02:17Z'

fieldsType: FieldsV1

fieldsV1:

'f:spec':

'f:ports':

.: {}

'k:{"port":80,"protocol":"TCP"}':

.: {}

'f:port': {}

'f:protocol': {}

'f:targetPort': {}

'f:selector':

.: {}

'f:app': {}

'f:sessionAffinity': {}

'f:type': {}

spec:

ports:

- protocol: TCP

port: 80

targetPort: 8080

selector:

app: idx

clusterIP: 10.233.47.126

clusterIPs:

- 10.233.47.126

type: ClusterIP

sessionAffinity: None

ipFamilies:

- IPv4

ipFamilyPolicy: SingleStack

status:

loadBalancer: {}

kind: Service

apiVersion: v1

metadata:

name: proxy

namespace: tribe-pf-dev-idxs-k8s

uid: 995e0990-d7f4-4f86-b9e2-4e84647dc0c0

resourceVersion: '72719914'

creationTimestamp: '2022-07-25T12:19:08Z'

managedFields:

- manager: Mozilla

operation: Update

apiVersion: v1

time: '2022-07-25T12:19:08Z'

fieldsType: FieldsV1

fieldsV1:

'f:spec':

'f:ports':

.: {}

'k:{"port":80,"protocol":"TCP"}':

.: {}

'f:port': {}

'f:protocol': {}

'f:targetPort': {}

'f:selector':

.: {}

'f:app': {}

'f:sessionAffinity': {}

'f:type': {}

spec:

ports:

- protocol: TCP

port: 80

targetPort: 8080

selector:

app: proxy

clusterIP: 10.233.10.29

clusterIPs:

- 10.233.10.29

type: ClusterIP

sessionAffinity: None

ipFamilies:

- IPv4

ipFamilyPolicy: SingleStack

status:

loadBalancer: {}

Установка Ingress:

kind: Ingress

apiVersion: networking.k8s.io/v1

metadata:

annotations:

kubernetes.io/ingress.class: haproxy

resourceVersion: '72726360'

name: ingress-router

uid: 6ecf8bd4-14d5-460f-907b-1f882a2edd6e

creationTimestamp: '2022-07-19T07:53:36Z'

generation: 7

managedFields:

- manager: Mozilla

operation: Update

apiVersion: networking.k8s.io/v1

time: '2022-06-23T12:09:22Z'

fieldsType: FieldsV1

fieldsV1:

'f:metadata':

'f:annotations':

.: {}

'f:kubernetes.io/ingress.class': {}

'f:labels':

.: {}

'f:type': {}

'f:spec':

'f:rules': {}

- manager: haproxy-ingress-controller

operation: Update

apiVersion: networking.k8s.io/v1

time: '2022-06-23T12:09:26Z'

fieldsType: FieldsV1

fieldsV1:

'f:status':

'f:loadBalancer':

'f:ingress': {}

namespace: tribe-pf-dev-idxs-k8s

labels:

type: ingress-route

spec:

rules:

- host: idxs.apps.k8s.devpub.solution.xxx

http:

paths:

- path: /

pathType: ImplementationSpecific

backend:

service:

name: idx

port:

number: 8080

- host: proxy.apps.k8s.devpub.solution.xxx

http:

paths:

- path: /

pathType: ImplementationSpecific

backend:

service:

name: proxy

port:

number: 8080

status:

loadBalancer:

ingress:

- {}

Установка в среду контейнеризации Red Hat OpenShift 4+ (опциональная):

kind: DeploymentConfig

apiVersion: apps.openshift.io/v1

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: >

{"apiVersion":"apps.openshift.io/v1","kind":"DeploymentConfig","metadata":{"annotations":{},"labels":{"app":"ufs-index-search-proxy","author":"hovsepyan","commitHash":"a22a4b64203884a62a51ac45e08fa508e2276740","tag":"develop"},"name":"ufs-index-search-proxy-develop","namespace":"ci02001608-edevgen-index-search-test"},"spec":{"replicas":1,"revisionHistoryLimit":2,"selector":{"commitHash":"a22a4b64203884a62a51ac45e08fa508e2276740","tag":"develop"},"strategy":{"activeDeadlineSeconds":21600,"resources":{},"rollingParams":{"intervalSeconds":1,"maxSurge":"25%","maxUnavailable":"25%","timeoutSeconds":600,"updatePeriodSeconds":1},"type":"Rolling"},"template":{"metadata":{"labels":{"commitHash":"a22a4b64203884a62a51ac45e08fa508e2276740","tag":"develop"}},"spec":{"containers":[{"env":[{"name":"ufs.tenant.code","value":"hovsepyan-develop:1.0.0"},{"name":"ufs.platform.config.directory","value":"/opt/conf/index-search/proxy/config"},{"name":"idxs.elasticsearch.urls","value":"http://10.53.64.102:9201"},{"name":"spring.profiles.active","value":"DEV,stubMode"},{"name":"STAND_TYPE","value":"DEV"}],"image":"registry.domain.mycompany.ru/efs-dev/ci00428440/ci00982654_bfs_oseo_dev/index-search-proxy/hovsepyan-develop:1.0.0","imagePullPolicy":"Always","livenessProbe":{"failureThreshold":3,"httpGet":{"path":"/ufs-index-search-proxy/environment/product","port":8080,"scheme":"HTTP"},"initialDelaySeconds":60,"periodSeconds":5,"successThreshold":1,"timeoutSeconds":1},"name":"ufs-index-search-proxy","ports":[{"containerPort":8080,"protocol":"TCP"}],"readinessProbe":{"failureThreshold":3,"httpGet":{"path":"/ufs-index-search-proxy/healthcheck","port":8080,"scheme":"HTTP"},"initialDelaySeconds":10,"periodSeconds":1,"successThreshold":1,"timeoutSeconds":1},"resources":{"limits":{"cpu":"900m","memory":"1600Mi"},"requests":{"cpu":"700m","memory":"1000Mi"}},"terminationMessagePath":"/dev/termination-log"}],"dnsPolicy":"ClusterFirst"}},"triggers":[{"type":"ConfigChange"}]}}

resourceVersion: '4610202511'

name: ufs-index-search-proxy-develop

uid: ff5dbdc3-086e-4bb2-8b69-c4632cb3ad9a

creationTimestamp: '2021-09-01T15:06:51Z'

generation: 18

managedFields:

- manager: kubectl

operation: Update

apiVersion: apps.openshift.io/v1

time: '2022-01-19T10:39:16Z'

fieldsType: FieldsV1

fieldsV1:

'f:metadata':

'f:annotations':

.: {}

'f:kubectl.kubernetes.io/last-applied-configuration': {}

'f:labels':

.: {}

'f:app': {}

'f:author': {}

'f:commitHash': {}

'f:tag': {}

'f:spec':

'f:replicas': {}

'f:revisionHistoryLimit': {}

'f:selector':

.: {}

'f:commitHash': {}

'f:tag': {}

'f:strategy':

'f:activeDeadlineSeconds': {}

'f:rollingParams':

.: {}

'f:intervalSeconds': {}

'f:maxSurge': {}

'f:maxUnavailable': {}

'f:timeoutSeconds': {}

'f:updatePeriodSeconds': {}

'f:type': {}

'f:template':

.: {}

'f:metadata':

.: {}

'f:creationTimestamp': {}

'f:labels':

.: {}

'f:commitHash': {}

'f:tag': {}

'f:spec':

.: {}

'f:containers':

.: {}

'k:{"name":"ufs-index-search-proxy"}':

'f:image': {}

'f:terminationMessagePolicy': {}

.: {}

'f:resources':

.: {}

'f:limits':

.: {}

'f:cpu': {}

'f:memory': {}

'f:requests':

.: {}

'f:cpu': {}

'f:memory': {}

'f:livenessProbe':

.: {}

'f:failureThreshold': {}

'f:httpGet':

.: {}

'f:path': {}

'f:port': {}

'f:scheme': {}

'f:initialDelaySeconds': {}

'f:periodSeconds': {}

'f:successThreshold': {}

'f:timeoutSeconds': {}

'f:env':

.: {}

'k:{"name":"STAND_TYPE"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"idxs.elasticsearch.urls"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"spring.profiles.active"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"ufs.platform.config.directory"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"ufs.tenant.code"}':

.: {}

'f:name': {}

'f:value': {}

'f:readinessProbe':

.: {}

'f:failureThreshold': {}

'f:httpGet':

.: {}

'f:path': {}

'f:port': {}

'f:scheme': {}

'f:initialDelaySeconds': {}

'f:periodSeconds': {}

'f:successThreshold': {}

'f:timeoutSeconds': {}

'f:terminationMessagePath': {}

'f:imagePullPolicy': {}

'f:ports':

.: {}

'k:{"containerPort":8080,"protocol":"TCP"}':

.: {}

'f:containerPort': {}

'f:protocol': {}

'f:name': {}

'f:dnsPolicy': {}

'f:restartPolicy': {}

'f:schedulerName': {}

'f:securityContext': {}

'f:terminationGracePeriodSeconds': {}

'f:triggers': {}

- manager: openshift-controller-manager

operation: Update

apiVersion: apps.openshift.io/v1

time: '2022-07-13T21:00:37Z'

fieldsType: FieldsV1

fieldsV1:

'f:status':

'f:updatedReplicas': {}

'f:readyReplicas': {}

'f:conditions':

.: {}

'k:{"type":"Available"}':

.: {}

'f:lastTransitionTime': {}

'f:lastUpdateTime': {}

'f:message': {}

'f:status': {}

'f:type': {}

'k:{"type":"Progressing"}':

.: {}

'f:lastTransitionTime': {}

'f:lastUpdateTime': {}

'f:message': {}

'f:reason': {}

'f:status': {}

'f:type': {}

'f:details':

.: {}

'f:causes': {}

'f:message': {}

'f:replicas': {}

'f:availableReplicas': {}

'f:observedGeneration': {}

'f:unavailableReplicas': {}

'f:latestVersion': {}

namespace: ci02001608-edevgen-index-search-test

labels:

app: ufs-index-search-proxy

author: hovsepyan

commitHash: a22a4b64203884a62a51ac45e08fa508e2276740

tag: develop

spec:

strategy:

type: Rolling

rollingParams:

updatePeriodSeconds: 1

intervalSeconds: 1

timeoutSeconds: 600

maxUnavailable: 25%

maxSurge: 25%

resources: {}

activeDeadlineSeconds: 21600

triggers:

- type: ConfigChange

replicas: 1

revisionHistoryLimit: 2

test: false

selector:

commitHash: a22a4b64203884a62a51ac45e08fa508e2276740

tag: develop

template:

metadata:

creationTimestamp: null

labels:

commitHash: a22a4b64203884a62a51ac45e08fa508e2276740

tag: develop

spec:

containers:

- resources:

limits:

cpu: 900m

memory: 1600Mi

requests:

cpu: 700m

memory: 1000Mi

readinessProbe:

httpGet:

path: /ufs-index-search-proxy/healthcheck

port: 8080

scheme: HTTP

initialDelaySeconds: 10

timeoutSeconds: 1

periodSeconds: 1

successThreshold: 1

failureThreshold: 3

terminationMessagePath: /dev/termination-log

name: ufs-index-search-proxy

livenessProbe:

httpGet:

path: /ufs-index-search-proxy/environment/product

port: 8080

scheme: HTTP

initialDelaySeconds: 60

timeoutSeconds: 1

periodSeconds: 5

successThreshold: 1

failureThreshold: 3

env:

- name: ufs.tenant.code

value: 'DICT'

- name: ufs.platform.config.directory

value: /opt/conf/index-search/proxy/config

- name: idxs.elasticsearch.urls

value: Server ELasticSearch'

- name: spring.profiles.active

value: 'DEV,stubMode'

- name: STAND_TYPE

value: DEV

ports:

- containerPort: 8080

protocol: TCP

imagePullPolicy: Always

terminationMessagePolicy: File

image: >-

'сылка на докер образ'

restartPolicy: Always

terminationGracePeriodSeconds: 30

dnsPolicy: ClusterFirst

securityContext: {}

schedulerName: default-scheduler

status:

observedGeneration: 18

details:

message: manual change

causes:

- type: Manual

availableReplicas: 1

unavailableReplicas: 0

latestVersion: 16

updatedReplicas: 1

conditions:

- type: Progressing

status: 'True'

lastUpdateTime: '2022-06-17T14:37:49Z'

lastTransitionTime: '2022-06-17T14:37:49Z'

reason: NewReplicationControllerAvailable

message: >-

replication controller "ufs-index-search-proxy-develop-16" successfully

rolled out

- type: Available

status: 'True'

lastUpdateTime: '2022-07-13T21:00:37Z'

lastTransitionTime: '2022-07-13T21:00:37Z'

message: Deployment config has minimum availability.

replicas: 1

readyReplicas: 1

kind: DeploymentConfig

apiVersion: apps.openshift.io/v1

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: >

{"apiVersion":"apps.openshift.io/v1","kind":"DeploymentConfig","metadata":{"annotations":{},"labels":{"app":"ufs-index-search-indexer","author":"penkin","commitHash":"3179729bc13d78e42bd578883e6b09ab1cf10146","tag":"indsrch1260"},"name":"ufs-index-search-indexer-indsrch1260","namespace":"ci02001608-edevgen-index-search-test"},"spec":{"replicas":1,"revisionHistoryLimit":2,"selector":{"commitHash":"3179729bc13d78e42bd578883e6b09ab1cf10146","tag":"indsrch1260"},"strategy":{"activeDeadlineSeconds":21600,"resources":{},"rollingParams":{"intervalSeconds":1,"maxSurge":"25%","maxUnavailable":"25%","timeoutSeconds":600,"updatePeriodSeconds":1},"type":"Rolling"},"template":{"metadata":{"labels":{"commitHash":"3179729bc13d78e42bd578883e6b09ab1cf10146","tag":"indsrch1260"}},"spec":{"containers":[{"env":[{"name":"ufs.tenant.code","value":"penkin-indsrch1260:1.0.1"},{"name":"ufs.platform.config.directory","value":"/opt/conf/index-search/indexer/config"},{"name":"idxs.elasticsearch.urls","value":"http://10.53.64.102:9201"},{"name":"spring.profiles.active","value":"DEV,stubMode"},{"name":"STAND_TYPE","value":"DEV"}],"image":"registry.domain.mycompany.ru/efs-dev/ci00428440/ci00982654_bfs_oseo_dev/index-search-indexer/penkin-indsrch1260:1.0.1","imagePullPolicy":"Always","livenessProbe":{"failureThreshold":3,"httpGet":{"path":"/ufs-index-search-indexer/environment/product","port":8080,"scheme":"HTTP"},"initialDelaySeconds":60,"periodSeconds":5,"successThreshold":1,"timeoutSeconds":1},"name":"ufs-index-search-indexer","ports":[{"containerPort":8080,"protocol":"TCP"}],"readinessProbe":{"failureThreshold":3,"httpGet":{"path":"/ufs-index-search-indexer/healthcheck","port":8080,"scheme":"HTTP"},"initialDelaySeconds":10,"periodSeconds":1,"successThreshold":1,"timeoutSeconds":1},"resources":{"limits":{"cpu":"900m","memory":"1600Mi"},"requests":{"cpu":"700m","memory":"1000Mi"}},"terminationMessagePath":"/dev/termination-log"}],"dnsPolicy":"ClusterFirst"}},"triggers":[{"type":"ConfigChange"}]}}

resourceVersion: '4610205344'

name: ufs-index-search-indexer-indsrch1260

uid: 27f67ca4-8826-408b-8e64-842852d11f4f

creationTimestamp: '2022-06-30T11:55:21Z'

generation: 1

managedFields:

- manager: kubectl

operation: Update

apiVersion: apps.openshift.io/v1

time: '2022-06-30T11:55:21Z'

fieldsType: FieldsV1

fieldsV1:

'f:metadata':

'f:annotations':

.: {}

'f:kubectl.kubernetes.io/last-applied-configuration': {}

'f:labels':

.: {}

'f:app': {}

'f:author': {}

'f:commitHash': {}

'f:tag': {}

'f:spec':

'f:replicas': {}

'f:revisionHistoryLimit': {}

'f:selector':

.: {}

'f:commitHash': {}

'f:tag': {}

'f:strategy':

'f:activeDeadlineSeconds': {}

'f:rollingParams':

.: {}

'f:intervalSeconds': {}

'f:maxSurge': {}

'f:maxUnavailable': {}

'f:timeoutSeconds': {}

'f:updatePeriodSeconds': {}

'f:type': {}

'f:template':

.: {}

'f:metadata':

.: {}

'f:creationTimestamp': {}

'f:labels':

.: {}

'f:commitHash': {}

'f:tag': {}

'f:spec':

.: {}

'f:containers':

.: {}

'k:{"name":"ufs-index-search-indexer"}':

'f:image': {}

'f:terminationMessagePolicy': {}

.: {}

'f:resources':

.: {}

'f:limits':

.: {}

'f:cpu': {}

'f:memory': {}

'f:requests':

.: {}

'f:cpu': {}

'f:memory': {}

'f:livenessProbe':

.: {}

'f:failureThreshold': {}

'f:httpGet':

.: {}

'f:path': {}

'f:port': {}

'f:scheme': {}

'f:initialDelaySeconds': {}

'f:periodSeconds': {}

'f:successThreshold': {}

'f:timeoutSeconds': {}

'f:env':

.: {}

'k:{"name":"STAND_TYPE"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"idxs.elasticsearch.urls"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"spring.profiles.active"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"ufs.platform.config.directory"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"ufs.tenant.code"}':

.: {}

'f:name': {}

'f:value': {}

'f:readinessProbe':

.: {}

'f:failureThreshold': {}

'f:httpGet':

.: {}

'f:path': {}

'f:port': {}

'f:scheme': {}

'f:initialDelaySeconds': {}

'f:periodSeconds': {}

'f:successThreshold': {}

'f:timeoutSeconds': {}

'f:terminationMessagePath': {}

'f:imagePullPolicy': {}

'f:ports':

.: {}

'k:{"containerPort":8080,"protocol":"TCP"}':

.: {}

'f:containerPort': {}

'f:protocol': {}

'f:name': {}

'f:dnsPolicy': {}

'f:restartPolicy': {}

'f:schedulerName': {}

'f:securityContext': {}

'f:terminationGracePeriodSeconds': {}

'f:triggers': {}

- manager: openshift-controller-manager

operation: Update

apiVersion: apps.openshift.io/v1

time: '2022-07-13T21:01:01Z'

fieldsType: FieldsV1

fieldsV1:

'f:status':

'f:updatedReplicas': {}

'f:readyReplicas': {}

'f:conditions':

.: {}

'k:{"type":"Available"}':

.: {}

'f:lastTransitionTime': {}

'f:lastUpdateTime': {}

'f:message': {}

'f:status': {}

'f:type': {}

'k:{"type":"Progressing"}':

.: {}

'f:lastTransitionTime': {}

'f:lastUpdateTime': {}

'f:message': {}

'f:reason': {}

'f:status': {}

'f:type': {}

'f:details':

.: {}

'f:causes': {}

'f:message': {}

'f:replicas': {}

'f:availableReplicas': {}

'f:observedGeneration': {}

'f:unavailableReplicas': {}

'f:latestVersion': {}

namespace: ci02001608-edevgen-index-search-test

labels:

app: ufs-index-search-indexer

spec:

strategy:

type: Rolling

rollingParams:

updatePeriodSeconds: 1

intervalSeconds: 1

timeoutSeconds: 600

maxUnavailable: 25%

maxSurge: 25%

resources: {}

activeDeadlineSeconds: 21600

triggers:

- type: ConfigChange

replicas: 1

revisionHistoryLimit: 2

test: false

selector:

commitHash: 3179729bc13d78e42bd578883e6b09ab1cf10146

tag: indsrch1260

template:

metadata:

creationTimestamp: null

labels:

commitHash: 3179729bc13d78e42bd578883e6b09ab1cf10146

tag: indsrch1260

spec:

containers:

- resources:

limits:

cpu: 900m

memory: 1600Mi

requests:

cpu: 700m

memory: 1000Mi

readinessProbe:

httpGet:

path: /ufs-index-search-indexer/healthcheck

port: 8080

scheme: HTTP

initialDelaySeconds: 10

timeoutSeconds: 1

periodSeconds: 1

successThreshold: 1

failureThreshold: 3

terminationMessagePath: /dev/termination-log

name: ufs-index-search-indexer

livenessProbe:

httpGet:

path: /ufs-index-search-indexer/environment/product

port: 8080

scheme: HTTP

initialDelaySeconds: 60

timeoutSeconds: 1

periodSeconds: 5

successThreshold: 1

failureThreshold: 3

env:

- name: ufs.tenant.code

value: 'DICT'

- name: ufs.platform.config.directory

value: /opt/conf/index-search/indexer/config

- name: idxs.elasticsearch.urls

value: 'Сервер ElasticSearch'

- name: spring.profiles.active

value: 'DEV,stubMode'

- name: STAND_TYPE

value: DEV

ports:

- containerPort: 8080

protocol: TCP

imagePullPolicy: Always

terminationMessagePolicy: File

image: >-

'Сылка на докер образ'

restartPolicy: Always

terminationGracePeriodSeconds: 30

dnsPolicy: ClusterFirst

securityContext: {}

schedulerName: default-scheduler

status:

observedGeneration: 1

details:

message: config change

causes:

- type: ConfigChange

availableReplicas: 1

unavailableReplicas: 0

latestVersion: 1

updatedReplicas: 1

conditions:

- type: Progressing

status: 'True'

lastUpdateTime: '2022-06-30T11:56:15Z'

lastTransitionTime: '2022-06-30T11:55:28Z'

reason: NewReplicationControllerAvailable

message: >-

replication controller "ufs-index-search-indexer-indsrch1260-1"

successfully rolled out

- type: Available

status: 'True'

lastUpdateTime: '2022-07-13T21:01:01Z'

lastTransitionTime: '2022-07-13T21:01:01Z'

message: Deployment config has minimum availability.

replicas: 1

readyReplicas: 1

kind: DeploymentConfig

apiVersion: apps.openshift.io/v1

metadata:

annotations:

kubectl.kubernetes.io/last-applied-configuration: >

{"apiVersion":"apps.openshift.io/v1","kind":"DeploymentConfig","metadata":{"annotations":{},"labels":{"app":"ufs-index-search-indexer","author":"penkin","commitHash":"3179729bc13d78e42bd578883e6b09ab1cf10146","tag":"indsrch1260"},"name":"ufs-index-search-indexer-indsrch1260","namespace":"ci02001608-edevgen-index-search-test"},"spec":{"replicas":1,"revisionHistoryLimit":2,"selector":{"commitHash":"3179729bc13d78e42bd578883e6b09ab1cf10146","tag":"indsrch1260"},"strategy":{"activeDeadlineSeconds":21600,"resources":{},"rollingParams":{"intervalSeconds":1,"maxSurge":"25%","maxUnavailable":"25%","timeoutSeconds":600,"updatePeriodSeconds":1},"type":"Rolling"},"template":{"metadata":{"labels":{"commitHash":"3179729bc13d78e42bd578883e6b09ab1cf10146","tag":"indsrch1260"}},"spec":{"containers":[{"env":[{"name":"ufs.tenant.code","value":"penkin-indsrch1260:1.0.1"},{"name":"ufs.platform.config.directory","value":"/opt/conf/index-search/indexer/config"},{"name":"idxs.elasticsearch.urls","value":"http://10.53.64.102:9201"},{"name":"spring.profiles.active","value":"DEV,stubMode"},{"name":"STAND_TYPE","value":"DEV"}],"image":"registry.domain.mycompany.ru/efs-dev/ci00428440/ci00982654_bfs_oseo_dev/index-search-indexer/penkin-indsrch1260:1.0.1","imagePullPolicy":"Always","livenessProbe":{"failureThreshold":3,"httpGet":{"path":"/ufs-index-search-indexer/environment/product","port":8080,"scheme":"HTTP"},"initialDelaySeconds":60,"periodSeconds":5,"successThreshold":1,"timeoutSeconds":1},"name":"ufs-index-search-indexer","ports":[{"containerPort":8080,"protocol":"TCP"}],"readinessProbe":{"failureThreshold":3,"httpGet":{"path":"/ufs-index-search-indexer/healthcheck","port":8080,"scheme":"HTTP"},"initialDelaySeconds":10,"periodSeconds":1,"successThreshold":1,"timeoutSeconds":1},"resources":{"limits":{"cpu":"900m","memory":"1600Mi"},"requests":{"cpu":"700m","memory":"1000Mi"}},"terminationMessagePath":"/dev/termination-log"}],"dnsPolicy":"ClusterFirst"}},"triggers":[{"type":"ConfigChange"}]}}

resourceVersion: '4610205344'

name: ufs-index-search-indexer-indsrch1260

uid: 27f67ca4-8826-408b-8e64-842852d11f4f

creationTimestamp: '2022-06-30T11:55:21Z'

generation: 1

managedFields:

- manager: kubectl

operation: Update

apiVersion: apps.openshift.io/v1

time: '2022-06-30T11:55:21Z'

fieldsType: FieldsV1

fieldsV1:

'f:metadata':

'f:annotations':

.: {}

'f:kubectl.kubernetes.io/last-applied-configuration': {}

'f:labels':

.: {}

'f:app': {}

'f:author': {}

'f:commitHash': {}

'f:tag': {}

'f:spec':

'f:replicas': {}

'f:revisionHistoryLimit': {}

'f:selector':

.: {}

'f:commitHash': {}

'f:tag': {}

'f:strategy':

'f:activeDeadlineSeconds': {}

'f:rollingParams':

.: {}

'f:intervalSeconds': {}

'f:maxSurge': {}

'f:maxUnavailable': {}

'f:timeoutSeconds': {}

'f:updatePeriodSeconds': {}

'f:type': {}

'f:template':

.: {}

'f:metadata':

.: {}

'f:creationTimestamp': {}

'f:labels':

.: {}

'f:commitHash': {}

'f:tag': {}

'f:spec':

.: {}

'f:containers':

.: {}

'k:{"name":"ufs-index-search-indexer"}':

'f:image': {}

'f:terminationMessagePolicy': {}

.: {}

'f:resources':

.: {}

'f:limits':

.: {}

'f:cpu': {}

'f:memory': {}

'f:requests':

.: {}

'f:cpu': {}

'f:memory': {}

'f:livenessProbe':

.: {}

'f:failureThreshold': {}

'f:httpGet':

.: {}

'f:path': {}

'f:port': {}

'f:scheme': {}

'f:initialDelaySeconds': {}

'f:periodSeconds': {}

'f:successThreshold': {}

'f:timeoutSeconds': {}

'f:env':

.: {}

'k:{"name":"STAND_TYPE"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"idxs.elasticsearch.urls"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"spring.profiles.active"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"ufs.platform.config.directory"}':

.: {}

'f:name': {}

'f:value': {}

'k:{"name":"ufs.tenant.code"}':

.: {}

'f:name': {}

'f:value': {}

'f:readinessProbe':

.: {}

'f:failureThreshold': {}

'f:httpGet':

.: {}

'f:path': {}

'f:port': {}

'f:scheme': {}

'f:initialDelaySeconds': {}

'f:periodSeconds': {}

'f:successThreshold': {}

'f:timeoutSeconds': {}

'f:terminationMessagePath': {}

'f:imagePullPolicy': {}

'f:ports':

.: {}

'k:{"containerPort":8080,"protocol":"TCP"}':

.: {}

'f:containerPort': {}

'f:protocol': {}

'f:name': {}

'f:dnsPolicy': {}

'f:restartPolicy': {}

'f:schedulerName': {}

'f:securityContext': {}

'f:terminationGracePeriodSeconds': {}

'f:triggers': {}

- manager: openshift-controller-manager

operation: Update

apiVersion: apps.openshift.io/v1

time: '2022-07-13T21:01:01Z'

fieldsType: FieldsV1

fieldsV1:

'f:status':

'f:updatedReplicas': {}

'f:readyReplicas': {}

'f:conditions':

.: {}

'k:{"type":"Available"}':

.: {}

'f:lastTransitionTime': {}

'f:lastUpdateTime': {}

'f:message': {}

'f:status': {}

'f:type': {}

'k:{"type":"Progressing"}':

.: {}

'f:lastTransitionTime': {}

'f:lastUpdateTime': {}

'f:message': {}

'f:reason': {}

'f:status': {}

'f:type': {}

'f:details':

.: {}

'f:causes': {}

'f:message': {}

'f:replicas': {}

'f:availableReplicas': {}

'f:observedGeneration': {}

'f:unavailableReplicas': {}

'f:latestVersion': {}

namespace: ci02001608-edevgen-index-search-test

labels:

app: ufs-index-search-indexer

spec:

strategy:

type: Rolling

rollingParams:

updatePeriodSeconds: 1

intervalSeconds: 1

timeoutSeconds: 600

maxUnavailable: 25%

maxSurge: 25%

resources: {}

activeDeadlineSeconds: 21600

triggers:

- type: ConfigChange

replicas: 1

revisionHistoryLimit: 2

test: false

selector:

commitHash: 3179729bc13d78e42bd578883e6b09ab1cf10146

tag: indsrch1260

template:

metadata:

creationTimestamp: null

labels:

commitHash: 3179729bc13d78e42bd578883e6b09ab1cf10146

tag: indsrch1260

spec:

containers:

- resources:

limits:

cpu: 900m

memory: 1600Mi

requests:

cpu: 700m

memory: 1000Mi

readinessProbe:

httpGet:

path: /ufs-index-search-indexer/healthcheck

port: 8080

scheme: HTTP

initialDelaySeconds: 10

timeoutSeconds: 1

periodSeconds: 1

successThreshold: 1

failureThreshold: 3

terminationMessagePath: /dev/termination-log

name: ufs-index-search-indexer

livenessProbe:

httpGet:

path: /ufs-index-search-indexer/environment/product

port: 8080

scheme: HTTP

initialDelaySeconds: 60

timeoutSeconds: 1

periodSeconds: 5

successThreshold: 1

failureThreshold: 3

env:

- name: ufs.tenant.code

value: 'DICT'

- name: ufs.platform.config.directory

value: /opt/conf/index-search/indexer/config

- name: idxs.elasticsearch.urls

value: 'Сервер ElasticSearch'

- name: spring.profiles.active

value: 'DEV,stubMode'

- name: STAND_TYPE

value: DEV

ports:

- containerPort: 8080

protocol: TCP

imagePullPolicy: Always

terminationMessagePolicy: File

image: >-

'Сылка на докер образ'

restartPolicy: Always

terminationGracePeriodSeconds: 30

dnsPolicy: ClusterFirst

securityContext: {}

schedulerName: default-scheduler

status:

observedGeneration: 1

details:

message: config change

causes:

- type: ConfigChange

availableReplicas: 1

unavailableReplicas: 0

latestVersion: 1

updatedReplicas: 1

conditions:

- type: Progressing

status: 'True'

lastUpdateTime: '2022-06-30T11:56:15Z'

lastTransitionTime: '2022-06-30T11:55:28Z'

reason: NewReplicationControllerAvailable

message: >-

replication controller "ufs-index-search-indexer-indsrch1260-1"

successfully rolled out

- type: Available

status: 'True'

lastUpdateTime: '2022-07-13T21:01:01Z'

lastTransitionTime: '2022-07-13T21:01:01Z'

message: Deployment config has minimum availability.

replicas: 1

readyReplicas: 1

Установка Ingress-controller

kind: Ingress

apiVersion: networking.k8s.io/v1

metadata:

annotations:

kubernetes.io/ingress.class: haproxy

resourceVersion: '54120417'

name: ingress-router

uid: 30b36ae9-6305-4a53-a09a-9b949f676b83

creationTimestamp: '2022-06-23T12:09:22Z'

generation: 2

managedFields:

- manager: Mozilla

operation: Update

apiVersion: networking.k8s.io/v1

time: '2022-06-23T12:09:22Z'

fieldsType: FieldsV1

fieldsV1:

'f:metadata':

'f:annotations':

.: {}

'f:kubernetes.io/ingress.class': {}

'f:labels':

.: {}

'f:type': {}

'f:spec':

'f:rules': {}

- manager: haproxy-ingress-controller

operation: Update

apiVersion: networking.k8s.io/v1

time: '2022-06-23T12:09:26Z'

fieldsType: FieldsV1

fieldsV1:

'f:status':

'f:loadBalancer':

'f:ingress': {}

namespace: tribe-pf-dev-dypx-k8s

labels:

type: ingress-route

spec:

rules:

- host: dypx.apps.k8s.devpub.solution.xxx

http:

paths:

- path: /ru.xxx.idxs.indicator.api.ProxyApi

pathType: ImplementationSpecific

backend:

service:

name: ufs-index-search-proxy-cloud-app

port:

number: 8080

- path: /ru.xxx.idxs.json.rpc.api.IndexerService

pathType: ImplementationSpecific

backend:

service:

name: ufs-index-search-indexer-cloud-app

port:

number: 8080

status:

loadBalancer:

ingress:

- {}

Обновление#

Для обновления продукта в среде контейнеризации необходимо обновить image в Deployment. Для обновления ElasticSearch выполните установку ElasticSearch (см. раздел "Установка ElasticSearch").

Внимание!

Приложение ufs-index-search-etl не версионируется, перед установкой нового релиза необходимо остановить все инстансы ufs-index-search-etl предыдущего релиза.

Проверка работоспособности#

В веб-консоли администратора среды контейнеризации по адресу http://<хост_кластера_openshift>/k8s/ns/<project_name>/pods удостоверьтесь, что readiness-пробы всех контейнеров во всех подах положительны (то есть все поды находятся в состоянии "ready"). Это является критерием того, что поды могут принимать трафик от потребителей.

Проверка миграции Elasticsearch#

Необходимо выполнить следующие действия:

Проверить домен данных atm (требуется ответ DONE):

GET /.domain_schema/_doc/atm?filter_path=_source.stateПроверить домена данных divisions (требуется ответ DONE):

GET /.domain_schema/_doc/divisions?filter_path=_source.stateПроверить версии .etl_sync (требуется версия 1):

GET /.etl_sync?filter_path=\.etl_sync.mappings._meta.version

Откат#

Автоматической процедуры отката нет.

Откат к предыдущей версии представляет собой удаление и установку последней стабильной версии.

Для отката необходимо выполнить установку предыдущей стабильной версии в соответствии с инструкцией, пункт Установка дистрибутива текущего документа.

Откат Elasticsearch#

Необходимо удалить .etl_sync:

DELETE /.etl_sync

Далее необходимо удалить запись divisions в индексе. domain_schema (удаление записи возможно, если существует индекс .domain_schema):

DELETE /.domain_schema/_doc/divisions

Часто встречающиеся проблемы и пути их устранения#

В случае неуспешной установки новой версии Продукта необходимо выполнить процедуру отката настроек (см. раздел Откат), произведенных во время неудачной установки новой версии, а затем установку предыдущей версии.

Чек-лист валидации установки#

Для валидации установки выполняются следующие шаги:

Проверка кластера на работоспособность. Для этого необходимо:

Убедиться в "зеленом" статусе кластера:

_ cluster / health ? prettyУбедиться, что в составе кластера три ноды:

_ cat / nodesПроверить версию плагина на соответствие ожидаемой:

_ cat / pluginsПроверить сертификаты SSL:

Отправить запрос на сертификат ssl/certificates (внутреннее API):

_ssl/certificates?prettyУбедиться, что в elasticsearch.yml указано xpack.security.transport.ssl.enabled: true.

Отправить запрос на внешнее API (или http или https).

Проверка прикладных компонентов продукта совместно с кластером. Для этого необходимо:

Проверить контекст:

/environment/productПроверить наличие индекса в кластере:

_ cat / indicesОтправить поисковый запрос:

POST ufs-index-search-proxy/rest/v1/divisions/_search { “query”: { “match_all”: {} } }

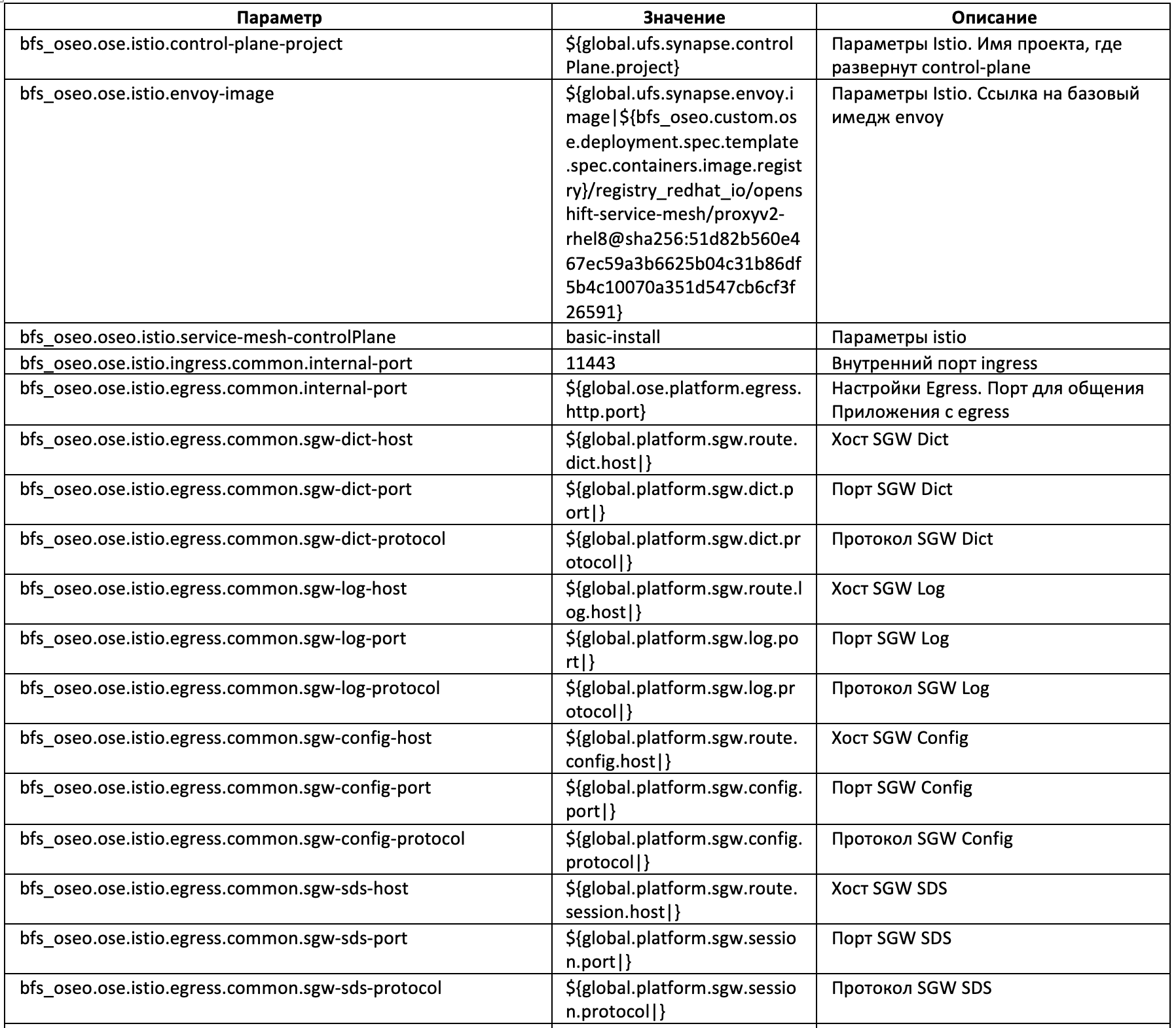

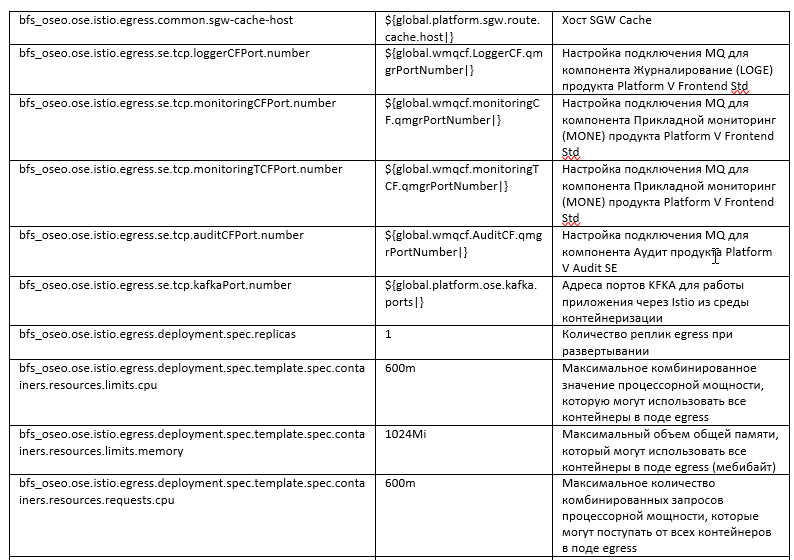

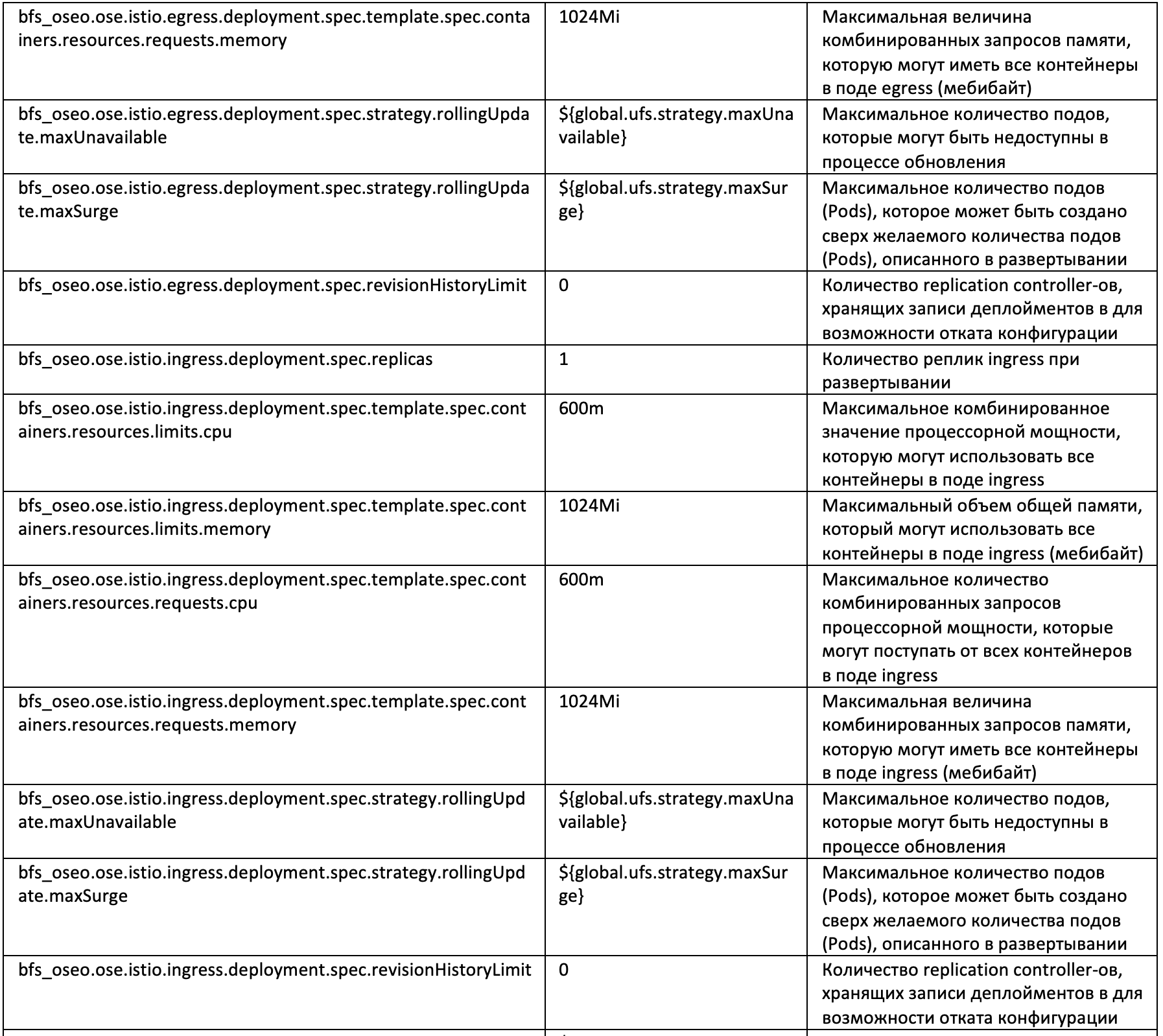

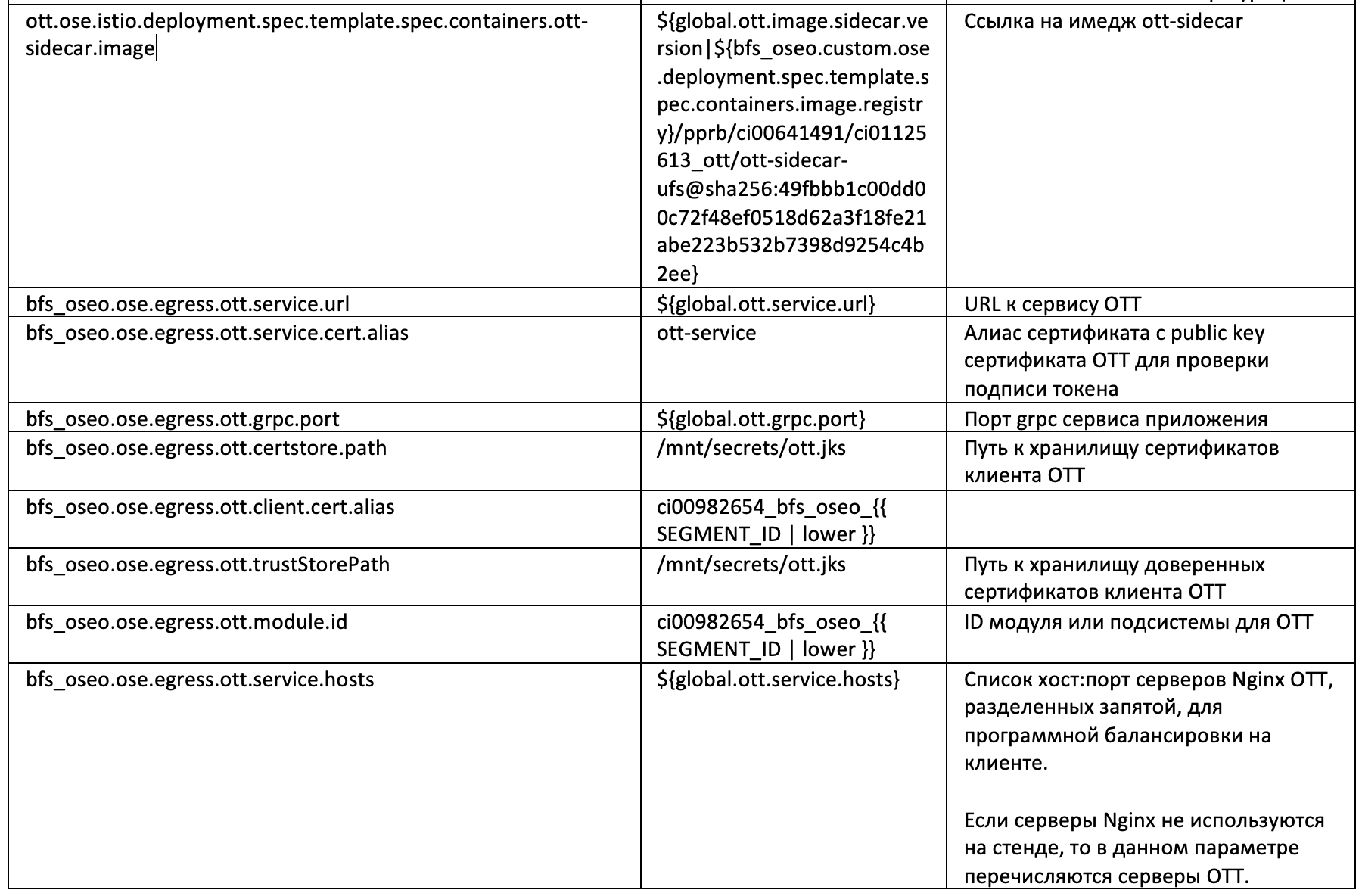

Описание конфигурационных параметров для взаимодействия Продукта с другими компонентами#

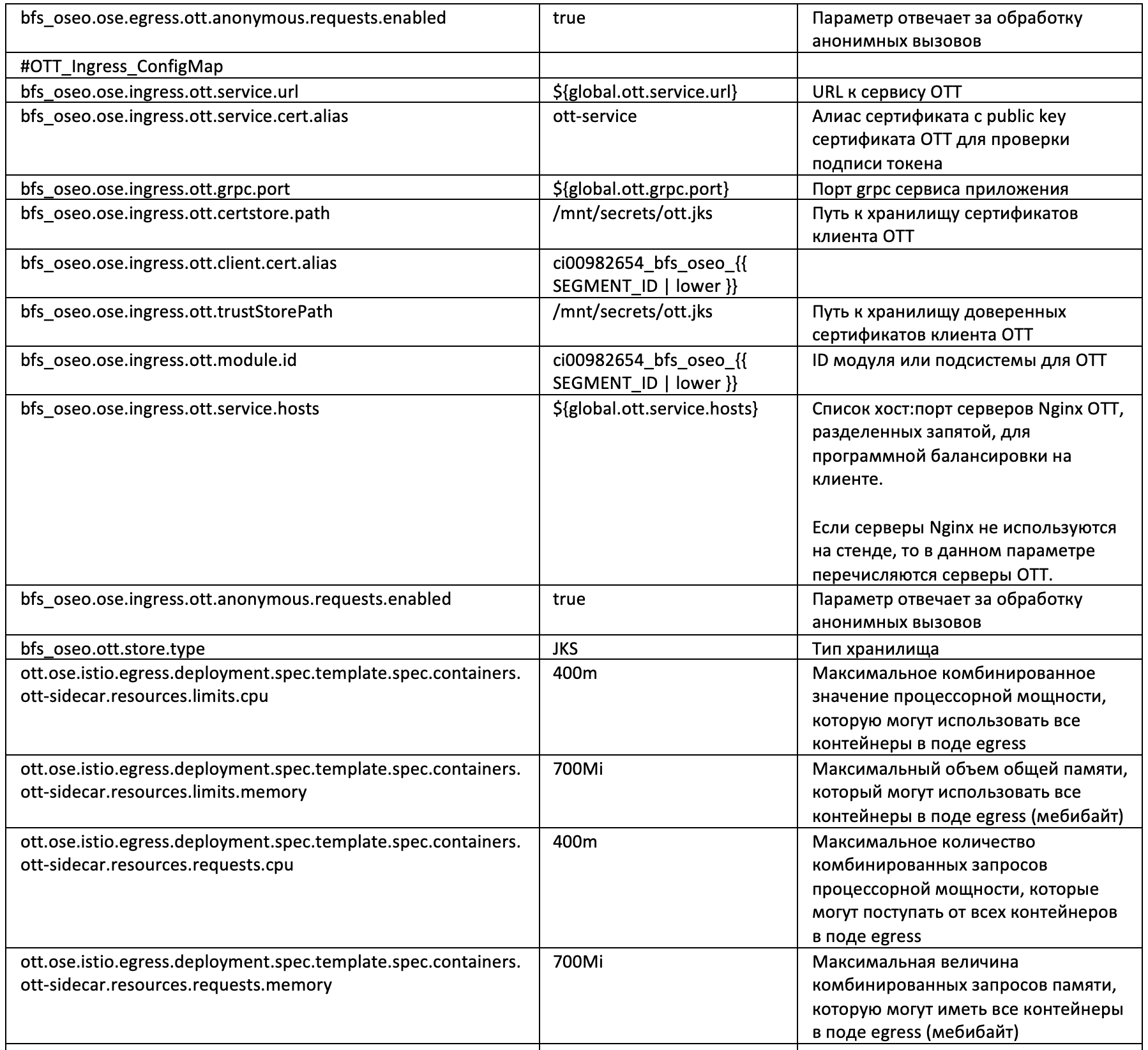

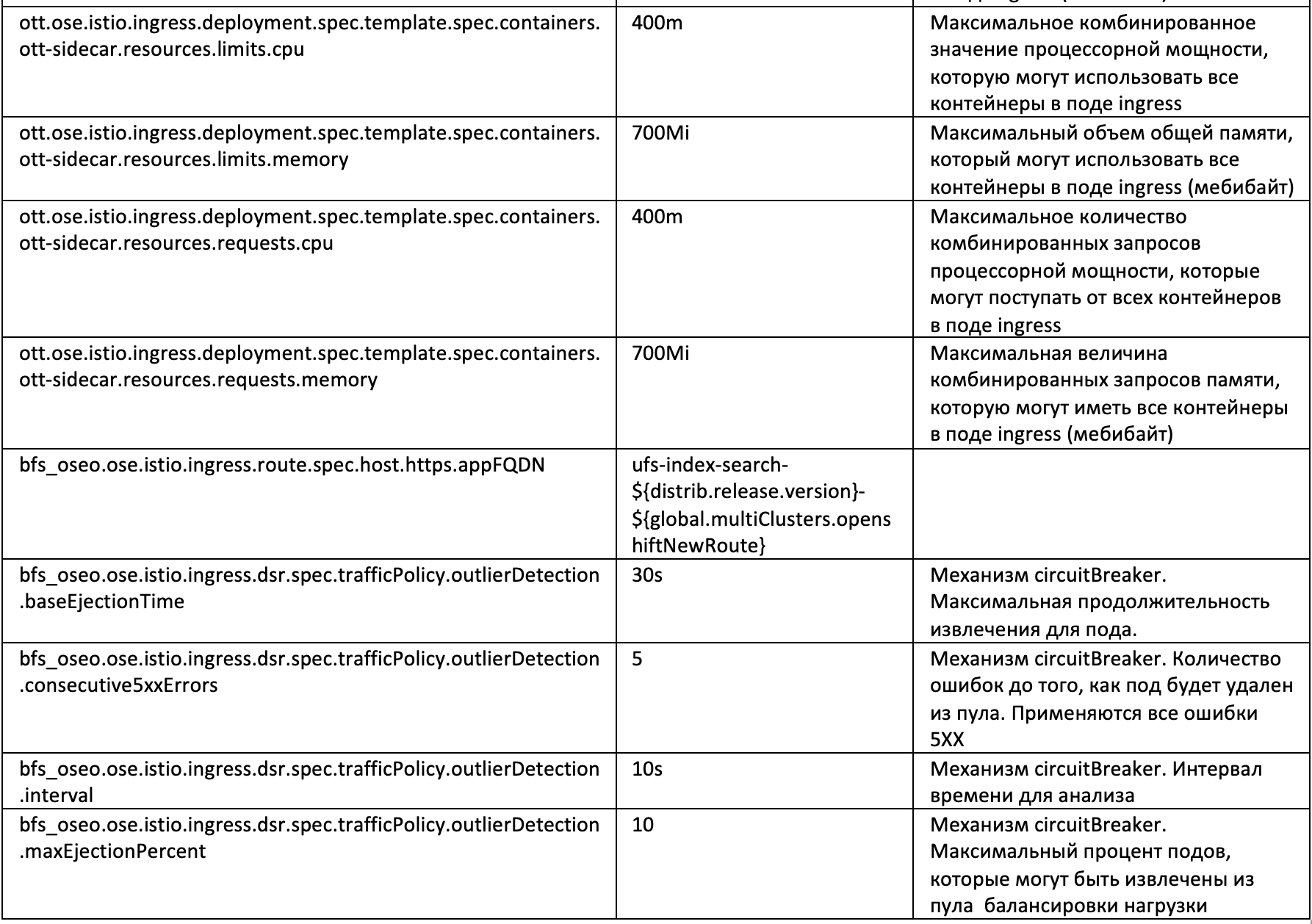

Параметр |

Значение |

Описание |

|---|---|---|

bfs_oseo.ose.istio.control-plane-project |

${global.ufs.synapse.controlPlane.project} |

Параметры Istio. Имя проекта, где развернут control-plane |

bfs_oseo.ose.istio.envoy-image |

!registry.redhat.io/openshift-service-mesh/proxyv2-rhel8@sha256:320f5bd35c208e00005c01ce0e83c8f05276119f273e9f881da950fdfff59a13 |

Параметры Istio. Ссылка на базовый имедж envoy |

bfs_oseo.ose.istio.egress.common.internal-port |

${global.ose.platform.egress.http.port} |

Настройки Egress. Порт для общения Приложения с egress |

bfs_oseo.ose.istio.egress.common.nlb_mm-host |

${global.default.nlb_mm.host} |

Настройка сетевого шлюза, хост |

bfs_oseo.ose.istio.egress.common.nlb_mm-port |

${global.default.nlb_mm.port} |

Настройка сетевого шлюза, порт |

bfs_oseo.ose.istio.egress.common.nlb_mm-protocol |

${global.default.nlb_mm.protocol} |

Настройка сетевого шлюза, протокол |

bfs_oseo.ose.istio.egress.se.tcp.kafkaPort.number |

${global.platform.ose.kafka.ports} |

Адреса портов KFKA для работы приложения через Istio из Kubernetes/Openshift |

bfs_oseo.ose.istio.egress.se.tcp.loggerCFPort.number |

${global.wmqcf.LoggerCF.qmgrPortNumber} |

Настройка подключения MQ для компонента Журналирование продукта Platform V Frontend Std |

bfs_oseo.ose.istio.egress.se.tcp.auditCFPort.number |

${global.wmqcf.AuditCF.qmgrPortNumber} |

Настройка подключения MQ для компонента Аудит продукта Platform V Audit SE |

bfs_oseo.ose.istio.egress.se.tcp.monitoringCFPort.number |

${global.wmqcf.monitoringCF.qmgrPortNumber} |

Настройка подключения MQ для Компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

bfs_oseo.ose.istio.egress.se.tcp.monitoringTCFPort.number |

${global.wmqcf.monitoringTCF.qmgrPortNumber} |

Настройка подключения MQ для Компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

bfs_oseo.ose.istio.egress.deployment.spec.replicas |

1 |

Количество реплик egress при развертывании |

bfs_oseo.ose.istio.egress.deployment.spec.template.spec.containers.resources.limits.cpu |

200m |

Максимальное комбинированное значение процессорной мощности, которую могут использовать все контейнеры в поде egress |

bfs_oseo.ose.istio.egress.deployment.spec.template.spec.containers.resources.limits.memory |

512Mi |

Максимальный объем общей памяти, который могут использовать все контейнеры в поде egress (мебибайт) |

bfs_oseo.ose.istio.egress.deployment.spec.template.spec.containers.resources.requests.cpu |

100m |

Максимальное количество комбинированных запросов процессорной мощности, которые могут поступать от всех контейнеров в поде egress |

bfs_oseo.ose.istio.egress.deployment.spec.template.spec.containers.resources.requests.memory |

256Mi |

Максимальная величина комбинированных запросов памяти, которую могут иметь все контейнеры в поде egress (мебибайт) |

bfs_oseo.ose.istio.egress.deployment.spec.strategy.rollingUpdate.maxUnavailable |

25% |

Максимальное количество подов, которые могут быть недоступны в процессе обновления |

bfs_oseo.ose.istio.egress.deployment.spec.strategy.rollingUpdate.maxSurge |

25% |

Максимальное количество подов (Pods), которое может быть создано сверх желаемого количества подов (Pods), описанного в развертывании |

bfs_oseo.ose.istio.ingress.deployment.spec.replicas |

1 |

Количество реплик ingress при развертывании |

bfs_oseo.ose.istio.ingress.deployment.spec.template.spec.containers.resources.limits.cpu |

450m |

Максимальное комбинированное значение процессорной мощности, которую могут использовать все контейнеры в поде ingress |

bfs_oseo.ose.istio.ingress.deployment.spec.template.spec.containers.resources.limits.memory |

800Mi |

Максимальный объем общей памяти, который могут использовать все контейнеры в поде ingress (мебибайт) |

bfs_oseo.ose.istio.ingress.deployment.spec.template.spec.containers.resources.requests.cpu |

350m |

Максимальное количество комбинированных запросов процессорной мощности, которые могут поступать от всех контейнеров в поде ingress |

bfs_oseo.ose.istio.ingress.deployment.spec.template.spec.containers.resources.requests.memory |

600Mi |

Максимальная величина комбинированных запросов памяти, которую могут иметь все контейнеры в поде ingress (мебибайт) |

bfs_oseo.ose.istio.ingress.deployment.spec.strategy.rollingUpdate.maxUnavailable |

25% |

Максимальное количество подов, которые могут быть недоступны в процессе обновления |

bfs_oseo.ose.istio.ingress.deployment.spec.strategy.rollingUpdate.maxSurge |

25% |

Максимальное количество подов (Pods), которое может быть создано сверх желаемого количества подов (Pods), описанного в развертывании |

bfs_oseo.ose.istio.ingress.route.spec.host.https.appFQDN |

ufs-index-search-${distrib.release.version}-${global.multiClusters.openshiftNewRoute} |

- |

Файл bfs_oseo.ufsparams-agent-sidecar.all.conf

Параметр |

Значение |

Описание |

|---|---|---|

ufs-monitoring.kafka.bootstrap.servers |

${global.kafka.monitoring.bootstrap.servers} |

Адреса серверов подключения к KFKA для отправки метрик в удаленный компонент Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.kafka.topic.metrics |

${global.kafka.monitoring.metrics.topic} |

Настройка KFKA для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.kafka.topic.settings |

${global.kafka.monitoring.settings.topic} |

Настройка KFKA для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.kafka.topic.metadata |

${global.kafka.monitoring.metadata.topic} |

Настройка KFKA для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.kafka.topic.filter |

${global.kafka.monitoring.filter.topic} |

Настройка KFKA для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.kafka.security.protocol |

${global.platform.kafka.security.protocol} |

Настройка протокола безопасности для подключения к KFKA |

ufs-monitoring.kafka.ssl.endpoint.identification.algorithm |

${global.platform.kafka.ssl.endpoint.identification.algorithm} |

Настройка алгоритма идентификации при подключении к KFKA |

ufs-monitoring.kafka.ssl.enabled.protocols |

${global.platform.kafka.ssl.enabled.protocols} |

Настройка включения SSL для подключения к KFKA |

ufs-monitoring.kafka.producer_factory.delivery.timeout.ms |

${global.platform.kafka.producer.delivery.timeout.ms} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.batch.size |

${global.platform.kafka.producer.batch.size} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.linger.ms |

${global.platform.kafka.producer.linger.ms} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.buffer.memory |

${global.platform.kafka.producer.buffer.memory} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.request.timeout.ms |

${global.platform.kafka.producer.request.timeout.ms} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.send.buffer.bytes |

${global.platform.kafka.producer.send.buffer.bytes} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.receive.buffer.bytes |

${global.platform.kafka.producer.receive.buffer.bytes} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.max.request.size |

${global.platform.kafka.producer.max.request.size} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.metadata.max.age.ms |

${global.platform.kafka.producer.metadata.max.age.ms} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.connections.max.idle.ms |

${global.platform.kafka.producer.connections.max.idle.ms} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.max.block.ms |

${global.platform.kafka.producer.max.block.ms} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.producer_factory.compression.type |

${global.platform.kafka.producer.compression.type} |

Настройка отправителя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.session.timeout.ms |

${global.platform.kafka.consumer.session.timeout.ms} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.fetch.max.bytes |

${global.platform.kafka.consumer.fetch.max.bytes} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.fetch.max.wait.ms |

${global.platform.kafka.consumer.fetch.max.wait.ms} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.fetch.min.bytes |

${global.platform.kafka.consumer.fetch.min.bytes} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.max.poll.interval.ms |

${global.platform.kafka.consumer.max.poll.interval.ms} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.heartbeat.interval.ms |

${global.platform.kafka.consumer.heartbeat.interval.ms} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.max.partition.fetch.bytes |

${global.platform.kafka.consumer.max.partition.fetch.bytes} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.send.buffer.bytes |

${global.platform.kafka.consumer.send.buffer.bytes} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.receive.buffer.bytes |

${global.platform.kafka.consumer.receive.buffer.bytes} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.kafka.consumer_factory.request.timeout.ms |

${global.platform.kafka.consumer.request.timeout.ms} |

Настройка получателя сообщений через KFKA |

ufs-monitoring.validation-jms-config |

true |

Валидация конфигурации jms в yaml |

ufs-monitoring.infra.metrics.period |

20s |

Период сбора инфраструктурных метрик |

ufs-monitoring.jms.enabled |

${global.monitoring.jms.enabledtrue} |

Настройка включения JMS для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.queue.monitoringCF.metrics |

${global.queue.monitoring.baseQueueName} |

Наименование очереди MQ компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std для событий |

ufs-monitoring.queue.monitoringCF.metadata |

${global.queue.monitoringMeta.baseQueueName} |

Наименование очереди MQ компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std для метаданных |

ufs-monitoring.topic.monitoringTCF.filters |

${global.topic.monitoringFilter.baseQueueName} |

Наименование очереди MQ компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std для фильтра |

ufs-monitoring.wmqcf.monitoringCF.qmgrName |

${global.wmqcf.monitoringCF.qmgrName} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringCF.qmgrHostname |

${global.wmqcf.monitoringCF.qmgrHostname} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringCF.qmgrPortNumber |

${global.wmqcf.monitoringCF.qmgrPortNumber} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringCF.qmgrSvrconnChannel |

${global.wmqcf.monitoringCF.qmgrSvrconnChannel} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringCF.maxConnections |

${global.wmqcf.monitoringCF.maxConnections} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringCF.sess.maxConnections |

${global.wmqcf.monitoringCF.sess.maxConnections} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringCF.connectionTimeout |

${global.wmqcf.connectionTimeout} |

Настройка Connection Timeout фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.sslCipherSuite |

${global.wmqcf.monitoringCF.ose.ssl.enabledCiphers} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringCF.agedTimeout |

${global.wmqcf.agedTimeout} |

Настройка фабрики подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.reapTime |

${global.wmqcf.reapTime} |

Настройка Reap Time фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.unusedTimeout |

${global.wmqcf.unusedTimeout} |

Настройка Unused Timeout фабрики подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.clientReconnectOptions |

${global.wmqcf.clientReconnectOptions} |

Настройка Reconnect фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.clientReconnectTimeout |

${global.wmqcf.clientReconnectTimeout} |

Настройка Reconnect Timeout фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.stuckTimerTime |

${global.wmqcf.stuckTimerTime} |

Настройка Stuck Timer Time фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.stuckTime |

${global.wmqcf.stuckTime} |

Настройка Stuck Time фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.stuckThreshold |

${global.wmqcf.stuckThreshold} |

Настройка Stuck Threashold фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.surgeThreshold |

${global.wmqcf.surgeThreshold} |

Настройка Surge Threshold фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.surgeCreationInterval |

${global.wmqcf.surgeCreationInterval} |

Настройка Surge Creation Interval фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringCF.reconnectOnException |

true |

Настройка для обновления соединения при получении JMSException |

ufs-monitoring.wmqcf.monitoringTCF.qmgrName |

${global.wmqcf.monitoringTCF.qmgrName} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringTCF.qmgrHostname |

${global.wmqcf.monitoringTCF.qmgrHostname} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringTCF.qmgrPortNumber |

${global.wmqcf.monitoringTCF.qmgrPortNumber} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringTCF.qmgrSvrconnChannel |

${global.wmqcf.monitoringTCF.qmgrSvrconnChannel} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringTCF.maxConnections |

${global.wmqcf.monitoringTCF.maxConnections} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringTCF.sess.maxConnections |

${global.wmqcf.monitoringTCF.sess.maxConnections} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringTCF.connectionTimeout |

${global.wmqcf.connectionTimeout} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Std |

ufs-monitoring.wmqcf.monitoringTCF.agedTimeout |

${global.wmqcf.agedTimeout} |

Настройка фабрики подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.sslCipherSuite |

${global.wmqcf.monitoringTCF.ose.ssl.enabledCiphers} |

Настройка подключения MQ для компонента Прикладной мониторинг (MONE) продукта Platform V Frontend Stdr |

ufs-monitoring.wmqcf.monitoringTCF.reapTime |

${global.wmqcf.reapTime} |

Настройка Reap Time фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.unusedTimeout |

${global.wmqcf.unusedTimeout} |

Настройка Unused Timeout фабрики подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.clientReconnectOptions |

${global.wmqcf.clientReconnectOptions} |

Настройка Reconnect фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.clientReconnectTimeout |

${global.wmqcf.clientReconnectTimeout} |

Настройка Reconnect Timeout фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.stuckTimerTime |

${global.wmqcf.stuckTimerTime} |

Настройка Stuck Timer Time фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.stuckTime |

${global.wmqcf.stuckTime} |

Настройка Stuck Time фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.stuckThreshold |

${global.wmqcf.stuckThreshold} |

Настройка Stuck Threashold фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.surgeThreshold |

${global.wmqcf.surgeThreshold} |

Настройка Surge Threshold фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.surgeCreationInterval |

${global.wmqcf.surgeCreationInterval} |

Настройка Surge Creation Interval фабрик подключений к MQ |

ufs-monitoring.wmqcf.monitoringTCF.reconnectOnException |

true |

Настройка для обновления соединения при получении JMSException |

ufs-logger.kafka.bootstrap.servers |

${global.platform.logger.kafka.bootstrap.servers} |

Адреса серверов подключения к KFKA для отправки логов в удаленный компонент Журналирование продукта Platform V Frontend Std |

ufs-logger.kafka.security.protocol |

${global.platform.logger.kafka.security.protocol} |

Настройка протокола безопасности для подключения к KFKA удаленного компонента Журналирование продукта Platform V Frontend Std |

ufs-logger.kafka.ssl.enabled.protocols |

${global.platform.kafka.ssl.enabled.protocols} |

Настройки подключения к KFKA для передачи сообщений в удаленный компонент Аудит продукта Platform V Audit SE |

ufs-logger.kafka.topic |

${global.platform.logger.kafka.topic} |

Настройка топика компонента Журналирование продукта Platform V Frontend Std |

ufs-logger.wmqcf.loggerCF.qmgrName |

${global.wmqcf.LoggerCF.qmgrName} |

Настройка подключения MQ для компонента Журналирование продукта Platform V Frontend Std |

ufs-logger.wmqcf.loggerCF.qmgrHostname |

${global.wmqcf.LoggerCF.qmgrHostname} |

Настройка подключения MQ для компонента Журналирование продукта Platform V Frontend Std |

ufs-logger.wmqcf.loggerCF.qmgrPortNumber |

${global.wmqcf.LoggerCF.qmgrPortNumber} |

Настройка подключения MQ для компонента Журналирование продукта Platform V Frontend Std |

ufs-logger.wmqcf.loggerCF.qmgrSvrconnChannel |

${global.wmqcf.LoggerCF.qmgrSvrconnChannel} |

Настройка подключения MQ для компонента Журналирование продукта Platform V Frontend Std |

ufs-logger.wmqcf.loggerCF.sslCipherSuite |

${global.wmqcf.LoggerCF.ose.ssl.enabledCiphers} |

Настройка подключения MQ для компонента Журналирование продукта Platform V Frontend Std |

ufs-logger.queue.loggerCF.system |