Руководство по системному администрированию#

Сценарии администрирования#

Примечание

Все предложенные сценарии работы DropApp Plus выполняются пользователем с ролью администратора DropApp Plus. DropApp Plus обеспечивает развертывание, масштабирование, балансировку нагрузки и позволяет администратору интегрировать решения для ведения журналов, мониторинга и оповещения.

Роль администратора – это роль сервисного пользовательского аккаунта по умолчанию (привилегированного пользователя), который автоматически создается при формировании кластера (cluster) DropApp Plus.

Примечание

Документ содержит названия переменных, конфигурационных файлов и инструментов, которые применимы для различных оркестраторов контейнерных нагрузок. Использование названий, созвучных сторонним оркестраторам, обусловлено облегчением миграции на продукт DropApp Plus.

Настройка основных параметров системы#

В этом разделе описываются основы системного администрирования в DropApp Plus. Основное внимание уделяется задачам, которые системный администратор должен выполнить сразу после успешной установки и настройки.

При развертывании DropApp Plus, осуществляется работа с кластерами. Кластер состоит из набора nodes, которые запускают контейнерные приложения. Кластер DropApp имеет, как минимум, две worker nodes.

Управляющий слой (control plane), представляет собой совокупность master nodes и управляет worker nodes и pods в кластере DropApp Plus.

После установки администратор кластера может настроить следующие компоненты:

node;

кластер;

сеть;

хранилище;

пользователи;

оповещения и уведомления.

Настройка функций операционной системы#

Machine Config Operator управляет объектами MachineConfig. Используя Machine Config Operator, выполняются следующие задачи в кластере DropApp Plus:

Настройка узлов с помощью

MachineConfigобъектов;Настройка пользовательских ресурсов, связанных с

MachineConfig.

Оператор MachineConfig управляет и применяет конфигурацию и обновления базовой операционной системы и среды выполнения контейнера, включая все, что находится между ядром и kubelet.

Оператор MachineConfig содержит компоненты:

machine-config-server: предоставляет конфигурацию Ignition новым машинам, присоединяющимся к кластеру;

machine-config-controller: координирует обновление машин до желаемых конфигураций, определенных объектом

MachineConfig. Предусмотрены опции для управления обновлением наборов машин по отдельности;machine-config-daemon: применяет новую конфигурацию машины во время обновления. Проверяет и отслеживает состояние машины в соответствии с запрошенной конфигурацией машины;

machine-config: предоставляет полный источник конфигурации машины при установке, первом запуске и обновлениях машины.

Оператор MachineConfig управляет обновлениями systemd, CRI-O и Kubelet, ядра, Network Manager и других системных функций. Он также предлагает MachineConfigCRD, который может записывать файлы конфигурации на node.

Типы компонентов, которые MachineConfig может изменить, включают:

config: создает объекты конфигурации Ignition, чтобы выполнять такие действия, как изменение файлов, системных служб и других функций на машинах с DropApp Plus:

Configuration files: создает или перезаписывает файлы в каталоге

/varили/etc;systemd unit: создает и устанавливает статус службы systemd или добавляет к существующей службе systemd с помощью дополнительных настроек;

users and groups: изменяет ключи SSH в разделе passwd после установки.

Важно

Только пользователь core может изменять ключи SSH через конфигурации.

kernelArguments: добавляет аргументы в командную строку ядра при загрузке nodes;

kernelType: опционально указывает нестандартное ядро, которое будет использоваться вместо стандартного ядра. Команда

realtimeпозволяет использовать ядро RT (для RAN);extensions: расширяет возможности SberLinux OS Core, добавив выбранное предварительно упакованное программное обеспечение;

Custom resources (для ContainerRuntime и Kubelet). Помимо конфигураций компьютера, MachineConfig управляет двумя специальными пользовательскими ресурсами для изменения настроек среды выполнения контейнера CRI-O (ContainerRuntime CR) и службы Kubelet (Kubelet CR).

Проверка состояния пула конфигурации машины#

Чтобы просмотреть количество nodes, управляемых Machine Config Operator и доступных в кластере для каждого пула конфигурации, выполните следующую команду:

oc get machineconfigpoolПример вывода:

NAME CONFIG UPDATED UPDATING DEGRADED MACHINECOUNT READYMACHINECOUNT UPDATEDMACHINECOUNT DEGRADEDMACHINECOUNT AGE master rendered-master-… True False False 3 3 3 0 4h42m worker rendered-worker-… False True False 3 2 2 0 4h42mГде:

UPDATED- статусTrueуказывает, что Machine Config Operator применил текущую конфигурацию машины к nodes в этом пуле конфигурации. Текущая конфигурация указывается в полеSTATUSполеoc get mcpвыходных данных. СтатусFalseуказывает, что node в пуле конфигураций обновляется.UPDATING- статусTrueуказывает, что Machine Config Operator применил желаемую конфигурацию машины, указанную в пользовательском ресурсеMachineConfigPool, по крайней мере, к одному из nodes в этом пуле конфигураций. Обновляемые nodes могут быть недоступны для планирования. СтатусFalseуказывает, что все nodes обновлены.DEGRADED- статусTrueуказывает, что Machine Config Operator заблокирован от применения текущей или желаемой конфигурации машины хотя бы к одному из nodes в этом пуле конфигурации или применение конфигурации не удалось. Nodes с пониженной производительностью могут быть недоступны для планирования. СтатусFalseуказывает, что все nodes готовы.MACHINECOUNT- указывает общее количество машин в этом пуле конфигурации.READYMACHINECOUNT- указывает общее количество машин в этом пуле конфигурации, готовых к планированию.UPDATEDMACHINECOUNT- указывает общее количество машин в этом пуле конфигурации, имеющих текущую конфигурацию.DEGRADEDMACHINECOUNT- указывает общее количество машин в этом пуле конфигурации, помеченных как устаревшие или несовместимые.

В примере вывода есть три master nodes и worker nodes. Плоскость управления и связанные nodes обновляются до текущей конфигурации. Worker nodes обновляются до желаемой конфигурации машины. Две worker nodes обновляются, на это указывает

UPDATEDMACHINECOUNTравное2.Пока nodes обновляются, конфигурация машины, указанная в

CONFIG, является текущей конфигурацией, с которой обновляется пул конфигурации. После завершения обновления указанная конфигурация машины будет желаемой, до которой был обновлен пул конфигурации.Выполните проверку пула конфигурации путем вывода CRD.

Настройка функций кластера#

Администратору кластера доступны следующие ресурсы конфигурации основных функций кластера DropApp Plus:

реестр образов;

конфигурация сети;

поведение сборки изображения;

поставщик удостоверений;

конфигурация etcd;

создание комплекта машин для обработки рабочих нагрузок.

Для получения текущей документации по настройкам, которыми управляются эти ресурсы, используйте команду oc explain, например: oc explain builds --api-version=config.openshift.io/v1.

Все ресурсы конфигурации кластера имеют глобальную область действия (не в namespace) и имеют имена cluster:

Имя ресурса |

Описание |

|---|---|

|

Предоставляет конфигурацию сервера API, такую как сертификаты и центры сертификации |

|

Управляет поставщиком удостоверений и конфигурацией аутентификации для кластера |

|

Управляет конфигурацией по умолчанию и принудительной конфигурацией для всех сборок в кластере |

|

Настраивает поведение интерфейса веб-консоли, включая поведение выхода из системы |

|

Включает FeatureGates для использования функции Tech Preview |

|

Настраивает способ обработки реестров образов (разрешенные, запрещенные, небезопасные сведения о центре сертификации) |

|

Сведения о конфигурации, связанные с маршрутизацией, например, домен по умолчанию для маршрутов |

|

Настраивает поставщиков удостоверений и другое поведение, связанное с внутренними потоками сервера OAuth |

|

Настраивает способ создания проектов, включая шаблон проекта |

|

Определяет прокси-серверы, которые будут использоваться компонентами, требующие доступ к внешней сети |

|

Настраивает поведение планировщика, такое как политики и селекторы nodes по умолчанию |

Эти ресурсы конфигурации представляют собой экземпляры в области кластера с именем cluster, которые управляют поведением определенного компонента, принадлежащего конкретному оператору.

Ресурсы конфигурации оператора.

Имя ресурса |

Описание |

|---|---|

|

Управляет внешним видом консоли, например, настройками фирменного стиля |

|

Настраивает параметры внутреннего реестра образов, такие как общедоступная маршрутизация, уровни журналов, настройки прокси-сервера, ограничения ресурсов, количество реплик и тип хранилища |

|

Настраивает оператора выборки для управления тем, какие примеры потоков изображений и шаблоны устанавливаются в кластере |

Выполнение операций с узлами#

По умолчанию DropApp Plus использует вычислительные машины Platform V SberLinux OS Core 8.9.1 (далее - SLC). В роли администратора доступны следующие операции в кластере:

добавление и удаление вычислительных машин;

добавление и удаление дефектов и доступов к машинам;

настройка максимального числа pods на машину.

Добавление вычислительных машин в кластер#

Предварительные условия:

кластер успешно установлен;

образы SLC, которые использовались для создания кластера, доступны;

получен URL-адрес файла конфигурации Ignition для worker nodes кластера. Этот файл загружен на HTTP-сервер во время установки.

Выполните следующую последовательность действий:

Используйте файл ISO для установки SLC на большем количестве worker nodes. Метод установки описан в документе «Руководство по установке».

После загрузки экземпляра нажмите клавишу

TABилиEдля редактирования командной строки ядра.Добавьте параметры в командную строку ядра:

coreos.inst.install_dev=sda # Укажите блочное устройство системы, на которую будет производиться установка. coreos.inst.ignition_url=http://example.com/worker.ign # Укажите URL-адрес файла конфигурации вычислений Ignition. Поддерживаются только протоколы HTTP и HTTPS.Нажмите

Enter, чтобы завершить установку. После установки SLC система перезагрузится. После перезагрузки применится указанный файл конфигурации Ignition.Повторите шаги 1-4 в зависимости от количества необходимых worker nodes для кластера.

Настройка сети#

После установки DropApp Plus доступны для настройки следующие сетевые параметры:

входящий трафик кластера;

диапазон обслуживания порта узла;

сетевая политика;

включение прокси-сервера на уровне кластера.

Конфигурация оператора сети кластера.

Конфигурация сети кластера указывается как часть конфигурации оператора сети кластера (CNO) и хранится в объекте настраиваемого ресурса (CR) с именем cluster. CR указывает поля для NetworkAPI в operator.openshift.io группе API.

Конфигурация CNO наследует следующие поля во время установки кластера от NetworkAPI в Network.config.openshift.io группе API, и эти поля нельзя изменить:

clusterNetwork- пулы IP-адресов, из которых выделяются IP-адреса pods;serviceNetwork- пул IP-адресов для сервисов;defaultNetwork.type- поставщик кластерной сети, например, OVN-Kubernetes.

Важно

После установки кластера поля, перечисленные в предыдущем разделе, изменить нельзя.

Настройка хранилища#

По умолчанию контейнеры работают с использованием эфемерного хранилища или временного локального хранилища. Эфемерное хранилище имеет ограничение по сроку службы. Чтобы хранить данные в течение длительного времени, необходимо настроить постоянное хранилище. Настроить хранилище можно одним из следующих способов:

динамическое предоставление. Выделение хранилища по требованию, определяя и создавая классы хранения, которые управляют различными уровнями хранилища, включая доступ;

статическое представление. Использование постоянных томов Kubernetes, чтобы сделать существующее хранилище доступным для кластера. Статическая подготовка может поддерживать различные конфигурации устройств и варианты подключения.

Объект StorageClass описывает и классифицирует хранилище, которое может быть запрошено, а также предоставляет средства для передачи параметров для динамически предоставляемого хранилища по требованию. StorageClass-объекты также могут служить механизмом управления различными уровнями хранения и доступом к хранилищу. Администраторы кластера определяют и создают StorageClass-объекты, которые пользователи могут запрашивать без необходимости каких-либо подробных знаний об источниках базовых томов хранения.

Платформа постоянных томов обеспечивает эту функцию и позволяет администраторам предоставлять кластеру постоянное хранилище. Платформа также дает пользователям возможность запрашивать эти ресурсы, не зная базовой инфраструктуры.

Многие типы хранилищ доступны для использования в качестве постоянных томов. Хотя все они могут быть предоставлены администратором статически, некоторые типы хранилищ создаются динамически с использованием встроенных API-интерфейсов поставщика и плагина.

Подробнее см. «Сценарии использования опциональных компонентов» -> «CSI».

Настройка пользователей#

Токены доступа OAuth позволяют пользователям аутентифицироваться в API. Для администратора кластера доступна настройка OAuth для выполнения следующих задач:

указание поставщика удостоверений;

использование управления доступом на основе ролей для определения и предоставления разрешений пользователям;

установка оператора из

OperationHub.

По умолчанию kubeadmin в кластере существует только пользователь. Чтобы указать поставщика удостоверений, необходимо создать настраиваемый ресурс (CR), описывающий этого поставщика удостоверений, и добавить его в кластер.

Следующий пользовательский ресурс (CR) показывает параметры и значения по умолчанию, которые настраивают поставщика удостоверений. В этом примере используется поставщик удостоверений htpasswd:

apiVersion: config.openshift.io/v1

kind: OAuth

metadata:

name: cluster

spec:

identityProviders:

- name: my_identity_provider # Это имя поставщика добавляется к именам пользователей для формирования идентификационного имени

mappingMethod: claim # Управляет тем, как устанавливаются сопоставления между удостоверениями и User-объектами этого поставщика

type: HTPasswd

htpasswd:

fileData:

name: htpass-secret # Существующий секрет, содержащий файл, созданный с использованием htpasswd.

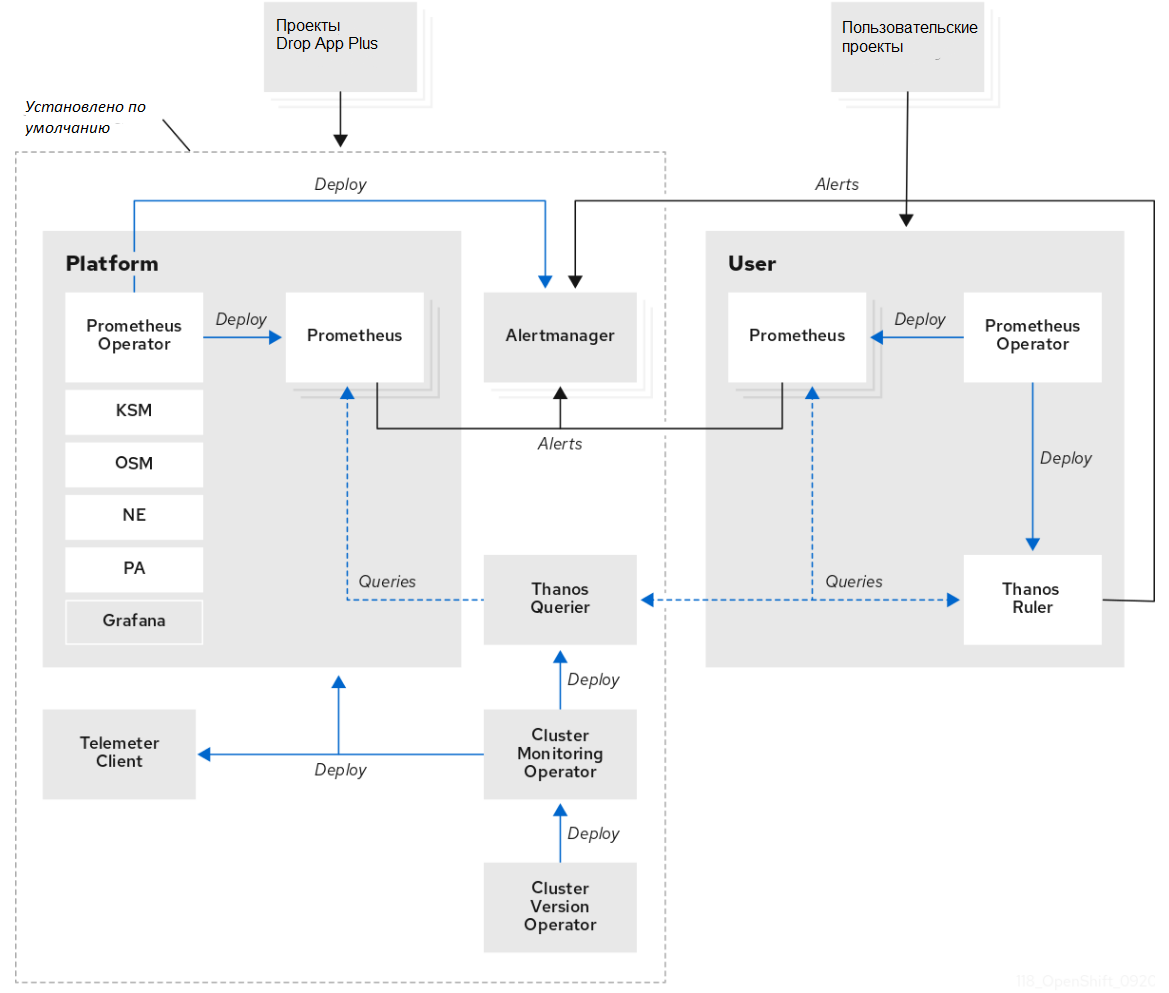

Управление оповещениями и уведомлениями#

По умолчанию оповещения о срабатывании отображаются в пользовательском интерфейсе оповещений веб-консоли.

По умолчанию оповещения не настроены на отправку в какие-либо системы уведомлений. Возможно настроить OKD для отправки оповещений следующим типам получателей:

PagerDuty;

Webhook;

Email;

Slack.

Маршрутизация оповещений получателям позволяет отправлять своевременные уведомления соответствующим группам при возникновении сбоев. Например, критические оповещения требуют немедленного внимания и обычно передаются отдельному пользователю или группе реагирования на критические ситуации. Оповещения, содержащие некритические предупреждения, вместо этого могут быть направлены в систему обработки заявок для несрочного рассмотрения.

Проверка работоспособности оповещений с помощью сторожевого таймера.

Мониторинг включает в себя постоянно срабатывающее сторожевое оповещение. Alertmanager неоднократно отправляет уведомления о предупреждениях сторожевого таймера настроенным поставщикам уведомлений. Поставщик обычно настроен на уведомление администратора, когда перестает получать оповещения сторожевого таймера. Этот механизм помогает быстро выявить любые проблемы связи между Alertmanager и поставщиком уведомлений.

Настройте приемники оповещений, чтобы получать информацию о важных проблемах в кластере:

В качестве администратора перейдите в раздел «Administration» → «Cluster Settings» → «Global Configuration» → «Alertmanager».

Альтернативно можно перейти на ту же страницу через панель уведомлений. Щелкните значок колокольчика в правом верхнем углу веб-консоли OKD и выберите «Configure» в оповещении AlertmanagerReceiverNotConfigured.

Выберите «Create Receiver» в разделе «Receivers».

В форме «Create Receiver» добавьте имя получателя и выберите тип получателя из списка.

Сценарии использования опциональных компонентов DropApp Plus#

Компоненты дистрибутива DropApp, которые могут быть использованы при реализации сценариев с данными компонентами, представлены в документе Руководство по установке в разделе «Состав дистрибутива DropApp».

API-server#

API-server — это центральный компонент кластера DropApp Plus. Он является связывающим компонентом для всех остальных сервисов. Все взаимодействие как самих компонентов, так и обращение извне к кластеру проходит через kube-apiserver и проверяется им.

Это единственный компонент кластера DropApp Plus, который общается с базой данных etcd, где хранится состояние кластера DropApp Plus.

API-Server не принимает решения, например, за то, на каком node запустить тот или иной сервис.

В нем существует логика проверки формата запросов, аутентификации, проверки прав и т.д.

Еще одной функцией API-Server является рассылка изменений конфигураций и состояния кластера DropApp Plus.

Другие компоненты подписываются на события, отслеживают их и обрабатывают, либо с определенной периодичностью считывают конфигурацию через API-Server.

Kube-scheduler#

Kube-scheduler — это компонент управляющего слоя, с его помощью необходимо отслеживать созданные pods без привязанного node и осуществлять выбор node, на котором pods должны работать. При развертывании pods на node учитывается множество факторов, включая требования к ресурсам, ограничения, связанные с аппаратными/программными политиками, принадлежности (affinity) и непринадлежности (anti-affinity) nodes/pods, местонахождения данных, предельных сроков.

Используя механизм оповещения об изменениях API-Server, kube-scheduler получает сообщения от управляющего слоя, когда необходимо запустить экземпляр сервиса и принимает решение о том, на каком node он должен быть запущен, и через API-server обновляет состояние кластера DropApp Plus. Сам kube-scheduler ничего не запускает.

Controller-manager#

Controller-manager - это компонент, отвечающий за запуск контроллеров, которые определяют текущее состояние системы.

Каждый контроллер представляет собой отдельный процесс, и для упрощения все такие процессы скомпилированы в один двоичный файл и выполняются в одном процессе.

Эти контроллеры включают:

контроллер node (Node Controller): уведомляет и реагирует на сбои node;

контроллер репликации (Replication Controller): поддерживает правильное количество pods для каждого объекта контроллера репликации в системе;

контроллер конечных точек (Endpoints Controller): заполняет объект конечных точек (Endpoints), то есть связывает сервисы (Services) и pods;

контроллеры учетных записей и токенов (Account & Token Controllers): создают стандартные учетные записи и токены доступа API для новых namespaces.

Kube-rbac-proxy#

Kube-rbac-proxy — это HTTP-прокси для одного исходящего потока, который может выполнять авторизацию RBAC для DropApp Plus API с помощью SubjectAccessReview.

В кластерах DropApp Plus без применения сетевой политики любой pod может выполнять запросы к любому другому pod в кластере. kube-rbac-proxy применяется для ограничения запросов только теми модулями, которые предоставляют действительный и авторизованный RBAC токен или клиентский TLS-сертификат.

Преимущества использования kube-rbac-proxy:

разгружает API DropApp Plus, чтобы он мог обрабатывать фактические запросы, связанные с компонентами кластера, а не запросы от клиентов;

принимает входящие HTTP-запросы, это позволяет гарантировать, что запрос авторизован и имеет право доступа к приложению, а не просто имеет сетевой доступ к объекту.

При входящем запросе kube-rbac-proxy выясняет, какой пользователь выполняет запрос. Он поддерживает использование клиентских TLS-сертификатов, а также токенов. В случае использования сертификата, он проверяется настроенным центром сертификации.

После того как пользователь прошел аутентификацию, снова используется authentication.k8s.io для выполнения SubjectAccessReview, чтобы авторизовать соответствующий запрос и убедиться, что аутентифицированный пользователь имеет необходимые роли RBAC.

У kube-rbac-proxy есть все glog флаги для ведения журнала. Чтобы использовать опциональный компонент, установите несколько флагов:

--upstream:- исходящий поток проксирования;--config-file:- файл, в котором указаны сведения о SubjectAccessReview, их необходимо выполнить по запросу. Например, можно указать, что объекту, выполняющему запрос, должно быть разрешено выполнять развертываниеget podс названиемmy-frontend-app.

Все флаги командной строки kube-rbac-proxy представлены в таблице.

Таблица. Флаги командной строки kube-rbac-proxy.

Синтаксис флага |

Значение |

|---|---|

|

Список путей, разделенных запятыми, по которым шаблон kube-rbac-proxy сопоставляет входящий запрос. Если запрос не совпадает, kube-rbac-proxy отвечает кодом состояния 404. Если этот параметр опущен, путь входящего запроса не проверяется. Нельзя использовать с параметром |

|

Значение |

|

Имя поля в заголовке запроса HTTP/2, чтобы сообщить вышестоящему серверу о группах пользователя (по умолчанию |

|

Разделитель, используемый для объединения нескольких имен групп в значении поля заголовка группы (по умолчанию |

|

Имя поля в заголовке запроса HTTP(2), сообщающее вышестоящему серверу об имени пользователя (по умолчанию |

|

Список аудиторий токенов, которые необходимо принять, разделенный запятыми. По умолчанию токен не должен иметь какой-либо конкретной аудитории. Рекомендуется установить конкретную аудиторию |

|

Любой запрос, представляющий сертификат клиента, подписанный одним из уполномоченных в файле |

|

Файл конфигурации для настройки kube-rbac-proxy |

|

Список путей, разделенных запятыми, по которым шаблон kube-rbac-proxy сопоставляет входящий запрос. Если запрос совпадает, он перенаправляет запрос без выполнения аутентификации или проверки авторизации. Нельзя использовать с флагом |

|

Путь к файлу kubeconfig*, указывающий, как подключиться к серверу API. Если значение |

|

Сертификат сервера OpenID будет проверен в файле oidc-ca при установке флага, в противном случае будет использоваться корневой набор CA хоста |

|

Идентификатор клиента для клиента OpenID Connect должен быть установлен, если установлен |

|

Идентификатор групп в заявке JWT |

|

Флаг, при установке которого все группы будут иметь префикс с этим значением, чтобы предотвратить конфликты с другими стратегиями аутентификации |

|

URL-адрес издателя OpenID, должен быть указан только в формате HTTPS. Если он установлен, он будет использоваться для проверки веб-токена OIDC JSON (JWT) |

|

Поддерживаемые алгоритмы подписи, по умолчанию |

|

Идентификатор пользователя в заявлении JWT, по умолчанию установлено значение «электронная почта» |

|

Порт для безопасного обслуживания конечных точек, специфичных для прокси-сервера (например, |

|

Адрес, который должен прослушивать HTTP-сервер kube-rbac-proxy |

|

Файл, содержащий сертификат x509 по умолчанию для HTTPS. Сертификат ЦС, если таковой имеется, объединенный после сертификата сервера |

|

Список наборов шифров для сервера, разделенный запятыми. Если этот параметр не указан, будут использоваться наборы шифров Go по умолчанию |

|

Минимальная поддерживаемая версия TLS 1.2. По умолчанию |

|

Файл, содержащий закрытый ключ x509 по умолчанию, соответствующий |

|

Интервал, с которым следует отслеживать изменения сертификата TLS 1.2, по умолчанию равен одной минуте |

|

Исходящий URL-адрес для прокси-сервера после успешной аутентификации и авторизации запросов |

|

ЦС, который исходящий поток использует для TLS 1.2-соединения. Это необходимо, когда исходящий поток использует TLS 1.2 и собственный сертификат ЦС |

|

Флаг, при установке которого клиент будет использоваться для аутентификации прокси-сервера в исходящем направлении. Также требуется установить |

|

Флаг, соответствующий сертификату из |

|

Флаг, заставляющий h2c взаимодействовать с исходящим потоком. Это необходимо, когда исходящий поток использует только h2c (открытый текст HTTP/2 — небезопасный вариант HTTP/2). Например, сервер go-grpc в небезопасном режиме без TLS 1.2 |

Глобальные флаги: |

|

|

Помощь для kube-rbac-proxy |

|

Флаг, позволяющий записывать файлы журналов в текущий каталог (не ведет запись, если |

|

Флаг, позволяющий вывести информацию о версии и выйти из приложения |

RBAC различается по двум типам, которые необходимо авторизовать: ресурсные и нересурсные. Например, авторизация запроса ресурса может заключаться в том, что запрашивающему объекту необходимо авторизоваться для выполнения действия get при развертывании DropApp.

Выполните следующие действия для защиты приложения с помощью kube-rbac-proxy (в примере ниже - prometheus-example-app). В этом примере запрашивающему объекту разрешено вызывать подресурс proxy в службе DropApp Plus с именем kube-rbac-proxy. Это настраивается в файле, переданном kube-rbac-proxy с флагом --config-file. Кроме того, необходимо установить флаг --upstream для настройки приложения, которое должно быть проксировано при успешной аутентификации и авторизации.

Kube-rbac-proxy также требует доступа RBAC для выполнения TokenReviews, а также SubjectAccessReviews. Это API-интерфейсы, доступные в DropApp Plus API для аутентификации и последующей проверки авторизации объекта.

Установка Kube-rbac-proxy#

Предварительные условия#

Предварительными условиями для установки Kube-rbac-proxy являются:

развернут кластер DropApp Plus;

установлен oc.

Установка#

Примечание

В приведенном сценарии IP адреса являются ненастоящими и приведены в качестве примера.

Для установки Kube-rbac-proxy:

Создайте файл yaml:

Создайте

deployment.yamlв DropApp Plus с использованием файлаdeployment.yaml, как представлено ниже.Команда

oc createпозволяет создать deployment на основе файлаdeployment.yaml, который содержит описание приложения и его настроек. Файлdeployment.yamlможет содержать информацию о контейнерах, ресурсах, настройках сети и другие параметры, необходимые для создания и управления deployment.oc create -f deployment.yamlВнесите при помощи текстового редактора, следующее содержание манифеста:

Пример настроек kube-rbac-proxy.yaml

apiVersion: v1 kind: ServiceAccount metadata: name: kube-rbac-proxy --- apiVersion: rbac.authorization.k8s.io/v1 kind: ClusterRoleBinding metadata: name: kube-rbac-proxy roleRef: apiGroup: rbac.authorization.k8s.io kind: ClusterRole name: kube-rbac-proxy subjects: - kind: ServiceAccount name: kube-rbac-proxy namespace: default --- apiVersion: rbac.authorization.k8s.io/v1 kind: ClusterRole metadata: name: kube-rbac-proxy rules: - apiGroups: ["authentication.k8s.io"] resources: - tokenreviews verbs: ["create"] - apiGroups: ["authorization.k8s.io"] resources: - subjectaccessreviews verbs: ["create"] --- apiVersion: v1 kind: Service metadata: labels: app: kube-rbac-proxy name: kube-rbac-proxy spec: ports: - name: HTTPs port: 8443 targetPort: HTTPs selector: app: kube-rbac-proxy --- apiVersion: v1 kind: ConfigMap metadata: name: kube-rbac-proxy data: config-file.yaml: |+ authorization: resourceAttributes: namespace: default apiVersion: v1 resource: services subresource: proxy name: kube-rbac-proxy --- apiVersion: apps/v1 kind: Deployment metadata: name: kube-rbac-proxy spec: replicas: 1 selector: matchLabels: app: kube-rbac-proxy template: metadata: labels: app: kube-rbac-proxy spec: securityContext: runAsUser: 65532 serviceAccountName: kube-rbac-proxy containers: - name: kube-rbac-proxy image: quay.io/brancz/kube-rbac-proxy:v0.14.1 args: - "--secure-listen-address=0.0.0.0:8443" - "--upstream=HTTP://127.0.0.1:8081/" - "--config-file=/etc/kube-rbac-proxy/config-file.yaml" - "--logtostderr=true" - "--v=10" ports: - containerPort: 8443 name: HTTPs volumeMounts: - name: config mountPath: /etc/kube-rbac-proxy securityContext: allowPrivilegeEscalation: false - name: prometheus-example-app image: quay.io/brancz/prometheus-example-app:v0.1.0 args: - "--bind=127.0.0.1:8081" volumes: - name: config configMap: name: kube-rbac-proxyПримечание

IP адреса являются ненастоящими и приведены в качестве примера.

Разверните объект

Job, который выполняетcurl, чтобы протестировать приложение prometheus-example-app. Поскольку он имеет правильные роли RBAC - запрос будет выполнен успешно:oc create -f client-rbac.yaml client.yamlЭто команда для создания клиента RBAC. В данном случае, команда создает два файла:

client-rbac.yamlиclient.yaml. Файлclient-rbac.yamlописывает клиента RBAC и содержит информацию о пользователях, группах и ролях, которые будут иметь доступ к ресурсам кластера. Файлclient.yamlсодержит конфигурацию клиента, включая его имя, IP-адрес и другие параметры.После выполнения команды

oc create, клиент будет создан и готов к использованию.Внесите при помощи текстового редактора, следующее содержание манифеста:

Пример манифеста

apiVersion: rbac.authorization v1 kind: ClusterRole metadata: name: kube-rbac-proxy-client rules: - apiGroups: [""] resources: ["services/proxy"] verbs: ["get"] --- apiVersion: rbac.authorization v1 kind: ClusterRoleBinding metadata: name: kube-rbac-proxy-client roleRef: apiGroup: rbac.authorization.k8s.io kind: ClusterRole name: kube-rbac-proxy-client subjects: - kind: ServiceAccount name: default namespace: default --- apiVersion: batch/v1 kind: Job metadata: name: krp-curl spec: template: metadata: name: krp-curl spec: containers: - name: krp-curl image: quay.io/brancz/krp-curl:v0.0.2 restartPolicy: Never backoffLimit: 4При просмотре журнала вывод должен отображать следующее содержание:

oc logs job/krp-curl * Trying 10.111.34.206... * TCP_NODELAY set * Connected to kube-rbac-proxy.default.svc (10.111.34.206) port 8080 (#0) > GET /metrics HTTP/1.1 > Host: kube-rbac-proxy.default.svc:8080 > User-Agent: curl/7.57.0 > Accept: */* > Authorization: Bearer eyJhbGciOiJSUzI1NiIsInR5clkLKJlkLK;lknLKnmLKNlknlkn:LkhGfgufiytFl[p;":lpl";l'kX > < HTTP/1.1 200 OK < Content-Type: text/plain; version=0.0.4 < Date: Sun, 17 Dec 2017 13:34:26 GMT < Content-Length: 102 < { [102 bytes data] * Connection #0 to host kube-rbac-proxy.default.svc left intact # Информация о версии этого бинарного файла version{version="v0.1.0"} 0Примечание

IP адреса являются ненастоящими и приведены в качестве примера.

Machine API Operator#

Machine API Operator (MAO) - оператор, который обеспечивает управление физическими серверами и виртуальными машинамии, автоматизацию развертывания виртуальных машин в кластере DropApp Plus. Путем использования машинного API оператор позволяет управлять жизненным циклом виртуальных машин, их масштабированием, мониторингом и управлением ресурсами.

Machine API Operator поддерживает автоматическое назначение IP-адресов при создании новых виртуальных машин.

Machine API Operator управляет жизненным циклом CRD - пользовательского определения ресурса, контроллеров и объектов RBAC определенного назначения, которые расширяют Kubernetes API. Это позволяет декларативно передавать желаемое состояние машин в кластере.

Контроллеры#

MachineSet Controller - контроллер машинного набора;

Убедитесь в наличии ожидаемого количества реплик и заданной конфигурации провайдера для набора машин.

Machine Controller - контроллер машины;

Убедитесь, что экземпляр

providerсоздан для объектаMachineв данном поставщике.machine-api-provider-aws;

machine-api-provider-gcp;

machine-api-provider-azure;

cluster-api-provider-libvirt;

cluster-api-provider-openstack;

cluster-api-provider-baremetal;

cluster-api-provider-ovirt;

cluster-api-provider-ibmcloud;

Nodelink Controller - контроллер Nodelink;

Убедитесь, что у машин есть nodeRef на основе IP-адресов или соответствия providerId. Пометьте nodes меткой, содержащей имя машины.

MachineHealthCheck Controller - контроллер проверки работоспособности машины.

Убедитесь, что машины, на которые нацелены объекты

MachineHealthCheck, удовлетворяют критериям работоспособности или исправлены иным образом.

Создание машин#

Создайте новую машину, применив манифест, представляющий экземпляр CRD-машины:

Пример манифеста

apiVersion: machine.openshift.io/v1beta1

kind: Machine

metadata:

labels:

machine.openshift.io/cluster-api-cluster: clusterID

machine.openshift.io/cluster-api-machine-role: role

machine.openshift.io/cluster-api-machine-type: role

name: machineName

namespace: openshift-machine-api

spec:

providerSpec:

value:

kind: AWSMachineProviderConfig

ami:

id: ami-0df3f99538fbef10f

apiVersion: awsproviderconfig.openshift.io/v1beta1

blockDevices:

- ebs:

iops: 0

volumeSize: 120

volumeType: gp2

credentialsSecret:

name: aws-cloud-credentials

deviceIndex: 0

iamInstanceProfile:

id: clusterID-worker-profile

instanceType: m5.large

placement:

availabilityZone: us-east-1a

region: us-east-1

securityGroups:

- filters:

- name: tag:Name

values:

- clusterID-worker-sg

subnet:

filters:

- name: tag:Name

values:

- clusterID-private-us-east-1a

tags:

- name: kubernetes.io/cluster/clusterID

value: owned

userDataSecret:

name: worker-user-data

Метка machine.openshift.io/cluster-api-cluster будет использоваться контроллерами для поиска нужного экземпляра облака.

Установите другие метки для предоставления пользователям удобного способа получения групп машин:

machine.openshift.io/cluster-api-machine-role: worker

machine.openshift.io/cluster-api-machine-type: worker

Разработка#

Сгенерируйте код:

make generateСоздайте сборку:

make buildИзвлеките

images.jsonв файл изinstall/0000_30_machine-api-operator_01_images.configmap.yamlи запустите:./bin/machine-api-operator start --kubeconfig ${HOME}/.kube/config --images-json=path/to/images.jsonСоздайте образ:

make image

Machine API Operator предназначен для работы совместно с Cluster Version Operator.

Развертывание Machine API Operator с Kubemark#

Разверните MAO через DropApp Plus:

kustomize build | oc apply -f -Предварительные требования для развертывания Kubemark actuator:

kustomize build config | oc apply -f -Создайте

clusterinfrastructure.config.openshift.io, чтобы сообщить MAO о развертывании поставщикаkubemark:apiVersion: apiextensions.k8s.io/v1beta1 kind: CustomResourceDefinition metadata: name: infrastructures.config.openshift.io spec: group: config.openshift.io names: kind: Infrastructure listKind: InfrastructureList plural: infrastructures singular: infrastructure scope: Cluster versions: - name: v1 served: true storage: true --- apiVersion: config.openshift.io/v1 kind: Infrastructure metadata: name: cluster status: platform: kubemarkЗапустите файл конфигурации

config/kubemark-config-infra.yaml:oc apply -f config/kubemark-config-infra.yaml

Machine image customization controller#

Machine image customization controller - это контроллер для настройки образов в DropApp Plus. Отвечает за управление и обновление образов контейнеров, развернутых в кластере. Он может использоваться для настройки параметров образа, таких как переменные окружения, секреты и другие настройки конфигурации. Работая с Machine image customization controller, можно легко внести изменения в образы контейнеров в кластере DropApp Plus без необходимости повторного развертывания всего приложения.

Создание образа#

Сетевые данные для каждого хоста должны быть в формате NMState под ключом с именем nmstate в секрете, указанном в networkDataName в поле PreprovisioningImage.

Все PreprovisioningImage файлы с меткой infraenvs.agent-install.openshift.io будут проигнорированы этим контроллером.

Сгенерированные URL-адреса являются случайными и изменятся при перезапуске контроллера.

Сохраняется только файл Ignition для каждого образа. При получении HTTP-запроса веб-сервер генерирует поток с архивом CPIO, содержащим файл Ignition и добавленный к initramfs. Поддерживаются запросы диапазона HTTP.

Настройки среды#

Требуются следующие переменные среды:

IRONIC_AGENT_IMAGE;

DEPLOY_ISO;

DEPLOY_INITRD.

Опциональны следующие переменные среды:

IRONIC_BASE_URL;

IRONIC_INSPECTOR_BASE_URL;

IRONIC_AGENT_PULL_SECRET;

IRONIC_AGENT_VLAN_INTERFACES;

IRONIC_RAMDISK_SSH_KEY;

REGISTRIES_CONF_PATH;

IP_OPTIONS;

HTTP_PROXY;

HTTPS_PROXY;

NO_PROXY.

Запуск контроллера#

Двоичный файл контроллера - /machine-image-customization-controller.

Для настройки используются следующие флаги командной строки:

-namespace- namespace, который отслеживает контроллер для согласования ресурсовpreprovisioningimage;-images-bind-addr- адрес и порт для привязки к веб-серверу;-images-publish-addr- адрес, с которого клиенты будут получать доступ к конечной точке образа.

Статическая работа#

Существует также отдельный двоичный файл, /machine-image-customization-server, который запускает веб-сервер с использованием статических конфигурационных файлов, а не как контроллер DropApp Plus.

Для настройки используются следующие флаги командной строки:

-nmstate-dir- расположение статических файлов NMState;-images-bind-addr- адрес и порт для привязки к веб-серверу;-images-publish-addr- адрес, с которого клиенты будут получать доступ к конечной точке образа.

Сluster-storage-operator#

Cluster Storage Operator - это инструмент, предназначенный для автоматизации развертывания, масштабирования и управления хранилищем данных, таким как Persistent Volumes (PV), Persistent Volume Claims (PVC) или Storage Classes, в кластере DropApp Plus.

Cluster Storage Operator позволяет упростить процесс управления хранилищем данных с помощью изменения настроек и управления данной частью инфраструктуры. Он также может обеспечивать более надежное и эффективное использование хранилища данных в кластере DropApp Plus.

Также Cluster Storage Operator обеспечивает установку плагинов тома CSI по умолчанию (см. «Сценарии использования опциональных компонентов» -> «CSI»).

Cluster-openshift-apiserver-operator#

Оператор Kubernetes API Server управляет и обновляет сервер Kubernetes API, развернутый поверх OpenShift. Оператор основан на платформе Go библиотеки OpenShift и устанавливается через оператор версии кластера (CVO).

Он содержит следующие компоненты:

Operator;

Bootstrap manifest renderer;

Installer based on static pods;

Configuration observer.

По умолчанию оператор предоставляет метрики Prometheus через сервис. Метрики собираются из компонента Kubernetes API Server Operator.

Configuration observer отвечает за реагирование на внешние изменения конфигурации. Например, это позволяет внешним компонентам (registry, etcd и т.д.) взаимодействовать с конфигурацией Kubernetes API (пользовательский ресурс KubeAPIServerConfig).

Operator также предоставляет события, которые могут помочь в отладке проблем. Чтобы получить события оператора, выполните следующую команду:

oc get events -n openshift-cluster-kube-apiserver-operator

Этот оператор настраивается через CRD KubeAPIServerс:

oc describe kubeapiserver

apiVersion: operator.openshift.io/v1

kind: KubeAPIServer

metadata:

name: cluster

spec:

managementState: Managed

Текущий статус оператора сообщается с помощью ресурса ClusterOperator. Чтобы получить текущий статус, выполните следующую команду:

oc get clusteroperator/kube-apiserver

Etcd#

Etcd — это высоконадежное распределенное хранилище данных. DropApp Plus хранит в нем информацию о состоянии существующих кластеров DropApp Plus, сервисах, сети и т.д.

Доступ к данным осуществляется через REST API. При изменениях записей, вместо поиска и изменения предыдущей копии, все предыдущие записи помечаются как устаревшие, а новые значения записываются в конец. Позже устаревшие значения удаляются специальным процессом. В важных системах, требующих избыточности и высокой доступности, etcd следует создавать в виде кластера, состоящего из нескольких nodes.

API server является основной точкой управления всего кластера DropApp. Он обрабатывает операции REST, проверяет их и обновляет соответствующие объекты в etcd. API server обслуживает DropApp Plus API и задуман как простой сервер, с большей частью бизнес-логики, реализованной в отдельных компонентах или в плагинах. Ниже приведены некоторые примеры API, доступных на сервере API.

# pods

api/v1/pods

# services

api/v1/services

# deployments

api/v1/deployments

Когда происходит работа с кластером DropApp Plus с использованием oc интерфейса командной строки, взаимодействие осуществляется с основным серверным компонентом API. Команды oc преобразуются в HTTP-вызовы REST и вызываются на сервере API. API server также отвечает за механизм аутентификации и авторизации. Все клиенты API должны быть аутентифицированы для взаимодействия с сервером API. Возможно написание клиентских библиотек/приложений DropApp Plus, используя API server.

Сluster-ingress-operator#

Сluster-ingress-operator — это компонент DropApp Plus, который обеспечивает внешний доступ к службам кластера путем настройки контроллеров Ingress, которые маршрутизируют трафик, как указано в ресурсах OpenShift Route и Kubernetes Ingress.

Чтобы обеспечить эту функциональность, Сluster-ingress-operator развертывает и управляет входным контроллером Kubernetes на базе HAProxy.

Сluster-ingress-operator реализует API входного контроллера OpenShift.

Сluster-ingress-operator — это основная функция DropApp Plus, которая включена по умолчанию.

Каждая новая установка имеет ingresscontroller с именем default, которое можно настроить, заменить или добавить экземпляры ingresscontroller. Чтобы просмотреть входной контроллер по умолчанию, используйте команду:

oc describe --namespace=openshift-ingress-operator ingresscontroller/default

Создавайте и редактируйте ресурсы ingresscontroller.operator.openshift.io для управления ingresscontroller.

Взаимодействуйте с входными контроллерами с помощью утилиты oc. Каждый ingresscontroller находится в namespace openshift-ingress-operator.

Масштабируйте ingresscontroller для обеспечения внешнего доступа к службам кластера:

oc scale \

--namespace=openshift-ingress-operator \

--replicas=1 \

ingresscontroller/<name>

oc patch \

--namespace=openshift-ingress-operator \

--patch='{"spec": {"replicas": 2}}' \

--type=merge \

ingresscontroller/<name>

Примечание

Если использование параметра where не установлено в ingresscontroller, то .spec.replica возвращает ошибку

Используйте команду oc для устранения проблем оператора:

Проверьте статус оператора:

oc describe clusteroperators/ingressПросмотрите логи оператора:

oc logs --namespace=openshift-ingress-operator deployments/ingress-operatorПроверьте состояние

ingresscontroller:oc describe --namespace=openshift-ingress-operator ingresscontroller/<name>

Machine-config-operator#

Machine-config-operator (MCO) воздействует на операционную систему (ОС), управляя обновлениями и изменениями конфигурации systemd, cri-o/kubelet, kernel, NetworkManager и других компонентов, располагающихся между ядром и kubelet.

Он также предлагает новый CRD MachineConfig, который может записывать файлы конфигурации на хост.

Machine-config-operator тесно взаимодействует как с установщиком ОС, так и с самой ОС. Как только machine-api-operator подготовит машину, Machine-config-operator ее настроит.

machine-os-content#

bootimage - это исходный образ Platform V SberLinux OS Core, например: VMWare VMDK, OpenStack QCOW2 и т.д.

bootimage в то же время является частью образа machine-os-content, которым управляет Machine-config-operator.

Примечание

machine-os-content - оболочка для фиксации OSTree. Формат OSTree - это формат образов, предназначенный для обновления операционной системы на месте; он работает на уровне файловой системы, как образы контейнеров, но, в отличие от среды выполнения контейнеров, имеет инструменты для управления такими вещами, как загрузчик и обработка сохраняемости /etc и /var.

Machine-config-operator с помощью machine-os-content обновляет слой OSTree поверх прочих операционных систем, каждое обновление – новый слой, с возможностью возвращения к предыдущим версиям.

Cluster Version Operator#

Cluster Version Operator (CVO) - один из операторов кластера, которые выполняются в каждом кластере DropApp Plus. CVO использует артефакт, называемый Выпуск образа полезной нагрузки, который представляет определенную версию DropApp Plus. Образ полезной нагрузки содержит файлы манифестов, необходимые для функционирования кластера.

CVO согласовывает ресурсы внутри кластера, чтобы они соответствовали манифестам в образе полезной нагрузки. В результате CVO реализует обновления кластера. После предоставления образа полезной нагрузки для более новой версии DropApp Plus CVO согласовывает все операторы кластера с их обновленными версиями, и операторы кластера аналогичным образом обновляют свои операнды.

Как и другие операторы кластера, Cluster Version Operators настраивается с помощью ресурса Config API в кластере ClusterVersion:

oc explain clusterversion

KIND: ClusterVersion

VERSION: config.openshift.io/v1

DESCRIPTION:

ClusterVersion is the configuration for the ClusterVersionOperator. This is

where parameters related to automatic updates can be set. Compatibility

level 1: Stable within a major release for a minimum of 12 months or 3

minor releases (whichever is longer).

FIELDS:

...

spec <Object> -required-

spec is the desired state of the cluster version - the operator will work

to ensure that the desired version is applied to the cluster.

status <Object>

status contains information about the available updates and any in-progress

updates.

Ресурс ClusterVersion следует установленному шаблону DropApp Plus, где свойство spec описывает желаемое состояние, которого CVO должен достичь и поддерживать, а свойство status заполняется CVO для описания его статуса и наблюдаемого состояния.

В типовом кластере DropApp Plus ресурс ClusterVersion с областью действия кластера, называется версией:

$ oc get clusterversion version

NAME VERSION AVAILABLE PROGRESSING SINCE STATUS

version 4.11.17 True False 6d5h Cluster version is 4.11.17

Bare metal machine controllers#

Bare metal machine controller один из набора инструментов для управления инфраструктурой bare metal с использованием DropApp Plus, реализует исполнительный механизм DropApp Cluster API.

Cluster API предоставляет декларативные API в стиле DropApp Plus для создания, настройки и управления кластерами. API является общим для нескольких облачных поставщиков.

Baremetal machine controller один из поставщиков Cluster API и позволяет пользователям развертывать кластер на основе Cluster API поверх инфраструктуры bare metal.

Cluster API - подпроект DropApp Plus, ориентированный на предоставление декларативных API и инструментов для упрощения подготовки, обновления и эксплуатации нескольких кластеров DropApp Plus.

Определения API и ресурсов#

Машина#

Ресурс машины определяется проектом Machine API Operator. Машина включает поле providerSpec, которое содержит данные, относящиеся к данному поставщику Cluster API.

machine-api-operator управляет жизненным циклом CRD, контроллеров и объектов RBAC специального назначения, которые расширяют Kubernetes API. Это позволяет передавать желаемое состояние машин в кластере декларативным способом.

BareMetalMachineProviderSpec#

image - включает в себя два подполя, url и checksum, состоящие из URL-адреса образа и URL-адреса контрольной суммы для этого образа.

userData - включает в себя два подполя, name и namespace, ссылающиеся на секрет, содержащий пользовательские данные в кодировке base64, которые должны быть записаны на диск конфигурации на подготовленном BareMetalHost.

hostSelector - задает критерии для сопоставления меток на объектах BareMetalHost. Это может быть использовано для ограничения набора доступных объектов BareMetalHost, выбранных для данной машины.

Пример настройки машины:

Пример манифеста

apiVersion: cluster.k8s.io/v1alpha1

kind: Machine

metadata:

annotations:

metal3.io/BareMetalHost: metal3/master-0

creationTimestamp: "2019-05-13T13:00:51Z"

finalizers:

- machine.cluster.k8s.io

generateName: baremetal-machine-

generation: 2

name: centos

namespace: metal3

resourceVersion: "1112"

selfLink: /apis/cluster.k8s.io/v1alpha1/namespaces/metal3/machines/centos

uid: 22acee54-757f-11e9-8091-280d3563c053

spec:

metadata:

creationTimestamp: null

providerSpec:

value:

apiVersion: baremetal.cluster.k8s.io/v1alpha1

image:

checksum: http://NNN.NN.N.N/images/CentOS-7-x86_64-GenericCloud-1901.qcow2.md5sum

url: http://NNN.NN.N.N/images/CentOS-7-x86_64-GenericCloud-1901.qcow2

kind: BareMetalMachineProviderSpec

userData:

name: centos-user-data

namespace: metal3

hostSelector:

matchLabels:

key1: value1

matchExpressions:

key: key2

operator: in

values: {'abc', '123', 'value2'}

versions:

kubelet: ""

где NNN.NN.N.N – актуальный IP адрес.

Пример секрета userData:

apiVersion: v1

data:

userData: BASE64_ENCODED_USER_DATA

kind: Secret

metadata:

annotations:

creationTimestamp: 2019-05-13T13:00:51Z

name: centos-user-data

namespace: metal3

resourceVersion: "1108"

selfLink: /api/v1/namespaces/metal3/secrets/centos-user-data

uid: 22792b3e-757f-11e9-8091-280d3563c053

type: Opaque

Поле hostSelector имеет два возможных необязательных подполя:

matchLabels- пары меток ключ/значение, которые должны точно совпадать;matchExpressions- набор выражений, которые должны принимать значениеtrueдля меток наBareMetalHost.

Допустимые операторы включают:

! - Ключ не существует. Значения игнорируются;

= - Ключ равен указанному значению. Должно быть указано только одно значение;

== - Ключ равен указанному значению. Должно быть указано только одно значение;

в - Значение является членом набора возможных значений;

!= - Ключ не равен указанному значению. Должно быть указано только одно значение;

notin - Значение не является членом указанного набора значений;

exists - Ключ существует. Значения игнорируются;

gt - Значение больше указанного. Значение должно быть целым числом;

lt - Значение меньше указанного. Значение должно быть целым числом.

Пример: BareMetalHost только с ключом key1, установленным в value1, и ключом key2, установленным в value2:

spec:

providerSpec:

value:

hostSelector:

matchLabels:

key1: value1

key2: value2

Масштабирование MachineSet#

Для автоматической масштабируемости MachineSet до количества совпадающих BareMetalHosts, пометьте MachineSet ключом metal3.io/autoscale-to-hosts и любым значением.

При согласовании MachineSet контроллер подсчитает все nodes BareMetalHosts, которые:

либо соответствуют спецификации MachineSet

Spec.Template.Spec.ProviderSpec.HostSelectorи имеют значениеConsumerRef, равноеnil;либо имеют значение

ConsumerRef, которое ссылается на машину, являющуюся частью MachineSet.

Cluster-baremetal-operator#

Cluster-baremetal-operator (CBO) разработан как оператор DropApp Plus, который отвечает за развертывание всех компонентов, необходимых для обеспечения работы серверов Baremetal, на worker nodes, которые присоединяются к кластеру DropApp Plus.

CBO отвечает за обеспечение того, чтобы развертывание metal3, состоящее из контейнеров Bare Metal Operator (BMO) и Ironic, всегда выполнялось на одном из master node в кластере DropApp Plus.

CBO отвечает за проверку обновлений DropApp Plus для ресурсов, которые он просматривает, и принятие соответствующих мер. CBO сообщает о своем собственном состоянии через ресурс ClusterOperator baremetal, как того требует каждый оператор DropApp Plus. CBO считывает и проверяет, предоставленную в ресурсе Provisioning Config (CR), и передает эту информацию в развертывание metal3. Он также создает секреты, которые используются контейнерами.

Bare Metal Operator#

Bare Metal Operator реализует Kubernetes API для управления хостами baremetal. Он ведет реестр доступных хостов в качестве экземпляров пользовательского определения ресурса BareMetalHost. Bare Metal Operator позволяет:

проверить сведения об оборудовании хоста и сообщить о них на соответствующем

BareMetalHost. Сведения включают информация о процессорах, оперативной памяти, дисках, сетевых адаптерах и многом другом;предоставить хостам заданный образ;

очистить содержимое диска хоста до или после подготовки.

BareMetalHost представляет собой хост сервера и содержит информацию о сервере. Классификация полей по следующим широким категориям:

известные свойства сервера: такие поля, как свойства

bootMACAddressсервера;неизвестные свойства сервера: такие поля, как

CPUиdisk, являются свойствами сервера и обнаруживаются Ironic;предоставленное пользователем: такие поля, как

image, предоставляются пользователем для определения загрузочного образа для сервера;динамические поля: такие поля, как IP, могут динамически назначаться серверу во время выполнения DHCP-сервером.

В течение жизненного цикла Bare Metal хоста некоторые из этих полей изменяются в зависимости от информации, поступающей от Ironic или других контроллеров, в то время такие поля, как MAC-адрес, не меняются.

Bare Metal Operator также может работать с Bare metal machine controller. При участии Bare metal machine controller и Ironic ниже показан упрощенный путь передачи информации и обзор ресурса BareMetalHost:

Пример манифеста

apiVersion: metal3.io/v1alpha1

kind: BareMetalHost

metadata:

name: node-0

namespace: metal3

spec:

bmc:

address: ipmi://NNN.NNN.NNN.N:6230

credentialsName: node-0-bmc-secret

bootMACAddress: 00:5a:91:3f:9a:bd

image:

checksum: http://MMM.MM.M.1/images/CENTOS_8_NODE_IMAGE_K8S_v1.22.2-raw.img.md5sum

url: http://MMM.MM.M.1/images/CENTOS_8_NODE_IMAGE_K8S_v1.22.2-raw.img

networkData:

name: test1-workers-tbwnz-networkdata

namespace: metal3

online: true

userData:

name: test1-workers-vd4gj

namespace: metal3

status:

hardware:

cpu:

arch: x86_64

count: 2

hostname: node-0

nics:

- ip: MMM.MM.M.73

mac: 00:5a:91:3f:9a:bd

name: enp1s0

ramMebibytes: 4096

storage:

- hctl: "0:0:0:0"

name: /dev/sda

serialNumber: drive-scsi0-0-0-0

sizeBytes: 53687091200

type: HDD

где NNN.NNN.NNN.N – актуальный IP адрес одной подсети, а MMM.MM.M.1 и MMM.MM.M.73 – актуальные IP адреса другой подсети.

Ресурс BareMetalHost содержит адрес и аутентификационную информацию для сервера.

Bare Metal Operator передает эту информацию Ironic и получает взамен сведения об оборудовании - данные проверки, такие как процессор и диск сервера. Эта информация добавляется к статусу ресурса BareMetalHost. Чтобы получить такую информацию, связанную с сервером, сервер загружается с помощью служебного ramdisk. Если происходят изменения, связанные с оборудованием, BareMetalHost обновляется соответствующим образом.

Масштабирование кластера, подготовленного пользователем, с помощью Bare Metal Operator#

После развертывания кластера инфраструктуры, подготовленного пользователем, можно использовать Bare Metal Operator (BMO) и другие компоненты metal3 для масштабирования baremetal хостов в кластере более автоматизированным способом.

Настройка Provisioning ресурса для масштабирования кластеров, подготовленных пользователем#

Создайте Provisioning пользовательский ресурс (CR), чтобы включить компоненты платформы Metal в кластере инфраструктуры, подготовленном пользователем.

Процедура#

Создайте

ProvisioningCR.Сохраните следующий YAML-настройку в файле

provisioning.yaml:apiVersion: metal3.io/v1alpha1 kind: Provisioning metadata: name: provisioning-configuration spec: provisioningNetwork: "Disabled" watchAllNamespaces: falseСоздайте

ProvisioningCR, выполнив следующую команду:oc create -f provisioning.yamlПример вывода:

provisioning.metal3.io/provisioning-configuration created

Проверка#

Убедитесь, что служба подготовки запущена, выполнив следующую команду:

oc get pods -n openshift-machine-api

Пример вывода:

NAME READY STATUS RESTARTS AGE

cluster-autoscaler-operator-678c476f4c-jjdn5 2/2 Running 0 5d21h

cluster-baremetal-operator-6866f7b976-gmvgh 2/2 Running 0 5d21h

control-plane-machine-set-operator-7d8566696c-bh4jz 1/1 Running 0 5d21h

ironic-proxy-64bdw 1/1 Running 0 5d21h

ironic-proxy-rbggf 1/1 Running 0 5d21h

ironic-proxy-vj54c 1/1 Running 0 5d21h

machine-api-controllers-544d6849d5-tgj9l 7/7 Running 1 (5d21h ago) 5d21h

machine-api-operator-5c4ff4b86d-6fjmq 2/2 Running 0 5d21h

metal3-6d98f84cc8-zn2mx 5/5 Running 0 5d21h

metal3-image-customization-59d745768d-bhrp7 1/1 Running 0 5d21h

Подготовка новых хостов в кластере, подготовленном пользователем, с помощью BMO#

BMO может быть использован для подготовки baremetal хостов в кластере, подготовленном пользователем, путем создания пользовательского ресурса BareMetalHost.

Чтобы предоставить кластеру baremetal хосты с помощью BMO, установите для спецификации spec.externallyProvisioned в пользовательском ресурсе BareMetalHost значение false.

Предварительные требования#

создан

Provisioningкластер, подготовленный пользователем;получен доступ к контроллеру управления базовой платой (BMC) к узлам;

развернута служба подготовки в кластере, создав сертификат подготовки.

Процедура#

Создайте Secret CR и BareMetalHost CR.

Сохраните следующий YAML в файле

bmh.yaml:Пример манифеста

--- apiVersion: v1 kind: Secret metadata: name: worker1-bmc namespace: openshift-machine-api type: Opaque data: username: <base64_of_uid> password: <base64_of_pwd> --- apiVersion: metal3.io/v1alpha1 kind: BareMetalHost metadata: name: worker1 namespace: openshift-machine-api spec: bmc: address: <protocol>://<bmc_url> credentialsName: "worker1-bmc" bootMACAddress: <nic1_mac_address> externallyProvisioned: false customDeploy: method: install_coreos online: true userData: name: worker-user-data-managed namespace: openshift-machine-apiСоздайте baremetal хост, выполнив следующую команду:

oc create -f bmh.yamlПример вывода:

secret/worker1-bmc created baremetalhost.metal3.io/worker1 createdУтвердите все запросы на подписание сертификатов (CSR).

Убедитесь, что состояние подготовки хоста подготовлено, выполнив следующую команду:

oc get bmh -AПример вывода:

NAMESPACE NAME STATE CONSUMER ONLINE ERROR AGE openshift-machine-api controller1 externally provisioned true 5m25s openshift-machine-api worker1 provisioned true 4m45sПолучите список ожидающих CSR, выполнив следующую команду:

oc get csrПример вывода:

certificatesigningrequest.certificates.k8s.io/<csr_name> approved

Верификация#

Убедитесь, что узел готов, выполнив следующую команду:

oc get nodes

Пример вывода:

NAME STATUS ROLES AGE VERSION

app1 Ready worker 47s v1.24.0+dc5a2fd

controller1 Ready master,worker 2d22h v1.24.0+dc5a2fd

Marketplace Operator#

Marketplace Operator - оператор, который позволяет управлять и разворачивать приложения и сервисы из Marketplace - рынка приложений, в кластере DropApp Plus.

Marketplace Operator позволяет пользователям просто настраивать и управлять различными приложениями, которые могут быть использованы в их кластере через централизованный механизм управления. Он обеспечивает простоту развертывания различных приложений в кластере DropApp Plus без необходимости знания их внутреннего устройства или конфигурации.

Open Virtual Networking with Kubernetes#

Подключаемый модуль OVN-Kubernetes Container Network Interface (CNI) — это поставщик сети для кластера по умолчанию. OVN-Kubernetes, основанный на открытой виртуальной сети (OVN), предоставляет реализацию сети на основе наложения.

Кластер, использующий сетевой поставщик OVN-Kubernetes, также запускает Open vSwitch (OVS) на каждом node. OVN настраивает OVS для реализации объявленной конфигурации сети.

OVN обеспечивает виртуализацию сети для контейнеров. В режиме наложения OVN может создавать логическую сеть между контейнерами, работающими на нескольких хостах. В этом режиме OVN программирует экземпляры Open vSwitch, работающие внутри хостов. Этими хостами могут быть простые машины или обычные виртуальные машины.

Telemeter#

Telemeter - это набор компонентов, используемых для удаленного мониторинга работоспособности DropApp Plus. Он позволяет кластерам отправлять данные их телеметрии в качестве метрик Prometheus.

Cервер телеметрии должен получать и отправлять метрики через несколько границ безопасности и, следовательно, должен выполнять несколько проверок аутентификации, авторизации и целостности данных. Он получает метрики и пересылает их вышестоящей службе в виде запроса на удаленную запись Prometheus через две конечные точки.

SDN#

SDN оригинальный сетевой плагин для DropApp Plus. Он использует Open vSwitch для локального подключения модулей с туннелями VXLAN для подключения различных nodes.

SDN предназначен для установки оператором Network Operator, и некоторые его компоненты, такие как Deployment и DaemonSet, находятся в образе Network Operator.

Network Operator определяет два образа: образ sdn, включающий SDN-компоненты контроллера и компоненты node, и образ kube-proxy, разворачивающийся сетевым оператором для сторонних сетевых плагинов, которым это необходимо.

SDN устарел и больше не разрабатывается. Рекомендуется использовать OVN Kubernetes.

Network-tools#

network-tools - это набор инструментов для отладки сетевых проблем кластера DropApp Plus. Также содержит инструменты для получения информации из кластера. Предназначен для управления и мониторинга сетевых соединений в кластере, отладки и диагностики проблем.

network-tools содержит:

сценарии отладки кластерной сети, написанные на bash;

часто используемые сетевые инструменты CLI, такие как ping, netcat, tcpdump, strace и др.

Чтобы использовать network-tools локально, клонируйте и запустите репозиторий ./debug-scripts/network-tools -h, в котором будут перечислены все доступные команды.

Чтобы использовать network-tools в кластере, используйте команду oc adm must-gather --image-stream openshift/network-tools:latest -- network-tools -h.

Network Metrics Daemon#

Network Metrics Daemon - это компонент, который собирает и публикует метрики, связанные с сетью.

После установки Network Metrics Daemon Kubelet публикует показатели, связанные с сетью:

container_network_receive_bytes_total;

container_network_receive_errors_total;

container_network_receive_packets_total;

container_network_receive_packets_dropped_total;

container_network_transmit_bytes_total;

container_network_transmit_errors_total;

container_network_transmit_packets_total;

container_network_transmit_packets_dropped_total.

Метки в этих метриках содержат:

имя pod (pod name);

pod namespace;

название интерфейса (interface name).

Network interface bond CNI#

Плагин Bond-CNI предоставляет метод объединения нескольких сетевых интерфейсов в единый логически связанный интерфейс.

CNI (Container Network Interface) - состоит из спецификации и библиотек для написания плагинов для настройки сетевых интерфейсов в контейнерах операционных систем, а также ряда поддерживаемых плагинов. CNI занимается только подключением контейнеров к сети и удалением выделенных ресурсов при удалении контейнера.

Чтобы добавить связанный интерфейс к контейнеру, необходимо создать определение сетевого подключения типа bond и добавить его в качестве сетевой аннотации в спецификации pod. Связанные интерфейсы могут быть взяты либо из хоста, либо из контейнера на основе значения параметра linksInContainer в определении сетевого подключения.

При настройке Bond CNI в качестве автономного плагина, интерфейсы формируются из namespace хост-сети. С помощью этих физических интерфейсов в namespace контейнерной сети создается связанный интерфейс.

При использовании с Multus появляется возможность связать два интерфейса, которые ранее были переданы в контейнер.

Основным вариантом использования соединения в контейнерах является сетевое резервирование приложения в случае сбоя сетевого устройства или пути и последующей недоступности.

Must-gather#

Must-gather - это инструмент для сбора данных кластера. Он выгружает данные clusteroperator и связанные с ними данные namespace в указанное местоположение --base-dir.

Сбор сценариев#

Сценарии сбора данных хранятся в ./collection-scripts. Содержимое этой папки помещено в /usr/bin в образе. Сценарии сбора данных должны включать логику сбора только для компонентов, которые включены как часть полезной нагрузки DropApp Plus. Сторонним компонентам рекомендуется создавать аналогичный образ Must-gather.

Запуск#

Запустите must-gather в кластере с помощью oc adm must-gather. Используйте флаг -h, чтобы просмотреть доступные параметры.

Cкрытие конфиденциальной информации#

Существует специальный раздел для скрытия и пропуска конфиденциальной информации must-gather-clean.

Machine-os-images#

Machine-os-images содержит компоненты, необходимые для создания node на базе Platform V SberLinux OS Core. Процесс включает в себя создание контейнера, который состоит из последней версии Platform V SberLinux OS Core для разработчиков, артефактов кластера DropApp Plus, демона Machine Controller и других различных контейнерных слоев.

Cloud Credential Operator#

Cloud Credential Operator - это контроллер, синхронизирующий пользовательские ресурсы CredentialsRequest. Запросы credentialsrequest позволяют компонентам DropApp Plus запрашивать подробные учетные данные для конкретного облачного провайдера, в отличие от использования учетных данных администратора или повышенных разрешений, предоставляемых через роли экземпляра.

Cluster-kube-storage-version-migrator-operator#

Cluster-kube-storage-version-migrator-operator (storage-version-migrator) - это управляемый контроллер ресурсов DropApp Plus, который отвечает за управление миграцией данных хранилища. Например, хранилища данных, используемые в приложениях или сервисах, при обновлении версии хранилища или сущности управления данными, такими как базы данных.

Storage-version-migrator помогает автоматизировать процесс миграции данных и обеспечивает их безопасность и целостность во время процесса обновления.

Storage-version-migrator переносит сохраненные в etcd данные в последнюю версию хранилища.

Мигратор состоит из двух контроллеров: триггерного контроллера и фактического контроллера миграции.

Триггерный контроллер:

обнаруживает изменения версии хранилища путем опроса документа обнаружения сервера API каждые 10 минут;

создает запросы на миграцию для типов ресурсов, версия хранилища которых изменяется.

Контроллер миграции обрабатывает запросы на миграцию один за другим. При переносе типа ресурса для всех объектов этого типа ресурсов контроллер миграции получает объект, а затем записывает его обратно на API server без изменений. Цель состоит в том, чтобы запустить API server для кодирования объекта в последней версии хранилища перед его сохранением.

Container Networking Plugins#

Некоторые сетевые плагины CNI поддерживаются Container Networking.

CNI (Container Network Interface) состоит из спецификации и библиотек для написания плагинов для настройки сетевых интерфейсов в контейнерах Linux и Windows, а также ряда поддерживаемых плагинов. CNI занимается только подключением контейнеров к сети и удалением выделенных ресурсов при удалении контейнера.

Поддерживаемые плагины#

Main: interface-creating:

bridge: Создаетbridge, добавляет к нему хост и контейнер;ipvlan: Добавляет интерфейсipvlanв контейнер;loopback: Устанавливает состояние интерфейса обратной связи наup;macvlan: Создает новый MAC-адрес, перенаправляет весь трафик идущий на него в контейнер;ptp: Создает паруveth;vlan: Выделяет устройствоvlan;host-device: Перемещает уже существующее устройство в контейнер;dummy: Создает новое фиктивное устройство в контейнере.

Windows: Windows specific:

win-bridge: Создаетbridge, добавляет к нему хост и контейнер;win-overlay: Создает интерфейс наложения для контейнера.

IPAM: Распределение IP-адресов:

dhcp: Запускает демона на хосте для выполнения DHCP-запросов от имени контейнера;host-local: Поддерживает локальную базу данных выделенных IP-адресов;static: Выделяет контейнеру один статический IPv4/IPv6-адрес.

Meta: другие плагины:

tuning: Настраивает параметрыsysctlсуществующего интерфейса;portmap: Плагин для отображения портов на основе iptables. Отображает порты из адресного пространства хоста в контейнер;bandwidth: Позволяет ограничить полосу пропускания за счет использования tbf управления трафиком (вход/выход);sbr: Плагин, который настраивает маршрутизацию на основе источника для интерфейса, от которого подключен;firewall: Плагин брандмауэра, который использует iptables или firewalld для добавления правил, разрешающих трафик в/из контейнера.

Cluster Update Keys#

Cluster Update Keys добавляет ConfigMap к образу DropApp Plus, который инструктирует оператора версии кластера проверять обновления с использованием предоставленных ключей и хранилищ перед их выполнением.

ConfigMap должен содержать аннотацию release.openshift.io/verification-config-map, которая предписывает оператору версии кластера проверять полезные нагрузки на соответствие сигнатурам OpenPGP в формате подписи атомарного контейнера.

Ключи в ConfigMap определяют, как выполняется проверка:

verifier-public-key-*: One or more GPG public keys in ASCII form that must have signed the

release image by digest.

store-*: A URL (scheme file://, http://, or https://) location that contains signatures. These

signatures are in the atomic container signature format. The URL will have the digest

of the image appended to it as "<STORE>/<ALGO>=<DIGEST>/signature-<NUMBER>" as described

in the container image signing format. The docker-image-manifest section of the

signature must match the release image digest. Signatures are searched starting at

NUMBER 1 and incrementing if the signature exists but is not valid. The signature is a

GPG signed and encrypted JSON message. The file store is provided for testing only at

the current time, although future versions of the CVO might allow host mounting of

signatures.

Cluster-policy-controller#

Cluster-policy-controller отвечает за поддержание ресурсов политики, необходимых для создания модулей в кластере. Контроллерами, управляемыми Cluster-policy-controller, являются:

контроллер согласования квот кластера – управляет использованием квот кластера;

контроллер распределения namespace SCC - выделяет UID и метки SELinux для namespaces.

контроллер утверждения кластера csr - утверждает csr для мониторинга очистки;

контроллер синхронизации меток допуска podsecurity - настраивает метки namespace допуска PodSecurity для namespaces с меткой

security.openshift.io/scc.podSecurityLabelSync: true.

Cluster-policy-controller запускается как контейнер в openshift-kube-controller-manager namespace, в статическом pod kube-controller-manager. Этот pod определяется и управляется оператором кластера kube-controller-manager, который устанавливает и поддерживает пользовательский ресурс KdubeControllerManager в кластере.

Его можно просмотреть с помощью:

oc get clusteroperator kube-controller-manager -o yaml

Сluster node tuning operator#

Сluster node tuning operator (CNT) - это оператор, который отвечает за оптимизацию и настройку nodes кластера для обеспечения оптимальной производительности и эффективности ресурсов.

Он анализирует производительность nodes и принимает решения о том, какие настройки и изменения должны быть применены для улучшения производительности и оптимизации использования ресурсов.

Сluster node tuning operator управляет настройкой на уровне cluster node.

Большинство высокопроизводительных приложений требуют определенного уровня настройки ядра. Оператор предоставляет пользователям унифицированный интерфейс управления sysctls на уровне node и больше гибкости для добавления пользовательской настройки. Оператор управляет контейнерным настроенным демоном, как набором демонов DropApp Plus. Это гарантирует, что спецификация пользовательской настройки передается всем демонам с контейнерной настройкой, запущенным в кластере, в понятном формате. Демоны запускаются на всех nodes кластера, по одному на каждый node.

При изменении профиля контейнерный настроенный демон отменит любые изменения настроек на уровне node перед применением нового профиля. Контейнерный настроенный демон обрабатывает сигналы завершения, откатывая все настройки на уровне node, которые он применил, перед корректным завершением работы.

Cluster Service CA Operator#

Cluster Service CA Operator - это оператор в DropApp Plus, который управляет сертификатным авторитетом (CA) для кластера. Он обеспечивает генерацию, обновление и управление сертификатами для различных компонентов и nodes в кластере.

Cluster Service CA Operator автоматически управляет выпуском сертификатов на основе запросов от различных компонентов в кластере. Он генерирует сертификаты для nodes кластера, служб, хранилищ данных и других ресурсов. Оператор также автоматически обновляет и перевыпускает сертификаты при истечении их срока действия.

Предоставляет возможность отслеживать и контролировать доступ к различным ресурсам и компонентам в кластере с помощью сертификатов.

Cluster Service CA Operator обычно устанавливается и конфигурируется вместе с кластером DropApp Plus и предлагает средства для управления сертификатами из командной строки или интерфейса пользователя. Интегрируется с другими компонентами и инструментами безопасности в DropApp Plus, такими как RBAC (модель на основе ролей), для обеспечения более надежной аутентификации и авторизации в кластере.

Cluster Service CA Operator запускает следующие контроллеры:

serving cert signer - выдает подписанную пару, обслуживающий сертификат/ключ, службам, помеченным

service.beta.openshift.io/serving-cert-secret-nameс помощью секрета.configmap cabundle injector - отслеживает конфигурационные карты, помеченные

service.beta.openshift.io/inject-cabundle=true, и добавляет или обновляет элемент данных (ключservice-ca.crt), содержащий пакет подписи CA в кодировке PEM. Затем пользователиconfigmapмогут доверятьservice-ca.crtв своей конфигурации клиента TLS, разрешая подключения к службам, использующим сертификаты обслуживания служб.

Cluster Network Operator#

Cluster Network Operator устанавливает и обновляет сетевые компоненты в кластере DropApp Plus.

Cluster Network Operator предоставляет инструменты для создания и настройки сетевых политик, балансировки нагрузки, маршрутизации и других функций сетевого взаимодействия внутри кластера.

Упрощает настройку и управление сетью в кластере DropApp Plus, предоставляя средства для выполнения сложных задач сетевого взаимодействия и автоматического управления сетевыми службами.

Cluster Network Operator следует шаблону контроллера: согласовывает состояние кластера с желаемой конфигурацией. Конфигурация, указанная с помощью CustomResourceDefinition с именем Network.config.openshift.io/v1, имеет соответствующий тип.

Большинство пользователей смогут использовать Config API верхнего уровня, который имеет сетевой тип. Оператор автоматически преобразует объект Network.config.openshift.io в Network.operator.openshift.io.

Чтобы связаться с оператором сети:

oc get -o yaml network.operator cluster

Когда контроллер согласован и все зависимые от него ресурсы объединены, в кластере должен быть установлен сетевой плагин и рабочая сервисная сеть. В DropApp Plus сетевой оператор кластера запускается на самом раннем этапе процесса установки – пока сервер boostrap API все еще запущен.

Cluster machine approver#

Cluster machine approver - контроллер, предоставляющий следующие функциональные возможности:

отслеживание конечной точки CSR на предмет запросов CSR;

решение о разрешении или запрете CSR;

утверждение или отклонение и обновление статуса CSR.

CSR (Certificate Signing Request - запрос на подписание сертификата) — это зашифрованный запрос на выпуск сертификата, содержащий подробную информацию о домене и организации. Генерация CSR является необходимой процедурой подготовки к получению SSL-сертификата. Сгенерированный CSR включается в анкету на получение сертификата.

DropApp Plus обладает поддержкой TLS bootstrapping для nodes.