Сценарии администрирования#

Администрирование компонента Pangolin (PSQL) продукта Platform V Pangolin SE (PSQ) (далее – Pangolin) осуществляется средствами, которые описаны в этом разделе.

Реализация АРМ администратора#

Для администрирования системы используется утилита psql. Эта утилита представляет собой терминальный клиент для передачи запросов к СУБД и отображения результатов.

psql [параметр...] [имя_бд [имя_пользователя]]

Примечание:

Решение по обеспечению безопасности АРМ администратора должно исходить из окружения конечной АС.

Получение информации об используемой версии#

В данном разделе приведены примеры команд для получения используемой версии Pangolin. Примеры команд одинаковы для любой из используемых ОС.

Для клиентской части#

Чтобы получить название и версию клиентской части Pangolin, запустите любую команду с ключом --product_version, например:

Команда:

pg_ctl --product_version

Результат выполнения команды:

Platform V Pangolin 5.2.0

где:

Platform V Pangolin SE — наименование продукта;

5.2.0 — версия продукта.

Чтобы получить название и версию PostgreSQL, запустите любую команду с ключом --version, например:

Команда:

pg_ctl --version

Результат выполнения команды:

pg_ctl (PostgreSQL) 13.4

Для серверной части#

Для получения названия и версии продукта серверной части подключитесь к серверу Pangolin, чтобы:

узнать версию Pangolin:

Команда:

SELECT product_version();Результат выполнения команды:

product_version --------------------------- Platform V Pangolin SE 5.1.0 (1 row)узнать версию PostgreSQL:

Команда:

SELECT version();Результат выполнения команды:

version --------------------------------------------------------------------------------------------------------- PostgreSQL 13.4 on x86_64-pc-linux-gnu, compiled by gcc (GCC) 4.8.5 20150623 (Red Hat 4.8.5-44), 64-bit (1 row)Примечание:

Вывод может отличаться от приведенного в примере.

Получение информации о сборке продукта#

Чтобы получить информацию о сборке Pangolin, запустите любую команду с ключом --product_build_info, например:

Команда:

pg_ctl --product_build_info

Результат выполнения команды:

build 54 (22:27:09 05.02.2022) commit {хеш}

где:

54— порядковый номер сборки продукта;22:27:09 05.02.2022— время и дата сборки продукта;{хеш}— хеш-сумма исходных кодов продукта (идентификатор коммита в git репозитории продукта).

Пример вывода информации о сборке продукта для psql:

Команда:

SELECT product_build_info();

Результат выполнения команды:

build 54 (22:27:09 05.02.2022) commit {хеш}

Примечание:

Вывод может отличаться, но будет сохранена структура и формат.

Получение хеш-суммы внутренней версии компонента продукта#

Для PostgreSQL можно получить хеш-сумму с помощью параметра --product_component_hash, например:

Команда:

pg_ctl --product_component_hash

Интерфейс администратора безопасности Pangolin#

Интерфейс администратора безопасности включает в себя следующие функции:

Действия с политиками:

pm_get_policies- вывод списка политик;pm_get_policy_grants- вывод списка разрешений (правил) в составе политики;pm_make_policy- создание политики;pm_grant_to_policy- внесение в политику разрешения на действия над объектом;pm_revoke_from_policy- исключение из политики разрешения на действия над объектом;pm_suspend_object- приостановка действия политики защиты;pm_resume_object- возобновление действия политики защиты;pm_remove_policy- удаление политики защиты.

Действия с пользователями:

pm_get_assigned_policies- вывод списка политик, назначенных пользователю;pm_assign_policy_to_user- назначение политики пользователю;pm_unassign_policy_from_user- изъятие политики у пользователя.

Действия над объектами:

pm_get_protected_objects- вывод списка объектов, находящихся под защитой;pm_protect_object- помещение объекта БД под защиту;pm_unprotect_object- снятие защиты с объекта БД;pm_get_object_access_path- получение информации об эффективных действующих для указанных объекте и роли ограничениях защиты и разрешениях на доступ к объекту под защитой.

Действия для администраторов безопасности:

pm_create_security_admin- создание учетной записи администратора безопасности;pm_set_security_admin_password- изменение пароля учетной записи администратора безопасности;pm_grant_security_admin- назначение пользователя администратором безопасности;pm_revoke_security_admin- снятие с пользователя политики администратора безопасности;pm_unblock_security_admin- разблокировка заблокированной учетной записи администратора безопасности.

Интерфейс управления парольными политиками: PL/pgSQL API#

Все запросы к базе выполняются через SPI интерфейс (то есть не через внутренний API Pangolin), так как вероятность изменения SQL интерфейса меньше.

Настройки механизма хранятся в файле postgresql.conf. Данный файл также содержит значения по умолчанию для настроек парольной политики. Настройки парольной политики хранятся в таблице pg_pp_policy.

При включенной защите от привилегированных пользователей, в режиме защищенного конфигурирования, параметры парольных политик конфигурируются администратором безопасности в хранилище секретов — HashiCorp Vault, в случае отсутствия KMS-hosts (использования эмулятора) для хранения параметров используются локальные конфигурационные файлы.

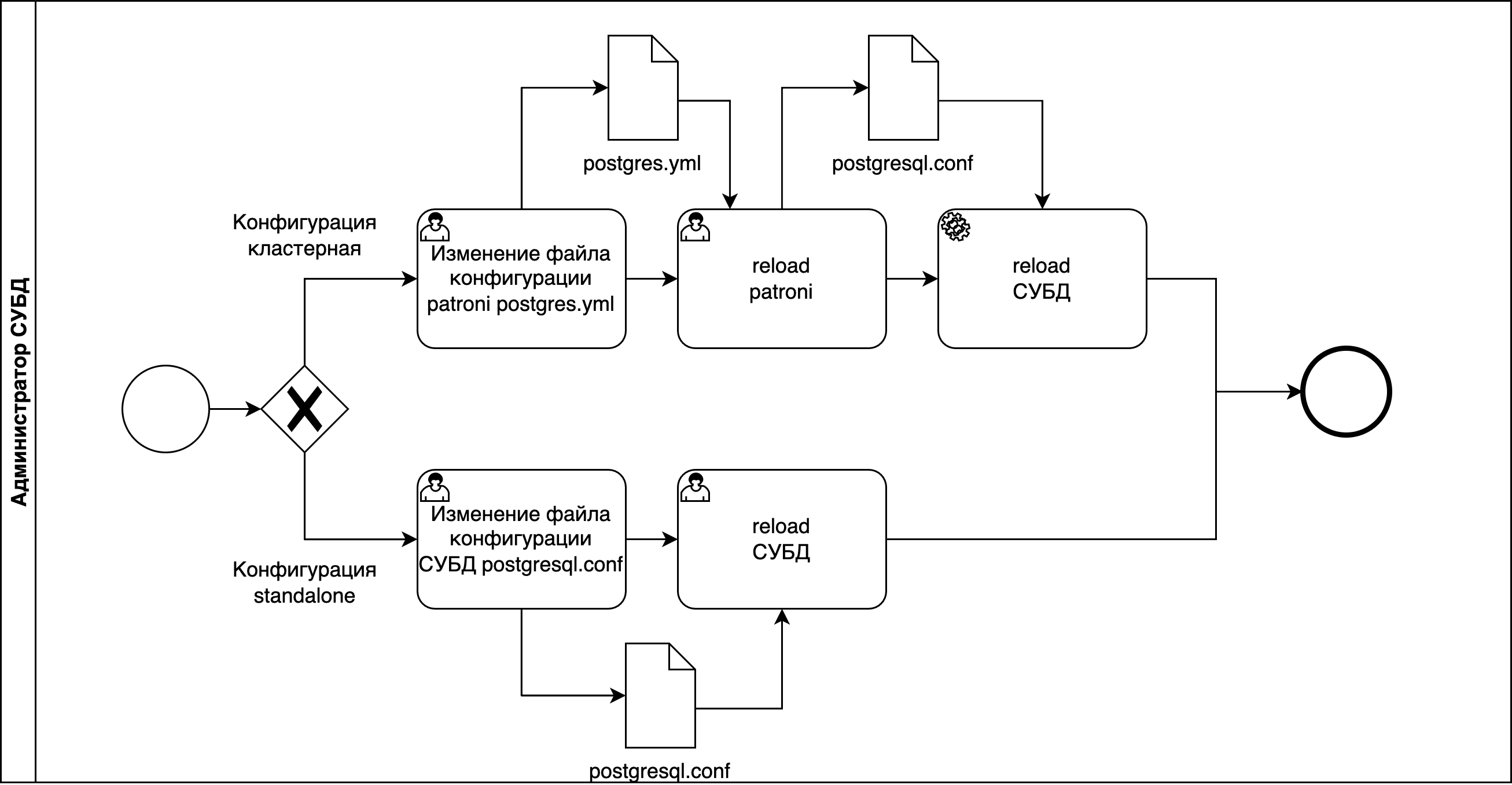

Параметры парольной политики хранятся в файле в зависимости от типа конфигурации сервера, если тип конфигурации:

standalone — в файле

$PGDATA/postgresql.conf;cluster — в файле

/etc/pangolin-manager/postgres.yml.

Подробнее о параметрах файла postgresql.conf в разделе «Параметры в postgresql.conf» данного документа.

Внимание!

При подключении через Pangolin Pooler с включенной сквозной аутентификацией ограниченно действуют парольные политики в части времени действия пароля и количества подключений. Проверка происходит только при первом подключении. Это связано с тем, что при подключении под Pangolin Pooler создается токен подключения. После получения данного токена следующее переподключение произойдет через

server_lifetime.

Сценарии работы с механизмом#

Большинство операций выполняется соответствующими функциями PL/pgSQL (см.«Список PL/SQL функций продукта», раздел «Парольные политики»):

создание парольной политики;

активация парольной политики;

деактивация парольной политики;

отображение парольных политик, примененных к роли;

отображение всех активных политик;

разблокировка роли.

Включение механизма (password_policies_enable)#

Параметр password_policies_enable включает (on) или выключает (off) механизм.

Статистика и история по паролю ведется в любом состоянии механизма.

Использование значений настроек парольной политики из файла postgresql.conf (password_policy.deny_default)#

Параметр password_policy.deny_default включает (on) или выключает (off) использование значений для настроек парольной политики из файла postgresql.conf.

Примечание:

Если выключить параметр

password_policy.deny_default:password_policy.deny_default=offто для всех политик должны быть заданы все обязательные настройки (см. подраздел «Обязательные настройки парольной политики» данного документа).

Управление шифрованием пароля (password_policy.psql_encrypt_password)#

Параметр password_policy.psql_encrypt_password управляет шифрованием пароля при передаче от фронтенда (psql) к базе с помощью команды psql \password .

В случае, если шифрование отключено, пароль передается хешем. Если при этом включены проверки пароля (сам механизм и один из способов проверки пароля), парольными политиками будет вызвана ошибка.

Задание значений по умолчанию для настроек парольной политики#

Все настройки для парольной политики имеют аналог в файле postgresql.conf. Это необходимо для возможности задания значения по умолчанию для настроек парольной политики.

Подробное описание настроек приведено в разделе «Использование значений настроек парольной политики из файла postgresql.conf» данного документа.

Создать новую политику#

Примечание:

Для созданной парольной политики необходимо перечислить параметры с новыми значениями и указать связанные с ними параметры.

Если связанные параметры с основным не будут указаны, то новая политика не применится.

Для создания новой политики последовательно выполните функции:

Создания парольной политики.

Примечание:

Если какая-либо настройка политики не задана, то ее значение берется из конфигурационного файла.

Активации парольной политики.

Функции создания и активации парольной политики описаны в документе «Список PL/SQL функций продукта», раздел «Парольные политики».

Разблокировать роль#

Выполняется соответствующей SQL-функцией (см. «Список PL/SQL функций продукта» раздел «Парольные политики»).

Активировать или деактивировать политику#

Выполняется соответствующими SQL-функциями:

активация парольной политики;

деактивация парольной политики.

Подробнее о функциях для данной функциональности в документе «Список PL/SQL функций продукта», раздел «Парольные политики».

Изменить настройки политики#

Выполняется соответствующей SQL-функцией (см. «Список PL/SQL функций продукта» раздел «Парольные политики»).

При изменении параметров учитывайте зависимости между ними и изменяемую функциональность (см. ниже подраздел «Обязательные настройки парольной политики»). Нельзя изменить параметр roloid.

Сменить политику для роли#

Роли связаны с политиками по идентификатору роли. Изменить политику для роли можно следующими способами:

удалить старую политику и создать новую политику;

включить роль в другую роль с нужной политикой.

Подробнее о функциях в документе «Список PL/SQL функций продукта», раздел «Парольные политики».

Обязательные настройки парольной политики#

Функциональность |

Обязательный параметр |

Зависимые параметры |

|---|---|---|

Хранение паролей |

Один из: |

- |

Изменение пароля |

|

- |

Синтаксическая проверка пароля |

|

|

Использование пакета cracklib |

|

- |

Проверка пароля библиотекой zxcvbn |

|

|

Пользовательская PSQL функция проверки пароля |

|

- |

Аутентификация |

|

- |

Пользовательская функция проверки пароля#

Пользователь может создать PL/pgSQL функцию проверки пароля. Ниже описаны требования к пользовательской функции.

Требование |

Описание |

|---|---|

Применимо к механизмам |

Создание или изменение роли |

Не применимо к механизмам |

Аутентификация по паролю |

Требования к вызову |

Пользовательская функция проверки пароля должна вызываться из PSQL: |

Прототип |

|

Входные атрибуты |

|

Требование к возвращаемому значению |

|

Примечание:

Зашифрованный пароль приходит, если Pangolin подключен к сторонней системе аутентификации.

Параметры для управления транспортными паролями#

Параметр |

Описание |

|---|---|

|

Определяет тип пароля (транспортный или нет) для указанных ТУЗ. По умолчанию — |

|

Определяет время жизни транспортного пароля. По умолчанию — |

|

При значении |

Разблокирование и восстановление работы кластера#

Определите, на каком хосте был последний активный лидер. Это можно проверить по логам Pangolin Manager:

host1$ sudo journalctl --since "5 hours ago" -u pangolin-manager | grep "i am " | tail -1 Aug 04 22:38:17 <Адрес сервера> python3[14026]: 2020-08-04 22:38:17,824 INFO: no action. i am the leader with the lock host2$ sudo journalctl --since "5 hours ago" -u pangolin-manager | grep "i am " | tail -1 Aug 04 22:38:07 <Адрес сервера> python3[21032]: 2020-08-04 22:38:07,814 INFO: no action. i am a secondary and i am following a leaderВ данном случае лидер был на хосте «host1».

Остановите Pangolin Manager на хосте последнего лидера:

host1$ sudo systemctl stop pangolin-managerЗапустите Pangolin в однопользовательском режиме:

host1$ postgres --singleЕсли postgres не запускается даже на предположительном лидере и выводит ошибку:

2020-08-04 23:08:34 MSK [20019]: [1-1] app=,user=,db=,client= LOG: database system was shut down in recovery at 2020-08-04 23:08:30 MSK 2020-08-04 23:08:34 MSK [20019]: [2-1] app=,user=,db=,client= WARNING: recovery command file "recovery.conf" specified neither primary_conninfo nor restore_command 2020-08-04 23:08:34 MSK [20019]: [3-1] app=,user=,db=,client= HINT: The database server will regularly poll the pg_wal subdirectory to check for files placed there. 2020-08-04 23:08:34 MSK [20019]: [4-1] app=,user=,db=,client= FATAL: standby mode is not supported by single-user serversУберите файл

recovery.confиз$PGDATAи снова выполните запуск:host1$ mv $PGDATA/recovery.conf{,.back} host1$ postgres --singleВ

single userрежиме выполните SQL команды от лица пользователяpostgres. Для выхода нажмитеCtrl/Cmd-D. Разблокируйте рольpostgres:select unblock_role('postgres')Если при попытке разблокировать пользователя

postgresвыходит ошибка:backend> select unblock_role('postgres') 1: unblock_role (typeid = 16, len = 1, typmod = -1, byval = t) ---- 2022-07-05 11:58:17 MSK [19233]: [2-1] app=[unknown],user=postgres,db=postgres,client=[tty] ERROR: Cant find role with Oid 10 in password policy cache 2022-07-05 11:58:17 MSK [19233]: [3-1] app=[unknown],user=postgres,db=postgres,client=[tty] STATEMENT: select unblock_role('postgres')Выполните команду для разблокировки пользователя

postgres:backend> update pg_pp_policy set lockout='f' WHERE roloid = to_regrole('postgres'); backend>Запустите службу Pangolin Manager.:

host1$ sudo systemctl start pangolin-managerУбедитесь, что кластер вернулся в стабильное состояние. В таблице вывода в столбце

Roleдолжен быть указанLeader:host1$ list + Cluster: clustername (6857170778029161231) ----------------------------------------+--------------+---------+----+-----------+ | Member | Host | Role | State | TL | Lag in MB | +---------------------------------------+--------------------------------------------+--------------+---------+----+-----------+ | <Адрес сервера> | <Адрес сервера>:5433 | Sync Standby | running | 4 | 0 | | <Адрес сервера> | <Адрес сервера>:5433 | Leader | running | 4 | | +---------------------------------------+--------------------------------------------+--------------+---------+----+-----------+Стандартным образом разблокируйте остальных администраторов БД.

Справочник журнальных сообщений#

Сообщение |

Расшифровка |

Решение |

|---|---|---|

User blocked: too many login fails |

Пользователь заблокирован из-за превышения счетчика неудачных аутентификаций |

Пользователь будет разблокирован, когда пройдет |

Password was expired |

Пользователь заблокирован из-за просроченного пароля |

Сменить пароль пользователя |

Role blocked cause long inactivity |

Пользователь заблокирован из-за долгой неактивности |

Пользователь может быть разблокирован с помощью команд |

Password will expire in <интервал> |

Предупреждение об оставшемся времени до обязательной смены пароля |

|

Password was expired. <число> grace logins left |

Время жизни пароля превышено. Осталось <число> входов, после которых пользователь будет заблокирован |

|

Password was expired. Grace period ends in <интервал> |

Время жизни пароля превышено. Осталось <интервал>, после истечения которого пользователь будет заблокирован |

Параметры в postgresql.conf#

В данном разделе более подробно описаны параметры файла postgresql.conf.

password_policy.policy_enable (Состояние по умолчанию для парольной политики)#

Признак включенной парольной политики:

on– политика включена;off– политика выключена.

Тип |

POSIX шаблон |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|

boolean |

on/off |

on |

policyenable |

password_policy.deny_default#

Запрет использования значений для настроек политик, указанных в файле postgresql.conf:

on– включить использование значений настроенных политик, указанных в файлеpostgresql.conf;off– выключить использование значений настроенных политик, указанных в файлеpostgresql.conf.

Тип |

POSIX шаблон |

Значение по умолчанию |

|---|---|---|

boolean |

on/off |

off |

Настройка хранения паролей#

password_policy.reuse_time#

Время в секундах, в течение которого старый пароль сохраняется и попытка сменить пароль на совпадающий со старым заканчивается ошибкой.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|

string |

\d+ s |

не отрицательное |

365 days |

reusetime |

password_policy.in_history#

Максимальное количество сохраненных старых паролей. При достижении максимума добавление еще одного старого пароля приводит к удалению наиболее старого (по pg_pp_history.createtime) из них.

Примечание:

Если задан параметр

password_policy.reuse_time, то параметрpassword_policy.in_historyне используется.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

integer |

[0-1000] |

0 - 1000 |

4 |

0 – Проверка на совпадение пароля с ранее использованным не проводится (при условии |

inhistory |

Время жизни пароля#

password_policy.max_age#

Время жизни пароля в секундах, после которого пароль считается истекшим.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

string |

\d+ s |

не отрицательное |

0 |

0 – Проверка максимального времени жизни пароля не производится |

maxage |

password_policy.min_age#

Время в секундах, которое должно пройти между двумя изменениями пароля.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

string |

\d+ s |

не отрицательное |

0 |

0 – Проверка максимального времени жизни пароля не производится |

minage |

password_policy.grace_login_limit#

Максимальное количество аутентификаций, доступных роли после истечения времени жизни пароля.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|

integer |

[0-1000] |

0 - 1000 |

0 |

graceloginlimit |

password_policy.grace_login_time_limit#

Время в секундах после окончания действия пароля, в течение которого он продолжает работать. Если вычисленное значение graceloginlimit=0, то параметр не учитывается.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

string |

\d+ s |

не отрицательное |

3 days |

0 – аутентификация не доступна по истечении времени жизни пароля |

gracelogintimelimit |

password_policy.expire_warning#

Время в секундах до окончания действия пароля, в течение которого пользователю будет отображаться предупреждение.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

string |

\d+ s |

не отрицательное |

7 days |

0 – не выводит предупреждение |

expirewarning |

Поведение при неудачной аутентификации#

password_policy.lockout#

Блокировка аккаунта в результате достижения максимума попыток входа с неверным паролем:

on – включить блокировку;

off – выключить блокировку.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|

boolean |

on/off |

lockout |

on |

lockout |

password_policy.max_failure#

Максимальное количество введенных подряд неверных паролей, при достижении которого вызывается блокировка пароля.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|

integer |

[1-1000] |

1 - 1000 |

6 |

maxfailure |

password_policy.failure_count_interval#

Время в секундах, после которого обнуляется количество неверных вводов пароля.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

string |

\d+ s |

>= 0 |

0 |

0 – счетчик не обнуляется |

failurecountinterval |

password_policy.lockout_duration#

Время в секундах, на которое блокируется аккаунт в результате достижения максимума попыток входа с неверным паролем.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

string |

\d+ s |

не отрицательное |

24 hours |

0 – блокировка пользователя по количеству неудачных аутентификаций бессрочна |

lockoutduration |

Синтаксические проверки пароля#

password_policy.check_syntax#

Признак включенных правил синтаксической проверки пароля:

on– включить механизм;off– выключить механизм.

Тип |

POSIX шаблон |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|

boolean |

on/off |

on |

checksyntax |

password_policy.alpha_numeric#

Минимальное количество цифр в пароле. Если вычисленное значение checksyntax=false, то параметр не учитывается.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

integer |

[0-1000] |

0 - 1000 |

3 |

0 – не проверять |

alphanumeric |

password_policy.min_length#

Минимальная длина пароля. Если вычисленное значение checksyntax=false, то параметр не учитывается.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

integer |

[0-1000] |

0 - 1000 |

16 |

0 – не проверять |

minlength |

password_policy.min_alpha_chars#

Минимальное количество букв в пароле. Если вычисленное значение checksyntax=false, то параметр не учитывается.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

integer |

[0-1000] |

0 - 1000 |

0 |

0 – не проверять |

minalphachars |

password_policy.min_special_chars#

Минимальное количество символов в пароле, не являющихся буквой или цифрой. Если вычисленное значение checksyntax=false, то параметр не учитывается.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

integer |

[0-1000] |

0 - 1000 |

0 |

0 – не проверять |

minspecialchars |

password_policy.min_uppercase#

Минимальное количество прописных букв. Если вычисленное значение checksyntax=false, то параметр не учитывается.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

integer |

[0-1000] |

0 - 1000 |

1 |

0 – не проверять |

minuppercase |

password_policy.min_lowercase#

Минимальное количество строчных букв. Если вычисленное значение checksyntax=false, то параметр не учитывается.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

integer |

[0-1000] |

0 - 1000 |

0 |

0 – не проверять |

minlowercase |

password_policy.max_rpt_chars#

Максимальное количество повторяющихся символов. Если вычисленное значение checksyntax=false, то параметр не учитывается.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

integer |

[0-1000] |

0 - 1000 |

0 |

0 – не проверять |

maxrptchars |

Проверка максимального времени неактивности пользователя#

password_policy.track_login#

Запоминать ли время последней аутентификации:

on– запоминать;off– не запоминать.

Тип |

POSIX шаблон |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|

boolean |

[0-1000] |

off |

tracklogin |

password_policy.max_inactivity#

Время в секундах после последней аутентификации, после которого роль будет заблокирована.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Специальные значения параметров |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|---|

string |

\d+ s |

не отрицательное |

0 |

0 – функциональность отключена |

maxinactivity |

Использование библиотеки zxcvbn#

password_policy.use_password_strength_estimator#

Включить или выключить использование библиотеки zxcvbn для проверки пароля:

on– включить механизм;off– выключить механизм.

Тип |

POSIX шаблон |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|

boolean |

on/off |

on |

usepasswordstrengthestimator |

password_policy.password_strength_estimator_score#

Минимальная оценка сложности пароля, допустимая в системе. Если вычисленное значение usepasswordstrengthestimator=false, то параметр не учитывается.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|---|

integer |

[0-4] |

0 - 4 |

3 |

passwordstrengthestimatorscore |

Использование пользовательской функции проверки пароля#

password_policy.custom_function#

Название пользовательской PL/pgSQL функции проверки пароля.

Тип |

POSIX шаблон |

Аналог в таблице pg_pp_policy |

|---|---|---|

string |

[\w\d]+ |

customfunction |

Использование библиотеки cracklib#

password_policy.illegal_values#

Использовать библиотеку cracklib для проверки пароля по списку часто используемых:

on– включить проверку;off– выключить проверку.

Тип |

POSIX шаблон |

Значение по умолчанию |

Аналог в таблице pg_pp_policy |

|---|---|---|---|

boolean |

on/off |

on |

illegalvalues |

Настройка кэширования#

password_policy.pp_cache_dump_interval#

Интервал сохранения данных кэша из памяти на диск (при наличии изменений).

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

|---|---|---|---|

integer |

\d+ |

1 - до максимального значения int в системе |

10 |

password_policy.pp_cache_init_size#

Размер изначально инициализированного кэша парольных политик в пользователях.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

|---|---|---|---|

integer |

\d+ |

1 - до максимального значения int в системе |

10 |

password_policy.pp_cache_soft_max_size#

Предполагаемый максимальный размер кэша парольных политик в пользователях. Используется для оптимизации работы кэша, не задает жестких ограничений.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

|---|---|---|---|

integer |

\d+ |

1 - до максимального значения int в системе |

60 |

password_policy.pp_cache_max_size#

Ограничение сверху на размер кэша парольных политик в пользователях. В случае превышения, аутентификации новых пользователей будут заканчиваться ошибкой.

Тип |

POSIX шаблон |

Ограничение значения |

Значение по умолчанию |

|---|---|---|---|

integer |

\d+ |

1 - до максимального значения int в системе |

1000 |

psql_encrypt_password#

Шифрование пароля при передаче от фронтенда (psql) к базе:

on– включить шифрование;off– выключить шифрование.

Пароль передается в захешированном виде, при этом парольные политики вызовут ошибку, если включены проверки пароля.

Тип |

POSIX шаблон |

|---|---|

boolean |

on/off |

password_policy.deduplicate_ssl_no_ssl_fail_auth_attepmts#

Включение механизма дедупликации повторных попыток подключения psql.

Тип |

POSIX шаблон |

Значение по умолчанию |

|---|---|---|

boolean |

on/off |

on |

password_policy.allow_hashed_password#

Разрешить задание пароля в виде хеша.

Тип |

POSIX шаблон |

Значение по умолчанию |

|---|---|---|

boolean |

on/off |

off |

Авторизация и аутентификация#

Pangolin поддерживает несколько типов авторизации и аутентификации пользователей и сервисов.

В данном разделе более подробно рассмотрены варианты сквозной и двухфакторной авторизации.

Сквозная аутентификация Pangolin Pooler — Pangolin#

В Pangolin Pooler и Pangolin реализован механизм сквозной аутентификации. Программа Pangolin Pooler выступает в режиме проксирования данных аутентификации от клиента к Pangolin и обратно, аутентификация пользователя выполняется только на Pangolin.

Количество итераций обмена данными аутентификации для конкретного пользователя зависит от установленных в файле pg_hba.conf методов аутентификации. Обмен данными аутентификации между Pangolin Pooler и Pangolin выполняется по отдельным сетевым каналам. Количество сетевых каналов зависит от количества баз данных, к которым выполняется подключение пользователей.

Конфигурирование сквозной аутентификации в Pangolin Pooler#

Настроить сквозную аутентификацию в Pangolin Pooler можно с помощью конфигурационных параметров, описанных в данном разделе.

Параметры аутентификации:

auth_proxy (string)— параметр включает/выключает режим сквозной аутентификации:off— режим сквозной аутентификации выключен, выполняется локальная аутентификация пользователя (значение по умолчанию);on— режим сквозной аутентификации включен, выполняется аутентификация пользователя только на Pangolin;

auth_failure_threshold (integer)— параметр задает максимальное число НЕ аутентифицированного N раз подряд клиента с идентичными параметрами (тип соединения, адрес клиента, база данных и имя пользователя), при котором будет взведен таймер не активности аутентификации для этого клиента. Значение по умолчанию 0 (выключено);auth_inactivity_period (integer)— параметр определяет период не активности аутентификации (в секундах). Это время, в течение которого ранее НЕ аутентифицированному более N раз подряд клиенту при подключении с идентичными параметрами (тип соединения, адрес клиента, база данных и имя пользователя), Pangolin Pooler откажет в обслуживании. Значение по умолчанию 0 (выключено);auth_lost_size (integer)— параметр задает максимальное число кэшируемых записей о последних аутентификациях пользователей. Значение по умолчанию 10. Информацию о последних аутентификациях пользователей можно получить с помощью командыshow last(см. подробнее в подразделе «Команды вывода информации» текущего раздела);log_audit (integer)— включает/выключает аудит. Значение по умолчанию - 0 (выключено).

Примечание:

Увеличение значения

auth_failure_thresholdпотенциально увеличит количество обработок отказов в подключении и соответствующих записей в логах, при обычных условиях эксплуатации это не должно приводить к отказу Pangolin Pooler.Увеличение

auth_inactivity_periodпозволяет избежать увеличения обработок отказов в подключении на указанное время.Одной единицей подключения (клиентом) считается соединение с определенным набором (сочетанием) параметров: логин/пароль пользователя, имя БД для подключения, IP-адрес клиента, тип соединения. Клиент считается ранее пытавшимся подключиться, по этому же сочетанию, только без передачи пароля. Блокировка пользователя происходит по этим учетным данным подключения, то есть любое изменение данного сочетания будет считаться попыткой соединения нового пользователя.

Параметры подключений:

auth_port (integer)— номер порта, к которому нужно подключиться для выполнения аутентификации пользователей. Параметр раздела базы данных[databases];auth_pool_size (integer)— параметр задает максимальное количество соединений для выполнения аутентификации пользователей. Значение по умолчанию 1. Параметр раздела базы данных[databases].

Примечание:

Общее количество соединений не должно превышать значения

authentication_max_workers, раздел «Конфигурирование сквозной аутентификации в Pangolin».

Пример конфигурации (содержит параметры, связанные со сквозной аутентификацией):

[databases]

* = host=<IP-адрес> port=5433 auth_port=5434

[pgbouncer]

listen_addr = *

listen_port = 6544

; включена сквозная аутентификация

auth_proxy = on

; включен audit

log_audit = 1

; выставлено время выполнения аутентификации

client_login_timeout = 10

; выставлен порог, по превышению которого пользователь временно блокируется

auth_failure_threshold = 3

; выставлен период неактивности аутентификации

auth_inactivity_period = 30

; выставлен размер кешируемых записей о последних аутентификациях пользователей

auth_last_size = 20

; пользователи, прописанные в userlist, будут выполнять аутентификацию, используя данный метод

auth_type = scram-sha-256

; в файле userlist содержатся пользователи, выполняющие действия администратора или мониторинг

auth_file = ./userlist.txt

admin_users = pgbouncer

stats_users = stat

Внимание!

Сквозная аутентификация не работает для пользователей, которые указаны в секции

[users]конфигурационного файла Pangolin Pooler.

Раздел [users] содержит пары ключ=значение, где в качестве ключа принимается имя пользователя, а в качестве значения — переопределяемые для него параметры конфигурации (в формате строк подключения libpq):

pool_mode– задает режим пула для всех подключений данного пользователя;max_user_connections– задает максимум подключений для пользователя.

Пользователь, для которого переопределен один или оба параметра:

должен быть указан в параметре

stats_usersилиadmin_users;должен присутствовать в списке

userlist.txt(параметрauth_file) в виде"имя_пользователя" "хеш_пароля_пользователя".

Пример конфигурации (содержит параметры, связанные с использованием секции [users] файла /etc/pangolin-pooler/pangolin-pooler.ini):

[pgbouncer]

; в файле userlist содержатся пользователи, выполняющие действия администратора или мониторинг

auth_file = ./userlist.txt

admin_users = pgbouncer

stats_users = user1

[users]

; раздел содержит имя пользователя и переопределяемые для него параметры конфигурации

user1 = pool_mode=session max_user_connections=1

Пользователю user1 при таких настройках будут применены персональные параметры pool_mode и max_user_connections, а аутентификация в базе данных будет выполняться только после аутентификации его в Pangolin Pooler.

Конфигурирование сквозной аутентификации в Pangolin#

Настроить сквозную аутентификацию в Pangolin можно с помощью конфигурационных параметров, описанных в данном разделе.

Параметры аутентификации:

authentication_proxy (integer)— параметр включает/выключает режим сквозной аутентификации:0— режим сквозной аутентификации выключен, не позволяет выполнять аутентификацию пользователей конкретной БД в отдельном потоке (значение по умолчанию);1— режим сквозной аутентификации включен, позволяет выполнять аутентификацию пользователей конкретной БД в отдельном потоке;

authentication_max_workers (integer)- параметр определяет максимальное число одновременных подключений для выполнения аутентификации пользователей. Значение по умолчанию 16. При значении, равном 0, сквозная аутентификация выполняться не будет.Примечание:

Параметр

authentication_max_workersможно задать только при запуске сервера.auth_handshake_timeout (integer)— параметр определяет максимальное время, за которое должно произойти подтверждение аутентификации (в секундах). Значение по умолчанию 10 сек. Если потенциальный клиент не сможет выполнить подтверждение аутентификации (рукопожатие) за это время, сервер закроет соединение;auth_activity_period (integer)— параметр определяет период активности аутентификации (в секундах). Значение по умолчанию 60 сек. Это время, в течение которого ранее аутентифицированный клиент при подключении с идентичными параметрами (тип соединения, адрес клиента, база данных и имя пользователя), выполнит аутентификацию поtoken.Значение передается на Pangolin Pooler и используется для проведения более быстрой аутентификации. Возможные значения:

-1— не используется период активности аутентификации;0— период активности аутентификации не имеет ограничений по времени;> 0— имеет ограничение по времени.

Примечание:

не рекомендуется выставлять значение

auth_activity_period = 0, так как его нельзя сбросить в Pangolin Pooler без перезагрузки;выставляемого значения должно хватить, чтобы запустить пул соединений между Pangolin Pooler и Pangolin.

auth_idle_period (integer)- параметр определяет период простоя процесса сквозной аутентификации (в секундах). Значение по умолчанию 60 сек. Отсчет периода начинается после обработки последнего полученного пакета. После окончания периода будет проверено, нужно ли продолжать работу процесса сквозной аутентификации. Процесс будет прерван, если связанной с ним базы данных нет, или она была удалена или переименована.

Параметры подключений:

authentication_port (integer) — TCP-порт, открываемый сервером для выполнения аутентификации пользователей (по умолчанию порт — 5433).

Примечание:

Параметр

authentication_port (integer)можно задать только при запуске сервера.

Пример конфигурации (содержит параметры связанные со сквозной аутентификацией):

port = 5433

authentication_port = 5434

authentication_timeout 60 # sec

auth_activity_period = 60 # sec

Команды вывода информации#

Для получения информации о статусе или результатах работы механизма сквозной аутентификации были добавлены следующие команды:

SHOW AUTHSERVERS— показывает информацию о соединениях с сервером аутентификации.SHOW AUTHPOOLS— показывает информацию по пулам аутентификации.Примечание:

Новый пул аутентификации создается для каждой базы данных.

SHOW AUTHUSERS— показывает информацию о пользователях.SHOW LAST— показывает информацию об аутентификации последних N пользователей.Примечание:

auth_last_size— по умолчанию команда показывает 10 последних пользователей.При превышении этого значения первые записи удаляются, а новые добавляются в конец. Ошибка аутентификации указана в логах Pangolin или Pangolin Pooler. В каком логе и в какое время - зависит от значений параметров place и connect_time\auth_time.

SHOW LOCKED_USERS— показывает информацию о заблокированных пользователях.Команда показывает временно заблокированных пользователей. Это пользователи с идентичными параметрами: тип соединения, адрес клиента, база данных и имя пользователя, которые не смогли аутентифицироваться N раз подряд (N определяет конфигурационный параметр

auth_failure_threshold). Длительность блокировки пользователя определяется конфигурационным параметромauth_inactivity_period.

Подробное описание команд приведено в документе «Список PL/SQL функций продукта», раздел «Сквозная аутентификация».

В утилите psql имелся механизм запоминания ранее выполненных запросов. Этот механизм позволял просмотреть историю ранее выполненных команд и повторно вызвать ранее выполненные запросы.

История запросов хранилась в открытом виде в файле ~/.psql_history. При выполнении запросов, содержащих пароли это могло представлять угрозу безопасности, так как пароли хранились так же в незашифрованном виде.

В связи с новой функциональностью изменяется поведение утилиты psql по сравнению с имеющимся:

создание и чтение файла

~/.psql_historyне производится;влияние переменной окружения

PSQL_HISTORYна работу утилитыpsqlотсутствует;установка переменной

HISTFILEв утилитеpsqlне дает эффекта.

Реализованная функциональность не приводит к удалению или очищению ранее созданных файлов истории запросов. После обновления продукта рекомендуется (если необходимо) удалить ранее созданные файлы истории, выполнив команду:

rm -f ~/.psql_history

Двухфакторная аутентификация#

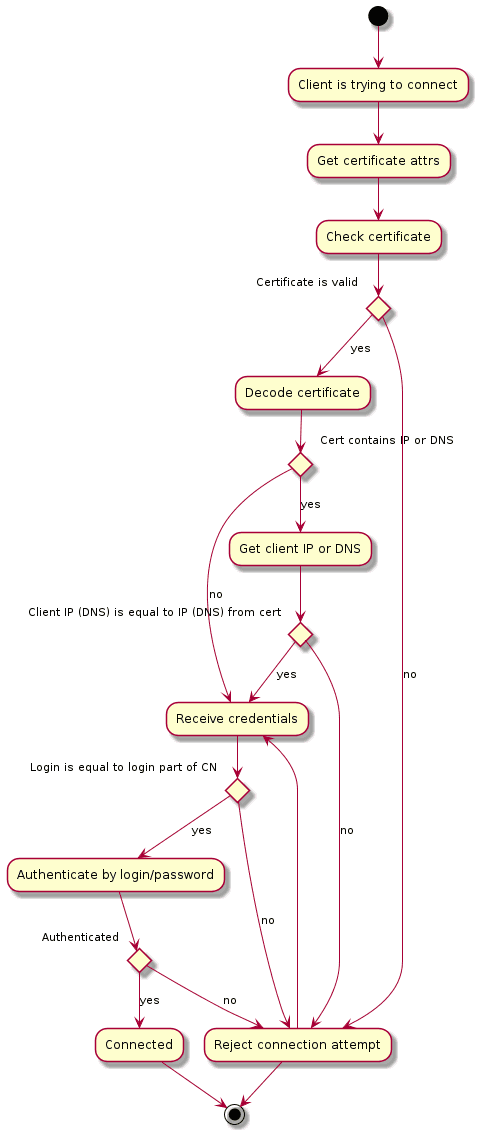

Двухфакторная аутентификация представляет собой технологию, обеспечивающую идентификацию пользователей при помощи запроса аутентификационных данных двух разных типов, что обеспечивает двухслойную, а значит, более эффективную защиту БД от несанкционированного проникновения.

Пользователь может подключаться к БД:

непосредственно (или напрямую) к Pangolin;

через Pangolin Pooler к Pangolin, используя сквозную аутентификацию;

через Pangolin Pooler к Pangolin, используя базовые механизмы аутентификации.

Сертификат безопасности клиента должен содержать поле CN, содержащее логин клиента и, опционально, поле SubjectAltName, содержащее один или несколько IP-адресов (возможен вариант указания подсети) и (или) DNS-имен клиента.

Для подключения непосредственно к Pangolin, в файле pg_hba.conf необходимо указать метод аутентификации: 2f-scram-sha-256, 2f-md5, 2f-password или 2f-ldap.

Для подключения через Pangolin Pooler к Pangolin, используя сквозную аутентификацию, необходимо:

в конфигурационных файлах Pangolin:

в файле

pg_hba.confнеобходимо указать метод аутентификации: 2f-scram-sha-256, 2f-md5, 2f-password или 2f-ldap;в файле

postgresql.confуказать:authentication_proxy = on;authentication_port = {AUTHPORT};

в конфигурационном файле Pangolin Pooler указать:

auth_port={AUTHPORT};auth_proxy = on;auth_type = scram-sha-256 или md5.

Для подключения через Pangolin Pooler к Pangolin, используя базовые механизмы аутентификации, необходимо в конфигурационном файле Pangolin Pooler указать:

в конфигурационных файлах Pangolin:

в файле

pg_hba.confнеобходимо указать метод аутентификации: 2f-scram-sha-256, 2f-md5, 2f-password или 2f-ldap;в файле

postgresql.confуказатьauthentication_proxy = off;

в конфигурационном файле Pangolin Pooler указать:

auth_proxy = off;auth_type = 2f-scram-sha-256 (2f-md5, 2f-plain);

Аутентификация LDAP не поддерживается Pangolin Pooler, поэтому 2f-ldap так же не поддерживается.

Внимание!

Необходимо учитывать, что разрешенными по умолчанию механизмами двухфаторной аутентификации являются 2f-scram-sha-256 и 2f-ldap.

При необходимости использования методов аутентификации 2f-md5 и 2f-password, нужно добавить эти методы в параметр

enabled_extra_auth_methodsв конфигурационном файлеpostgresql.conf.Например:

enabled_extra_auth_methods = '2f-md5,2f-password'

Настройка Pangolin для двухфакторной аутентификации#

Для выполнения двухфакторной аутентификации клиентов требуется:

в файле

postgresql.conf- включить SSL режим и прописать сертификаты:ssl = on ssl_ca_file = './root.crt' ssl_cert_file = './server.crt' ssl_key_file = './server.key'в файле pg_hba.conf указать:

тип сети - hostssl;

тип аутентификации: 2f-md5 или 2f-scram-sha-256;

# TYPE DATABASE USER ADDRESS METHOD hostssl test test1 127.0.0.1/32 2f-md5 hostssl test test1 hostname 2f-scarm-sha-256

Настройка Pangolin Pooler для двухфакторной аутентификации#

Для выполнения двухфакторной аутентификации клиентов требуется в файле конфигурации pangolin-pooler.ini (имя файла конфигурации может быть другим) указать:

параметры подключения SSL/TLS;

тип аутентификации: 2f-scram-sha-256 или 2f-md5;

Ниже приведен пример конфигурации, когда защищенное соединение выполняется между клиентом и Pangolin Pooler, а между Pangolin Pooler и Pangolin используется обычное соединение.

[pgbouncer]

auth_type = 2f-scram-sha-256

; TLS settings

client_tls_protocols = all

client_tls_sslmode = verify-full

client_tls_ca_file = ./root.crt

client_tls_cert_file = ./server.crt

client_tls_key_file = ./server.key

Настройка сквозной двухфакторной аутентификации#

Все специальные настройки были описаны ранее — необходимо только включить сквозную аутентификацию на Pangolin Pooler с Pangolin.

В файле pangolin-pooler.ini:

[pgbouncer]

auth_proxy = on

auth_type = scram-sha-256

client_tls_sslmode = verify-ca

client_tls_key_file = ./server.key

client_tls_cert_file = ./server.crt

client_tls_ca_file = ./root.crt

server_tls_sslmode = verify-full

server_tls_key_file = ./pgbouncer.key

server_tls_cert_file = ./pgbouncer.crt

server_tls_ca_file = ./root.crt

server_tls_ciphers = normal

[databases]

* = host=localhost port=5432 auth_port=5433 auth_port=5444 auth_pool_size=1

В файле postgresql.conf:

port = 5432

authentication_port = 5433

authentication_timeout = 60 # sec

auth_activity_period = 10 # sec

ssl = on

ssl_key_file = ./server.key

ssl_cert_file = ./server.crt

ssl_ca_file = ./root.crt

Управление протоколом LDAPS#

В Pangolin реализована возможность настроить шифрование запросов от сервера Postgres к AD (Active Directory). Для этого нужно настроить протокол LDAPS, использующий LDAP поверх SSL с использованием шифрования TLS. Далее приведены шаги для включения TLS соединения с LDAP.

Набор имеющихся корневых AD сертификатов скопируйте на сервер, где будет производиться установка (в случае кластера - и на мастер, и на реплику). Примером директории может быть:

etc/pki/ca-trust/source/anchors.Выполните команду

sudo update-ca-trustдля обновления списка доверенных сертификатов.В файле конфигурации

etc/openldap/ldap.confукажите путь к сертификатам в параметреTLS_CACERTDIR. Также добавьте набор шифров, используемых сервером AD:TLS_CIPHER_SUITE TLSv1.2:!NULL.Отредактируйте раздел

hba_rulesконфигурационного файла инсталлятораcustom_file_template.yml. В нем пропишите параметры подключения к серверу:ldapserver="{{ ldap_server }}" ldapport=3268 ldapbasedn="" ldapprefix="cn=" ldapsuffix=" OU=NPA OU=PAM OU=ALL DC=MustBeFilled dc=ru ldap_tls=1Запустите установку/обновление Pangolin. Ниже приведен пример строки

pg_hba.confпри включенномldaptls:host all +all-sa-pam-group 0.0.0.0/0 ldap ldaptls=1 ldapserver=X.XX.ru ldapport=389 ldapprefix="cn=" ldapsuffix=", OU=NPA, OU=PAM, OU=ALL, OU=XX, DC=X, dc=ru

Генерация сертификатов#

Для включения SSL между компонентами кластера необходимо подготовить сертификаты.

Подготовка сертификатов не выполняется инсталлятором Pangolin. Ожидается, что на хосте уже есть сертификаты, которые будут переданы на вход инсталлятору. Инсталлятор сам разместит их в нужных директориях и выдаст права для служебных пользователей (например, etcd).

Серверный сертификат (необходимо создать для каждого хоста в кластере):

Сгенерируйте ключ:

openssl genrsa -out server.key 2048Создайте файл конфигурации для создания запроса на подпись сертификата

vim server.conf:[req] req_extensions = v3_req distinguished_name = req_distinguished_name [req_distinguished_name] [ v3_req ] basicConstraints = CA:FALSE keyUsage = nonRepudiation, digitalSignature, keyEncipherment subjectAltName = @alt_names [ ssl_client ] extendedKeyUsage = clientAuth, serverAuth basicConstraints = CA:FALSE subjectKeyIdentifier=hash authorityKeyIdentifier=keyid,issuer subjectAltName = @alt_names [ v3_ca ] basicConstraints = CA:TRUE keyUsage = nonRepudiation, digitalSignature, keyEncipherment subjectAltName = @alt_names authorityKeyIdentifier=keyid:always,issuer [alt_names] DNS.1 = <host> ## hostname with domain IP.1 = <IP-адрес> ## host ip addressЭкспортируйте файл конфигурации:

CONFIG=`echo $PWD/server.conf`Создайте запрос на подпись сертификата. В

CNнеобходимо указать полныйhostname:openssl req -new -key server.key -out server.csr -subj "/CN=<host>" -config ${CONFIG}

Клиентский сертификат:

Сгенерируйте ключ:

openssl genrsa -out postgres.key 2048Создайте файл конфигурации для создания запроса на подпись сертификата

vim client.conf:[req] req_extensions = v3_req distinguished_name = req_distinguished_name [req_distinguished_name] [ v3_req ] basicConstraints = CA:FALSE keyUsage = nonRepudiation, digitalSignature, keyEncipherment [ ssl_client ] extendedKeyUsage = clientAuth basicConstraints = CA:FALSE subjectKeyIdentifier=hash authorityKeyIdentifier=keyid,issuer [ v3_ca ] basicConstraints = CA:TRUE keyUsage = nonRepudiation, digitalSignature, keyEncipherment authorityKeyIdentifier=keyid:always,issuerЭкспортируйте файл конфигурации:

CONFIG=`echo $PWD/client.conf`Создайте запрос на подпись сертификата. В

CNнеобходимо указать имя клиента/компонента (postgres, patroni, patronietcd, pgbouncer):openssl req -new -key postgres.key -out postgres.csr -subj "/CN=postgres" -config ${CONFIG}

Примечание:

При создании клиентских сертификатов, в поле

subjectAltNameможно указать IP-адрес или(и) DNS-имя машины (список машин), на которой(ых) будет использоваться сертификат. Также в этом поле можно указать адрес подсети.

Сгенерированные запросы на подпись сертификатов (файлы в формате *.csr) необходимо подписать удостоверяющем центре.

Полученные сертификаты необходимо перевести в формат PEM (например, командой openssl x509 -inform DER -outform PEM -in ./certificate.cer -out ./certificate.crt), расположить в одинаковых директориях на каждом хосте и выдать права - 600 для ключей и 644 для сертификатов, владелец — УЗ ОС postgres.

Наименование сертификатов, с которыми будет работать инсталлятор:

Назначение |

Наименование сертификата |

Наименование ключа |

|---|---|---|

Сертификат сервера |

server.crt |

server.key |

Сертификат пользователя postgres |

postgres.crt |

postgres.key |

Сертификат пользователя Pangolin Pooler |

pgbouncer.crt |

pgbouncer.key |

Сертификат пользователя patronietcd |

patronietcd.crt |

patronietcd.key |

Сертификат пользователя patroni |

patroni.crt |

patroni.key |

Поскольку в Pangolin можно указать только один корневой сертификат, а в нашем случае их два (один — УЦ непосредственно выпустивший сертификат, второй — УЦ выпустивший сертификат для УЦ и имеющий признак CA), необходимо объединить сертификаты корневого и промежуточного УЦ в один:

cat root.crt intermediate.crt > rootCA.crt

Все корневые сертификаты необходимо скопировать в папку /etc/pki/ca-trust/source/anchors и выполнить команду обновления хранилища доверенных корневых сертификатов:

sudo update-ca-trust

Настройка компонентов#

Внимание!

В процессе работы инструмента развертывания производится валидация сертификатов на их соответствие требованиям указанным в разделе «Подготовка». После работы инструмента развертывания валидация сертификатов находится на стороне владельца стенда.

Произведите настройку компонентов на использование сертификатов (задача инструмента развертывания):

В файле

postgres.conf(для стендов в конфигурации standalone-postgresql-pgbouncer). В данном случае необходимо указать путь к подписанным сертификатам для сервера БД:ssl = 'on' ssl_cert_file = '/home/postgres/ca/server.crt' ssl_key_file = '/home/postgres/ca/server.key' ssl_ca_file = '/home/postgres/ca/rootCA.crt' ssl_crl_file = 'путь к файлу со списком отозванных сертификатов'В

pangolin-pooler.iniдобавьте секцию TLS-настроек. Между Pangolin Pooler и Pangolin настраивается обязательное SSL-соединение, между Pangolin Pooler и клиентом — по требованию клиента. В обоих случаях минимальная версия TLS 1.2 и соответствующие ему шифры (Cipher suites (TLS 1.2): ECDHE-ECDSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-ECDSA-AES256-GCM-SHA384:ECDHE-RSA-AES256-GCM-SHA384:ECDHE-ECDSA-CHACHA20-POLY1305:ECDHE-RSA-CHACHA20-POLY1305:DHE-RSA-AES128-GCM-SHA256:DHE-RSA-AES256-GCM-SHA384).# TLS settings server_tls_protocols = secure server_tls_ciphers = secure server_tls_sslmode = verify-full server_tls_ca_file = /home/postgres/ca/rootCA.crt server_tls_cert_file = /home/postgres/ca/pgbouncer.crt server_tls_key_file = /home/postgres/ca/pgbouncer.key client_tls_protocols = secure client_tls_ciphers = secure client_tls_sslmode = prefer client_tls_ca_file = /home/postgres/ca/rootCA.crt client_tls_cert_file = /home/postgres/ca/server.crt client_tls_key_file = /home/postgres/ca/server.keyВ

etcd.confзначенияhttpпереведите вhttpsи добавьте секцию настроекTLS. Аутентификация в БД etcd происходит по паролю, так же необходимо указать сертификат пользователя.ETCD_NAME="<hostname>" ETCD_LISTEN_CLIENT_URLS="https://<IP-адрес>:2379" ETCD_ADVERTISE_CLIENT_URLS="<hostname>:<порт>" ETCD_LISTEN_PEER_URLS="https://<IP-адрес>:2380" ETCD_INITIAL_ADVERTISE_PEER_URLS="<hostname>:<порт>" ETCD_INITIAL_CLUSTER_TOKEN="test" ETCD_INITIAL_CLUSTER="<hostname>:<порт>,<hostname>:<порт>,<hostname>:<порт>" ETCD_INITIAL_CLUSTER_STATE="new" ETCD_DATA_DIR="/var/lib/etcd" ETCD_ELECTION_TIMEOUT="5000" ETCD_HEARTBEAT_INTERVAL="1000" ETCD_ENABLE_V2="false" # TLS settings ETCD_CIPHER_SUITES="TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256,TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384" ETCD_TRUSTED_CA_FILE="/home/postgres/ca/rootCA.crt" ETCD_CERT_FILE="/home/postgres/ca/server.crt" ETCD_KEY_FILE="/home/postgres/ca/server.key" ETCD_PEER_TRUSTED_CA_FILE="/home/postgres/ca/rootCA.crt" ETCD_PEER_CERT_FILE="/home/postgres/ca/server.crt" ETCD_PEER_KEY_FILE="/home/postgres/ca/server.key" ETCD_PEER_CLIENT_CERT_AUTH="true" ETCD_PEER_CRL_FILE="путь к файлу со списком отозванных сертификатов"В файле конфигурации pangolin-manager

postgres.ymlвнесите изменения в секцииrestapi, etcd3, postgres, pg_hba.restapiдобавить параметрыverify_client, cafile, certfile, keyfile- пути до сертификатов. Параметрverify_client: optional- означает, что все запросы «управления»PUT, POST, PATCH, DELETEтребуют аутентификации по сертификатам. Параметрыallowlist: [] allowlist_include_members: true- означают, что доступ к запросам «управления» есть только у членов кластера и хостов, которые перечислены вallowlist. ЗапросыGET(только получение сведений о кластере) будут возвращаться без аутентификации.restapi: listen: <IP-адрес>:8008 connect_address: <hostname>:<порт> allowlist: [] allowlist_include_members: true verify_client: optional cafile: /home/postgres/ca/rootCA.crt certfile: /home/postgres/ca/server.crt keyfile: /home/postgres/ca/server.key authentication: username: patroniyml password: <пароль>В секции

etcdдобавьте параметрыprotocol, cacert, cert, key. Соединение с etcd будет осуществляться по протоколу HTTPS.etcd: hosts: <hostname>:<порт>,<hostname>:<порт>,<hostname>:<порт> protocol: https cacert: /home/postgres/ca/rootCA.crt cert: /home/postgres/ca/patronietcd.crt key: /home/postgres/ca/patronietcd.key username: patronietcd password: <пароль>

В секции postgres в подразделе аутентификации пользователя patroni добавьте параметры

sslmode, sslkey, sslcert, sslrootcertи в разделеparametersукажите путь к серверному сертификату.sslmodeустанавливается в значениеverify-caиз-за особенностей локального подключения.postgresql: listen: <IP-адрес>:5433 bin_dir: /usr/pgsql-se-05/bin connect_address: <hostname>:<порт> data_dir: /pgdata/05/data/ create_replica_methods: - basebackup basebackup: format: plain wal-method: fetch authentication: replication: username: patroni database: replication sslmode: verify-ca sslkey: /home/postgres/ca/patroni.key sslcert: /home/postgres/ca/patroni.crt sslrootcert: /home/postgres/ca/rootCA.crt sslcrl: "путь к файлу со списком отозванных сертификатов" superuser: username: patroni sslmode: verify-ca sslkey: /home/postgres/ca/patroni.key sslcert: /home/postgres/ca/patroni.crt sslrootcert: /home/postgres/ca/rootCA.crt sslcrl: "путь к файлу со списком отозванных сертификатов" ssl: 'on' ssl_cert_file: /home/postgres/ca/server.crt ssl_key_file: /home/postgres/ca/server.key ssl_ca_file: /home/postgres/ca/rootCA.crt ssl_crl_file: "путь к файлу со списком отозванных сертификатов"В секции pg_hba смените метод подключения для УЗ patroni с host на hostssl:

hostssl all patroni <IP-адрес>/32 scram-sha-256 hostssl all patroni <IP-адрес>/32 scram-sha-256 hostssl replication patroni <IP-адрес>/32 scram-sha-256 hostssl replication patroni <IP-адрес>/32 scram-sha-256Если какой-либо сертификат был просрочен или отозван, необходимо выпустить новый, согласно инструкции описанной в разделе «Генерация сертификатов», и, в случае изменения наименования сертификата, произвести настройку компонента, где данный сертификат был задействован. В случае сохранения имени сертификата, необходимо перезапустить сервисы компонентов после замены файлов сертификатов.

Использование сертификатов PKCS#12 в кластере Pangolin#

В версиях Pangolin до 5.3.0 сертификаты и закрытые ключи, используемые для установки TLS/SSL соединений, хранились в кластере Pangolin в формате, не предусматривающем предъявление секрета для доступа к сертификату и/или закрытому ключу. В версии Pangolin 5.3.0 в целях повышения уровня информационной безопасности вводится авторизация для использования сертификатов и закрытых ключей на промышленных стендах.

Сертификаты и закрытые ключи, используемые в версии Pangolin 5.2.1, приведены в таблице ниже и используются для установления TLS-соединения между компонентами кластера Pangolin:

Клиентские сертификат и ключ Pangolin Pooler для подключения к серверу СУБД Pangolin |

Назначение сертификатов и закрытых ключей |

|---|---|

server.crt / server.key |

Серверный сертификат СУБД Pangolin для установления клиентских подключений |

pgbouncer.crt / pgbouncer.key |

Клиентский сертификат Pangolin Pooler для подключения к серверу СУБД Pangolin |

patroni.crt / patroni.key |

Клиентский сертификат Pangolin Manager для подключения к серверу СУБД Pangolin |

patronietcd.crt / patronietcd.key |

Клиентский сертификат Pangolin Manager для подключения к серверу etcd |

client.crt / client.key |

Клиентский сертификат пользователя postgres |

root.crt |

Корневой сертификат УЦ |

С версии Pangolin 5.3.0 данные сертификаты и закрытые ключи, за исключением root.crt и patronietcd.crt/patronietcd.key, хранятся в файловой системе в зашифрованных контейнерах PKCS#12, а парольные фразы для их расшифровки - в зашифрованном виде. Ключ для зашифровывания/расшифровывания парольных фраз генерируется на основе параметров сервера, поэтому файлы с парольными фразами не переносимы между узлами кластера Pangolin.

Примечание:

Следующая ключевая информация хранится в файловой системе в PEM-формате:

Сертификаты и закрытые ключи etcd (

etcd.crt/etcd.key,patronietcd.crt/patronietcd.key), так как этот компонент не поддерживается командой разработки Pangolin.Корневой сертификат, которым подписаны сертификаты etcd (может не совпадать с сертификатом, подписавшим сертификаты компонентов Pangolin, Pangolin Pooler и Pangolin Manager.).

Корневой сертификат

root.crt, которым подписаны сертификаты компонентов Pangolin, Pangolin Pooler и Pangolin Manager…

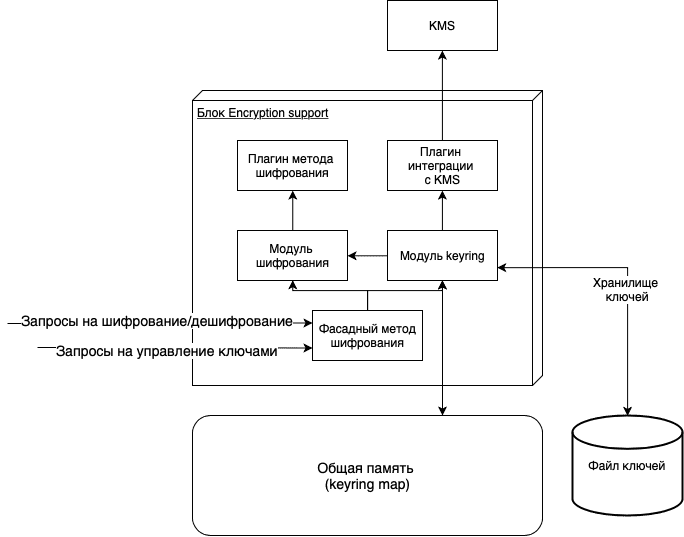

Для компонентов кластера введены настроечные параметры для установки пути до конфигурационного файла, включающего путь к контейнеру PKCS#12 и парольную фразу в зашифрованном виде:

в конфигурационном файле pangolin-manager

postgresql.ymlпараметрpkcs12_config_pathв секциях:restapi:pkcs12_config_path: example.p12.cfg;

postgresql:authentication:replication/superuser/rewind:pkcs12_config_path: example.p12.cfg;

postgresql:parameters:serverssl.pkcs12_config_path: example.p12.cfg;

в конфигурационном файле СУБД Pangolin

postgresql.confпараметрserverssl.pkcs12_config_path;в конфигурационном файле Pangolin Pooler

pangolin-pooler.iniпараметрыclient_tls_pkcs12_config_pathиserver_tls_pkcs12_config_path;в строке подключения

psql:pkcs12_config_path(переменная окруженияPKCS12_CONFIG_PATH);pkcs12_passphrase(переменная окруженияPKCS12_PASSPHRASE) - используется для предоставления парольной фразы без ручного ввода в случае, если в файле.p12.cfgотсутствует поле passphrase. Парольная фраза может быть как в открытом, так и в зашифрованном виде. Парольная фраза зашифровывается утилитойpg_auth_password.

Формат конфигурационного файла .p12.cfg:

{

"pkcs12": "", // Путь к контейнеру PKCS#12

"passphrase": "" // Парольная фраза, зашифрованная ключом на параметрах сервера, либо в открытом виде

}

Для валидации сертификатов компонентов, выполняющих подключение, по умолчанию используется полная цепочка сертификатов в контейнере PKCS#12, если в конфигурационных файлах не прописаны прежние параметры для установки цепочки доверенных сертификатов:

в конфигурационном файле Pangolin Manager

postgresql.ymlв секциях:restapi:cafile: /path/to/CAfile.pem;capath: /path/to/CAdir(параметр введен в версии 5.3.0);

postgresql:authentication:replication/superuser/rewind:sslrootcert: /path/to/CAfile.pem;sslrootpath: /path/to/CAdir(параметр введен в версии 5.3.0);

postgresql:parameters:ssl_ca_file: /path/to/CAfile.pem;ssl_ca_path: /path/to/CAdir(параметр введен в версии 5.3.0);

в конфигурационном файле СУБД Pangolin

postgresql.conf:ssl_ca_file = '/path/to/CAfile.pem';ssl_ca_path = '/path/to/CAdir'(параметр введен в версии 5.3.0);

в конфигурационном файле Pangolin Pooler

pangolin-pooler.ini:client_tls_ca_file = /path/to/CAfile.pem;server_tls_ca_file = /path/to/CAfile.pem;client_tls_ca_path = /path/to/CAdir(параметр введен в версии 5.3.0);server_tls_ca_path = /path/to/CAdir(параметр введен в версии 5.3.0);

в строке подключения

psql:sslrootcert = /path/to/CAfile.pem(переменная окруженияPGSSLROOTCERT);sslrootpath = /path/to/CAdir(переменная окруженияPGSSLROOTPATH(параметр введен в версии 5.3.0)).

Если один из этих параметров указан, то он будет использоваться для инициализации цепочки доверенных сертификатов для проверки сертификатов: со стороны сервера - клиентского сертификата, со стороны клиента - серверного сертификата. В дополнение к приведенным вариантам поиска доверенных сертификатов добавлен поиск среди доверенных сертификатов операционной системы. Настроечный параметр для этого не требуется.

Примечание:

Клиентские компоненты кластера (

psql) используют полную цепочку сертификатов в контейнере PKCS#12 для валидации сертификатов, если в строке подключения параметрsslmodeустановлен вverify-caилиverify-full.

Порядок поиска доверенных сертификатов:

если не используются параметры, указывающие на файл, либо директорию с сертификатами: сначала в полной цепочке сертификатов из контейнера PKCS#12, затем в в директории ОС, указанной по умолчанию;

если используются параметры, указывающие на файл и/или директорию с сертификатами: сначала в файле, содержащем один или несколько доверенных сертификатов, затем в директории, если установлена, и, если в них не удалось найти нужный сертификат, то - в директории ОС, указанной по умолчанию.

Возможность конфигурирования сертификатов через PEM-файлы сохранена.

Реализация интерфейса получения контейнера PKCS#12 и парольной фразы к нему выполнена в виде плагинов (подключаемых модулей). В директории установки Pangolin созданы символические ссылки на плагины:

/usr/pangolin-5.3.0/lib/libpkcs12_exporter_plugin_link.so -> plugins/libpkcs12_exporter_plugin.so

/usr/pangolin-5.3.0/lib/libpkcs12_passphrase_plugin_link.so -> plugins/libpkcs12_passphrase_plugin.so

Для контроля сроков действия сертификатов и проверки подписи локальным корневым сертификатом в контейнерах PKCS#12 предоставляется утилита pkcs12_cert_info. По умолчанию поиск корневого сертификата также ведется в системных директориях по умолчанию. Утилита принимает на вход аргументы: путь к конфигурационному файлу со стратегией получения контейнера PCKS#12 и парольной фразы --pkcs12_config_path (-p), параметр включения проверки подписи --verify (-v), опционально путь к корневому сертификату --CAfile (-f), опционально путь к директории с корневым сертификатом --CApath (-d), опциональный параметр отключения поиска в директориях по умолчанию --no-CApath (-n).

Справка по использованию утилиты:

$ pkcs12_cert_info -h

Usage:

pkcs12_cert_info <option>...

Options:

--help [-h] This help

--pkcs12_config_path [-p] Path to config file with info how to get PKCS#12 file

--verify [-v] Check that PKCS#12 certificate trusted by anchor

--CAfile [-f] Path to root/intermediate certificate file

--CApath [-d] Path to root/intermediate certificate directory

--no-CApath [-n] Do not use the default directory of trusted certificates.

Pangolin product version information:

--product_version prints product name and version

--product_build_info prints product build number, date and hash

--product_component_hash prints component hash string

Вывод утилиты включает статус наличия закрытого ключа в контейнере, сроки действия сертификата и атрибуты, идентифицирующие сертификат (имя издателя и общее имя сертификата), а также сроки действия цепочки доверенных сертификатов. При введенном параметре проверки подписи выводится результат проверки, а также путь до использованного корневого сертификата.

Пример запуска утилиты:

$ pkcs12_cert_info -p /pg_ssl/server.p12.cfg

Certificate:

Issuer: CN=Pangolin_intermediate_CA

Validity

Not Before: Nov 8 10:52:13 2022 GMT

Not After : Nov 5 10:52:13 2032 GMT

Subject: CN=srv-0-154

Private key exists

Certificate chain:

Certificate #1:

Issuer: CN=Pangolin_CA

Validity

Not Before: Nov 8 10:52:13 2022 GMT

Not After : Nov 5 10:52:13 2032 GMT

Subject: CN=Pangolin_intermediate_CA

Certificate #2:

Issuer: CN=Pangolin_CA

Validity

Not Before: Nov 8 10:52:12 2022 GMT

Not After : Nov 5 10:52:12 2032 GMT

Subject: CN=Pangolin_CA

Использование сертификатов в локально хранящихся контейнерах PKCS#12 настраивается путем установки следующих параметров в конфигурационных файлах компонентов кластера:

в конфигурационном файле Pangolin Manager

postgresql.ymlпараметрpkcs12_config_pathв секциях:restapi;pkcs12_config_path: example.p12.cfg;

postgresql:authentication:replication/superuser/rewind;pkcs12_config_path: example.p12.cfg;

postgresql:parameters;serverssl.pkcs12_config_path: example.p12.cfg;

в конфигурационном файле СУБД Pangolin

postgresql.confпараметрserverssl.pkcs12_config_path;в конфигурационном файле Pangolin Pooler

pangolin-pooler.iniпараметрыclient_tls_pkcs12_config_pathиserver_tls_pkcs12_config_path.

Изменение данных параметров не требует перезапуска компонентов кластера, достаточно выполнить перечитывание конфигурационных файлов.

Если для подключения к СУБД Pangolin требуется предоставить сертификат, и кластер настроен с использованием контейнеров PKCS#12, хранящихся в файловой системе, то в строке подключения psql необходимо указать параметр pkcs12_config_path с путем до конфигурационного файла .p12.cfg, содержащего путь к контейнеру PKCS#12 и парольную фразу в зашифрованном виде.

Примеры запуска утилиты psql:

# В файле /pg_ssl/client.p12.cfg установлена парольная фраза.

$ psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full pkcs12_config_path=/pg_ssl/client.p12.cfg"

# В файле /pg_ssl/client.p12.cfg установлена парольная фраза. Путь к /pg_ssl/client.p12.cfg указан через переменную окружения.

$ PKCS12_CONFIG_PATH=/pg_ssl/client.p12.cfg psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full"

# В файле /pg_ssl/client.p12.cfg парольная фраза не установлена. Парольная фраза передается в строке подключения в зашифрованном виде.

$ psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full pkcs12_config_path=/pg_ssl/client.p12.cfg pkcs12_passphrase=$enc$+tsiUlhEuNw4ASyvN6ta0A==$sys$mKb2BejR/MLUBzZQ2PaFs+zXGHDRljMWqX46w0CMmDWtjPDzwbxwNSfDAmVTT3Wu"

# В файле /pg_ssl/client.p12.cfg парольная фраза не установлена. Парольная фраза передается через переменную окружения в зашифрованном виде.

$ PKCS12_PASSPHRASE='$enc$+tsiUlhEuNw4ASyvN6ta0A==$sys$mKb2BejR/MLUBzZQ2PaFs+zXGHDRljMWqX46w0CMmDWtjPDzwbxwNSfDAmVTT3Wu' psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full pkcs12_config_path=/pg_ssl/client.p12.cfg"

# В файле /pg_ssl/client.p12.cfg парольная фраза не установлена. Требуется ручной ввод парольной фразы.

$ psql "host=$(hostname -f) port=5433 dbname=postgres user=postgres sslmode=verify-full pkcs12_config_path=/pg_ssl/client.p12.cfg"

Enter passphrase for PKCS#12 file:

***

Внимание!

В режиме защищенного конфигурирования (

secure_config = on) управление параметром СУБД Pangolinserverssl.pkcs12_config_pathвыполняется на стороне хранилища секретов.

Если для валидации сертификатов не подходит полная цепочка сертификатов в контейнере PKCS#12, предоставляется возможность использования существующих параметров для установки путей к файлам с полными цепочками доверенных сертификатов или введенных в текущей работе новых параметров для установки директории с доверенными сертификатами:

в конфигурационном файле Pangolin Manager.

postgresql.ymlв секциях:restapi;cafile: /path/to/CAfile.pem;capath: /path/to/CAdir;

postgresql:authentication:replication/superuser/rewind;sslrootcert: /path/to/CAfile.pem;sslrootpath: /path/to/CAdir;

postgresql:parameters;ssl_ca_file: /path/to/CAfile.pem;ssl_ca_path: /path/to/CAdir;

в конфигурационном файле СУБД Pangolin

postgresql.conf:ssl_ca_file = '/path/to/CAfile.pem';ssl_ca_path = '/path/to/CAdir';

в конфигурационном файле Pangolin Pooler

pangolin-pooler.ini:client_tls_ca_file = /path/to/CAfile.pem;server_tls_ca_file = /path/to/CAfile.pem;client_tls_ca_path = /path/to/CAdir;server_tls_ca_path = /path/to/CAdir;

в строке подключения

psql:sslrootcert = /path/to/CAfile.pem(переменная окруженияPGSSLROOTCERT);sslrootpath = /path/to/CAdir(переменная окруженияPGSSLROOTPATH).

Поиск доверенных сертификатов также выполняется среди доверенных сертификатов операционной системы. Настроечный параметр для этого не требуется.

Пример подготовки директории с доверенными сертификатами:

# Добавление корневого сертификата в директорию с доверенными сертификатами

cp /path/to/panglolin.crt /pg_ssl/root_dir

c_rehash /pg_ssl/root_dir

Пример управления доверенными сертификатами операционной системы CentOS 7.9:

# Добавление корневого сертификата с именем Pangolin_CA в хранилище доверенных сертификатов ОС

sudo cp /path/to/panglolin.crt /etc/pki/ca-trust/source/anchors/

sudo update-ca-trust extract

trust list|grep Pangolin_CA

# Удаление корневого сертификата с именем Pangolin_CA из хранилища доверенных сертификатов ОС

sudo rm /etc/pki/ca-trust/source/anchors/panglolin.crt

sudo update-ca-trust extract

trust list|grep Pangolin_CA

Для контроля сроков действия сертификатов в контейнерах PKCS#12 предоставляется утилита pkcs12_cert_info. Утилита принимает на вход один аргумент: путь к конфигурационному файлу со стратегией получения контейнера PCKS#12 и парольной фразы. Вывод утилиты включает статус наличия закрытого ключа в контейнере, сроки действия сертификата и атрибуты, идентифицирующие сертификат (имя издателя и общее имя сертификата), а также сроки действия полной цепочки сертификатов.

В пользовательском конфигурационном файле инсталлятора введены следующие параметры:

Контейнер PKCS#12, помимо сертификата и закрытого ключа, может содержать полную цепочку сертификатов, включая корневой, которыми подписан сертификат. Для упрощения настройки доверенных SSL/TLS сертификатов в кластере предоставляется возможность использовать цепочку сертификатов из контейнера в качестве доверенных, установив параметр pkcs12_use_ca_chain_from_container в true.

# Флаг определяет, использовать ли полную цепочку сертификатов в контейнере PKCS#12 в качестве доверенной. # Если флаг true, то использовать полную цепочку доверенных сертификатов в контейнере, если есть, в качестве доверенной, иначе - false. pkcs12_use_ca_chain_from_container: trueЕсли вариант с использованием полной цепочки сертификатов из контейнера PKCS#12 не подходит для настройки доверенных SSL/TLS сертификатов, предоставляется возможность установки доверенных сертификатов через следующие параметры:

pg_certs_pwd: root_ca_file: "{{ '' | default('/pg_ssl/root.crt', true) }}" # Использовать PEM файл, который может содержать один или несколько доверенных сертификатов root_ca_path: "{{ '' | default('/pg_ssl/root_dir', true) }}" # Использовать подготовленную директорию с доверенными сертификатамиПараметры для поддержки использования сертификатов и закрытых ключей из контейнеров PKCS#12, расположенных в файловой системе:

# Активация получения контейнера PKCS#12 и парольной фразы к нему из файловой системы. # Если флаг true, то устанавливаются плагины libpkcs12_passphrase_plugin.so и libpkcs12_exporter_plugin.so. # Если флаг false, то используется прежний подход для получения ключевой информации: из файлов в PEM формате. Плагин не устанавливается. pkcs12_plugin_enable: true pg_certs_pwd: # Установка параметра p12_path обязательна при активации флага pkcs12_plugin_enable. server_p12: p12_path: "{{ '' | default('/home/postgres/ssl/server.p12', true) }}" # Путь в файловой системе к контейнеру PKCS#12 с серверной ключевой парой и цепочкой доверенных сертификатов. p12_pass: "{{ '' | default('', true) }}" # Парольная фраза для доступа к контейнеру PKCS#12 (server.p12), зашифрованная средствами Ansible Vault (в ходе установки парольная фраза расшифровывается и сохраняется в файл по пути p12_config_path (см. ниже) в зашифрованном виде на ключе, сгенерированном на параметрах сервера). Параметр обязателен в случае установки параметра p12_path. p12_config_path: "{{ '' | default('/home/postgres/ssl/server.p12.cfg', true) }}" # Путь к файлу в JSON-формате, содержащему параметр ("passphrase") для получения парольной фразы для доступа к контейнеру PKCS#12, зашифрованную на ключе, сгенерированном на параметрах сервера, и параметр ("pkcs12") для получения контейнера PKCS#12. Параметр обязателен при установке флага pkcs12_plugin_enable в true. postgres_p12: p12_path: "{{ '' | default('/home/postgres/ssl/client.p12', true) }}" # Путь в файловой системе к контейнеру PKCS#12 с клиентской ключевой парой пользователя postgres и цепочкой доверенных сертификатов p12_pass: "{{ '' | default('', true) }}" p12_config_path: "{{ '' | default('/home/postgres/ssl/client.p12.cfg', true) }}" pgbouncer_p12: p12_secman_integration: true p12_path: "{{ '' | default('/home/postgres/ssl/pgbouncer.p12', true) }}" # Путь в файловой системе к контейнеру PKCS#12 с клиентской ключевой парой Pangolin Pooler и цепочкой доверенных сертификатов для подключения к СУБД Pangolin p12_pass: "{{ '' | default('', true) }}" p12_config_path: "{{ '' | default('/home/postgres/ssl/pgbouncer.p12.cfg', true) }}" patroni_p12: p12_path: "{{ '' | default('/home/postgres/ssl/patroni.p12', true) }}" # Путь в файловой системе к контейнеру PKCS#12 с клиентской ключевой парой и цепочкой доверенных сертификатов для подключения Pangolin Manager к СУБД Pangolin p12_pass: "{{ '' | default('', true) }}" p12_config_path: "{{ '' | default('/home/postgres/ssl/patroni.p12.cfg', true) }}" etcd_cert: "{{ '' | default('/home/postgres/ssl/etcd.crt', true) }}" # Путь к сертификату для взаимодействия экземпляров ETCD. Может быть подписан сертификатом, отличным от сертификата, подписавшего сертификаты компонентов Pangolin, Pangolin Pooler, Pangolin Manager. Тогда потребуется указать путь к корневому сертификату в параметре etcd_root_ca. etcd_key: "{{ '' | default('/home/postgres/ssl/etcd.key', true) }}" # Путь к приватному ключу для взаимодействия экземпляров ETCD etcd_root_ca: "{{ '' | default('/home/postgres/ssl/root_etcd.crt', true) }}" # Корневой сертификат для проверки действительности сертификатов ETCDПримечания к ключам словаря