Руководство по установке#

В руководстве приведены инструкции по установке компонента Synapse Rate Limiter (SRLS) продукта Synapse Enterprise Integration (SEI).

Термины и определения#

Термин/Аббревиатура |

Определение |

|---|---|

API |

Application Programming Interface |

CPU |

Central Processing Unit, центральный процессор |

Endpoint |

Сетевая точка, обеспечивающая взаимодействие с поставщиком |

gRPC |

Современная высокопроизводительная платформа, которая используется для развития устаревшего протокола удаленного вызова процедур (RPC) |

Ingress Gateway |

Ресурс Istio, который описывает правила маршрутизации и балансировки входящих запросов. Альтернатива K8s Ingress, настраивается через ресурсы Gateway, Virtual Service и при необходимости DestinationRule |

K8s |

Kubernetes, платформа с открытым исходным кодом для управления кластерами приложений и сервисами на основе контейнеров |

OpenSSL |

Криптографическая библиотека с открытым исходным кодом и инструментарий SSL |

OS |

OpenShift, открытая и расширяемая платформа приложений-контейнеров |

RL Operator |

Компонент SRLS, обеспечивающий конфигурирование Ingress Gateway в соответствии с CRD в runtime |

RL Service |

Компонент SRLS, сервис расчета лимитов, принимает gRPC-запросы от Ingress Gateway в прикладных namespace, содержащих информацию о домене (в качестве домена используется название namespace), о вызываемом сервисе и данные из заголовка synapse-consumerid |

Runtime |

Время выполнения |

SRLS (SRL) |

Программный компонент Synapse Rate Limiter Service (Synapse Rate Limit), сервис ограничения (квотирования) входящих запросов, необходим для ограничения прикладной нагрузки (payload) со стороны потребителя на защищаемые сервисы, исполняемые в рамках Synapse Service Mesh |

TPS |

Transactions per second, транзакций в секунду |

Deploy Tools |

Программный компонент, предназначенный для автоматизации развертывания и автоматической установки технологических сервисов и бизнес-приложений на тестовых и промышленных стендах (CDJE), программного продукта Platform V DevOps Tools (DOT) |

Unimon |

Программный компонент Объединенный мониторинг Unimon (MONA) программного продукта Platform V Monitor (OPM) |

Децентрализованный Rate Limit |

Компонент Rate Limit, специфичный для одного namespace |

Pod |

Набор контейнеров внутри узла кластера Kubernetes или Red Hat OpenShift (опционально) |

ТУЗ |

Технологическая учётная запись |

SecMan |

Система управления секретами Secret Management System |

Системные требования#

Настройки безопасности окружения и перечень платформенных (дополнительных внешних) продуктов, используемых для установки, настройки и контроля в конечной информационной системе (далее — ИС), выбираются клиентом при разработке конечной ИС, исходя из характера обрабатываемой в ней информации и иных требований информационной безопасности (далее — ИБ), предъявляемых к ней.

Системное программное обеспечение#

Ниже представлены категории системного программного обеспечения (далее — ПО), которые обязательны или опциональны для установки, настройки, контроля и функционирования компонента. В каждой категории перечислены все поддерживаемые продукты сторонних правообладателей. Отдельно обозначены варианты, которые рекомендует АО «СберТех» (маркировка «Рекомендовано» в столбце «Продукт, функциональная совместимость с которым подтверждена»). Клиенту необходимо выбрать один из продуктов в каждой категории, исходя из условий использования конечной ИС.

Категория ПО |

Обязательность установки (да/нет) |

Наименование ПО |

Версия |

Продукт, функциональная совместимость с которым подтверждена |

Описание |

|---|---|---|---|---|---|

Операционная система |

Да |

ОС Альт 8 СП |

10.0 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендована ОС – Platform V SberLinux OS Server), см. раздел «Платформенные зависимости» |

ОС контейнеров для запуска модулей компонента |

Red Hat Enterprise Linux |

7.9.9 и выше |

Опционально |

|||

Среда контейнеризации |

Да |

1.24 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендована среда контейнеризации – Platform V DropApp, см. раздел «Платформенные зависимости» |

Платформа контейнеризации для запуска компонентов сервиса |

|

Red Hat OpenShift |

4.8 и выше |

Опционально |

|||

Средство контейнеризации |

Да |

1.13.1 и выше |

Рекомендовано |

Инструмент для автоматизации работы с контейнерами |

|

Инструмент сборки, тестирования, развертывания контейнеризированных приложений |

Нет |

2.346.0 и выше |

Рекомендовано |

Сервер автоматизации, используемый для внедрения непрерывной интеграции и непрерывной доставки (CI/CD) для проектов программного обеспечения |

|

Сервис интеграции и оркестрации микросервисов в облаке |

Да |

1.12 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендован сервис интеграции и оркестрации микросервисов в облаке, основанный на Istio, – Platform V Synapse Service Mesh, см. раздел «Платформенные зависимости» |

Сервис интеграции микросервисов в облаке |

|

Хранилище данных |

Да |

6.2.7 и выше |

Рекомендовано. Образы, с которыми была проверена работоспособность компонента SRLS: docker.io/library/redis:6.0.9, docker.io/library/redis:6.2.11, docker.io/library/redis:7.0.10 |

Внешний распределенный кеш используется для корректного подсчета лимитов для сервиса, запущенного более чем в одном экземпляре |

|

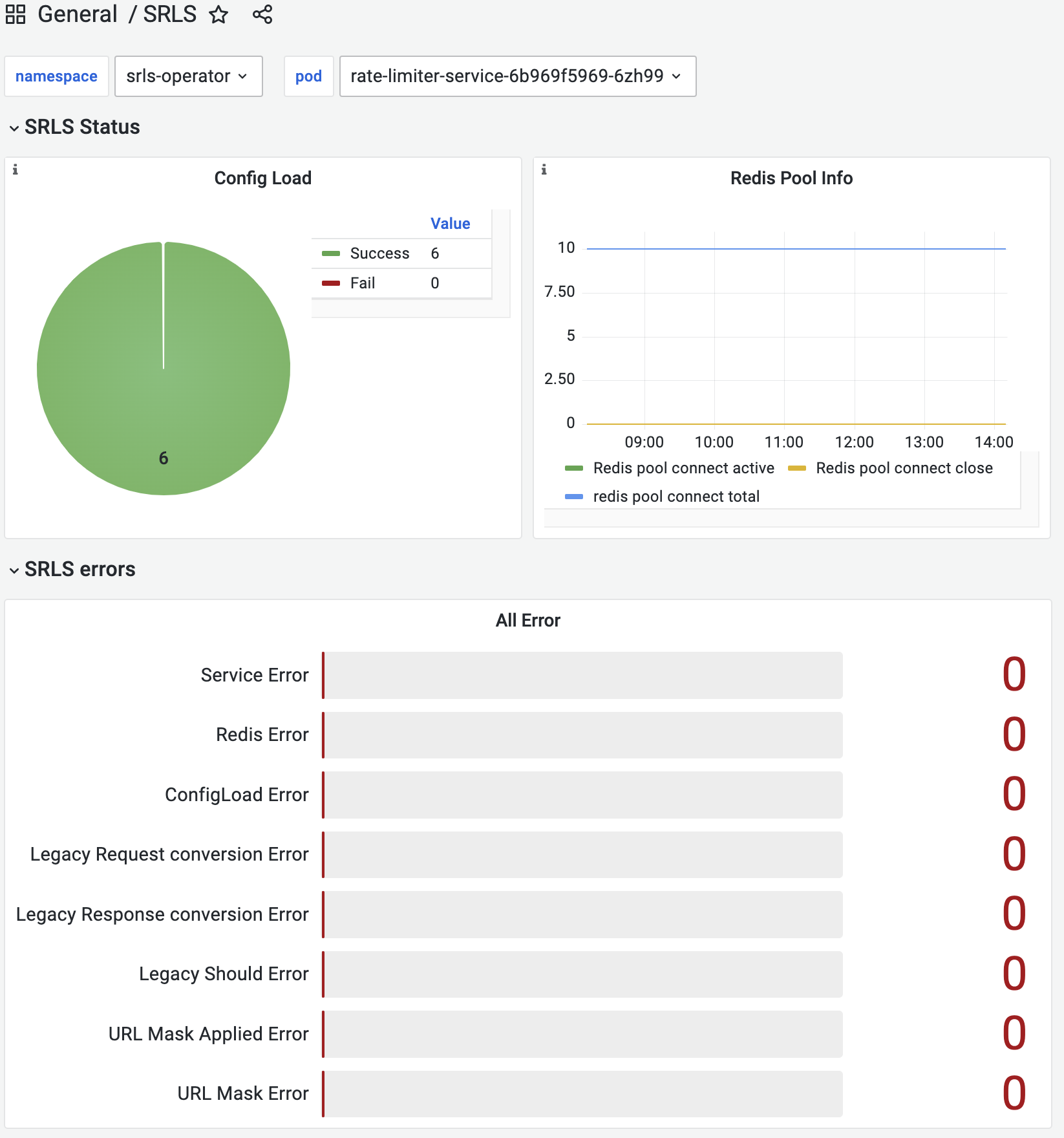

Система мониторинга (сбор и хранение метрик) |

Нет |

2.37.0 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендован Сервис для сбора прикладных и инфраструктурных метрик и отправки их в целевую систему хранения – Объединенный мониторинг Unimon Platform V Monitor, см. раздел «Платформенные зависимости» |

Система для сбора и хранения численных метрик |

|

Система мониторинга (визуализация) |

Нет |

9.5 и выше |

Рекомендовано |

Система для визуализации численных метрик (предоставленных, например, Prometheus) |

|

Система управления секретами |

Нет |

Secret Management System |

1.10.0 и выше |

Рекомендовано |

Система управления аутентификационными данными сервисных аккаунтов или учетных записей |

Здесь и далее поддерживаемой системой приложений-контейнеров является Kubernetes (использование Red Hat OpenShift – опционально). В именах и параметрах системы, в названиях переменных, настроек могут встречаться названия (в т.ч. сокращения) систем контейнеризации, которые одинаково применимы для обеих сред контейнеризации.

Примечание:

*

Да — категория ПО обязательна для функционирования сервиса (это означает, что сервис не может выполнять свои основные функции без установки данной категории ПО).

Нет — категория ПО необязательна для функционирования сервиса (это означает, что сервис может выполнять свои основные функции без установки данной категории ПО).

**

Рекомендовано — рекомендованный правообладателем АО «СберТех» продукт.

Опционально — альтернативный по отношению к рекомендованному правообладателем АО «СберТех» продукт.

Платформенные зависимости#

Для настройки, контроля и функционирования компонента реализована интеграция с программными продуктами, правообладателем которых является АО «СберТех»:

Наименование продукта |

Код |

Версия продукта |

Код и наименование компонента |

Обязательность установки (да/нет) |

Описание |

Аналог других производителей |

|---|---|---|---|---|---|---|

Platform V Monitor |

OPM |

1.2 и выше до потери обратной совместимости |

LOGA Журналирование |

Нет |

Сервис для хранения лог-файлов |

Любой сервис сбора записей о событиях, совместимый с fluent-bit, например: Elasticsearch, InfluxDB |

MONA Объединенный мониторинг Unimon |

Нет |

Сервис для сбора прикладных и инфраструктурных метрик и отправки их в целевую систему хранения |

Prometheus 2.37.0 |

|||

INDA Indicator |

Нет |

Сервис контроля качества работы сервисов платформы, обеспечивающий представление информации о состоянии сервисов посредством обработки значений метрик с последующей визуализацией метрик на различных типах панелей |

Grafana 7.5 |

|||

Platform V DevOps Tools |

DOT |

1.3 |

CDJE Deploy tools |

Нет |

Сервис для развертывания и обновления компонентов Платформы и приложений потребителей, для настройки и обслуживания инфраструктуры Платформы |

Ручное развертывание |

Platform V Synapse Service Mesh |

SSM |

3.8 |

POLM Управление политиками |

Нет |

Панель управления с открытым исходным кодом, служащая для взаимодействия, мониторинга и обеспечения безопасности контейнеров в среде контейнеризации Kubernetes |

Istio control plane 1.12 |

Platform V SberLinux OS Server |

SLO |

8.7 |

INST Операционная система |

Нет |

ОС контейнеров для запуска модулей компонента |

ОС Альт 8 СП |

Platform V DropApp |

K8S |

1.1 и выше |

K8SC K8S Core |

Нет |

Дистрибутив Kubernetes со встроенными механизмами мультитенантности и бессерверным исполнением |

Kubernetes, Red Hat OpenShift Container Platform |

Примечание:

***

Да — компонент или продукт необходим для функционирования сервиса (это означает, что сервис не может выполнять свои основные функции без установки данного компонента).

Нет — необязательный для функционирования сервиса компонент или продукт (это означает, что сервис может выполнять свои основные функции без установки данного компонента).

**** Рекомендуется установка программного продукта, правообладателем которого является АО «СберТех», при этом не исключена возможность (допускается правообладателем) использования аналога других производителей. Аналоги, в отношении которых продукт успешно прошел испытания и подтвердил свою работоспособность, указаны в разделе «Системное программное обеспечение».

Аппаратные требования#

Для установки компонента требуется следующая конфигурация аппаратного обеспечения:

Квота для установки централизованного варианта SRLS:

количество ядер процессора — 5 ядер;

объем оперативной памяти — 10 ГБ.

Квота для установки централизованного варианта SRLS c TLS шифрованием:

количество ядер процессора — 7 ядер;

объем оперативной памяти — 12 ГБ.

Квота для установки децентрализованного варианта SRLS:

количество ядер процессора — 3 ядра;

объем оперативной памяти — 8 ГБ.

Для работы программного компонента в среде контейнеризации Kubernetes или Red Hat OpenShift 4.8 (опционально) необходимы следующие ресурсы:

для компонента RL Operator (на 1 Pod, без учета fluent-bit sidecar и istio sidecar):

CPU |

Memory |

|

|---|---|---|

Limits |

200m |

200Mi |

Requests |

100m |

100Mi |

для компонента RL Service (на 1 Pod, без учета fluent-bit sidecar и istio sidecar):

CPU |

Memory |

|

|---|---|---|

Limits |

500m |

300Mi |

Requests |

250m |

150Mi |

для Redis (на 1 Pod):

Redis/Redis Sentinel |

CPU |

Memory |

|---|---|---|

Limits |

300m/200m |

500Mi/200Mi |

Requests |

150m/100m |

250Mi/100Mi |

для Ingress Gateway (на 1 Pod) — при централизованном варианте SRLS:

CPU |

Memory |

|

|---|---|---|

Limits |

600m |

900Mi |

Requests |

400m |

700Mi |

для Egress Gateway (на 1 Pod) — при централизованном варианте SRLS c TLS-шифрованием:

CPU |

Memory |

|

|---|---|---|

Limits |

600m |

900Mi |

Requests |

400m |

700Mi |

Методика расчета сайзинга#

Оценить производительность программного компонента SRLS можно по результатам нагрузочного тестирования. Были проведены тесты. Результаты:

Централизованный SRLS

CPU |

Memory |

|||

|---|---|---|---|---|

TPS |

Ingress |

RLS |

Ingress |

RLS |

200 |

290 |

220 |

360 |

20 |

500 |

540 |

370 |

363 |

21 |

800 |

820 |

530 |

366 |

21 |

1100 |

1010 |

670 |

367 |

22 |

1400 |

1260 |

820 |

368 |

24 |

Децентрализованный SRLS

CPU |

Memory |

|||

|---|---|---|---|---|

TPS |

Ingress |

RLS |

Ingress |

RLS |

300 |

480 |

360 |

350 |

28 |

800 |

870 |

530 |

354 |

29 |

1100 |

1270 |

690 |

371 |

32 |

1700 |

1600 |

930 |

389 |

31 |

На промежутке TPS, который был выбран для тестирования, отличие от линейной функции будет незначительное, поэтому по полученным результатам тестирования на основе линейной функции (x*a+b) аппроксимировали следующие формулы для расчета требуемых ресурсов CPU и Memory для Ingress и RLS в зависимости от интенсивности нагрузки (TPS):

Централизованный SRLS

CPU

Ingress = Целевой TPS*0,8+141RLS= Целевой TPS*0,5+122

Memory

Ingress = Целевой TPS*0,01+359,5RLS= Целевой TPS*0,003+19,2

Децентрализованный SRLS

CPU

Ingress = Целевой TPS*0,82+255RLS= Целевой TPS*0,41+224

Memory

Ingress = Целевой TPS*0,03+337RLS= Целевой TPS*0,0024+28

Необходимые ресурсы для централизованного SRLS:

CPU |

Memory |

|||

|---|---|---|---|---|

Целевой TPS |

RLS |

Ingress Gateway |

RLS |

Ingress Gateway |

500 |

372 |

541 |

20,7 |

364,5 |

1100 |

672 |

1021 |

22,5 |

370,5 |

1700 |

972 |

1501 |

24,3 |

376,5 |

Необходимые ресурсы для децентрализованного SRLS:

CPU |

Memory |

|||

|---|---|---|---|---|

Целевой TPS |

RLS |

Ingress Gateway |

RLS |

Ingress Gateway |

500 |

429 |

665 |

29,2 |

352 |

1100 |

675 |

1157 |

30,64 |

370 |

1700 |

921 |

1649 |

32,08 |

388 |

Состав дистрибутива#

Элемент дистрибутива |

Описание |

|---|---|

./bh/ratelimit |

Исполняемый файл RL Service |

./bh/rloperator |

Исполняемый файл RL Operator |

Выбор способа установки#

В зависимости от способа развертывания сервиса воспользуйтесь одной из инструкций:

ручная установка сервиса;

автоматизированная установка сервиса с использованием Deploy Tools;

автоматическая установка по агентской схеме;

автоматизированная установка сервиса с использованием Synapse Installer.

Подготовка окружения#

Namespace, в который требуется установить компонент SRLS, должен быть подключен к Istio: убедиться, что в namespace существуют стандартные Config Map Istio с именами istio-ca-root-cert, istio-basic (если нет, то добавить).

Убедиться, что в namespace существует ServiceAccount c именем default (если нет, то добавить).

Для доступа к образам из среды контейнеризации к Docker-registry требуется создать ImagePullSecret (

<дистрибутив>/openshift/other/rls-image-pull-secret.yaml), для этого нужно подготовить JSON вида:

{"auths":{"registry.local.host.ru":{"username":"user","password":"pass","auth":"auth-b64","email":""}}}

Здесь:

user — учетная запись для доступа к registry.local.host.ru;

pass — пароль учетной записи;

auth-b64 — base64 от строки в формате user:pass.

Заполнить поле .dockerconfigjson получившимся JSON:

kind: Secret

apiVersion: v1

metadata:

name: rls-image-pull-secret

namespace: ${rls_namespace}

data:

.dockerconfigjson: >-

type: kubernetes.io/dockerconfigjson

Связать секрет rls-image-pull-secret с ServiceAccount, который используется для скачивания образов. Пример команды для Kubernetes:

kubectl secrets link default rls-image-pull-secret --for=pull -n <namespace>

Здесь namespace — уникальное имя пространства.

Пример команды для OpenShift:

oc secrets link default rls-image-pull-secret --for=pull

Создать или обновить артефакт CustomResourceDefinition в среде контейнеризации Kubernetes или Red Hat OpenShift (опционально).

Пользовательские ресурсы являются расширением API Kubernetes. Артефакт CustomResourceDefinition (сокращенно CRD) позволяет определять пользовательские ресурсы — указать тип и схему ресурса. Добавление артефакта CRD позволяет затем использовать новые пользовательские ресурсы.

В нашем случае для артефактов типа GlobalRateLimit необходимо добавить следующий СRD:

apiVersion: apiextensions.k8s.io/v1

kind: CustomResourceDefinition

metadata:

annotations:

controller-gen.kubebuilder.io/version: v0.9.2

creationTimestamp: null

name: globalratelimits.ratelimit.service

spec:

group: ratelimit.service

names:

kind: GlobalRateLimit

listKind: GlobalRateLimitList

plural: globalratelimits

singular: globalratelimit

scope: Namespaced

versions:

- name: v1alpha1

schema:

openAPIV3Schema:

description: GlobalRateLimit is the Schema for the globalratelimits API

properties:

apiVersion:

description: 'APIVersion defines the versioned schema of this representation

of an object. Servers should convert recognized schemas to the latest

internal value, and may reject unrecognized values. More info: https://git.k8s.io/community/contributors/devel/sig-architecture/api-conventions.md#resources'

type: string

kind:

description: 'Kind is a string value representing the REST resource this

object represents. Servers may infer this from the endpoint the client

submits requests to. Cannot be updated. In CamelCase. More info: https://git.k8s.io/community/contributors/devel/sig-architecture/api-conventions.md#types-kinds'

type: string

metadata:

type: object

spec:

description: GlobalRateLimitSpec defines the desired state of GlobalRateLimit

properties:

endpoints:

items:

properties:

by_header:

nullable: true

properties:

anon_value:

description: Specifies limit for request without header

format: int64

nullable: true

type: integer

header:

default: synapse-consumerid

description: Specifies header to be used

type: string

invokers:

items:

properties:

header_value:

description: Specifies particular consumer

type: string

name:

description: Human-readable consumer description

type: string

schedule:

description: Specifies unnamed schedule for quota

nullable: true

properties:

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment

value

type: integer

value:

default: 1

description: The current soft quota value

of a resource

type: integer

type: object

start:

description: Time to start schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

stop:

description: Time to stop schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

required:

- start

- stop

type: object

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment value

type: integer

value:

default: 1

description: The current soft quota value of a

resource

type: integer

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

type: object

nullable: true

type: array

modify_header:

description: Specifies how the header will be modified

nullable: true

properties:

rule:

description: Specifies the rule of modify

type: string

type:

default: cert

description: Specifies the type of modify

enum:

- cert

type: string

type: object

schedule:

description: Specifies unnamed schedule for quota

nullable: true

properties:

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment value

type: integer

value:

default: 1

description: The current soft quota value of a resource

type: integer

type: object

start:

description: Time to start schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

stop:

description: Time to stop schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

required:

- start

- stop

type: object

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment value

type: integer

value:

default: 1

description: The current soft quota value of a resource

type: integer

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

uri_prefixes:

items:

properties:

anon_value:

description: Specifies limit for request without header

format: int64

nullable: true

type: integer

invokers:

items:

properties:

header_value:

description: Specifies particular consumer

type: string

name:

description: Human-readable consumer description

type: string

schedule:

description: Specifies unnamed schedule for

quota

nullable: true

properties:

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment

value

type: integer

value:

default: 1

description: The current soft quota

value of a resource

type: integer

type: object

start:

description: Time to start schedule for

quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12,

1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6,

0-sunday)

type: string

type: object

stop:

description: Time to stop schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12,

1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6,

0-sunday)

type: string

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

required:

- start

- stop

type: object

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment

value

type: integer

value:

default: 1

description: The current soft quota value

of a resource

type: integer

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

type: object

nullable: true

type: array

schedule:

description: Specifies unnamed schedule for quota

nullable: true

properties:

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment

value

type: integer

value:

default: 1

description: The current soft quota value

of a resource

type: integer

type: object

start:

description: Time to start schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

stop:

description: Time to stop schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

required:

- start

- stop

type: object

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment value

type: integer

value:

default: 1

description: The current soft quota value of a

resource

type: integer

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

uri_prefix:

description: Specifies particular prefix in url

type: string

value:

default: 1

description: Specifies limit

format: int64

type: integer

type: object

nullable: true

type: array

value:

default: 1

description: Specifies limit

format: int64

type: integer

type: object

by_path:

nullable: true

properties:

mask:

default: rn/*:*:*

description: Regular expression to parse path rn/account-id:project-id:resource-id

type: string

quotas:

description: Specifies resource quotas SRLSv2

nullable: true

properties:

flat:

default: 1

description: The current flat quota value of a resource

type: integer

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment value

type: integer

value:

default: 1

description: The current soft quota value of a resource

type: integer

type: object

required:

- flat

type: object

schedule:

description: Specifies unnamed schedule for quota

nullable: true

properties:

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment value

type: integer

value:

default: 1

description: The current soft quota value of a resource

type: integer

type: object

start:

description: Time to start schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

stop:

description: Time to stop schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

required:

- start

- stop

type: object

tenants:

items:

properties:

name:

description: Human-readable consumer description

type: string

quotas:

description: Specifies resource quotas SRLSv2

properties:

flat:

default: 1

description: The current flat quota value of a

resource

type: integer

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment

value

type: integer

value:

default: 1

description: The current soft quota value

of a resource

type: integer

type: object

required:

- flat

type: object

resourceName:

description: Specifies particular consumer

type: string

schedule:

description: Specifies unnamed schedule for quota

nullable: true

properties:

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment

value

type: integer

value:

default: 1

description: The current soft quota value

of a resource

type: integer

type: object

start:

description: Time to start schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

stop:

description: Time to stop schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

required:

- start

- stop

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

required:

- quotas

type: object

nullable: true

type: array

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

type: object

endpoint:

description: Represents target host

minLength: 1

type: string

header:

description: Specifies header to be used

enum:

- synapse-invoker-namespace

- synapse-consumerid

type: string

invokers:

items:

properties:

header_value:

description: Specifies particular consumer

type: string

name:

description: Human-readable consumer description

type: string

schedule:

description: Specifies unnamed schedule for quota

nullable: true

properties:

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment value

type: integer

value:

default: 1

description: The current soft quota value of a

resource

type: integer

type: object

start:

description: Time to start schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

stop:

description: Time to stop schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

required:

- start

- stop

type: object

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment value

type: integer

value:

default: 1

description: The current soft quota value of a resource

type: integer

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

type: object

nullable: true

type: array

name:

description: Human-readable description of target host

type: string

overall_limit:

description: Overall limit per endpoint. Value 0 - block all

requests, negative value - unlimited

format: int64

nullable: true

type: integer

overall_schedule:

description: Specifies unnamed schedule for quota

nullable: true

properties:

soft:

description: Specifies soft quota

nullable: true

properties:

step:

default: 1

description: Resource soft quota increment value

type: integer

value:

default: 1

description: The current soft quota value of a resource

type: integer

type: object

start:

description: Time to start schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

stop:

description: Time to stop schedule for quota

nullable: true

properties:

day:

description: Specifies day (1-31)

type: string

hour:

description: Specifies hour (0-24)

type: string

minute:

description: Specifies minutes (0-59)

type: string

month:

description: Specifies month (1-12, 1-january)

type: string

second:

description: Specifies seconds (0-59)

type: string

weekday:

description: Specifies weekday (0-6, 0-sunday)

type: string

type: object

unit:

default: second

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

default: 1

description: Specifies limit

type: integer

required:

- start

- stop

type: object

shortname:

description: Short description of target host without spaces,

special characters, 3-10 English letter

pattern: ^[a-z]{3,10}$

type: string

unit:

description: Specifies time unit

enum:

- second

- minute

- hour

- day

type: string

value:

description: Specifies limit

format: int64

nullable: true

type: integer

required:

- endpoint

- shortname

type: object

nullable: true

type: array

envoyVersion:

description: Version of the used Envoy

type: string

rlnamespace:

description: Specifies Rate Limit Namespace, this allow to have multiple

SRLS Operators in same cluster

nullable: true

type: string

rlserver:

description: Specifies Rate Limiter service to be used

type: string

rlservercert:

nullable: true

properties:

cert:

description: Path to certificate chain

minLength: 1

type: string

key:

description: Path to private key

minLength: 1

type: string

trust_ca:

description: Path to trusted CA cert

minLength: 1

type: string

required:

- cert

- key

- trust_ca

type: object

rlserverport:

default: 12001

description: Specifies Rate Limiter service port to be used

format: int32

maximum: 65000

minimum: 1

type: integer

type_mode:

default: full

description: Specifies current quota allocation mode

enum:

- full

- share

type: string

visibility:

default: cluster

description: Specifies current settings visibility

enum:

- namespace

- cluster

type: string

workloadSelector:

description: Selector used to find ingress gateway in provider namespace

properties:

labels:

additionalProperties:

type: string

nullable: true

type: object

type: object

type: object

status:

description: GlobalRateLimitStatus defines the observed state of GlobalRateLimit

properties:

applied:

description: Is applied successfully or not

type: boolean

attempt:

description: number of attempts

type: integer

message:

description: Response message from Rate Limiter operator

type: string

operator_version:

description: operator version

type: string

statuses:

description: List with statuses

items:

properties:

name:

description: Status of settings loading on the RateLimiterService

type: string

reason:

description: Reason represents the cause of particular status

type: string

status:

description: Status of adding EnvoyFilter's

type: string

type: object

nullable: true

type: array

timestamp:

description: Last status update timestamp

type: string

type: object

type: object

served: true

storage: true

subresources:

status: {}

В некоторых случаях для добавления CRD администраторы требуют артефакт типа CRDProxy, где в поле data размещен непосредственно CRD.

apiVersion: apps.firepaws.io/v1

kind: CRDProxy

metadata:

name: crdproxy-globalratelimits-ratelimit-service

namespace: ${rls_namespace}

serviceAccount:

- rate-limiter-service

data: |-

< содержимое нашего артефакта СRD >

Далее описаны подготовительные шаги, специфичные для конкретного варианта развертывания: централизованный, децентрализованный.

Централизованный вариант развертывания#

Сертификаты для Ingress Gateway#

Необходимо подготовить сертификаты для Ingress Gateway (ca-root.pem, ingress.key, ingress.pem), рекомендуемая утилита для генерации и выпуска сертификатов — OpenSSL.

Для хранения «чувствительной» информации с точки зрения безопасности целевым подходом является интеграция с Secret Management System (далее SecMan).

Вариант установки с SecMan.

Добавить необходимые сертификаты в Key-Value хранилище. Структура секрета в хранилище в формате JSON:

{

"ca": "-----BEGIN CERTIFICATE-----<...>-----END CERTIFICATE-----\n",

"crt": "-----BEGIN CERTIFICATE-----<...>-----END CERTIFICATE-----\n",

"key": "-----BEGIN RSA PRIVATE KEY-----<...>-----END RSA PRIVATE KEY-----\n"

"ttl": "3m"

}

Ключи в хранилище должны соответствовать указанным:

Название ключа |

Описание |

|---|---|

ca |

Ключ для корневого сертификата (ca-root.pem) |

crt |

Ключ для серверного сертификата (ingress.pem) |

key |

Ключ для приватного ключа сертификата (ingress.key) |

ttl |

Ключ для времени жизни секрета (определяет период обновления в реальном времени секрета в Pod) |

Вариант установки без SecMan.

Добавить в Kubernetes или Red Hat OpenShift (опционально) секрет ingress-secrets.

Секрет может быть создан с помощью инструмента командной строки или через файл манифеста Secret

Пример команды для Kubernetes:

kubectl create secret generic ingress-secrets \

--from-file=ca-root.pem=ca-root.pem \

--from-file=ingress.key=ingress.key \

--from-file=ingress.pem=ingress.pem \

-n <namespace>

Здесь namespace — уникальное имя пространства.

Пример команды для OpenShift:

oc create secret generic ingress-secrets \

--from-file=ca-root.pem=ca-root.pem \

--from-file=ingress.key=ingress.key \

--from-file=ingress.pem=ingress.pem

Пример манифеста:

kind: Secret

apiVersion: v1

metadata:

name: ingress-secrets

namespace: ${rls_namespace}

data:

ca-root.pem: >-

ingress.key: >-

ingress.pem: >-

type: Opaque

Здесь поля ca-root.pem, ingress.key, ingress.pem должны быть заполнены данными из соответствующих файлов в base64 кодировке.

Пример команды для получения данных в формате base64:

base64 -w 0 ca-root.pem

Сертификаты для Egress Gateway#

Необходимо подготовить сертификаты для Egress Gateway (ca-root.pem, egress.key, egress.pem), рекомендуемая утилита для генерации и выпуска сертификатов — OpenSSL.

Для хранения «чувствительной» информации с точки зрения безопасности целевым подходом является интеграция с Secret Management System (далее SecMan).

Вариант установки с SecMan.

Добавить необходимые сертификаты в Key-Value хранилище. Структура секрета в хранилище в формате JSON:

{

"ca": "-----BEGIN CERTIFICATE-----<...>-----END CERTIFICATE-----\n",

"crt": "-----BEGIN CERTIFICATE-----<...>-----END CERTIFICATE-----\n",

"key": "-----BEGIN RSA PRIVATE KEY-----<...>-----END RSA PRIVATE KEY-----\n"

"ttl": "3m"

}

Ключи в хранилище должны соответствовать указанным:

Название ключа |

Описание |

|---|---|

ca |

Ключ для корневого сертификата (ca-root.pem) |

crt |

Ключ для серверного сертификата (egress.pem) |

key |

Ключ для приватного ключа сертификата (egress.key) |

ttl |

Ключ для времени жизни секрета (определяет период обновления в реальном времени секрета в Pod) |

Вариант установки без SecMan.

Добавить в Kubernetes или Red Hat OpenShift (опционально) секрет egress-secrets.

Секрет может быть создан с помощью инструмента командной строки или через файл манифеста Secret.

Пример команды для Kubernetes:

kubectl create secret generic egress-secrets \

--from-file=ca-root.pem=ca-root.pem \

--from-file=egress.key=ingress.key \

--from-file=egress.pem=ingress.pem \

-n <namespace>

Здесь namespace — уникальное имя пространства.

Пример команды для OpenShift:

oc create secret generic egress-secrets \

--from-file=ca-root.pem=ca-root.pem \

--from-file=egress.key=ingress.key \

--from-file=egress.pem=ingress.pem

Пример манифеста:

kind: Secret

apiVersion: v1

metadata:

name: egress-secrets

namespace: ${rls_namespace}

data:

ca-root.pem: >-

egress.key: >-

egress.pem: >-

type: Opaque

Здесь поля ca-root.pem, egress.key, egress.pem должны быть заполнены данными из соответствующих файлов в base64-кодировке.

Пример команды для получения данных в формате base64:

base64 -w 0 ca-root.pem

Сертификаты для RL Service#

Если планируется использование шифрования трафика между граничным прокси и централизованным RL Service, необходимо подготовить сертификаты для RL Service (ca-root.pem, server.key, server.pem). Рекомендуемая утилита для генерации и выпуска сертификатов — OpenSSL.

Для хранения «чувствительной» информации с точки зрения безопасности целевым подходом является интеграция с Secret Management System (далее SecMan).

Вариант установки с SecMan.

Добавить необходимые сертификаты в Key-Value хранилище. Структура секрета в хранилище в формате JSON:

{

"ca": "-----BEGIN CERTIFICATE-----<...>-----END CERTIFICATE-----\n",

"crt": "-----BEGIN CERTIFICATE-----<...>-----END CERTIFICATE-----\n",

"key": "-----BEGIN RSA PRIVATE KEY-----<...>-----END RSA PRIVATE KEY-----\n"

"ttl": "3m"

}

Ключи в хранилище должны соответствовать указанным:

Название ключа |

Описание |

|---|---|

ca |

Ключ для корневого сертификата (ca-root.pem) |

crt |

Ключ для серверного сертификата (server.pem) |

key |

Ключ для приватного ключа сертификата (server.key) |

ttl |

Ключ для времени жизни секрета (определяет период обновления в реальном времени секрета в Pod) |

Вариант установки без SecMan.

Добавить в Kubernetes или Red Hat OpenShift (опционально) секрет rate-limiter-secrets.

Секрет может быть создан с помощью инструмента командной строки или через файл манифеста Secret.

Пример команды для Kubernetes:

kubectl create secret generic rate-limiter-secrets \

--from-file=ca-root.pem=ca-root.pem \

--from-file=egress.key=server.key \

--from-file=egress.pem=server.pem \

-n <namespace>

Здесь namespace — уникальное имя пространства.

Пример команды для OpenShift:

oc create secret generic rate-limiter-secrets \

--from-file=ca-root.pem=ca-root.pem \

--from-file=egress.key=server.key \

--from-file=egress.pem=server.pem

Пример манифеста:

kind: Secret

apiVersion: v1

metadata:

name: rate-limiter-secrets

namespace: ${rls_namespace}

data:

ca-root.pem: >-

server.key: >-

server.pem: >-

type: Opaque

Здесь поля ca-root.pem, server.key, server.pem должны быть заполнены данными из соответствующих файлов в base64-кодировке.

Пример команды для получения данных в формате base64:

base64 -w 0 ca-root.pem

Ролевая модель централизованного варианта развертывания#

Для корректной работы компонента в централизованном варианте развертывания необходимо предоставление следующих прав на артефакты k8s:

Артефакт |

API группа |

Права |

Описание |

|---|---|---|---|

globalratelimits |

ratelimit.service |

- get - list - watch |

Права предоставляются на уровне кластера K8s |

globalratelimits/status globalratelimits/finalizers |

ratelimit.service |

- get - list - watch - update - patch |

Права предоставляются на уровне кластера K8s |

namespaces |

- list |

Права предоставляются на уровне кластера K8s |

|

leases |

coordination.k8s.io |

- get - update - patch |

Права предоставляются на уровне namespace, в котором развертывается централизованный SRLS |

events |

- create |

Права предоставляются на уровне namespace, в котором развертывается централизованный SRLS |

|

envoyfilters |

networking.istio.io |

- get - list - watch - create - update - patch - delete |

Права предоставляются на уровне namespace, в котором развертывается прикладной дистрибутив; в артефакте RoleBinding необходимо указать ServiceAccount в namespace централизованного SRLS |

Ниже приведены артефакты, необходимые для настройки прав доступа (актуальные артефакты доступны в <дистрибутив>/conf/k8s/base/other/operator-role):

ServiceAccount

kind: ServiceAccount

apiVersion: v1

metadata:

name: rate-limiter-service

namespace: ${rls_namespace}

ClusterRole

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: rate-limiter-service-operator

rules:

- verbs:

- get

- list

- watch

apiGroups:

- ratelimit.service

resources:

- globalratelimits

- verbs:

- get

- list

- watch

- update

- patch

apiGroups:

- ratelimit.service

resources:

- globalratelimits/status

- globalratelimits/finalizers

- verbs:

- list

apiGroups:

- ''

resources:

- namespaces

ClusterRoleBinding

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: rloperator-crb-${rls_namespace}

subjects:

- kind: ServiceAccount

name: rate-limiter-service

namespace: ${rls_namespace}

roleRef:

kind: ClusterRole

name: rate-limiter-service-operator

apiGroup: rbac.authorization.k8s.io

Lease (если не создается в рамках установки через Deploy Tools)

apiVersion: coordination.k8s.io/v1

kind: Lease

metadata:

name: srls-operator-lock

namespace: ${rls_namespace}

labels:

app: rloperator

proj: synapse-rls

agent: srls

Role

kind: Role

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: srls-operator-role

namespace: ${rls_namespace}

rules:

- verbs:

- get

- update

- patch

apiGroups:

- 'coordination.k8s.io'

resources:

- leases

resourceNames:

- srls-operator-lock

- apiGroups:

- ""

resources:

- events

verbs:

- create

RoleBinding

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: rloperator-rb

namespace: ${rls_namespace}

subjects:

- kind: ServiceAccount

name: rate-limiter-service

namespace: ${rls_namespace}

roleRef:

kind: Role

name: srls-operator-role

apiGroup: rbac.authorization.k8s.io

ClusterRole

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: srls-role

rules:

- verbs:

- get

- list

- watch

- create

- update

- patch

- delete

apiGroups:

- networking.istio.io

resources:

- envoyfilters

Артефакт, который необходимо создать команде сопровождения прикладного namespace для подключения к централизованному SRLS:

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: srls-role-binding

namespace: ${namespace}

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: srls-role

subjects:

- kind: ServiceAccount

name: rate-limiter-service

namespace: ${rls_namespace}

Сетевая видимость RL Service в рамках кластера#

Для обеспечения возможности подключения к Pod RL Service из других namespace необходимо создать артефакт (актуальный шаблон артефакта расположен в <дистрибутив>/k8s/base/other/network-policy.yaml):

kind: NetworkPolicy

apiVersion: networking.k8s.io/v1

metadata:

name: rlservice

namespace: ${rls-namespace}

spec:

podSelector:

matchLabels:

app: rls

proj: synapse-rls

ingress:

- ports:

- protocol: TCP

port: 8081

from:

- podSelector:

matchLabels:

srls: ratelimit

namespaceSelector: {}

policyTypes:

- Ingress

Артефакт разрешает входящий трафик в namespace централизованного SRLS к Pod RL Service по порту 8081 из других namespace, но только для Pod, у которых есть label srls: ratelimit. Данный подход позволяет сократить время на запрос к RL Service за счет прямого обращения, минуя Egress Gateway и Ingress Gateway.

Децентрализованный вариант развертывания#

Ролевая модель децентрализованного варианта развертывания#

Для корректной работы компонента в децентрализованном варианте развертывания необходимо предоставление следующих прав на артефакты k8s:

Артефакт |

API группа |

Права |

Описание |

|---|---|---|---|

globalratelimits |

ratelimit.service |

- get - list - watch |

Права предоставляются на уровне прикладного namespace |

globalratelimits/status globalratelimits/finalizers |

ratelimit.service |

- get - list - watch - update - patch |

Права предоставляются на уровне прикладного namespace |

namespaces |

- list |

Права предоставляются на уровне прикладного namespace |

|

leases |

coordination.k8s.io |

- get - update - patch |

Права предоставляются на уровне прикладного namespace |

events |

- create |

Права предоставляются на уровне прикладного namespace |

|

envoyfilters |

networking.istio.io |

- get - list - watch - create - update - patch - delete |

Права предоставляются на уровне прикладного namespace |

Возможен вариант развертывания, при котором не производится автоматизированное создание артефакта EnvoyFilter компонентом RL Operator в процессе обработки артефакта GlobaLRateLimit. В этом случае необходимо выбрать соответствующий артефакт Role, установить значение true стендозависимого параметра disable_envoy_filter_automation и создать необходимые для работы артефакты EnvoyFilter самостоятельно. Инструкция по созданию артефакта EnvoyFilter описана в документе «Руководство прикладного разработчика» в разделе «Конфигурирование артефактов среды контейнеризации и Istio для децентрализованного варианта развертывания».

Ниже приведены артефакты, необходимые для настройки прав доступа (актуальные артефакты доступны в <дистрибутив>/conf/k8s/base/operator-role/other):

ServiceAccount

kind: ServiceAccount

apiVersion: v1

metadata:

name: rate-limiter-service

namespace: ${namespace}

Role с поддержкой автоматизированного создания артефакта EnvoyFilter

kind: Role

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: srls-decentr-operator-role

namespace: ${namespace}

rules:

- verbs:

- get

- list

- watch

apiGroups:

- ratelimit.service

resources:

- globalratelimits

- verbs:

- get

- list

- watch

- update

- patch

apiGroups:

- ratelimit.service

resources:

- globalratelimits/status

- globalratelimits/finalizers

- verbs:

- get

- list

- watch

- create

- update

- patch

- delete

apiGroups:

- networking.istio.io

resources:

- envoyfilters

- verbs:

- get

- update

- patch

apiGroups:

- 'coordination.k8s.io'

resources:

- leases

resourceNames:

- srls-operator-lock

- apiGroups:

- ""

resources:

- events

verbs:

- create

Role без поддержки автоматизированного создания артефакта EnvoyFilter (опционально)

kind: Role

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: srls-decentr-operator-role

namespace: ${namespace}

rules:

- verbs:

- get

- list

- watch

apiGroups:

- ratelimit.service

resources:

- globalratelimits

- verbs:

- get

- list

- watch

- update

- patch

apiGroups:

- ratelimit.service

resources:

- globalratelimits/status

- globalratelimits/finalizers

- verbs:

- get

- update

- patch

apiGroups:

- 'coordination.k8s.io'

resources:

- leases

resourceNames:

- srls-operator-lock

- apiGroups:

- ""

resources:

- events

verbs:

- create

Lease (если не создается в рамках установки через Deploy Tools)

apiVersion: coordination.k8s.io/v1

kind: Lease

metadata:

name: srls-operator-lock

namespace: ${namespace}

labels:

app: rloperator

proj: synapse-rls

agent: srls

RoleBinding

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: rloperator

namespace: ${namespace}

subjects:

- kind: ServiceAccount

name: rate-limiter-service

namespace: ${namespace}

roleRef:

kind: Role

name: srls-decentr-operator-role

apiGroup: rbac.authorization.k8s.io

Установка#

Параметры установки#

Параметры шаблонизации расположены в <дистрибутив>/conf/custom_property.conf.yml.

Название |

Описание |

Значение по умолчанию |

|---|---|---|

srls_registry |

ссылка до registry, если не задано администратором в настройках инструмента развертывания/распаковки |

docker-registy.mydomain.com |

srls_registry_path |

базовый путь до каталога с образами, если не задано администратором в настройках инструмента развертывания/распаковки |

/public |

FLUENT_BIT_SIDECAR_ENABLED |

Если |

False |

TENANT_CODE |

Код тенанта, используемый в конфигурации fluent-bit ufs-logger, определяется в настройках инструмента развертывания/распаковки |

- |

SRLS_TLS_ENABLED |

Включить TLS-шифрование на RL Service |

False |

SRLS_TENANT_CODE |

Код тенанта, используемый в конфигурации fluent-bit ufs-logger, если в настройках инструмента развертывания/распаковки не задан параметр TENANT_CODE |

SRLS |

POD_DISRUPTION_BUDGET_ENABLED |

Если |

True |

DEPLOY_TO_KUBERNETES |

Для совместимости с Kubernetes и Platform V DropApp |

False |

DEPLOY_LEASE_ENABLED |

Разворачивать или нет артефакт Lease в составе дистрибутива |

False |

SECMAN_ENABLED |

Если |

True |

SECMAN_NAMESPACE_ENABLED |

Поддержка пространств в хранилище SecMan |

False |

SECRET_ENABLED |

Если |

False |

SSM_ENABLED |

Если |

True |

DEPLOY_ACCOUNT |

Если |

False |

DEPLOY_CENTR |

Если |

False |

DEPLOY_DECENTR |

Если |

True |

DEPLOY_LIMITS |

Если |

False |

endpoints |

Если значение параметра DEPLOY_LIMITS выставлено в |

Пример значения параметра endpoints:

[{"endpoint": "test-server2-endpoint:8080","name": "test service2","shortname": "server2","overall_limit": 100,"by_header": {"header": "synapse-consumerid","uri_prefixes": [{"uri_prefix": "/service","unit":"second","value": 5,"soft": {"step": 2,"value": 1},"anon_value": 10,"invokers": [{"header_value": "test-client-namespace2","name": "invoker_prefix_2","unit": "second","value": 10,"soft": {"step": 2,"value": 1}},{"header_value": "test-client-namespace1","name": "invoker_prefix_1","unit": "second","value": 5}]}]}},{"endpoint": "test-server-endpoint:8080","name": "test service","shortname": "server","overall_limit": -1,"by_header": {"header": "synapse-consumerid","unit": "minute","value": 5,"soft": {"step": 2,"value": 1},"anon_value": 10,"invokers": [{"header_value": "test-client-namespace2","name": "invoker2","unit": "second","value": 10,"soft": {"step": 2,"value": 1}},{"header_value": "test-client-namespace1","name": "invoker1","unit": "second","value": 5}]}},{"endpoint": "test-server3-endpoint:8080","name": "test service","shortname": "server","overall_limit": -1,"by_path": {"mask": "mask","unit": "second","quotas": {"flat": 7,"soft": {"step": 2,"value": 4}},"tenants": [{"name": "tenant1","resourceName": "rntenant1","unit": "second","quotas": {"soft": {"step": 1,"value": 2}}},{"name": "tenant2","resourceName": "rntenant2","unit": "second","quotas": {"flat": 1}}]}}]

Список стендозависимых параметров (указываются в конфигурации job) для установки и их описание представлены в таблице «Список и описание параметров». Стендозависимые параметры расположены в <дистрибутив>/conf/config/parameters.

ВАЖНО!

Названия стендозависимых параметров, начиная с версии компонента SRLS 2.6, отличаются от названий в предыдущих версиях.

Список и описание параметров:

Название |

Описание |

Пример |

Примечание |

|---|---|---|---|

rls_namespace |

Имя пространства, в котором разворачиваются RL Service, RL Operator и Ingress Gateway |

synapse-dev-sandbox |

|

rls_redisUrl |

Адрес подключения к Redis |

mymaster,redis-sentinel-0.redis-sentinel:26379,redis-sentinel-1.redis-sentinel:26379,redis-sentinel-2.redis-sentinel:26379 |

Для standalone развертывания с Redis с режимом подключения SINGLE можно указать один адрес |

rls_redisType |

Тип работы Redis |

SENTINEL |

Для подключения к Redis с одной нодой нужно указать SINGLE |

rls_localCacheSizeInBytes |

Размер локального кеша |

524288 |

|

rls_backend |

Тип хранилища key-value для RL Service |

redis |

|

rls_logLevel |

Уровень логирования для RL Service |

info |

|

rls_tls_enable |

Включение/выключение шифрования TLS |

false |

|

rls_tls_client_auth |

Запрос и валидация сертификатов пользователей: none — не запрашивать; must — запрашивать; want — запрашивать и валидировать |

none |

|

rls_tls_cert_path |

Путь до сертификатов в контейнере RL Service |

/cert |

|

rls_tls_cert_pem |

Имя файла сертификата в контейнере RL Service |

server.pem |

|

rls_tls_cert_key |

Имя файла с ключом сертификата в контейнере RL Service |

server.key |

|

rls_tls_cert_ca_pem |

Имя файла CA сертификата в контейнере RL Service |

ca-root.pem |

|

envoy_filter_grpc_timeout |

Тайм-аут на обращение к сервису Rate Limit |

1s |

|

ingress_image |

Полное название образа ingress |

registry.redhat.io/openshift-service-mesh/proxyv2-rhel8@sha256:dbb1f724333f6892d53f13c9619dcf3eff572b06c944c28fe6ad12fa18a7dc7b |

|

istiod_svc |

Адрес подключения к istiod |

istiod-basic.synapse-smcp20-control-plane.svc:15012 |

|

tracing_collector |

Адрес подключения к сервису публикации данных о трассировке запросов |

jaeger-collector.sbt-devpub-controlplanev2.svc:9411 |

|

redis_image |

Ссылка на образ с Redis 6 |

docker.registry.host/registry_redhat_io/rhel8/redis-6@sha256:fe10fcc7b9734d22a18d5c96c219b2e25d7fdddd19c6292b8b2cb38b0f2f6037 |

|

redis_fsgroup |

Идентификатор дополнительной группы для запуска Pod Redis и Redis Sentinel |

1337 |

|

redis_run_as_user |

Идентификатор пользователя для запуска Pod Redis и Redis Sentinel |

1337 |

|

operator_backend |

Тип хранилища key-value для RL Operator |

redis |

|

operator_redisType |

Тип работы Redis |

SENTINEL |

Для подключения к Redis с одной нодой нужно указать SINGLE |

operator_redisUrl |

Адрес подключения к Redis |

mymaster,redis-sentinel-0.redis-sentinel:26379,redis-sentinel-1.redis-sentinel:26379,redis-sentinel-2.redis-sentinel:26379 |

Для standalone развертывания с Redis с режимом подключения SINGLE можно указать один адрес |

operator_scope |

Режим работы оператора |

namespace |

Для централизованного режима — cluster, для децентрализованного — namespace |

operator_logLevel |

Уровень логирования RL Operator |

info |

|

rls_hostname |

Имя host в Route для подключения к namespace централизованного SRLS |

||

global.common.poddisruptionbudget.minAvailable |

Глобальный параметр среды для PodDistributionBudget |

Параметр, который гарантирует, что как минимум столько реплик будет гарантировано доступны при работе Machine Config, при обновлении кластера OpenShift и других работах, требующих переезд Pod с одной ноды на другую |

|

rloperator_ose_poddisruptionbudget_spec_minAvailable |

Параметр среды для RL Operator PodDistributionBudget |

1 |

Параметр задается в файле конфигурации operator.srls.conf |

ratelimiter_ose_poddisruptionbudget_spec_minAvailable |

Параметр среды для RateLimiter PodDistributionBudget |

1 |

Параметр задается в файле конфигурации rls.srls.conf |

ingress_ose_poddisruptionbudget_spec_minAvailable |

Параметр среды для Ingress Gateway PodDistributionBudget |

1 |

Параметр задается в файле конфигурации ingress.srls.conf |

redis_ose_poddisruptionbudget_spec_minAvailable |

Параметр среды для Redis PodDistributionBudget |

1 |

Параметр задается в файле конфигурации redis.srls.conf |

sentinel_ose_poddisruptionbudget_spec_minAvailable |

Параметр среды для Sentinel PodDistributionBudget |

1 |

Параметр задается в файле конфигурации sentinel.srls.conf |

egress_ose_poddisruptionbudget_spec_minAvailable |

Параметр среды для Egress Gateway PodDistributionBudget |

1 |

Параметр задается в файле конфигурации egress.srls.conf |

whiteList_headers_regular |

Список заголовков с регулярным выражением для реализации белого списка |

|

Данный пример для пропуска сертификата с CN=someCN.local.host.ru, больше примеров представлено в таблице «Варианты конфигурации белых списков» |

secman_role |

Роль в SecMan, получаемая при подключении к хранилищу |

role |

|

secman_namespace |

Пространство в хранилище SecMan |

CI01234567_CI76543210 |

Указывать, если в хранилище поддерживаются пространства имён. При этом должен быть задан параметр шаблонизации SECMAN_NAMESPACE_ENABLED |

secman_full_path_to_secret |

Полный путь до секрета в SecMan для Ingress Gateway |

DEV/TEST/FS/KV/ingress-secrets |

|

secman_full_path_to_secret_egress |

Полный путь до секрета в SecMan для Egress Gateway |

DEV/TEST/FS/KV/egress-secrets |

|

secman_full_path_to_rls_secret |

Полный путь до секрета в SecMan для RL Service |

DEV/TEST/FS/KV/rls-secrets |

|

secman_host |

Host для SecMan |

secman.solution.ru |

|

secman_port |

Port для SecMan |

8443 |

|

egress_secman_port |

Порт для сервиса SecMan на egress |

8550 |

|

kubernetes_service_host |

Cервис kubernetes |

kubernetes.default.svc.cluster.local |

|

kubernetes_service_port |

Порт сервиса kubernetes |

443 |

|

kube_ip |

IP-адрес сервиса kubernetes |

||

egress_kubeapi_port |

Порт для сервиса kubernetes на egress |

4443 |

|

egress_selectors |

Селекторы egress, установленного в прикладном namespace |

{"istio":"egress-my_namespace"} |

|

ufs_logger_kafka_bootstrap_servers |

Список адресов кластера брокеров Kafka для журналирования |

{ IP_ADDRESS }:9092 |

|

ufs_logger_kafka_topic |

Название топика для журналирования |

eventlog |

|

ufs_logger_kafka_security_protocol |

Конфигурация закрытого соединения с Kafka |

plaintext / ssl |

|

loggerOpenshiftRegistry |

Docker registry для образа платформенного Logger |

docker-registy.mydomain.com/public/efs |

|

logger_pl_sidecar_cpuLimit |

fluent-bit sidecar cpu limit |

200m |

|

logger_pl_sidecar_memLimit |

fluent-bit sidecar memory limit |

200Mi |

|

logger_pl_sidecar_cpuRequest |

fluent-bit sidecar cpu request |

100m |

|

logger_pl_sidecar_memRequest |

fluent-bit sidecar memory request |

100Mi |

|

logger_pl_sidecar_run_as_user |

fluent-bit sidecar securityContext runAsUser |

1001560000 |

Для k8s – 1001 |

logger_pl_sidecar_run_as_group |

fluent-bit sidecar securityContext runAsGroup |

1001560000 |

Для k8s – 2000 |

logger_pl_sidecar_cert_ca_root |

Значение в base64-кодировке logger_cacerts.cer для secret (fluent-bit-kafka-cert) fluent-bit sidecar |

||

logger_pl_sidecar_cert |

Значение в base64-кодировке logger_cert.pem для secret (fluent-bit-kafka-cert) fluent-bit sidecar |

||

logger_pl_sidecar_cert_key |

Значение в base64-кодировке logger_private-key.pem для secret (fluent-bit-kafka-cert) fluent-bit sidecar |

||

secman_sidecar_cpuLimit |

secman sidecar cpu limit |

100m |

|

secman_sidecar_cpuRequest |

secman sidecar cpu request |

50m |

|

secman_sidecar_memRequest |

secman sidecar memory request |

64Mi |

|

secman_sidecar_memLimit |

secman sidecar memory limit |

128Mi |

|

disable_envoy_filter_automation |

Если выставлено значение |

false |

|

ingress_cert_ca_root |

Значение в base64-кодировке ca-root.pem для secret (ingress-secrets) Ingress Gateway |

||

ingress_cert |

Значение в base64-кодировке ingress.pem для secret (ingress-secrets) Ingress Gateway |

||

ingress_cert_key |

Значение в base64-кодировке ingress.key для secret (ingress-secrets) Ingress Gateway |

||

egress_cert_ca_root |

Значение в base64-кодировке ca-root.pem для secret (egress-secrets) Egress Gateway |

||

egress_cert |

Значение в base64-кодировке egress.pem для secret (egress-secrets) Egress Gateway |

||

egress_cert_key |

Значение в base64-кодировке egress.key для secret (egress-secrets) Egress Gateway |

||

rls_cert_ca_root |

Значение в base64-кодировке ca-root.pem для secret (rate-limiter-secrets) RL Service |

||

rls_cert |

Значение в base64-кодировке server.pem для secret (rate-limiter-secrets) RL Service |

||

rls_cert_key |

Значение в base64-кодировке server.key для secret (rate-limiter-secrets) RL Service |

||

igeg_fsgroup |

Идентификатор дополнительной группы для запуска Pod Ingress и Egress |

1337 |

|

igeg_run_as_user |

Идентификатор пользователя для запуска Pod Ingress и Egress |

1337 |

|

igeg_run_as_group |

Идентификатор группы для запуска Pod Ingress и Egress |

1337 |

|

redis_fsgroup |

Идентификатор дополнительной группы для запуска Pod Redis и Sentinel |

1001 |

|

redis_run_as_user |

Идентификатор пользователя для запуска Pod Redis и Sentinel |

1001 |

|

redis_run_as_group |

Идентификатор группы для запуска Pod Redis и Sentinel |

1001 |

|

secman_sidecar_run_as_user |

Идентификатор пользователя для запуска secman sidecar |

1001 |

|

secman_sidecar_as_group |

Идентификатор группы для запуска secman sidecar |

1001 |

|

rls_fsgroup |

Идентификатор дополнительной группы для запуска Pod RL Operator и RL Service |

1001 |

|

rls_run_as_user |

Идентификатор пользователя для запуска Pod RL Operator и RL Service |

1001 |

|

rls_run_as_group |

Идентификатор группы для запуска Pod RL Operator и RL Service |

1001 |

Параметры числа реплик Pod:

Название |

Описание |

Значение по умолчанию |

|---|---|---|

srls_ingress_deployment_replicas |

Число реплик Ingress Gateway |

2 |

srls_egress_deployment_replicas |

Число реплик Egress Gateway |

2 |

srls_rloperator_deployment_replicas |

Число реплик RL Operator |

2 |

srls_ratelimiter_deployment_replicas |

Число реплик RL Service |

2 |