Руководство по установке#

В руководстве приведены инструкции по установке компонента Поисковый движок (SRHX) продукта Platform V Search (SRH).

Расшифровку основных понятий смотрите в перечне Термины и определения.

Системные требования#

Настройки безопасности окружения и перечень платформенных (дополнительных внешних) продуктов, используемых для установки, настройки и контроля в конечной информационной системе (далее — ИС), выбираются при разработке конечной ИС, исходя из характера обрабатываемой в ней информации и иных требований информационной безопасности (далее — ИБ), предъявляемых к ней.

Системное программное обеспечение#

Ниже представлены категории системного программного обеспечения (далее — ПО), которые обязательны или опциональны для установки, настройки, контроля и функционирования компонента SRHX. В каждой категории перечислены все поддерживаемые продукты сторонних правообладателей. Отдельно обозначены варианты, которые рекомендует АО «СберТех» (маркировка «Рекомендовано» в столбце «Продукт, функциональная совместимость с которым подтверждена»). Клиенту необходимо выбрать один из продуктов в каждой категории, исходя из условий использования конечной ИС.

Категория ПО |

Обязательность установки* |

Наименование ПО |

Версия |

Продукт, функциональная совместимость с которым подтверждена** |

Описание |

|---|---|---|---|---|---|

Операционная система |

Да |

ОС Альт 8 СП |

9 и выше |

Опционально. Правообладателем АО «СберТех» также рекомендован компонент Операционная система INST продукта Platform V SberLinux OS Server SLO, см. раздел «Платформенные зависимости» |

Среда для запуска модулей компонента |

Red Hat Enterprise Linux |

8.8.1 и выше |

Опционально. Правообладателем АО «СберТех» также рекомендован компонент Операционная система INST продукта Platform V SberLinux OS Server SLO, см. раздел «Платформенные зависимости» |

Среда для запуска модулей компонента |

||

Среда контейнеризации |

Да |

Kubernetes |

1.26 и выше |

Опционально. Правообладателем АО «СберТех» также рекомендован компонент K8S Core K8SC продукта Platform V DropApp, см. раздел «Платформенные зависимости» |

Платформа контейнеризации для запуска компонентов сервиса |

Java-машина |

Да |

OpenJDK |

17.0.12.0.7-2 и выше до потери обратной совместимости (в рамках 17 версии) |

Рекомендовано |

Окружение для работы модулей компонента |

Программная платформа |

Да |

NodeJS |

18.20.4-1 и выше до потери обратной совместимости (в рамках 18 версии) |

Рекомендовано |

Среда выполнения JS |

Система управления доступом к информационным ресурсам |

Нет |

СУДИР |

любая актуальная версия |

Опционально. Правообладателем АО «СберТех» также рекомендован компонент IAM Proxy продукта Platform V IAM SE, см. раздел «Платформенные зависимости» |

Сервис управления доступом и информационными ресурсами |

Брокер сообщений |

Нет |

Kafka |

3.4.1 и выше |

Опционально. Правообладателем АО «СберТех» также рекомендован брокер сообщений, основанный на Kafka, – Platform V Corax, см. раздел «Платформенные зависимости» |

Событийный обмен сообщениями между модулями компонента |

Система создания, хранения и распространения секретов |

Нет |

HashiCorp Vault |

1.15.0 и выше |

Опционально |

Система, обеспечивающая безопасный и надежный способ создания, хранения и распространения секретов |

Secret Management System |

1.16.1 и выше до потери обратной совместимости |

Опционально |

Система управления аутентификационными данными сервисных аккаунтов или учетных записей |

||

Браузер |

Да |

Яндекс Браузер |

19.1.3.281 и выше |

Рекомендовано |

Браузер для входа в UI |

Сервис интеграции и оркестрации микросервисов в облаке |

Да |

Istio |

1.12 и выше |

Опционально. Правообладателем АО «СберТех» также рекомендован компонент Platform V Synapse Service Mesh, см. раздел «Платформенные зависимости» |

ISTIO - это платформа для управления трафиком и обеспечения безопасности микросервисных приложений |

Примечание

*

Да — категория ПО обязательна для функционирования сервиса (это означает, что сервис не может выполнять свои базовые функции без установки данной категории ПО).

Нет — категория ПО необязательна для функционирования сервиса (это означает, что сервис может выполнять свои базовые функции без установки данной категории ПО).

**

Рекомендовано — рекомендованный правообладателем АО «СберТех» продукт.

Опционально — альтернативный по отношению к рекомендованному правообладателем АО «СберТех» продукт.

Платформенные зависимости#

Для настройки, контроля и функционирования компонента реализована интеграция с программными продуктами, правообладателем которых является АО «СберТех»:

Наименование продукта |

Код |

Версия |

Код и наименование компонента |

Обязательность установки (да/нет) |

Описание |

Аналог других производителей |

|---|---|---|---|---|---|---|

Platform V IAM SE |

IAM |

1.8.12 и выше до потери обратной совместимости |

AUTH IAM Proxy |

Нет |

Сервис управления доступом и информационными ресурсами |

СУДИР |

Platform V SberLinux OS Server |

SLO |

9.4.2 и выше до потери обратной совместимости |

INST Операционная система |

Да |

Операционная система на базе ядра Linux для запуска контейнеризированных приложений |

Red Hat Enterprise Linux, ОС Альт 8 СП |

Platform V Corax |

KFK |

10.340.2 и выше до потери обратной совместимости |

KFKA Corax |

Нет |

Программный брокер сообщений, представляющий собой распределенную, отказоустойчивую, реплицированную и легко масштабируемую систему передачи сообщений, рассчитанную на высокую пропускную способность. Данная инсталляция Platform V Corax не входит в состав компонента SRHX, принадлежит провайдеру аудита и необходима для передачи событий аудита. Если нет необходимости в передачи событий провайдеру аудита, то настройка взаимодействия с инсталляцией Platform V Corax не требуется. При необходимости передачи данных из Kafka (Platform V Corax) в компонент Поисковый движок (SRHX) используйте сервис DataPrepper, доступный в дистрибутиве компонента SRHX. |

Kafka |

Platform V DropApp |

K8S |

2.1.0 и выше до потери обратной совместимости |

K8SC K8S Core |

Да |

Дистрибутив Kubernetes со встроенными механизмами мультитенантности и бессерверным исполнением |

Kubernetes |

Platform V Synapse Service Mesh |

SSM |

4.3 и выше до потери обратной совметимости |

IGEG Граничный и сервисный прокси |

Да |

Synapse Service Mesh предназначен для установки и подключения к namespace (проекту) |

Istio |

Примечание

***

Да — компонент или продукт необходим для функционирования сервиса (это означает, что сервис не может выполнять свои основные функции без установки данного компонента).

Нет — необязательный для функционирования сервиса компонент или продукт (это означает, что сервис может выполнять свои основные функции без установки данного компонента).

**** Рекомендуется установка программного продукта, правообладателем которого является АО «СберТех», при этом не исключена возможность (допускается правообладателем) использования аналога других производителей. Аналоги, в отношении которых продукт успешно прошел испытания и подтвердил свою работоспособность, указаны в разделе «Системное программное обеспечение».

Аппаратные требования#

Расчет потребности в физическом оборудовании происходит на основе коэффициентов повторной подписки, применяемых к требованиям по виртуальным ресурсам для каждого из стендов.

Для установки компонента требуется следующая конфигурация аппаратного обеспечения:

Название компонента |

ПО среды функционирования |

Количество |

CPU (кол-во ядер) |

ОЗУ (ГБ) |

Внутренние диски (ГБ) |

Горизонтальное масштабирование |

|---|---|---|---|---|---|---|

SRHX |

x86_vm |

3 node |

16 |

64 |

200 |

Да |

Требования к окружению для установки программного компонента#

Компонент SRHX не выдвигает требований к настройкам безопасности окружения.

Состав дистрибутива#

Элемент дистрибутива |

Описание |

|---|---|

Search-server |

Компонент SRHX, управляемый посредством REST |

Search-dashboard |

Компонент серверной части, отвечающий за аутентификацию |

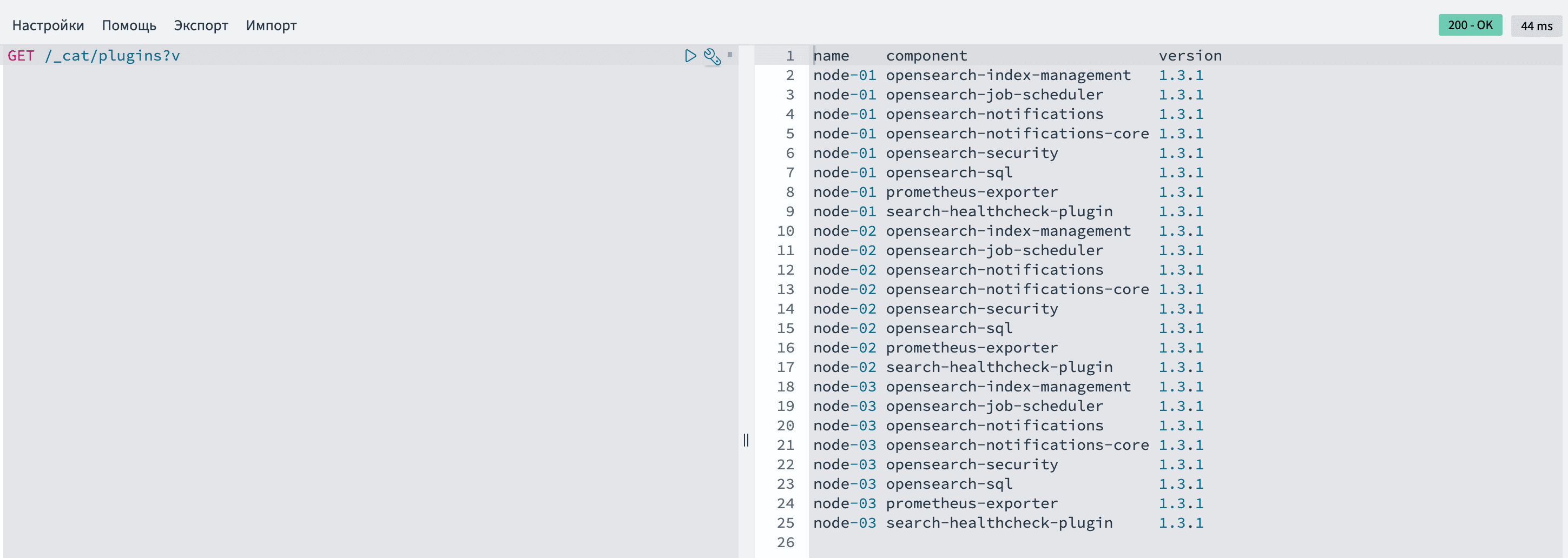

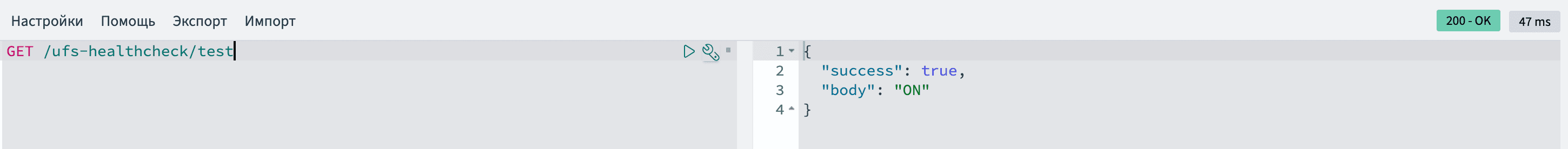

Search-healthcheck |

Проверка работоспособности компонента SRHX |

Search-notifications |

Управление уведомлениями от плагинов компонента SRHX |

Search-security |

Безопасность, шифрование и авторизация компонента SRHX |

Search-index-management |

Автоматизация действия по управлению индексами |

Search-job-scheduler |

Создание расписаний для общих задач, выполняемых в кластере |

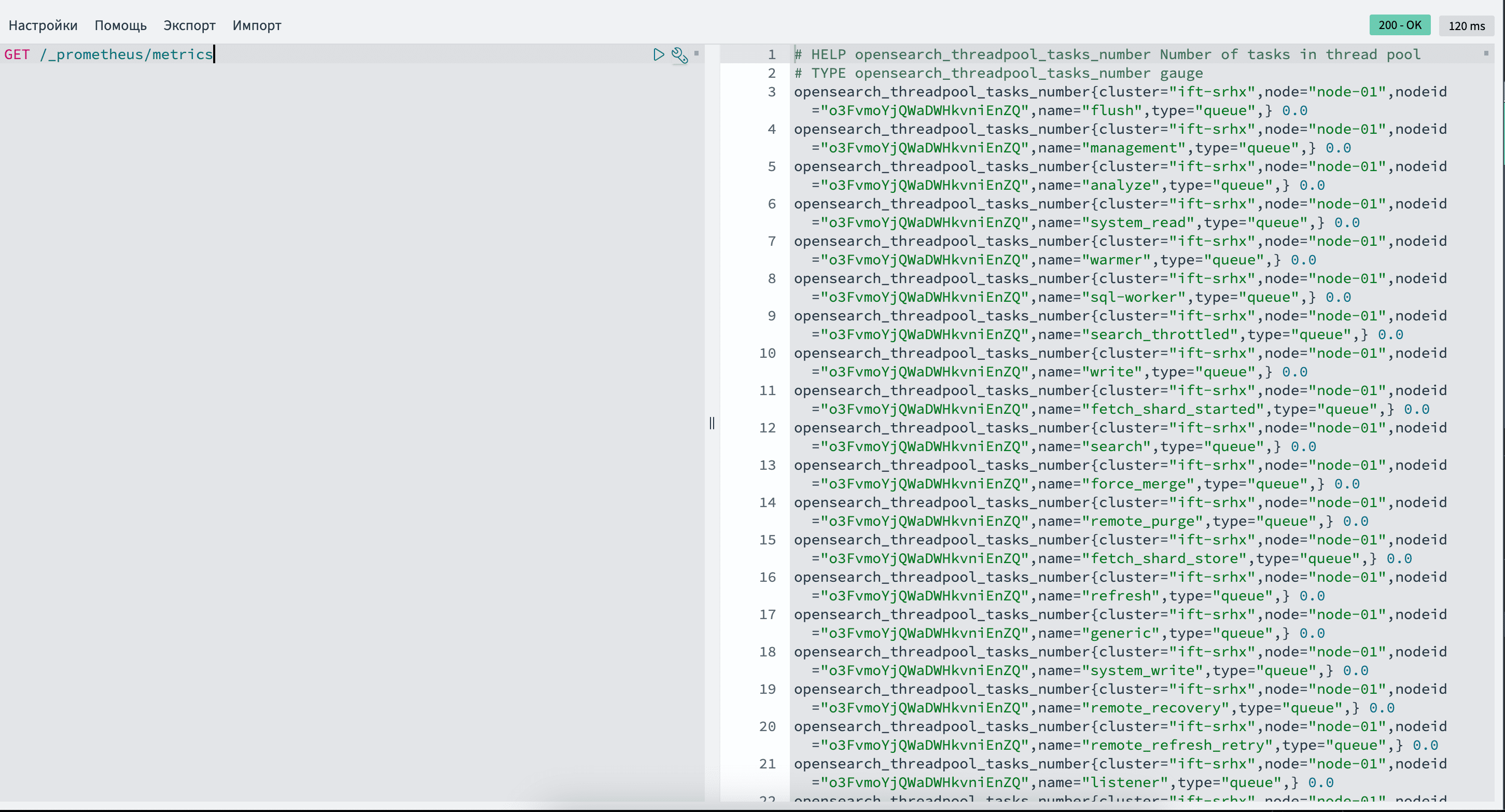

Search-Prometheus-exporter |

Сбор и отправка метрик в формате prometheus |

Search-audit |

Сбор и отправка событий аудита |

Search-sql |

Плагин, позволяющий использовать SQL синтаксис |

Search-queryWorkbenchDashboards |

Плагин, позволяющий использовать SQL синтаксис в Dashboards |

Search-KNN |

Плагин, позволяющий использовать векторный поиск |

Search-custom-codecs |

Плагин добавляет пользовательские кодеки для кодирования индексов на диске |

Выбор способа установки#

Единственным и целевым способом установки является ручной способ.

Подготовка окружения#

Создание пользователей на сервере#

Создайте пользователей:

opensearch – для сервера opensearch;

opensearch-dashboards – для сервера opensearch-dashboards, в том случае, если он будет устанавливаться на данном сервере.

Добавьте созданных пользователей в необходимые группы.

Ниже представлен пример, когда пользователи созданы с таким же паролем, как и их имя. Возможно изменить значения после

passwd -1на необходимые:sudo useradd -p $(openssl passwd -1 opensearch) opensearch sudo useradd -p $(openssl passwd -1 opensearch-dashboards) opensearch-dashboards sudo usermod -aG opensearch-dashboards opensearch sudo usermod -aG opensearch opensearch-dashboards

Установка java#

Установите последнюю доступную в репозитории Java 17. Удалите директорию /usr/share/opensearch/jdk, если существует. Выполните symlink из /etc/alternatives/jre в /usr/share/opensearch/jdk.

ln -s /etc/alternatives/jre /usr/share/opensearch/jdk

Добавление переменных для работы компонента SRHX#

Пропишите системные переменные в файл

.bashrc. Переменные пользователей, под которыми будет выполнен запуск компонента SRHX:

OPENSEARCH_JAVA_HOME;OPENSEARCH_PATH_CONF;OSD_PATH_CONF.

Примените обновленный файл командой

source.Ниже описан алгоритм для пользователей opensearch и opensearch-dashboards:

sudo sh -c "echo -e 'export OPENSEARCH_JAVA_HOME=/usr/share/opensearch/jdk\nexport OPENSEARCH_PATH_CONF=/etc/opensearch\nexport OSD_PATH_CONF=/etc/opensearch-dashboards' >> /home/opensearch/.bashrc && source /home/opensearch/.bashrc" sudo sh -c "echo -e 'export OPENSEARCH_JAVA_HOME=/usr/share/opensearch/jdk\nexport OPENSEARCH_PATH_CONF=/etc/opensearch\nexport OSD_PATH_CONF=/etc/opensearch-dashboards' >> /home/opensearch-dashboards/.bashrc && source /home/opensearch-dashboards/.bashrc"OPENSEARCH_JAVA_HOME – путь до JAVA, который будет использовать компонент SRHX. При использовании JAVA вместе с дистрибутивом, заранее укажите путь, где будет находиться Java, после распаковки дистрибутива.

OPENSEARCH_PATH_CONF и OSD_PATH_CONF – пути до каталога с конфигурационными файлами для сервера opensearch-dashboards.

Изменение параметров компонента SRHX#

Установите значение системных параметров

vm.max_map_count = 262144иvm.swappiness=0в файле/etc/sysctl.conf.Примените обновленные значения командой

sysctl -p.Отключите использование swap:

sudo swapoff -a sudo sh -c "echo -e 'vm.swappiness=0\nvm.max_map_count=262144' >> /etc/sysctl.conf && sysctl -p"

Внимание!

Обязательно проверьте значения в данном файле. Если они уже присутствуют, то их необходимо изменить вручную. После применения команды, указанной выше, произойдет дублирование параметров, если они уже существуют. Команда

swapoff -aработает только до перезагрузки.

Проверьте текущее значение или примененные изменения командой:

cat /proc/sys/vm/max_map_count

Изменение лимитов пользователей#

Повысьте лимиты для пользователей, которые будут выполнять запуск компонента SRHX. Это позволит в дальнейшем запускать программы вручную и не получать ошибки от компонента SRHX.

Создайте файлы

/etc/security/limits.d/opensearch.confи/etc/security/limits.d/opensearch-dashboards.confи внесите в них данные, используя следующие команды:#для создания файлов /etc/security/limits.d/opensearch.conf , /etc/security/limits.d/opensearch-dashboards.conf и установки лимитов SRHX sudo sh -c "echo -e 'opensearch - nproc 65535\nopensearch - nofile 500000\nopensearch - memlock unlimited' >> /etc/security/limits.d/opensearch.conf" sudo sh -c "echo -e 'opensearch-dashboards - nproc 8096\nopensearch-dashboards - nofile 8096' >> /etc/security/limits.d/opensearch-dashboards.conf"После исполнения команд файлы должны иметь вид:

#для /etc/security/limits.d/opensearch.conf opensearch - nofile 500000 opensearch - nproc 65535 opensearch - memlock unlimited #для /etc/security/limits.d/opensearch-dashboards.conf opensearch-dashboards - nofile 8096 opensearch-dashboards - nproc 8096Проверьте, что параметр для пользователя задан верно и его значение равно установленному в предыдущем пункте. Проверка возможна только под пользователем, для которого применяли значение:

sudo su opensearch -c 'ulimit -u -n -l' sudo su opensearch-dashboards -c 'ulimit -u -n'Посмотрите полный список лимитов:

sudo su opensearch -c 'ulimit -a' sudo su opensearch-dashboards -c 'ulimit -a'

Создание необходимых директорий#

Создайте необходимые директории для распаковки дистрибутива:

sudo mkdir /usr/share/opensearch \

sudo mkdir -p /etc/opensearch/secman/certs \

sudo mkdir /etc/opensearch/usertoken \

sudo mkdir /var/log/opensearch \

sudo mkdir /var/lib/opensearch

#если на данную виртуальную машину устанавливается opensearch-dashboards

sudo mkdir /usr/share/opensearch-dashboards \

sudo mkdir -p /etc/opensearch-dashboards/secman/certs \

sudo mkdir /etc/opensearch-dashboards/usertoken \

sudo mkdir /var/log/opensearch-dashboards

Подробное описание директорий

Название |

Описание |

|---|---|

/usr/share/opensearch |

Директория, куда будет установлен компонент SRHX |

/etc/opensearch |

Директория, где будут размещены конфигурационные файлы компонента SRHX |

/var/log/opensearch |

Директория для хранения логов компонента SRHX, которую нужно указать в настройках |

/var/lib/opensearch |

Директория для данных кластера, которую нужно указать в настройках |

/etc/opensearch/secman/certs |

Директория, где будут храниться зашифрованные JKS-архивы с сертификатами, получаемые из Secret Management System |

/etc/opensearch/usertoken |

Директория для перекладки wrapped-токена компонента SRHX |

/usr/share/opensearch-dashboards |

Директория, куда будет установлен |

/etc/opensearch-dashboards |

Директория, где будут размещены конфигурационные файлы |

/var/log/opensearch-dashboards |

Директория для хранения логов |

/etc/opensearch-dashboards/secman/certs |

Директория, где будут храниться зашифрованные JKS-архивы с сертификатами Dashboards, получаемые из Secret Management System |

/etc/opensearch-dashboards/usertoken |

Директория для перекладки wrapped-токена Dashboards |

Создайте пустые файлы для переменных компонента SRHX, которые он считывает при запуске. Ссылаться на эти файлы нужно в Unit service:

sudo touch /etc/sysconfig/opensearch

#если на данную виртуальную машину устанавливается opensearch-dashboards

sudo touch /etc/sysconfig/opensearch-dashboards

Повышение привилегий пользователя#

Выдайте права пользователю opensearch на управление unit-сервисом, который будет создан далее.

Примечание

Это может понадобиться только для удобства работы под пользователем

opensearch.

sudo nano /etc/sudoers.d/opensearch

Добавьте:

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl start opensearch.service, /bin/systemctl start opensearch

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl restart opensearch.service, /bin/systemctl restart opensearch

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl stop opensearch.service, /bin/systemctl stop opensearch

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl enable opensearch.service, /bin/systemctl enable opensearch

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl disable opensearch.service, /bin/systemctl disable opensearch

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl start opensearch-dashboards.service, /bin/systemctl start opensearch-dashboards

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl restart opensearch-dashboards.service, /bin/systemctl restart opensearch-dashboards

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl stop opensearch-dashboards.service, /bin/systemctl stop opensearch-dashboards

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl enable opensearch-dashboards.service, /bin/systemctl enable opensearch-dashboards

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl disable opensearch-dashboards.service, /bin/systemctl disable opensearch-dashboards

opensearch ALL=(ALL) NOPASSWD: /bin/systemctl daemon-reload

Необходимый софт на сервере#

Внимание!

Установить:

node.js – требуется для работы и запуска dashboards; unzip (если не установлен по умолчанию в системе); nano (или любой другой редактор текста).

Установка#

Ручная установка сервиса#

Перед началом установки убедитесь, что выполнена подготовка окружения.

Распаковка дистрибутива#

Внимание!

Название и версии дистрибутива будут различаться, внимательно проверьте и укажите необходимые.

Загрузите полученный дистрибутив на сервер, распакуйте его и перейдите в созданную директорию:

unzip srhx-1.5.0-*-distrib.zip -d /tmp && cd /tmp/srhx/Выполните следующие команды из директории, где находятся распакованные файлы.

[user@vm-name srhx]$ pwd /tmp/srhx/ [user@vm-name srhx]$ ls -l -rw-r--r-- 1 user root 327821009 Mar 5 20:54 dashboard-1.5.0.zip -rw-r--r-- 1 root root 2045982 Mar 5 20:47 index-management-dashboards-1.5.0.zip -rw-r--r-- 1 root root 756487 Mar 5 20:45 notifications-dashboards-1.5.0.zip -rw-r--r-- 1 root root 14842422 Mar 5 21:54 opensearch-index-management-1.5.0.zip -rw-r--r-- 1 root root 9198790 Mar 5 22:04 opensearch-job-scheduler-1.5.0.zip -rw-r--r-- 1 root root 4919467 Mar 5 21:59 opensearch-notifications-1.5.0.zip -rw-r--r-- 1 root root 10896680 Mar 5 21:59 opensearch-notifications-core-1.5.0.zip -rw-r--r-- 1 root root 101699727 Mar 5 21:40 opensearch-security-1.5.0.zip -rw-r--r-- 1 root root 44754603 Mar 5 22:11 opensearch-sql-1.5.0.zip -rw-r--r-- 1 root root 44754603 Mar 5 22:11 opensearch-knn-1.5.0.zip -rw-r--r-- 1 root root 150311 Mar 5 22:07 prometheus-exporter-1.5.0.zip -rw-r--r-- 1 root root 2700708 Mar 5 20:47 queryWorkbenchDashboards-1.5.0.zip -rw-r--r-- 1 root root 7771 Mar 5 21:50 search-healthcheck-plugin-1.5.0.zip -rw-r--r-- 1 root root 232892620 Mar 5 20:29 search-server-1.5.0.zip -rw-r--r-- 1 root root 1170157 Mar 5 20:44 security-dashboards-1.5.0.zip -rw-r--r-- 1 root root 1170157 Mar 5 20:44 opensearch-custom-codecs-1.5.0.zip

Краткое описание распакованных компонентов

Название компонента |

Описание |

|---|---|

search-server-1.5.0 |

Дистрибутив компонента Поисковый движок SRHX |

opensearch-security-1.5.0 |

Плагин безопасности для компонента Поисковой движок SRHX, содержащий в себе плагин audit |

Дополнительные плагины для компонента Поисковый движок (SRHX) |

opensearch-index-management-1.5.0, |

dashboard-1.5.0 |

UI для компонента Поисковый движок (SRHX) |

security-dashboards-1.5.0 |

Плагин безопасности для Dashboards |

Дополнительные плагины для Dashboards |

index-management-dashboards-1.5.0, |

Установка компонента SRHX#

Выполните команды для распаковки дистрибутива:

sudo unzip -q ./search-server-*.zip -d /usr/share/opensearch/

sudo mv /usr/share/opensearch/config/* /etc/opensearch/ && sudo rm -rf /usr/share/opensearch/config/

sudo sh -c "echo -e 'path.data: /var/lib/opensearch\npath.logs: /var/log/opensearch' >> /etc/opensearch/opensearch.yml"

sudo mv opensearch-security-*.zip opensearch-sql-*.zip opensearch-index-management-*.zip opensearch-job-scheduler-*.zip opensearch-notifications-*.zip opensearch-notifications-core-*.zip prometheus-exporter-*.zip search-healthcheck-plugin-*.zip opensearch-knn-*.zip opensearch-custom-codecs-*.zip /usr/share/opensearch/

Описание общего списка команд#

Распакуйте сервер в директорию

/usr/share/opensearch:sudo unzip -q ./search-server-1.5.0.zip -d /usr/share/opensearch/Переместите конфигурационные файлы из

/usr/share/opensearch/configв заранее созданную директорию, для конфигурационных файлов компонента Поискового движка SRHX –/etc/opensearchи удалите пустую директорию/usr/share/opensearch/config:sudo mv /usr/share/opensearch/config/* /etc/opensearch/ && sudo rm -rf /usr/share/opensearch/config/Укажите директории в конфигурационном файле OpenSearch, где он будет хранить данные кластера (path.data) и логи (path.logs). В примере ниже данные кластера будут храниться по пути

/var/lib/opensearch, а логи в/var/log/opensearch, если требуется изменить места хранения, то укажите корректные директории в командах ниже.sudo sh -c "echo -e 'path.data: /var/lib/opensearch\npath.logs: /var/log/opensearch' >> /etc/opensearch/opensearch.yml"Переместите плагины в домашнюю директорию компонента Поисковый движок (SRHX):

sudo mv \ opensearch-sql-*.zip \ opensearch-security-*.zip \ opensearch-index-management-*.zip \ opensearch-job-scheduler-*.zip \ opensearch-notifications-core-*.zip \ opensearch-notifications-*.zip \ prometheus-exporter-*.zip \ opensearch-knn-*.zip \ search-healthcheck-plugin-*.zip \ opensearch-custom-codecs-*.zip \ /usr/share/opensearch/

Установка Dashboards#

Примечание

Dashboards используется один на весь кластер. Не устанавливайте Dashboards на каждый сервер, где стоит компонент Поисковый движок SRHX.

Внимание!

Используйте команды ниже, только если требуется установить Dashboards на сервер, с которым работаете в данный момент.

Общий список выполняемых команд для распаковки дистрибутива:

sudo unzip -q ./dashboards-*.zip -d /usr/share/opensearch-dashboards/

sudo mv security-dashboards-*.zip queryWorkbenchDashboards-*.zip index-management-dashboards-*.zip notifications-dashboards-*.zip /usr/share/opensearch-dashboards/

sudo mv /usr/share/opensearch-dashboards/config/* /etc/opensearch-dashboards/ && sudo rm -rf /usr/share/opensearch-dashboards/config/

Описание общего списка команд выше#

Распакуйте сервер в директорию

/usr/share/opensearch-dashboards:sudo unzip -q ./dashboards-1.5.0.zip -d /usr/share/opensearch-dashboards/Переместите плагины для opensearch-dashboards к нему в домашнюю директорию:

sudo mv security-dashboards-1.5.0.zip queryWorkbenchDashboards-1.5.0.zip index-management-dashboards-1.5.0.zip notifications-dashboards-1.5.0.zip /usr/share/opensearch-dashboards/Переместите конфигурационные файлы

/usr/share/opensearch-dashboards/configв заранее созданную директорию для конфигурационных файлов компонента Поискового движка SRHX -/etc/opensearch-dashboardsи удалите пустую директорию/usr/share/opensearch-dashboards/config:sudo mv /usr/share/opensearch-dashboards/config/* /etc/opensearch-dashboards/ && sudo rm -rf /usr/share/opensearch-dashboards/config/

Установка прав. Наделение правами владельца#

После распаковки измените владельцев директорий и выставите необходимые права.

sudo chown -R opensearch:opensearch /usr/share/opensearch

sudo chown -R opensearch:opensearch /var/log/opensearch

sudo chown -R opensearch:opensearch /var/lib/opensearch

sudo chown -R opensearch:opensearch /etc/opensearch

sudo chown opensearch:opensearch /etc/sysconfig/opensearch

sudo chown -R opensearch-dashboards:opensearch-dashboards /usr/share/opensearch-dashboards

sudo chown -R opensearch-dashboards:opensearch-dashboards /var/log/opensearch-dashboards

sudo chown -R opensearch-dashboards:opensearch-dashboards /etc/opensearch-dashboards

sudo chown opensearch-dashboards:opensearch-dashboards /etc/sysconfig/opensearch-dashboards

sudo chmod 740 /var/lib/opensearch

sudo chmod 750 /usr/share/opensearch

sudo chmod 750 /usr/share/opensearch/logs

sudo chmod 750 -R /usr/share/opensearch/bin

sudo chmod 750 -R /usr/share/opensearch/plugins

sudo chmod 750 -R /var/log/opensearch

sudo chmod 750 /etc/opensearch

sudo chmod 0700 -R /etc/opensearch/secman

sudo chmod 770 -R /etc/opensearch/usertoken

sudo chmod 750 /usr/share/opensearch-dashboards

sudo chmod 750 -R /usr/share/opensearch-dashboards/bin

sudo chmod 750 -R /usr/share/opensearch-dashboards/plugins

sudo chmod 750 -R /var/log/opensearch-dashboards

sudo chmod 750 /etc/opensearch-dashboards

sudo chmod 0700 -R /etc/opensearch-dashboards/secman

sudo chmod 770 -R /etc/opensearch-dashboards/usertoken

Установка плагинов#

Команды по установке плагинов могут быть применены, только в том случае, если валидно заполнен файл opensearch.yml.

Название компонента |

Описание |

|---|---|

search-server-1.5.0 |

Дистрибутив компонента Поисковой движок SRHX |

opensearch-security-1.5.0 |

Плагин безопасности для компонента Поисковой движок SRHX |

Дополнительные плагины для компонента Поисковой движок SRHX |

opensearch-index-management-1.5.0 |

opensearch-job-scheduler-1.5.0 |

|

opensearch-notifications-1.5.0 |

|

opensearch-notifications-core-1.5.0 |

|

prometheus-exporter-1.5.0 |

|

search-healthcheck-plugin-1.5.0 |

|

opensearch-sql-1.5.0 |

|

opensearch-knn-1.5.0 |

|

opensearch-custom-codecs-1.5.0 |

|

dashboard-1.5.0 |

UI для компонента Поисковый движок SRHX |

security-dashboards-1.5.0 |

Плагин безопасности для Dashboards |

Дополнительные плагины для Dashboards |

index-management-dashboards-1.5.0 |

queryWorkbenchDashboards-1.5.0 |

|

notifications-dashboards-1.5.0 |

Установка плагинов от пользователя opensearch на opensearch-server#

При распаковке дистрибутива все плагины перемещены в корневую директорию программы

/usr/share/opensearch/. Далее при установке плагинов будет использоваться указанный путь.Если плагины находятся в другом месте, укажите полный путь до них и проверьте, имеется ли доступ туда у пользователя opensearch.

Внимание!

Установку плагинов выполните от пользователя, под которым запускается компонент SRHX. Для компонента Поисковый движок (SRHX) используйте пользователя –

opensearch.(Не устанавливайте плагины из-под root!)Название и версии плагинов могу различаться, внимательно проверьте и укажите необходимые.

sudo su - opensearch -c 'yes | /usr/share/opensearch/bin/opensearch-plugin install \ file:///usr/share/opensearch/opensearch-knn-1.5.0.zip \ file:///usr/share/opensearch/opensearch-custom-codecs-1.5.0.zip \ file:///usr/share/opensearch/opensearch-sql-1.5.0.zip \ file:///usr/share/opensearch/opensearch-security-1.5.0.zip \ file:///usr/share/opensearch/opensearch-job-scheduler-1.5.0.zip \ file:///usr/share/opensearch/opensearch-index-management-1.5.0.zip \ file:///usr/share/opensearch/opensearch-notifications-core-1.5.0.zip \ file:///usr/share/opensearch/opensearch-notifications-1.5.0.zip \ file:///usr/share/opensearch/search-healthcheck-plugin-1.5.0.zip \ file:///usr/share/opensearch/prometheus-exporter-1.5.0.zip'Возможна установка плагинов по одиночке:

sudo su - opensearch -c 'yes | /usr/share/opensearch/bin/opensearch-plugin install file:///usr/share/opensearch/opensearch-security-1.5.0.zip'После установки плагина безопасности появятся скрипты:

securityadmin.sh;

hash.sh;

audit_config_migrater.sh,

которые находятся по пути /usr/share/opensearch/plugins/opensearch-security/tools. Необходимо сделать их исполняемыми.

sudo chmod +x \

/usr/share/opensearch/plugins/opensearch-security/tools/securityadmin.sh \

/usr/share/opensearch/plugins/opensearch-security/tools/hash.sh \

/usr/share/opensearch/plugins/opensearch-security/tools/audit_config_migrater.sh

После установки плагина безопасности потребуется настройка шифрования. Для тестового запуска можно временно отключить плагин безопасности и проверить работоспособность программы. Для этого в файл

/etc/opensearch/opensearch.ymlдобавьте строкуplugins.security.disabled: true.sudo sh -c "echo -e 'plugins.security.disabled: true' >> /etc/opensearch/opensearch.yml"

Установка плагинов от пользователя opensearch-dashboards на opensearch-dashboards#

При распаковке дистрибутива все плагины перемещены в корневую директорию программы

usr/share/opensearch-dashboards/. Далее при установке плагинов будет использоваться указанный путь.Если плагины находятся в другом месте, укажите полный путь до них и проверьте, имеется ли доступ туда у пользователя opensearch-dashboards.

Внимание!

Установку плагинов выполните от пользователя, под которым запускается компонент SRHX. Для компонента Поисковый движок (SRHX) используйте пользователя –

opensearch-dashboards.(Не устанавливайте плагины из-под root!)Название и версии плагинов могу различаться, внимательно проверьте и укажите необходимые.

sudo su - opensearch-dashboards -c 'yes | /usr/share/opensearch-dashboards/bin/opensearch-dashboards-plugin install file:///usr/share/opensearch-dashboards/security-dashboards-1.5.0.zip' sudo su - opensearch-dashboards -c 'yes | /usr/share/opensearch-dashboards/bin/opensearch-dashboards-plugin install file:///usr/share/opensearch-dashboards/notifications-dashboards-1.5.0.zip' sudo su - opensearch-dashboards -c 'yes | /usr/share/opensearch-dashboards/bin/opensearch-dashboards-plugin install file:///usr/share/opensearch-dashboards/index-management-dashboards-1.5.0.zip' sudo su - opensearch-dashboards -c 'yes | /usr/share/opensearch-dashboards/bin/opensearch-dashboards-plugin install file:///usr/share/opensearch-dashboards/queryWorkbenchDashboards-1.5.0.zip'

Создание Unit services и их запуск#

Убедитесь, что все пути указаны корректно.

Создайте точки монтирования в RAM для Server:

sudo nano /etc/systemd/system/etc-opensearch-secman-secrets.mountДобавьте:

[Unit] Description=Mount /etc/opensearch/secman/secrets DefaultDependencies=no Before=shutdown.target reboot.target halt.target [Mount] What=tmpfs Where=/etc/opensearch/secman/secrets Type=tmpfs Options=mode=0700,uid=opensearch,gid=opensearch,size=100m ForceUnmount=true [Install] WantedBy=multi-user.target shutdown.target reboot.target halt.targetСоздайте точки монтирования в RAM для Dashboards:

sudo nano /etc/systemd/system/etc-opensearch\\x2ddashboards-secman-secrets.mountДобавьте:

[Unit] Description=Mount /etc/opensearch-dashboards/secman/secrets DefaultDependencies=no Before=shutdown.target reboot.target halt.target [Mount] What=tmpfs Where=/etc/opensearch-dashboards/secman/secrets Type=tmpfs Options=mode=0700,uid=opensearch-dashboards,gid=opensearch-dashboards,size=100m ForceUnmount=true [Install] WantedBy=multi-user.target shutdown.target reboot.target halt.targetСоздайте Unit services для Server:

sudo nano /etc/systemd/system/opensearch.serviceДобавьте:

[Unit] Description=Platform V Search Wants=network-online.target After=network-online.target etc-opensearch-secman-secrets.mount [Service] Type=forking RuntimeDirectory=opensearch PrivateTmp=true Environment=MAX_LOCKED_MEMORY=unlimited Environment=OPENSEARCH_PATH_CONF=/etc/opensearch EnvironmentFile=-/etc/sysconfig/opensearch Environment=PID_DIR=/var/run/opensearch Environment=KNN_LIB_DIR=/usr/share/opensearch/plugins/opensearch-knn/lib Environment=LD_LIBRARY_PATH=/usr/java/packages/lib:/usr/lib64:/lib64:/lib:/usr/lib:/usr/share/opensearch/plugins/opensearch-knn/lib WorkingDirectory=/usr/share/opensearch ExecStartPre=/usr/share/opensearch/bin/init_script.sh ExecStart=/usr/share/opensearch/bin/opensearch -d -p ${PID_DIR}/opensearch.pid ExecStopPost=/usr/share/opensearch/bin/saving-secman-data.sh User=opensearch Group=opensearch StandardOutput=journal StandardError=inherit # Service restart - 5 times with an interval of 30 seconds for 200 seconds Restart=on-failure RestartSec=30 StartLimitInterval=200 StartLimitBurst=5 # Unlimited memory lock for service LimitMEMLOCK=infinity # Specifies the maximum file descriptor number that can be opened by this process LimitNOFILE=65535 # Specifies the maximum number of processes LimitNPROC=4096 # Specifies the maximum size of virtual memory LimitAS=infinity # Specifies the maximum file size LimitFSIZE=infinity # Disable timeout logic and wait until process is stopped TimeoutStopSec=0 # SIGTERM signal is used to stop the Java process KillSignal=SIGTERM # Send the signal only to the JVM rather than its control group KillMode=process # Java process is never killed SendSIGKILL=no # When a JVM receives a SIGTERM signal it exits with code 143 SuccessExitStatus=143 # Allow a slow startup before the systemd notifier module kicks in to extend the timeout TimeoutStartSec=75 [Install] WantedBy=multi-user.targetСоздайте Unit services для Dashboards (Если на данном сервере установлен opensearch-dashboards):

sudo nano /etc/systemd/system/opensearch-dashboards.serviceДобавьте

[Unit] Description=Platform V Search Dashboard Wants=network-online.target After=network-online.target etc-opensearch\\x2ddashboards-secman-secrets.mount [Service] Type=simple User=opensearch-dashboards Group=opensearch-dashboards Environment=OSD_PATH_CONF=/etc/opensearch-dashboards EnvironmentFile=-/etc/sysconfig/opensearch-dashboards WorkingDirectory=/usr/share/opensearch-dashboards/ ExecStartPre=/usr/share/opensearch-dashboards/bin/init_script.sh ExecStart=/bin/bash -c '/usr/share/opensearch-dashboards/bin/opensearch-dashboards &> /var/log/opensearch-dashboards/stdout.log' ExecStopPost=/usr/share/opensearch-dashboards/bin/saving-dashboards-secman-data.sh StandardOutput=journal StandardError=inherit # Service restart - 5 times with an interval of 30 seconds for 200 seconds Restart=on-failure RestartSec=30 StartLimitInterval=200 StartLimitBurst=5 [Install] WantedBy=multi-user.targetВыполните перезагрузку systemd:

sudo systemctl daemon-reloadДобавьте точку монтирования в автозагрузку и запустите:

sudo systemctl enable etc-opensearch-secman-secrets.mount --now sudo systemctl enable etc-opensearch\\x2ddashboards-secman-secrets.mount --nowДобавьте opensearch-services в автозагрузку и запустите:

sudo systemctl enable opensearch.service --nowДобавьте opensearch-dashboards-services в автозагрузку и запустите:

sudo systemctl enable opensearch-dashboards.service --now

Настройка компонента SRHX#

Настройка параметров в opensearch.yml#

Большинство настроек компонента SRHX описываются в файле /etc/opensearch/opensearch.yml и считываются при запуске.

Внимание!

Для настройки кластера подготовьте два сертификата с разными CN и подписанные одним УЦ. Один сертификат используется для межкластерного шифрования и шифрования HTTP-уровня. Второй, сертификат администратора, для доступа с правами администратора.

Сертификаты администратора — это обычные клиентские сертификаты с повышенными правами внутри компонента SRHX, для выполнения административных задач. Сертификат администратора необходим для изменения конфигурации плагина безопасности с помощью plugins/opensearch-security/tools/securityadmin.sh или REST API. Сертификаты администратора настраиваются в opensearch.yml путем указания их DN:

plugins.security.authcz.admin_dn:

- 'CN=<Common Name вашего сертификата администратора>, OU=<Подразделение организации>, O=<Наименование организации, выдавшей сертификат>, STREET=<Наименование улицы, на которой располагается организация>, L=<Населенный пункт, в котором расположена организация>, ST=<Наименование региона, в котором расположен сертификат>, C=<Наименование страны, в которой расположена организация>'

Сертификаты должны быть в формате PKCS#8.

Замените все содержимое файла (удалите весь текст в существующем фале) /etc/opensearch/opensearch.yml.

### Шаблон безопасной конфигурации сервера.

### Подставьте необходимые значения там, где требуется.

### Символы < > указывают значения, которые требуется заменить. При подстановке необходимых значений символы < > использовать не нужно.

bootstrap.memory_lock: true

# Настройки хоста

network.host: <FQDN или IP текущего хоста>

http.port: `<Необходимо выбрать один любой порт выше 10000 (например:19200 )>`

transport.port: `<Необходимо выбрать один любой порт выше 10000 (например:19301)>`

# Настройки кластера

cluster.name: <ваше имя кластера>

node.name: <ваше имя текущей node>

node.roles:

- cluster_manager

- data

cluster.initial_cluster_manager_nodes:

- <node.name node 1 в кластере>

- <node.name node 2 в кластере>

- <node.name node 3 в кластере>

discovery.seed_hosts:

- <FQDN или IP node 1 в кластере>:<Значение указанное в параметре "transport.port">

- <FQDN или IP node 2 в кластере>:<Значение указанное в параметре "transport.port">

- <FQDN или IP node 3 в кластере>:<Значение указанное в параметре "transport.port">

# Настройки для хранения данных и логов текущей node

path.data: /var/lib/opensearch

path.logs: /var/log/opensearch

# Настройки плагина Security

#############################################################

## Не отключаемые параметры.

plugins.security.disabled: false

plugins.security.secman.enabled: true

plugins.security.ssl.http.enabled: true

plugins.security.ssl.transport.enabled: true

plugins.security.ssl.http:

keystore_filepath: "/etc/opensearch/secman/certs/http.jks"

truststore_filepath: "/etc/opensearch/secman/certs/httptrust.jks"

enabled_protocols: ["TLSv1.2", "TLSv1.3"]

enabled_ciphers: ["TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384", "TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256"]

clientauth_mode: REQUIRE

plugins.security.ssl.transport:

keystore_filepath: "/etc/opensearch/secman/certs/transport.jks"

truststore_filepath: "/etc/opensearch/secman/certs/transport.jks"

enabled_protocols: ["TLSv1.2", "TLSv1.3"]

enabled_ciphers: ["TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384", "TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256"]

enforce_hostname_verification: true

plugins.security.authcz.admin_dn:

- 'CN=<Common Name вашего сертификата администратора>, OU=<Подразделение организации>, O=<Наименование организации, выдавшей сертификат>, STREET=<Наименование улицы, на которой располагается организация>, L=<Населенный пункт, в котором расположена организация>, ST=<Наименование региона, в котором расположен сертификат>, C=<Наименование страны, в которой расположена организация>'

plugins.security.nodes_dn:

- 'CN=<Common Name межкластерного сертификата/Параметр указанный в plugins.security.secman.transport.cn>, OU=<Подразделение организации>, O=<Наименование организации, выдавшей сертификат>, STREET=<Наименование улицы, на которой располагается организация>, L=<Населенный пункт, в котором расположена организация>, ST=<Наименование региона, в котором расположен сертификат>, C=<Наименование страны, в которой расположена организация>'

plugins.security.audit.type: ru.sbt.audit.PlatformVAuditSink

plugins.security.allow_default_init_securityindex: true

plugins.security.restapi.roles_enabled: "all_access"

plugins.security.system_indices:

enabled: true

indices: [".plugins-ml-model", ".plugins-ml-task", ".opendistro-alerting-config", ".opendistro-alerting-alert*", ".opendistro-anomaly-results*", ".opendistro-anomaly-detector*", ".opendistro-anomaly-checkpoints", ".opendistro-anomaly-detection-state", ".opendistro-reports-*", ".opensearch-notifications-*", ".opensearch-notebooks", ".opensearch-observability", ".opendistro-asynchronous-search-response*", ".replication-metadata-store"]

plugins.security.cache.ttl_minutes: 120

## Не отключаемые параметры.

#############################################################

Описание всех параметров указанных в примере opensearch.yml приведены в таблице ниже.

Имя параметра |

Описание |

|---|---|

bootstrap.memory_lock: true |

Позволяет программе блокировать на сервере определенное количество оперативной памяти, которое указано в файле |

network.host: <FQDN или IP текущего хоста> |

Сетевой адрес текущего хоста, на котором будет доступен сервер |

http.port: ХХХХХ |

Порт, на котором будет доступен API сервера. Используется для доступа к серверу по HTTP. По умолчанию 9200 |

transport.port: ХХХХХ |

Порт, на котором будет доступен сервер на транспортном уровне. Используется для связи серверов между собой в кластере. По умолчанию 9300 |

cluster.name: <ваше имя кластера> |

Произвольное имя текущего кластера в котором будет находится данная node |

node.name: <ваше имя текущей node> |

Произвольное имя текущего сервера в кластере |

node.roles: |

Роли данной node в кластере. |

cluster.initial_cluster_manager_nodes: |

Перечисление всех заданных ранее имен node (node.name) в кластере |

discovery.seed_hosts: |

Перечисление адресов и портов всех node, которые будут находится в кластере |

path.data: /var/lib/opensearch |

Директория для хранения данных node |

path.logs: /var/log/opensearch |

Директория для хранения логов node |

plugins.security.disabled: false |

Принудительное включение плагина безопасности |

plugins.security.ssl.http.enabled: true |

Включение шифрования HTTP-уровня |

plugins.security.ssl.http.keystore_filepath: «/etc/opensearch/secman/certs/http.jks» |

Путь к месту хранения сертификатов для HTTP-уровня |

plugins.security.ssl.http.truststore_filepath: «/etc/opensearch/secman/certs/httptrust.jks» |

Путь к месту хранения цепочки сертификатов HTTP-уровня |

plugins.security.ssl.http.enabled_protocols: |

Позволяет использовать только указанные методы шифрования для HTTP-уровня |

plugins.security.ssl.http.enabled_ciphers: |

Позволяет использовать только указанные шифры для HTTP-уровня |

plugins.security.ssl.http.clientauth_mode: REQUIRE |

Режим проверки сертификатов при запросах к серверу, запросы без сертификатов блокируются. По умолчанию OPTIONAL – ожидать сертификаты, но не требовать их |

plugins.security.ssl.transport.enabled: true |

Включение шифрования транспортного уровня |

plugins.security.ssl.transport.keystore_filepath: «/etc/opensearch/secman/certs/transport.jks» |

Путь к месту хранения сертификатов для транспортного уровня |

plugins.security.ssl.transport.truststore_filepath: «/etc/opensearch/secman/certs/transport.jks» |

Путь к месту хранения цепочки сертификатов транспортного уровня |

plugins.security.ssl.transport.extended_key_usage_enabled:false |

Параметр, отвечающий за работу отдельно с клиентским и серверным сертификатом на транспортном уровне взаимодействия |

plugins.security.ssl.transport.enabled_protocols: |

Позволяет использовать только указанные методы шифрования для транспортного уровня |

plugins.security.ssl.transport.enabled_ciphers: |

Позволяет использовать только указанные шифры для транспортного уровня |

plugins.security.ssl.transport.enforce_hostname_verification: true |

Проверка имени хоста на транспортном уровне. Необязательный. По умолчанию true |

plugins.security.authcz.admin_dn |

Здесь необходимо указать полный DN сертификата, который будет использоваться для доступа с правами полного администратора. В основном используется для применения изменений методов аутентификации/авторизации и ролевой модели, указывается при вызове скрипта securityadmin.sh. Должен состоять из CN, OU, O, STREET, L, ST, C. |

plugins.security.nodes_dn |

Здесь необходимо указать полный DN сертификата, который будет использоваться для межкластерного шифрования между node и доступа к API сервера. Все REST запросы необходимо осуществлять с данными сертификатами. Должен состоять из CN, OU, O, STREET, L, ST, C. |

plugins.security.audit.type: internal_opensearch |

Метод хранения данных аудита. |

plugins.security.audit.config.disabled_rest_categories: NONE |

Принудительно включить запись всех событий HTTP-уровня в журнал аудита |

plugins.security.audit.config.disabled_transport_categories: NONE |

Принудительно включить запись всех событий транспортного уровня в журнал аудита |

plugins.security.allow_default_init_securityindex: true |

Позволяет инициализировать системные индексы, если они не были созданы |

plugins.security.restapi.roles_enabled: |

Имя роли, которая может осуществлять системные вызовы через REST-запросы к API сервера. |

plugins.security.system_indices.enabled: true |

Включить защиту системных индексов указанных в следующем параметре |

plugins.security.system_indices.indices: |

Доступ к данным индексам будет ограничен |

plugins.security.cache.ttl_minutes: 120 |

Время хранения данных кеша пользователей в минутах. При использовании внешних систем аутентификации/авторизации необходимо установить |

plugins.security.secman.enabled: true |

Включение интеграции с Secret Management System |

Настройка JVM Heap Size параметров#

Для быстрой и стабильной работы рекомендуется выделять компоненту SRHX 50 процентов оперативной памяти сервера.

Для этого:

Unit services компонента SRHX в Linux должен содержать параметры:

Environment=MAX_LOCKED_MEMORY=unlimitedиLimitMEMLOCK=infinity(прописывается при создании unit service). В лимитах для пользователяopensearch– должен быть установлен параметрopensearch - memlock unlimited(описано в разделе Изменение лимитов пользователей данного документа).В

opensearch.ymlдолжен быть прописан параметрbootstrap.memory_lock:со значениемtrue.

Укажите нужное значение в параметрах Java. Для этого откройте файл /etc/opensearch/jvm.options, найдите параметры -Xms и -Xmx и укажите значение в гигабайтах, равное половине оперативной памяти текущего сервера, но не более 32766 Мб.

Узнайте размер оперативной памяти на текущем сервере с помощью команды:

free -g | grep Mem: | awk '{print $2}' 23Отредактируйте параметры в файле с настройками JVM и укажите округленные значения, равные половине числа, полученного в предыдущей команде.

sudo nano /etc/opensearch/jvm.options # JVM configuration ################################################################ ## IMPORTANT: JVM heap size ################################################################ # Xms represents the initial size of total heap space # Xmx represents the maximum size of total heap space -Xms11g -Xmx11g

Добавление параметров в opensearch-keystore#

Внимание!

Выполнение данного пункта для компонента Поисковый движок (SRHX) требуется для обеспечения работы при недоступности Secret Management System. Обратите внимание, что Dashboards имеет свой собственный Keystore –

opensearch-dashboards-keystore. Его настройка отличается и описана в пункте Добавление параметров в opensearch-dashboards-keystore.

Создайте keystore с помощью параметра create.

#создайте хранилище, если оно еще не существует

sudo su - opensearch -c '/usr/share/opensearch/bin/opensearch-keystore create'

Внимание!

opensearch-keystore будет создан для пользователя linux, от которого будут запускаться команды. Не выполняйте команды из под

root! Используйте для этого пользователяopensearch.

Opensearch-keystore используется для сохранения сертификатов на случай недоступности Secret Management System и для сокрытия чувствительных данных (например логин/пароль) в компоненте Поисковый движок (SRHX). Хранение логина и пароля выполняется в opensearch.yml.

Список часто используемых параметров

Параметр |

Описание |

|---|---|

help |

Список доступных команд |

create |

Создание нового keystore хранилища (дополнительный параметр -p позволит создать keystore, защищенный паролем) |

add |

Добавление нового параметра в созданный keystore |

list |

Просмотр параметров, которые хранятся в данный момент в keystore |

remove |

Удалить существующий параметр из текущего keystore |

Настройка параметров в opensearch_dashboards.yml#

Большинство настроек компонента SRHX описываются в файле /etc/opensearch-dashboards/opensearch_dashboards.yml и считываются при запуске компонента SRHX.

Внимание!

Должны быть подготовлены сертификаты для межкластерного шифрования и шифрования HTTP-уровня. Здесь используются те же сертификаты, которые были установлены ранее.

Замените все содержимое файла (удалите весь текст в существующем файле) /etc/opensearch-dashboards/opensearch_dashboards.yml текстом указанным в готовом образце opensearch_dashboards.yml, изменив значения на необходимые.

Готовый образец opensearch_dashboards.yml

### Шаблон безопасной конфигурации dashboards.

### Подставьте необходимые значения там, где требуется.

### Символы < > указывают значения, которые требуется заменить. При подстановке необходимых значений символы < > использовать не нужно.

# Настройки для самого dashboards

server.host: "<FQDN или IP текущего хоста>"

server.port: 15601

server.ssl.enabled: true

server.ssl.keystore.path: /etc/opensearch-dashboards/secman/certs/http.p12

server.ssl.truststore.path: /etc/opensearch-dashboards/secman/certs/trust.p12

# Настройки для соединения dashboards с сервером OpenSearch

opensearch.hosts:

- https://<FQDN или IP node 1 в кластере>:ХХХХХ

- https://<FQDN или IP node 2 в кластере>:ХХХХХ

- https://<FQDN или IP node 3 в кластере>:ХХХХХ

opensearch.ssl.alwaysPresentCertificate: true

opensearch.ssl.verificationMode: full

opensearch.ssl.keystore.path: /etc/opensearch-dashboards/secman/certs/transport.p12

opensearch.ssl.truststore.path: /etc/opensearch-dashboards/secman/certs/trust.p12

opensearch.requestHeadersAllowlist:

- authorization

- securitytenant

# Настройки логирования

logging.dest: /var/log/opensearch-dashboards/opensearch-dashboards.log

logging.json: false

logging.verbose: true

# Настройки плагина Security

opensearch_security.auth.type: "basicauth"

opensearch_security.cookie.secure: true

opensearch_security.session.keepalive: true

# Указанны значения в миллисекундах

opensearch_security.cookie.ttl: 86400000

opensearch_security.session.ttl: 1200000

i18n.locale: "ru"

secman.enabled: true

#Настройка метрик в Dashboards

prometheus.metrics.job_name: opensearch_dashboards

prometheus.metrics.path: _prometheus/metrics

Описание всех параметров указанных в примере opensearch_dashboards.yml представлено в таблице ниже.

Имя параметра |

Описание |

|---|---|

server.host: <FQDN или IP текущего хоста> |

Сетевой адрес текущего хоста, на котором будет доступен сервер |

server.port: 15601 |

Порт, на котором будет доступен API сервера. Используется для доступа к серверу по HTTP. По умолчанию 5601 |

server.ssl.enabled: true |

Включить HTTP шифрование |

server.ssl.keystore.path: /etc/opensearch-dashboards/secman/certs/http.p12 |

Путь к сертификату для HTTP-уровня. |

server.ssl.truststore.path: /etc/opensearch-dashboards/secman/certs/trust.p12 |

Путь к цепочке сертификата HTTP-уровня. |

opensearch.hosts: |

Перечисление адресов и портов всех серверов в кластере. Порт по умолчанию 9200. Вместо ХХХХХ необходимо указать нужный порт |

opensearch.requestHeadersAllowlist: |

Перечисление заголовков, которые сервер будет считывать, при отправке запросов к нему |

opensearch.ssl.alwaysPresentCertificate: true |

Всегда передавать сертификат при запросах к компоненту SRHX |

opensearch.ssl.verificationMode: full |

Тип проверки при аутентификации соединения с сервером. |

opensearch.ssl.keystore.path: /etc/opensearch-dashboards/secman/certs/transport.p12 |

Путь к сертификату для транспортного уровня. |

opensearch.ssl.truststore.path: /etc/opensearch-dashboards/secman/certs/trust.p12 |

Путь к цепочке сертификата транспортного уровня. |

opensearch_security.auth.type: |

Тип аутентификации. |

opensearch_security.cookie.secure: true |

Шифрование cookies. Необходимо при включении HTTPs |

opensearch_security.session.keepalive: true |

Поддерживать сессию, пока действуют cookies. |

#specified values are in milliseconds |

Время хранения cookies в миллисекундах. Может быть равно 0 для сессии cookie. По умолчанию – 1 час |

opensearch_security.session.ttl: 1200000 |

Время жизни установленной сессии с пользователем. Если установлено, пользователю будет предложено снова войти в систему через заданное время, независимо от файла cookie. По умолчанию: 1 час |

i18n.locale: ru |

Выбранный язык локализации. Необязательный параметр. По умолчанию - en |

secman.enabled: false |

Параметр, отвечающий за активацию интеграции с Secret Management System. Необязательный параметр. По умолчанию - false |

prometheus.metrics.job_name: opensearch_dashboards |

Параметр обозначающий префикс для метрик, котрые откидывает сервис dashboards. В примере метрики будут с префиксом opensearch_dashboards |

prometheus.metrics.path: _prometheus/metrics |

Путь по умолчанию, может быть параметризирован. |

opensearch_security.auth.anonymous_auth_enabled: false |

Включает или отключает анонимную аутентификацию. Анонимный доступ должен быть запрещён! |

Добавление параметров в opensearch-dashboards-keystore#

Для сокрытия чувствительных данных (например логин/пароль) в компоненте SRHX существует opensearch-dashboards-keystore.

Внимание!

Выполнение данного пункта для Dashboards требуется для обеспечения работы при недоступности Secret Management System.

Для работы с opensearch-dashboards-keystore запустите /usr/share/opensearch-dashboards/bin/opensearch-dashboards-keystore <параметр> (--help, чтобы увидеть все доступные параметры).

Список часто используемых параметров

Параметр |

Описание |

|---|---|

create |

Создание нового keystore хранилища (дополнительный параметр -p позволит создать keystore, защищенный паролем) |

add |

Добавление нового параметра в созданный keystore |

list |

Просмотр параметров, которые хранятся в данный момент в keystore |

remove |

Удалить существующий параметр из текущего keystore |

Для продолжения установки добавьте в opensearch-dashboards-keystore логин и пароль для соединения с компонентом SRHX, так же пароли от сертификатов. Это будут параметры:

Параметр |

Описание |

|---|---|

opensearch.username |

Логин пользователя. Должен присутствовать в |

opensearch.password |

Пароль от логина, указанного в предыдущем пункте. Должен присутствовать в |

Создайте keystore с помощью параметра create. Добавьте необходимые параметры при помощи параметра add.

Внимание!

opensearch-dashboards-keystoreбудет создан для пользователя, который будет запускать команды. Не выполняйте команды из-подroot! Используйте для этого пользователяopensearch-dashboards.

#Создайте хранилище, если оно еще не существует

sudo su - opensearch-dashboards -c '/usr/share/opensearch-dashboards/bin/opensearch-dashboards-keystore create'

#После команды будет ожидать ввода данных

sudo su - opensearch-dashboards -c '/usr/share/opensearch-dashboards/bin/opensearch-dashboards-keystore add opensearch.username'

#После команды будет ожидать ввода данных

sudo su - opensearch-dashboards -c '/usr/share/opensearch-dashboards/bin/opensearch-dashboards-keystore add opensearch.password'

На этом настройка сервера может быть завершена. Для первого запуска можно использовать ролевую модель по умолчанию с пользователями из internal_users.yml.

Настройка методов аутентификации/авторизации и ролевой модели#

В разделе приведена информация для ознакомления с возможностями ролевой модели компонента SRHX.

Ролевая модель настраивается в файлах

internal_users.yml,roles.yml,roles_mapping.yml, которые находятся в/etc/opensearch/opensearch-security/.Методы аутентификации настраиваются в файле

config.yml, который находится в/etc/opensearch/opensearch-security/.

При старте компонента SRHX в первый раз подгружаются данные из этих файлов. Поэтому на сервере уже будут стандартные пользователи из этих файлов и метод аутентификации basicauth, который указан в config.yml. Редактирование файлов выполняется при необходимости.

Создание шифрованного пароля для пользователя#

Все пароли в internal_users.yml хранятся в зашифрованном виде. Для шифрования пароля есть скрипт hash.sh.

Запустите скрипт от пользователя

opensearch.sudo su - opensearch -c '/usr/share/opensearch/plugins/opensearch-security/tools/hash.sh'После загрузки скрипта он будет ожидать ввода пароля, который будет зашифрован. В примере используйте пароль

der_parol.************************************************************************** ** This tool will be deprecated in the next major release of OpenSearch ** ************************************************************************** [Password:]После ввода данных и нажатия Enter, получите введенный пароль в зашифрованном виде.

$2y$12$MnTVuoi0Ue.Bbn47Np.xFuPjNcGGrazvgAZDkfSDMzSSd69Y3H6SW

Создание пользователя#

В файл

internal_users.ymlдобавьте блок нового пользователя:sudo nano /etc/opensearch/opensearch-security/internal_users.ymlДобавьте, подставив необходимые данные:

pvs_admin: hash: "$2y$12$MnTVuoi0Ue.Bbn47Np.xFuPjNcGGrazvgAZDkfSDMzSSd69Y3H6SW" reserved: false description: "Demo pvs_admin user, using internal role mapping`

Создание роли#

Создайте роль с возможностями администрирования в файле

roles.yml.sudo nano /etc/opensearch/opensearch-security/roles.ymlДобавьте:

super_administrator: cluster_permissions: - 'cluster:admin/*' - 'cluster:monitor/*' index_permissions: - index_patterns: - '*' allowed_actions: - 'indices:admin/*' - 'indices:data/*' - 'indices:monitor/*

Связывание созданной роли и пользователя#

Присвойте роль созданному пользователю в файле

roles_mapping.yml.sudo nano /etc/opensearch/opensearch-security/roles_mapping.ymlДобавьте:

super_administrator: reserved: false users: - "pvs_admin" description: "Maximum access to everything"

Применение данных к кластеру#

Внимание!

После применения новой конфигурации к кластеру, предыдущие параметры будут перезаписаны без возможности восстановления. Для сохранения текущих параметров используйте опцию

-backup.

После редактирования данных в файлах примените их к кластеру.

Запустите скрипт securityadmin.sh, который находится по пути /usr/share/opensearch/plugins/opensearch-security/tools/securityadmin.sh.

При запуске этого скрипта укажите дополнительные параметры.

Параметры |

Описание |

|---|---|

-backup my-backup-directory |

Необязательно. Создание копии текущих настроек сервера |

-icl |

Игнорировать имя кластера (не использовать вместе с параметром -cn) |

-nhnv |

Отключить проверку имени host’a |

-cd |

Путь до конфигурационных файлов opensearch-security |

-h |

FQDN или IP-адрес хоста для подключения |

-p |

API-Порт подключения |

-cacert |

Путь до корневого сертификата |

-cert |

Путь до сертификата администратора |

-key |

Путь до приватного ключа для сертификата администратора |

-keypass |

Пароль от приватного ключа для сертификата администратора |

Параметры для работы с хранилищем сертификатов p12 или jks. Нельзя использовать вместе с параметрами для обычных сертификатов.

Параметры |

Описание |

|---|---|

-ks |

Путь до keystore с сертификатом администратора |

-kspass |

Пароль от keystore с сертификатом администратора |

-ts |

Путь до keystore с корневым сертификатом администратора |

-tspass |

Пароль от keystore с корневым сертификатом администратора |

Пример запуска скрипта от пользователя opensearch:

sudo su - opensearch -c '/usr/share/opensearch/plugins/opensearch-security/tools/securityadmin.sh \

-icl \

-nhnv \

-cd /etc/opensearch/opensearch-security/ \

-h "<адрес вашего хоста, где запущен компонент SRHX>" \

-p "ХХХХХ" \

-cacert "/etc/opensearch/certs/<имя вашего корневого сертификата>" \

-cert "/etc/opensearch/certs/<имя вашего сертификата администратора>" \

-key "/etc/opensearch/certs/<имя вашего приватного ключа для сертификата администратора>" \

-keypass "<пароль от приватного ключа для сертификата администратора>"'

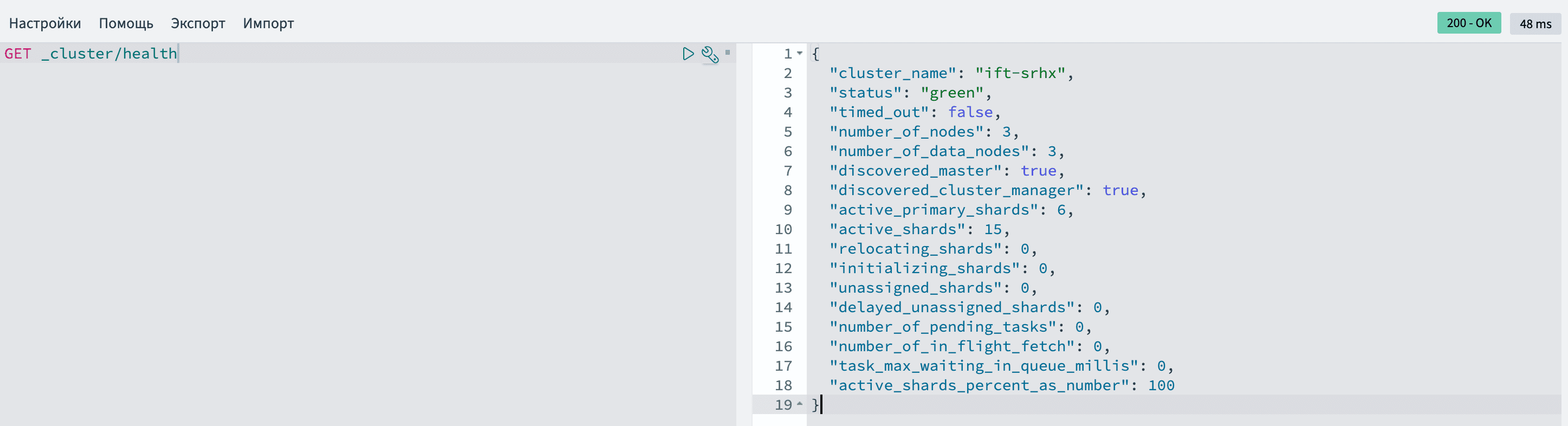

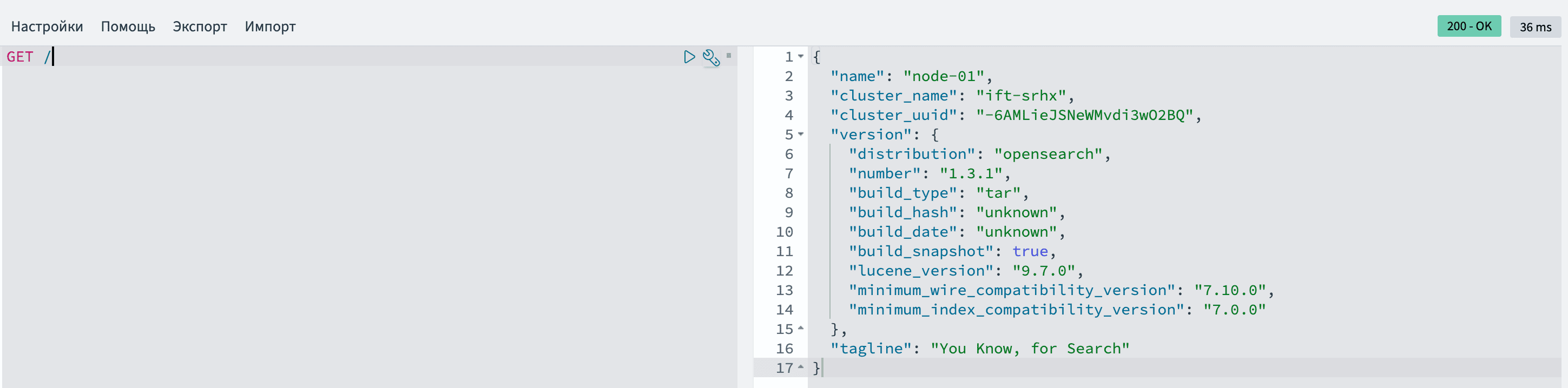

Пример вывода успешного выполнения скрипта. В конце должна быть надпись Done with success

Security Admin v7

Will connect to <адрес вашего хоста, где запущен SRHX>:ХХХХХ ... done

Connected as "CN=<CN вашего админ-сертификата>,O=<имя вашего УЦ>"

OpenSearch Version: 1.5.0

Contacting opensearch cluster 'opensearch' and wait for YELLOW clusterstate ...

Clustername: <название вашего кластера>

Clusterstate: GREEN

Number of nodes: 3

Number of data nodes: 3

.opendistro_security index already exists, so we do not need to create one.

Populate config from /etc/opensearch/opensearch-security/

Will update '/config' with /etc/opensearch/opensearch-security/config.yml

SUCC: Configuration for 'config' created or updated

Will update '/roles' with /etc/opensearch/opensearch-security/roles.yml

SUCC: Configuration for 'roles' created or updated

Will update '/rolesmapping' with /etc/opensearch/opensearch-security/roles_mapping.yml

SUCC: Configuration for 'rolesmapping' created or updated

Will update '/internalusers' with /etc/opensearch/opensearch-security/internal_users.yml

SUCC: Configuration for 'internalusers' created or updated

Will update '/actiongroups' with /etc/opensearch/opensearch-security/action_groups.yml

SUCC: Configuration for 'actiongroups' created or updated

Will update '/tenants' with /etc/opensearch/opensearch-security/tenants.yml

SUCC: Configuration for 'tenants' created or updated

Will update '/nodesdn' with /etc/opensearch/opensearch-security/nodes_dn.yml

SUCC: Configuration for 'nodesdn' created or updated

Will update '/whitelist' with /etc/opensearch/opensearch-security/whitelist.yml

SUCC: Configuration for 'whitelist' created or updated

Will update '/audit' with /etc/opensearch/opensearch-security/audit.yml

SUCC: Configuration for 'audit' created or updated

Will update '/allowlist' with /etc/opensearch/opensearch-security/allowlist.yml

SUCC: Configuration for 'allowlist' created or updated

SUCC: Expected 10 config types for node {"updated_config_types":["allowlist","tenants","rolesmapping","nodesdn","audit","roles","whitelist","internalusers","actiongroups","config"],"updated_config_size":10,"message":null} is 10 (["allowlist","tenants","rolesmapping","nodesdn","audit","roles","whitelist","internalusers","actiongroups","config"]) due to: null

Done with success

Установка Data Prepper#

Сборка Docker образа#

В директории с Data Prepper расположены следующие файлы:

data-prepper-jdk-2.8.0-linux-x64.tar.gz – архив с Data Prepper;

папка config – pipeline.yaml конфигурации по настройке pipeline обработки данных и data-prepper-config.yaml конфигурационный файл настройки сервера;

Dockerfile – файл с описанием образа.

В данной директории соберите Dockerfile.

Ниже представлено описание Dockerfile:

FROM '<path-to-image>'

ARG PIPELINE_FILEPATH=/usr/share/data-prepper/pipelines

ARG CONFIG_FILEPATH=/usr/share/data-prepper/config

ARG ARCHIVE_NAME=opensearch-data-prepper-jdk-2.8.0-SNAPSHOT-linux-x64

ARG ARCHIVE_FILE=$ARCHIVE_NAME.tar.gz

ARG ARCHIVE_FILE_UNPACKED=$ARCHIVE_NAME

ENV DATA_PREPPER_PATH /usr/share/data-prepper

ENV ENV_CONFIG_FILEPATH=$CONFIG_FILEPATH/data-prepper-config.yaml

ENV ENV_PIPELINE_FILEPATH=$PIPELINE_FILEPATH/pipelines.yaml

RUN mkdir -p /var/log/data-prepper

ADD $ARCHIVE_FILE /usr/share

RUN mv /usr/share/$ARCHIVE_FILE_UNPACKED /usr/share/data-prepper

COPY config/data-prepper-config.yaml $ENV_CONFIG_FILEPATH

COPY config/pipeline.yaml $ENV_PIPELINE_FILEPATH

WORKDIR $DATA_PREPPER_PATH

CMD ["bin/data-prepper"]

Соберите образ с помощью команды и укажите тэг с

registry.docker build -t `<path-to-registry>`/data-prepper:latest .Загрузите образ в nexus.

docker push `<path-to-registry>`/data-prepper:latest

После выполнения данных команд будет создан готовый образ Data Prepper.

Пример

pipelines.yaml: |

main-pipeline:

source:

kafka:

encryption:

type: none

bootstrap_servers:

- your-server-host

topics:

- name: dataprepper

group_id: dataprepperGroup

buffer:

bounded_blocking:

buffer_size: 1024

batch_size: 256

processor:

- parse_json:

source: message

- grok:

grok_when: '(/fields != null and /fields != "") and contains(/fields/app_name, "merchant_profile")'

match:

message: [ '\[%{TIMESTAMP_ISO8601:timestamp}\] \[%{LOGLEVEL:level}\s?\] [-] UnPrs \[%{GREEDYDATA:unparsedMerchantName}\] \[%{GREEDYDATA:city}\] \[%{GREEDYDATA:country}\] \[%{GREEDYDATA:merchantId}\] \[%{GREEDYDATA:mccCode}\] \[%{GREEDYDATA:isCategoryParsed}\]' ]

- add_entries:

entries:

- key: "uniqueMerchantNameStat"

value_expression: /unparsedMerchantName

add_when: '/timestamp != null'

- grok:

grok_when: '/timestamp == null'

match:

message: [ '\[%{TIMESTAMP_ISO8601:timestamp}\] \[%{LOGLEVEL:level}\s?\] [-] Prs \[%{GREEDYDATA:parsedMerchantName}\] \[%{GREEDYDATA:city}\] \[%{GREEDYDATA:country}\] \[%{GREEDYDATA:merchantId}\] \[%{GREEDYDATA:mccCode}\] \[%{GREEDYDATA:brandName}\] \[%{GREEDYDATA:logoFilename}\] \[%{GREEDYDATA:address}\] \[%{GREEDYDATA:location}\] \[%{GREEDYDATA:feedbackAllowed}\] \[%{GREEDYDATA:isCategoryLogo}\] \[%{GREEDYDATA:isCategoryParsed}\] \[%{GREEDYDATA:isFullSearchMatched}\]' ]

- add_entries:

entries:

- key: "uniqueMerchantNameStat"

value_expression: /parsedMerchantName

add_when: '/timestamp != null'

- grok:

grok_when: '/timestamp == null'

match:

message: [ '\[%{TIMESTAMP_ISO8601:timestamp}\] \[%{LOGLEVEL:level}\s?\] [-] Prs \[%{GREEDYDATA:parsedMerchantName}\] \[%{GREEDYDATA:city}\] \[%{GREEDYDATA:country}\] \[%{GREEDYDATA:merchantId}\] \[%{GREEDYDATA:mccCode}\] \[%{GREEDYDATA:brandName}\] \[%{GREEDYDATA:logoFilename}\] \[%{GREEDYDATA:isCategoryLogo}\] \[%{GREEDYDATA:isCategoryParsed}\]' ]

- add_entries:

entries:

- key: "uniqueMerchantNameStat"

value_expression: /parsedMerchantName

add_when: '/timestamp != null'

- key: "address"

value_expression: "false"

add_when: '/timestamp != null'

- key: "location"

value: "false"

add_when: '/timestamp != null'

- key: "isFullSearchMatched"

value: "false"

add_when: '/timestamp != null'

- grok:

grok_when: '/timestamp == null'

match:

message: [ '\[%{TIMESTAMP_ISO8601:timestamp}\] \[%{LOGLEVEL:level}\s?\] [-] PrsDup \[%{GREEDYDATA:duplicateMerchantName}\] \[%{GREEDYDATA:city}\] \[%{GREEDYDATA:country}\] \[%{GREEDYDATA:merchantId}\] \[%{GREEDYDATA:mccCode}\] \[%{GREEDYDATA:brandName}\] \[%{GREEDYDATA:logoFilename}\] \[%{GREEDYDATA:isCategoryLogo}\] \[%{GREEDYDATA:isCategoryParsed}\]' ]

- add_entries:

entries:

- key: "parsedMerchantName"

value_expression: /duplicateMerchantName

add_when: '/timestamp != null'

- key: "address"

value: "false"

add_when: '/timestamp != null'

- key: "location"

value: "false"

add_when: '/timestamp != null'

- grok:

grok_when: '/timestamp == null'

match:

message: [ '\[%{TIMESTAMP_ISO8601:timestamp}\] \[%{LOGLEVEL:level}\s?\] [-] PrsDupIn \[%{GREEDYDATA:parsedMerchantName}\] \[%{GREEDYDATA:city}\] \[%{GREEDYDATA:country}\] \[%{GREEDYDATA:merchantId}\] \[%{GREEDYDATA:mccCode}\] \[%{GREEDYDATA:brandName}\] \[%{GREEDYDATA:logoFilename}\] \[%{GREEDYDATA:isCategoryLogo}\] \[%{GREEDYDATA:isCategoryParsed}\]' ]

- add_entries:

entries:

- key: "address"

value: "false"

add_when: '/timestamp != null'

- key: "location"

value: "false"

add_when: '/timestamp != null'

- key: "isFullSearchMatched"

value: "false"

add_when: '/timestamp != null'

route:

- alpha: '/fields/app_name != null and /fields/app_name != ""'

- beta: '/level != null and /level == "INFO"'

sink:

- opensearch:

routes:

- alpha

connection:

insecure: true

hosts: [ "your-opensearch-host-1" ]

index: "logs-${/fields/app_name}-datastream"

username: "{{ search_username }}"

password: "{{ search_password }}"

- opensearch:

routes:

- beta

connection:

insecure: true

hosts: [ "your-opensearch-host-2" ]

index: fallback

username: "{{ search_username }}"

password: "{{ search_password }}"

- stdout:

Deploy приложения в DropApp#

Для deploy приложения понадобится создать 4 манифеста:

Config map для описания конфигурации приложения (data-prepper-config);

Service для приложения (data-prepper-server);

Service для метрик приложения (data-prepper-metrics);

Deployment для описания deploy приложения (data-prepper).

Создайте директорию k8s с помощью команды (выбор пути для создания директории опционален):

mkdir -p /usr/share/k8s

Перейдите в данную директорию:

cd /usr/share/k8s

Создайте в ней файлы, представленные ниже.

Примеры манифестов:

В Config map можно переопределить pipeline.yaml и data-prepper-config.yaml. Config map монтируется в volume в разделе deployment.

Config map для описания конфигурации приложения (cm-data-prepper.yml):

apiVersion: v1

kind: ConfigMap

metadata:

labels:

app: data-prepper

name: data-prepper-config

data:

pipelines.yaml: |

simple-sample-pipeline:

workers: 2 # the number of workers

delay: 5000 # in milliseconds, how long workers wait between read attempts

source:

random:

buffer:

bounded_blocking:

buffer_size: 1024 # max number of records the buffer accepts

batch_size: 256 # max number of records the buffer drains after each read

processor:

- string_converter:

upper_case: true

sink:

- stdout:

data-prepper-config.yaml: |

ssl: false

- Service для приложения (svc-data-prepper-server.yml):

apiVersion: v1

kind: Service

metadata:

labels:

app: data-prepper

name: data-prepper-server

spec:

clusterIP: None

ports:

- name: "21890"

port: 21890

targetPort: 21890

selector:

app: data-prepper

- Service для метрик (svc-data-prepper-metrics.yml):

apiVersion: v1

kind: Service

metadata:

labels:

app: data-prepper

name: data-prepper-metrics

spec:

type: NodePort

ports:

- name: "4900"

port: 4900

targetPort: 4900

selector:

app: data-prepper

- Deployment для приложения (dc-data-prepper.yml)

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: data-prepper

name: data-prepper

spec:

replicas: 1

selector:

matchLabels:

app: data-prepper

strategy:

type: Recreate

template:

metadata:

labels:

app: data-prepper

spec:

containers:

- args:

- bin/data-prepper

- /etc/data-prepper/pipelines.yaml

- /etc/data-prepper/data-prepper-config.yaml

image: `<path-to-registry>`/data-prepper:latest

name: data-prepper

ports:

- containerPort: 2021

resources: {}

volumeMounts:

- mountPath: /etc/data-prepper

name: prepper-configmap-claim0

imagePullSecrets:

- name: nexuscred

restartPolicy: Always

serviceAccountName: ""

volumes:

- name: prepper-configmap-claim0

configMap:

name: data-prepper-config

В директории k8s с манифестами примените команду:

kubectl apply -f .Проверьте корректность deploy.

В namespace в разделе workloads появится pod с data-prepper, в логах контейнера будут указаны сгенерированные сообщения.

Безопасная конфигурация Data Prepper в корпоративной среде#

Чтобы настроить mTLS между DataPrepper и внешними компонентами (далее в качестве примера будут рассмотрены Search и Kafka) выполните следующие действия:

В первую очередь на кластере Kubernetes установите Synapse Service Mesh или Istio.

Далее включите его в namespace, где размещен DataPrepper:

apiVersion: v1 kind: Namespace metadata: name: data-prepper labels: pod-security.kubernetes.io/enforce: restricted istio-injection: enabled istio.io/rev: istio-systemСоздайте секрет для подключения к Kafka, где будут находиться клиентская пара сертификат-ключ и сертификат УЦ:

kind: Secret apiVersion: v1 metadata: name: kafka-secret namespace: data-prepper data: root.crt: <сертификат удостоверяющего центра в base64> tls.crt: <сертификат клиента в base64> tls.key: <ключ клиента в base64> type: OpaqueСоздайте секрет для подключения к Search:

kind: Secret apiVersion: v1 metadata: name: pvs-secret namespace: data-prepper data: root.crt: <сертификат удостоверяющего центра в base64> tls.crt: <сертификат клиента в base64> tls.key: <ключ клиента в base64> type: OpaqueCоздайте экземпляр istio-egressgateway в том же пространстве имен: