Руководство по установке#

В руководстве приведены инструкции по установке компонента «Сбор и анализ метрик» (GATM).

Термины и определения#

Термин/аббревиатура |

Определение |

|---|---|

Платформа |

Платформа оркестрации приложений со средствами автоматизации и управления на основе политик, например, Kubernetes |

Istio SE |

Настраиваемая сервисная сеть с открытым исходным кодом, служащая для обеспечения безопасности контейнеров в кластере Kubernetes |

Pod / «kind: Pod» |

Набор контейнеров внутри узла кластера Kubernetes |

Statefullset / «kind: Statefullset» |

Статистический набор инструкций для запуска приложения в Kubernetes |

Deployment / «kind: Deployment» |

Набор инструкций для запуска приложения в Kubernetes |

Граничный прокси / IGEG / egressgateway |

Компонент Граничный прокси |

Контрольная панель |

Проект, где запущены управляющие приложения Synapse Service Mesh (компонент POLM) |

Делиметр |

Символ,используемый для разделения слов (или частей слов) в наименовании тега метрики |

GATM |

Программный компонент «Сбор и анализ метрик» (GATM) |

KACM |

Компонент «Управление ключами и сертификатами» из состава Synapse Service Mesh, отвечающий за создание и ротацию x509 ключевых пар в среде Kubernetes |

SSM |

Platform V Synapse Service Mesh — программный продукт на базе Istio SE, обеспечивающий возможность создания сервисной сети поверх Платформенной в Kubernetes |

SYOP |

Программный компонент Synapse Operator (SYOP) |

RHSM |

Red Hat Service Mesh — настраиваемая сервисная сеть, служащая для обеспечения безопасности контейнеров в кластере Kubernetes |

KFGT / Kafka шлюз |

Компонент Kafka шлюз |

Span |

Запись операции, выполняемой одним сервисом |

Сервис трассировки / TRAS |

Компонент Сервис трассировки |

Trace / трассировка |

Цепочка единичных операций (span), представляющих часть потока выполнения запроса. Тrace позволяет визуализировать активность запроса при его перемещении по системе и является самостоятельной единицей трассировки. |

VISL |

Компонент Visual SSM |

Системные требования#

Настройки безопасности окружения и перечень платформенных (дополнительных внешних) продуктов, используемых для установки, настройки и контроля в конечной информационной системе (далее — ИС), выбираются клиентом при разработке конечной ИС, исходя из характера обрабатываемой в ней информации и иных требований информационной безопасности (далее — ИБ), предъявляемых к ней.

Для установки модулей компонента GATM в среде контейнеризации Kubernetes – рекомендуется устанавливать приложения в рамках одного Pod. Приложения компонента не требуют дополнительной настройки окружения. Все настройки идут на уровне кластера в рамках среды контейнеризации.

Для возможности ручной установки, убедиться, что в рамках персонального компьютера установлен Helm версии не ниже 3.0.

Рекомендуемые настройки безопасности окружения приведены в разделе «Подготовка окружения» данного документа.

Системное программное обеспечение#

Ниже представлены категории системного программного обеспечения (далее — ПО), которые обязательны или не обязательны для установки, настройки, контроля и функционирования компонента. В каждой категории перечислены все поддерживаемые продукты/компоненты. Клиенту необходимо выбрать один из вариантов в каждой категории, исходя из условий использования конечной ИС.

Обязательность установки (да/нет) |

Наименование ПО |

Описание |

|---|---|---|

Да |

Alt Linux SP8 10 или |

Операционная система |

Да |

Docker CE 19.03.14 и выше |

Средство контейнеризации |

Да |

Platform V DropApp (K8S) 1.3 и выше (K8S Core (K8SC)) или |

Среда контейнеризации |

Да |

Nexus-Public 3.42.0 |

Сервис централизованного хранения репозиториев артефактов (хранилище артефактов) |

Да |

GitLab Community Edition 15.7 и выше |

Сервис централизованного хранения репозиториев исходного кода |

Нет |

Istio 1.6 и выше или |

Сервис интеграции и оркестрации микросервисов в облаке |

Нет |

HashiCorp Vault 1.10 и выше |

Система хранения и распространения secrets |

Нет |

Prometheus 2.37 и выше |

Система мониторинга |

Нет |

Helm 3 и выше |

Менеджер пакетов |

Нет |

kubectl CLI 1.20.5 и выше |

Интерфейс командной строки для взаимодействия с кластером |

Нет |

Apache Kafka 3.0.0 и выше |

Система хранение данных в формате плоского «JSON» |

Нет |

Platform V Synapse Enterprise Integration (SEI) 4.5 и выше (kafka шлюз (KFGT)) |

Шлюз для взаимодействия с Kafka |

Нет |

Platform V Synapse Service Mesh (SSM) 1.0 и выше (synapse operator (SYOP)) |

Оператор по установке приложений |

Нет |

Platform V Synapse Service Mesh (SSM) 1.0 и выше (KACM) |

Менеджер по работе с сертификатами |

Примечание:

*

Да — ПО, необходимое для функционирования сервиса, без установки которого не гарантирована работоспособность.

Нет — ПО, необязательное для функционирования сервиса, установка которого не влияет на работоспособность основных функций.

** Минимальная версии программного обеспечения, на которой гарантируется работоспособность. Использование версий выше заявленной возможно до потери обратной совместимости.

Аппаратные требования#

Для установки компонента требуется следующая рекомендованная конфигурация аппаратного обеспечения:

Название модуля |

ПО среды функционирования |

Количество |

Список контейнеров |

CPU Request, m |

CPU Limit, m |

Memory Request, Mi |

Memory Limit, Mi |

Горизонтальное масштабирование |

|---|---|---|---|---|---|---|---|---|

Приложение „Agent“ |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-metrics-agent |

300 |

500 |

300 |

500 |

Да |

istio-proxy |

300 |

300 |

300 |

300 |

Да |

|||

Приложение Kafka „adapter“ |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-metrics-adapter |

300 |

2000 |

300 |

1500 |

Да |

istio-proxy |

300 |

300 |

300 |

300 |

Да |

|||

Приложение Event exporter |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-metrics-event-exporter |

300 |

300 |

300 |

300 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение Select |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-metrics-select |

300 |

300 |

300 |

300 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение Insert |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-metrics-insert |

300 |

300 |

300 |

300 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение „Storage“ |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-metrics-storage |

100 |

1000 |

300 |

5000 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение Alert |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-metrics-alert |

300 |

300 |

300 |

300 |

Да |

synapse-metrics-agent |

300 |

300 |

300 |

300 |

Да |

|||

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение AlertManager |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-metrics-alertmanager |

300 |

300 |

300 |

300 |

Да |

istio-proxy |

100 |

300 |

200 |

300 |

Да |

|||

Приложение „Agent“ (logs) |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-logs-agent |

100 |

1400 |

100 |

400 |

Да |

istio-proxy |

50 |

1000 |

50 |

1000 |

Да |

|||

Приложение Insert (logs) |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-logs-insert |

300 |

600 |

300 |

600 |

Да |

istio-proxy |

1000 |

1000 |

2000 |

3000 |

Да |

|||

Приложение Select (logs) |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-logs-select |

300 |

300 |

300 |

300 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение „Storage“ (logs) |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-logs-storage |

300 |

300 |

300 |

300 |

Да |

istio-proxy |

100 |

400 |

200 |

400 |

Да |

|||

Приложение Sender (logs) |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-logs-sender |

300 |

300 |

300 |

300 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение Insert (trace) |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-trace-insert |

1000 |

1000 |

1000 |

1000 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение Select (trace) |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-trace-select |

300 |

300 |

300 |

300 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение „Storage“ (trace) |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-trace-storage |

300 |

300 |

300 |

1000 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

|||

Приложение Proxy (trace) |

Kubernetes/Platform V DropApp (опционально OpenShift NS) |

1 pod |

synapse-trace-proxy |

300 |

300 |

300 |

300 |

Да |

istio-proxy |

100 |

200 |

200 |

300 |

Да |

Компонент GATM поддерживает горизонтальную масштабируемость. При горизонтальном масштабировании продукта, для подтверждения соответствия ожидаемым нефункциональным характеристикам, рекомендуется предварительно провести нагрузочное тестирование на целевой конфигурации конкретной инсталляции.

Состав дистрибутива#

Компонент GATM предоставляет 2 архива:

Элементы поставки:

gatm-bin

Элемент дистрибутива |

Описание |

|---|---|

./package/bh/gatm_agent |

Приложение по сбору метрик |

./package/bh/gatm_alert |

Приложение по агрегации метрик |

./package/bh/gatm_insert |

Приложение по добавлению метрик |

./package/bh/gatm_select |

Приложение по запросу метрик |

./package/bh/gatm_storage |

Приложение по хранению метрик |

./package/bh/prometheus-kafka-adapter |

Приложение по передаче метрик в Kafka метрик |

./package/bh/gatm_event_exporter |

Приложение по сбору событий (event) |

./package/bh/gatm-tracing-collector |

Приложение по добавлению трассировок и перевод формата с zipkin в jeager |

./package/bh/gatm-tracing-query |

Приложение по запросу трассировок |

./package/bh/gatm-tracing-proxy-storage |

Приложение по корректному запросу к репликам „storage“ трассировок |

./package/bh/gatm-tracing-remote-storage |

Приложение по хранению трассировок |

./package/bh/gatm_logs_agent |

Приложение по сбору логов |

./package/bh/gatm_lselect |

Приложение по запросу логов |

./package/bh/gatm_linsert |

Приложение по добавлению логов |

./package/bh/gatm_lstorage |

Приложение по хранению логов |

./package/bh/synapse_sender |

Приложение для реализации переотправки сообщений в рамках интеграционного журнала |

./package/bh/gatm_alertmanager |

Приложение по работе с alert сообщениями |

gatm-cfg

Конфигурации для установки.

Элемент дистрибутива |

Описание |

|---|---|

./package/conf/helm/application/gatm/* |

Базовые конфигурации по установке компонента GATM |

./package/conf/helm/application/ext-gatm/* |

Расширенные конфигурации по установке компонента GATM |

./package/conf/helm/application/ext-sender/* |

Базовые конфигурации по установке приложения synapse sender компонента GATM |

./package/conf/helm/application/ext-sender-job/* |

Базовые конфигурации по установке приложения synapse sender (планировщик заданий) компонента GATM |

Внимание! В рамках конфигураций чарт gatm предназначен для установки посредством SMDL. Чарты с префиксом ext- реализованы для ручной установки, либо установки посредством SYOP (с деталями установки через данный компонент можно ознакомиться в рамках документации SYOP).

При необходимости, в рамках реализации транспортных сертификатов, реализована опция по публикации конфигураций компонента KACM, в рамках секций стендозависимых параметров (certManager.apiVersion, для использования компонента необходимо указать группу «security.synapse.sber»). Выпускаемые сертификаты реализуются посредством публикации «kind: Secret». Более подробно можно ознакомиться в рамках документации KACM.

Выбор способа установки#

В зависимости от способа развертывания сервиса воспользуйтесь одной из инструкций:

целевая автоматизированная установка сервиса с использованием компонента SMDL, «ClientUnpacker»

опциональная ручная установка сервиса

Подготовка окружения#

Для выполнения установки программного компонента GATM должны быть выполнены следующие условия:

Развернут и настроен кластер «Kubernetes» версии 1.19 или выше в соответствии с требованиями, предъявляемыми к Платформе.

В кластере создан проект (namespace), в котором установлена контрольная панель.

В проекте создана учетная запись с правами на get, list, watch ресурсов Pod и Namespace, при опциональной установке компонента event exporter необходимо также реализовать ролевую модель на get, list, watch к ресурсу «kind: Event».

В проекте имеются свободные ресурсы по limits и requests не менее, чем зарезервировано в конфигурационных артефактах.

В проект добавлен секрет для загрузки Docker-образов из целевого Docker-репозитория.

В кластере создан проект (namespace), или используется ранее реализованный пользовательский проект, где будут реализованы компонент GATM, так же необходимо будет подключить указанный проект к контрольной панели.

В рамках реализованного кластера созданы необходимые роли («kind: ClusterRole») и привязки к роли в рамках проекта («kind: RoleBinding»), в рамках ролевой модели компонента GATM.

Для установки через консоль на рабочем месте должен быть установлен клиент Kubectl (CLI - command-line interface).

1. Создать директорию установки#

„Agent“ (директория - gatm_agent)

„Storage“ (директория - gatm_storage)

Insert (директория - gatm_insert)

Select (директория - gatm_select)

Alert (директория - gatm_alert)

Event exporter (директория - gatm_event_exporter)

Kafka „adapter“ (директория - gatm_kafka_adapter)

„Agent“ „Logs“ (директория - gatm_logs_agent)

Select „Logs“ (директория - gatm_lselect)

„Storage“ „Logs“ (директория - gatm_lstorage)

Insert „Logs“ (директория - gatm_linsert)

Select Trace (директория - gatm_tselect)

Insert Trace (директория - gatm_tinsert)

Proxy Trace (директория - gatm_tproxy)

„Storage“ Trace (директория - gatm_tstorage)

AlertManager (директория - gatm_alertmanager)

Sender (директория - gatm_sender)

Пререквизиты:

Базовый образ для сборки docker image загружен в docker registry

Ручная установка:

Публикация базового образа:

Загрузить образ из файла командой docker load

Поставить тег полученному образу и залить в docker registry (командами

docker tag,docker push)

В рамках примера пошагово будет описан процесс сборки образа и загрузка его в registry, аналогичные действия необходимо произвести по всем компонентам.

Шаг |

Действия |

Описание |

|---|---|---|

Создать директорию для установки |

На компьютере, с которого будет производиться установка, создайте папку, например, «synapse-gatm» |

– |

Разархивировать файлы |

Распакуйте в созданную папку архив с конфигурационными артефактами компонента GATM |

– |

Вставить базовый образ в рамках файла Dockerfile |

Пройти в каталог «docker/gatm_agent/Dockerfile», открыть и отредактировать файл, в рамках секции «FROM» подставить ссылку на базовый образ |

Сохранить и закрыть файл |

Авторизуйтесь в Docker Registry |

Выполните команду, находясь в корне распакованного архива: |

$Registry — это host Docker реестра. Необходимо ввести логин с паролем для авторизации |

Соберите Docker образ для установки приложения |

Выполните команду, находясь в корне распакованного архива: |

$registry_tag — полный путь, где будет реализован образ, $version — версия образа. Пример заполнения двух параметров «registry/dev/gatm-agent:0.0.1» |

Загрузите полученный Docker образ в Registry |

Выполните команду, находясь в корне распакованного архива: |

– |

Сохраните полученный sha256 образа |

При выполнении шага «Загрузите полученный Docker образ в Registry» в терминале будет информация о sha256 загруженного образа, пример вывода терминала |

Сохраните указанное значение в переменную $sha256 |

Тем самым получаем image приложений - «IMAGE_$component=$registry_tag@$sha256»

Автоматическая установка:

Для сборки образа рекомендуем использовать инструмент автоматической сборки образа, компонента SMDL, «ClientUnpacker» (более подробно о настройке и запуске можно ознакомиться в документации компонента «SMDL», «Руководство оператора»), результатом исполнения будет собранный образ приложений.

Необходимо обновить параметр из JSON «teamProducts.json» (при реализации автоматической установки также необходимо провести актуализацию используемых образов по интеграциям).

{

"name": "Сбор и анализ метрик",

"code": "GATM",

"user": "****",

"parts": [

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_agent}",

"deploymentUnit": "gatm_agent"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_agent@sha256:(?<hash>\\w+)" # регулярное выражение для поиска в конфигурациях развертывания места с указанием image компонента

}

]

},

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_kafka_adapter}",

"deploymentUnit": "gatm_kafka_adapter"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_kafka_adapter@sha256:(?<hash>\\w+)"

}

]

},

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_alert}",

"deploymentUnit": "gatm_alert"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_alert@sha256:(?<hash>\\w+)"

}

]

},

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_insert}",

"deploymentUnit": "gatm_insert"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_insert@sha256:(?<hash>\\w+)"

}

]

},

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_select}",

"deploymentUnit": "gatm_select"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_select@sha256:(?<hash>\\w+)"

}

]

},

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_storage}",

"deploymentUnit": "gatm_storage"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_storage@sha256:(?<hash>\\w+)"

}

],

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_lselect}",

"deploymentUnit": "gatm_lselect"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_lselect@sha256:(?<hash>\\w+)"

}

],

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_sender}",

"deploymentUnit": "gatm_sender"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_sender@sha256:(?<hash>\\w+)"

}

],

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_alertmanager}",

"deploymentUnit": "gatm_alertmanager"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_alertmanager@sha256:(?<hash>\\w+)"

}

],

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_linsert}",

"deploymentUnit": "gatm_linsert"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_linsert@sha256:(?<hash>\\w+)"

}

],

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_lstorage}",

"deploymentUnit": "gatm_lstorage"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_lstorage@sha256:(?<hash>\\w+)"

}

],

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm-tracing-collector}",

"deploymentUnit": "gatm-tracing-collector"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm-tracing-collector@sha256:(?<hash>\\w+)"

}

],

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm-tracing-query}",

"deploymentUnit": "gatm-tracing-query"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm-tracing-query@sha256:(?<hash>\\w+)"

}

],

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm-tracing-remote-storage}",

"deploymentUnit": "gatm-tracing-remote-storage"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm-tracing-remote-storage@sha256:(?<hash>\\w+)"

}

],

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm-tracing-proxy-storage}",

"deploymentUnit": "gatm-tracing-proxy-storage"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm-tracing-proxy-storage@sha256:(?<hash>\\w+)"

}

]

},

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_event_exporter}",

"deploymentUnit": "gatm_event_exporter"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_event_exporter@sha256:(?<hash>\\w+)"

}

]

},

{

"docker": [

{

"baseImageLink": "${базовый образ для сборки приложения}", # пример "*/alt-sp8-golang:1.22

"version": "${версия компонента gatm_logs_agent}",

"deploymentUnit": "gatm_logs_agent"

}

],

"imageLinkMapping": [

{

"regex": "(?<=(\\{\\{|\\$\\{)\\s?\\.Values\\.registry\\s?(\\}){1,2})/(\\{\\{|\\$\\{)\\s?\\.Values\\.registry_path\\s?(\\}){1,2}/gatm_logs_agent@sha256:(?<hash>\\w+)"

}

]

},

{

"artifactId": "gatm-cfg",

"imageLinkMapping": [

{

"string": "/{{ .Values.registry_path_igegose }}/proxyv2@sha256:***",

"replace": "/openshift/proxyv2-rhel8@sha256:***"

},

{

"string": "/{{ .Values.registry_path_igegse117 }}/proxyv2@sha256:***",

"replace": "/synapse/polm/proxyv2@sha256:***"

},

{

"string": "/{{ .Values.registry_path_igegse119 }}/proxyv2@sha256:***",

"replace": "/synapse/polm/proxyv2@sha256:***"

},

{

"string": "{{ .Values.registry }}", # при необходимости использовать .Values.global.registry

"replace": "{{ $registry }}"

}

]

}

],

Запустить инструмент автоматической сборки - компонент SMDL, «ClientUnpacker» (более подробно о настройке и запуске можно ознакомиться в документации компонента «SMDL», «Руководство оператора»), результатом исполнения будут собранные артефакты для установки приложения (на email сотрудника, который запустил job, придет таблица со ссылками на артефакты).

Провести проверку корректной подстановки образов по шаблону, указанному в шаге 3. В таблице, появившейся после запуска job «ClientUnpacker», необходимо загрузить артефакты, которые относятся к компоненту GATM (позиция «product GATM_agent», ссылка на дистрибутив располагается в секции «distribUrl»).

Проверка релевантна только для чарта с наименованием gatm.

### в рамках приложения gatm_agent располагаются общие конфигурации по установке

### путь к конфигурационному файлу «package/conf/helm/application/gatm/templates/statefulset.yaml»

### произвести поиск по ключу «image»

...

envFrom:

- configMapRef:

name: synapse-kafka-adapter-env

image: '{{ $registry }}/ci90000017_synapse/ci90000017_synapse/gatm/gatm_kafka_adapter@sha256:****' # пример корректной подстановки образа для компонента gatm_kafka_adapter

...

- name: synapse-metrics-data

mountPath: /data

terminationMessagePolicy: File

image: '{{ $registry }}/ci90000017_synapse/ci90000017_synapse/gatm/gatm_agent@sha256:****' # пример корректной подстановки образа для компонента gatm_kafka_adapter

...

Аналогичные проверки необходимо сделать по проверке корректной подстановки образов в рамках «kind: Deployment».

### путь к конфигурационному файлу «package/conf/helm/application/gatm/templates/deployment-egress.yaml»

### произвести поиск по ключу «image»

...

image: */igeg/proxyv2:${version istio 1.6} # пример корректной подстановки образа для компонента IGEG (версия для работоспособности с контрольной панелью RHSM)

...

image: */igeg/proxyv2:${version istio 1.20} # пример корректной подстановки образа для компонента IGEG (версия для работоспособности с контрольной панелью POLM)

...

image: */igeg/proxyv2:${version istio 1.17} # пример корректной подстановки образа для компонента IGEG (версия для работоспособности с контрольной панелью POLM)

...

image: */igeg/proxyv2:${version istio 1.19} # пример корректной подстановки образа для компонента IGEG (версия для работоспособности с контрольной панелью POLM)

...

В рамках конфигурационных файлов предусмотрена опция организации автоматизации по стендозависимым параметрам в рамках директории «conf.config.parameters», при наличии автоматизированных инструментов.

gatm_agent.all.conf

# пример параметра

synapse-metrics-all.k8s.istio.control-plane-project=istio-system

gatm_agent.istio.all.conf

# пример параметра

synapse-metrics.k8s.istio.control-plane-project=istio-system

2. Подключиться к проекту#

Через CLI Kubectl

Шаг |

Действия |

Описание |

|---|---|---|

Выполнить вход в Kubernetes |

Загрузите «kubeConfig» от вашего «ServiceAccount» с правами администратора. Заведите переменную |

– |

Перейти в «namespace», где будет реализован компонент GATM |

Введите команду: |

– |

3. Установить необходимый перечень ресурсов#

В рамках предоставляемого дистрибутива реализованы все необходимые ресурсы для успешного функционирования компонента GATM. Ресурсы в рамках ролевой модели – «kind: ClusterRole»/«kind: RoleBinding»/«kind: ServiceAccount».

Если будет производиться установка посредством чартов с префиксом ext-, то все необходимые ресурсы будут в рамках чарта, предварительные шаги по установке ресурсов избыточны.

Через CLI Kubectl

Шаг |

Действия |

Описание |

|---|---|---|

Добавить необходимый перечень ресурсов |

В консоли выполнить команды, которые описаны в данном разделе ниже |

– |

Перед запуском заполните параметры, следующей командой:

GATM_NAMESPACE=<имя namespace>

IMAGE_PULL_SECRETS=<имя секрета для скачивания образа>

«kind: ServiceAccount»

Команда:

kubectl apply -n $GATM_NAMESPACE -f - <<EOF

kind: ServiceAccount

apiVersion: v1

metadata:

name: synapse-metrics-sa

imagePullSecrets:

- name: $IMAGE_PULL_SECRETS

--- # при установке event exporter

kind: ServiceAccount

apiVersion: v1

metadata:

name: synapse-metrics-event-exporter

imagePullSecrets:

- name: $IMAGE_PULL_SECRETS

EOF

Ожидаемый результат:

serviceaccount/synapse-metrics-sa created

serviceaccount/synapse-metrics-event-exporter created

«kind: ClusterRole»

Команда:

kubectl apply -n ${GATM_NAMESPACE} -f - <<EOF

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: synapse-metrics-agent-role

rules:

- verbs:

- get

- list

- watch

apiGroups:

- ''

resources:

- pods

- services # при реализации сбора прикладных метрик

- endpoints # при реализации сбора прикладных метрик

- namespaces

--- # при установке event exporter

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: synapse-metrics-event-role

rules:

- verbs:

- get

- list

- watch

apiGroups:

- ''

resources:

- events

- pods # при необходимости использовать функционал по мониторингу конфигураций «kind: Pod»

EOF

Ожидаемый результат:

clusterrole.rbac.authorization.k8s.io/synapse-metrics-agent-role created

clusterrole.rbac.authorization.k8s.io/synapse-metrics-event-role created

«kind: RoleBinding»/«kind: ClusterRoleBinding»

Команда:

kubectl apply -n $GATM_NAMESPACE -f - <<EOF

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: synapse-metrics-agent-rb

namespace: $GATM_NAMESPACE

subjects:

- kind: ServiceAccount

name: synapse-metrics-sa

namespace: $GATM_NAMESPACE

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: synapse-metrics-agent-role

--- # при установке event exporter

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: synapse-metrics-event-rb

namespace: $GATM_NAMESPACE

subjects:

- kind: ServiceAccount

name: synapse-metrics-event-exporter

namespace: $GATM_NAMESPACE

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: synapse-metrics-event-role

EOF

Ожидаемый результат:

rolebinding.rbac.authorization.k8s.io/synapse-metrics-agent-rb created

rolebinding.rbac.authorization.k8s.io/synapse-metrics-event-rb created

Привязка роли к приложению GATM для успешного запроса к системным метрикам кластера Openshift:

«kind: RoleBinding»/«kind: ClusterRoleBinding»

Команда:

kubectl apply -n $GATM_NAMESPACE -f - <<EOF

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: synapse-metrics-agent-rb

namespace: openshift-monitoring

subjects:

- kind: ServiceAccount

name: synapse-metrics-sa

namespace: $GATM_NAMESPACE

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: synapse-metrics-agent-role

EOF

Обращаем ваше внимание, что доступ к системным метрикам может настраиваться индивидуально, при реализации сервера по сбору системных метрик администратор может изменить необходимые привилегии для приложений, которые запрашивают информацию. В примере, который описан выше, продемонстрирована ролевая модель по умолчанию, если указанных привилегий будет недостаточно, то необходимо связаться с администратором кластера.

Пример настройки для OpenShift:

kind: Deployment

apiVersion: apps/v1

metadata:

name: federate

namespace: openshift-monitoring

...

spec:

replicas: 2

selector:

matchLabels:

app: federate

template:

metadata:

labels:

app: federate

spec:

nodeSelector:

type: monitoring

terminationGracePeriodSeconds: 30

containers:

- resources:

requests:

cpu: 50m

memory: 50Mi

name: federate-proxy

args:

- >-

-openshift-sar={"resource": "namespaces", "verb": "get",

"resourceName": "openshift-monitoring", "namespace":

"openshift-monitoring"}

При указанных настройках ServiceAccount GATM необходимы привилегии на «get» ресурса «namespace», в рамках проекта «openshift-monitoring».

Также существуют практики, когда необходимо реализовать RoleBinding в рамках проекта где планируется производиться сбор системных метрик, по данным настройкам также необходимо обратиться к вашему администратору кластера.

Установка#

Предусловия#

Первоначально необходимо определиться со схемой развертывания компонента:

Определить набор компонент, необходимый для установки;

Определить необходимость установки серверной части в рамках трассировок и логов;

Выбрать сервер для хранения метрик (Kafka, серверная часть GATM, внешний сервер формата Prometheus);

Определить точку сборка метрик (централизованный сбор метрик с ServiceMesh, установка в пользовательский namespace).

Рассмотрим схемы по установке.

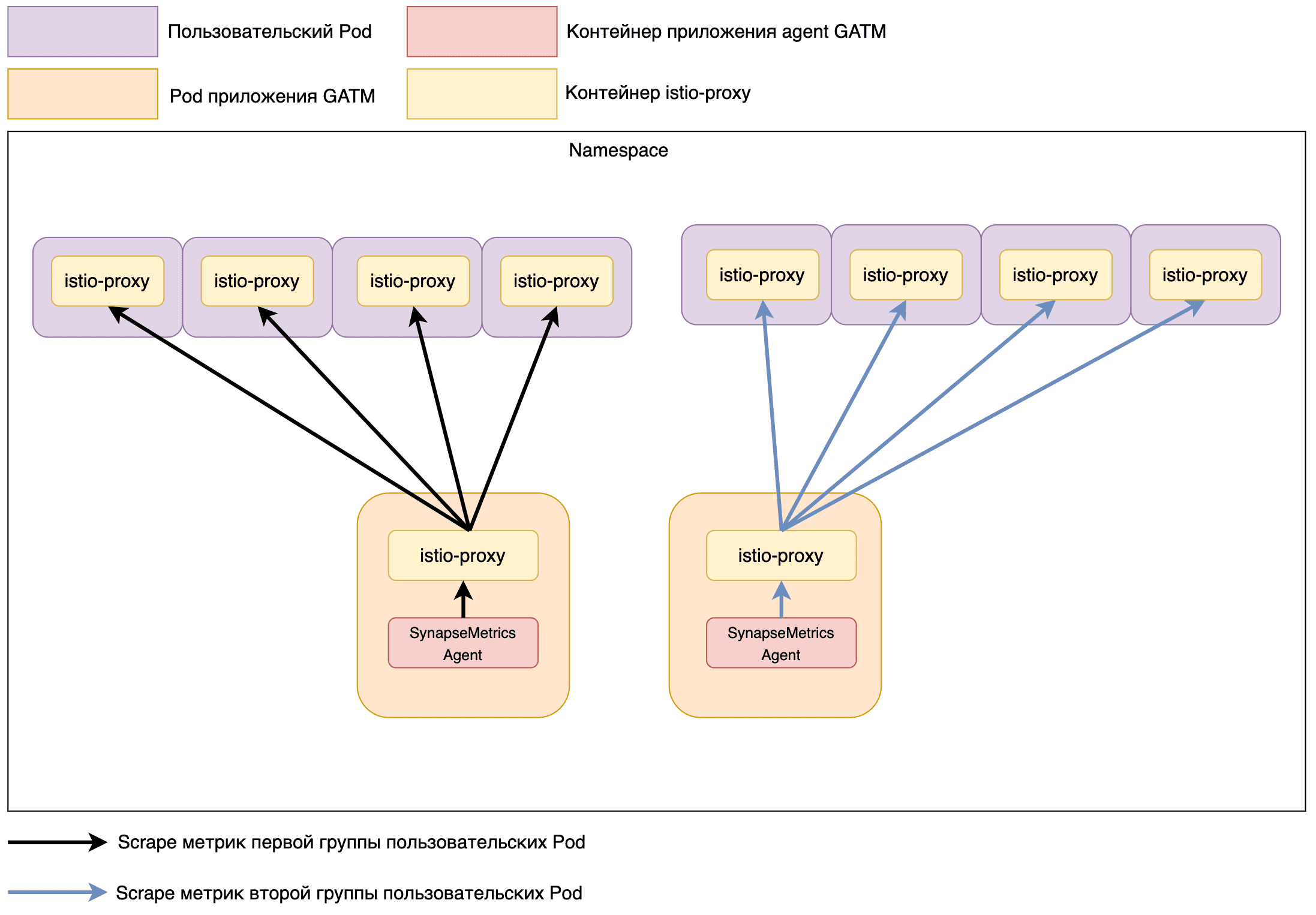

Метрики.

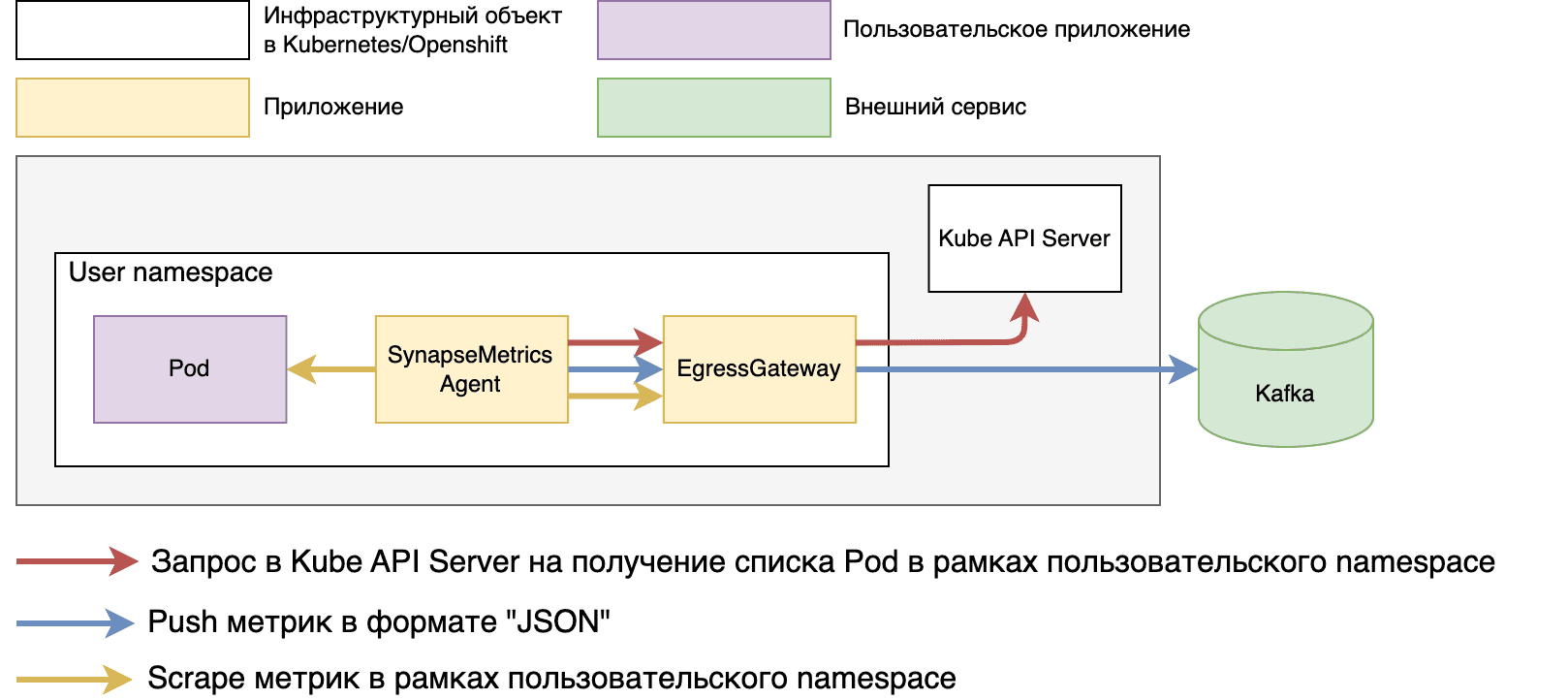

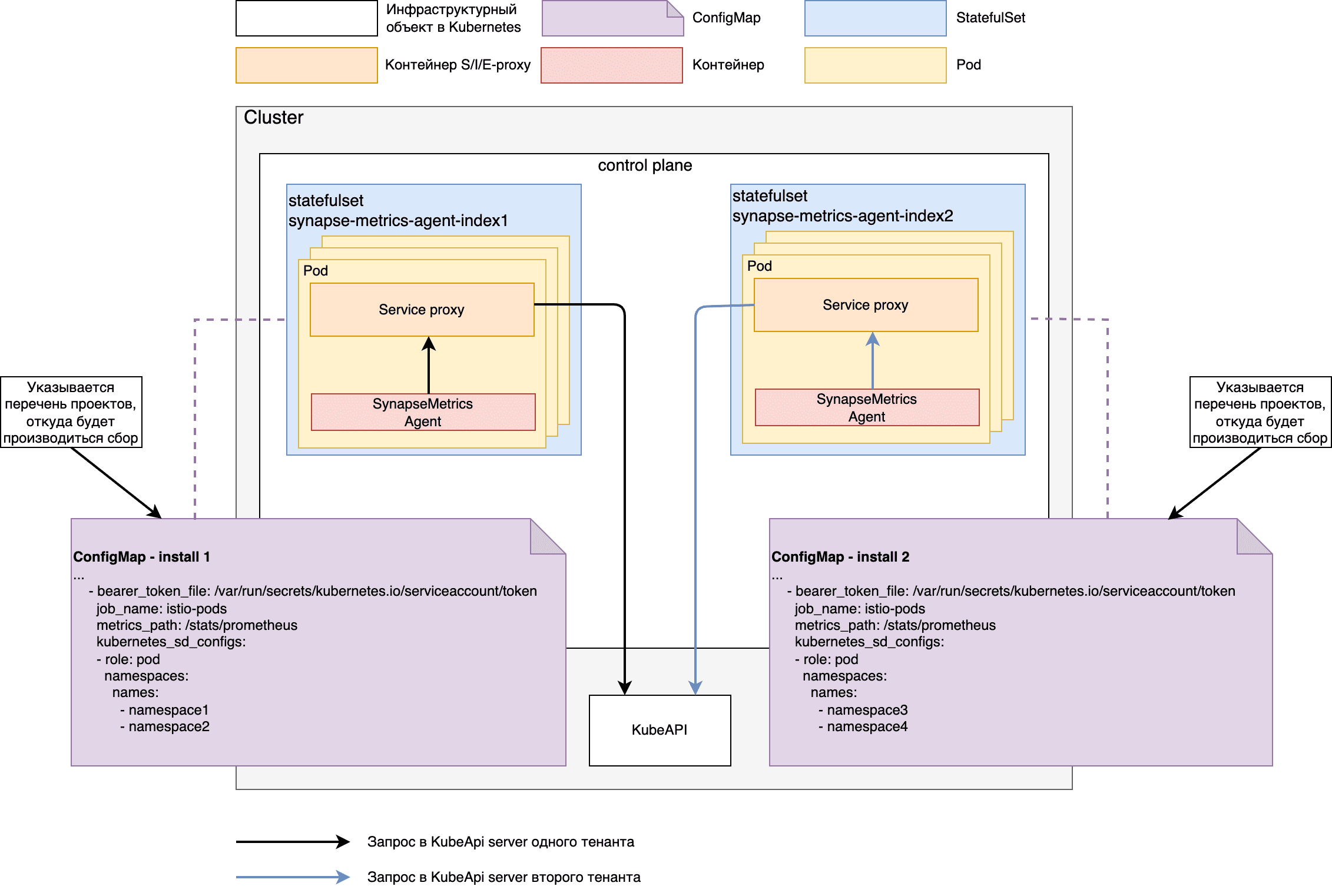

Схема. Схема развертывания сбора метрик из пользовательского namespace. Данная схема является концептуальной для визуализации установки

Схема. Схема развертывания сбора метрик из пользовательского namespace. Данная схема является концептуальной для визуализации установки

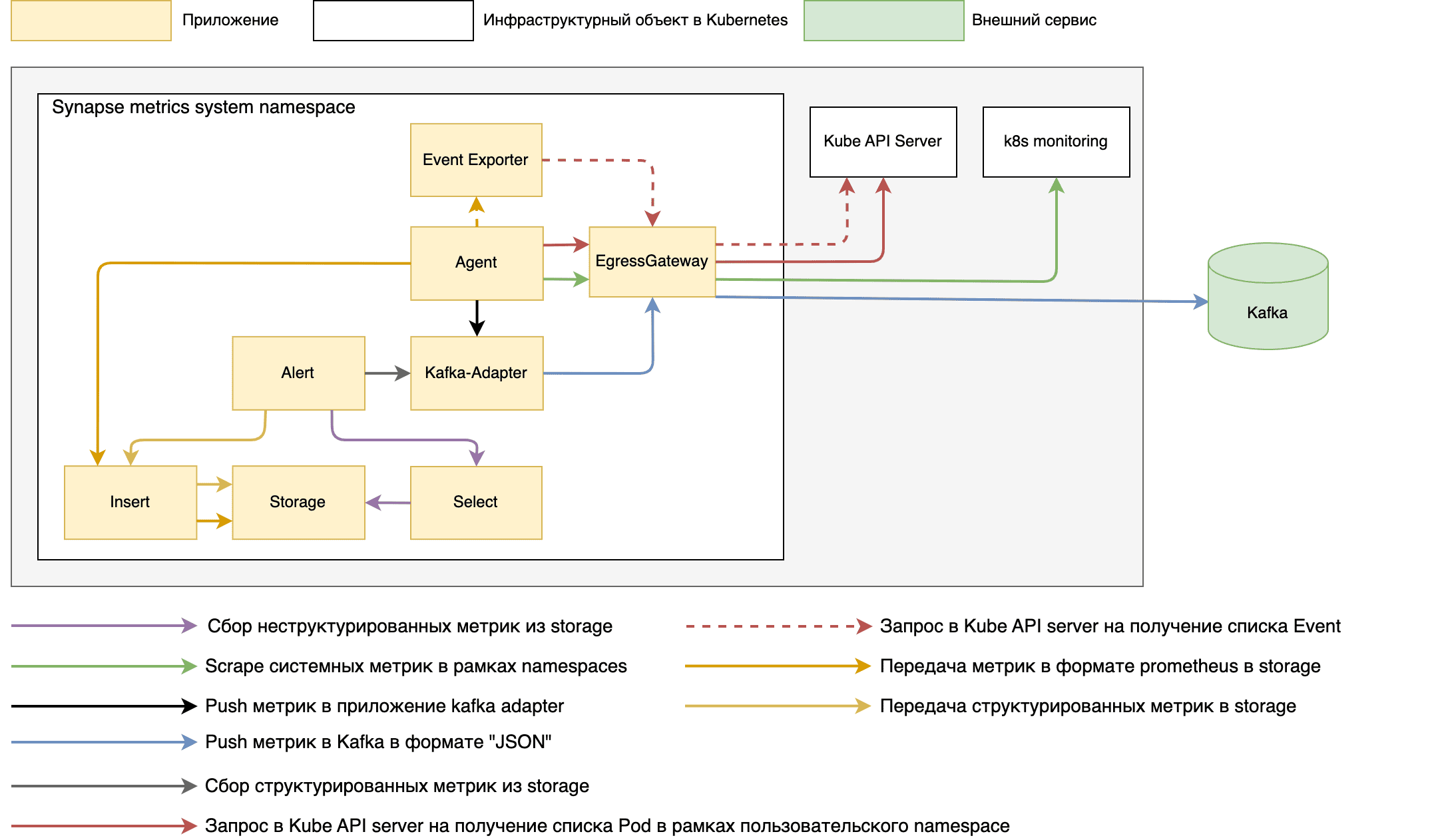

Схема. Схема развертывания установки в рамках Kubernetes (с установкой event exporter). Данная схема является концептуальной для визуализации установки

Схема. Схема развертывания установки в рамках Kubernetes (с установкой event exporter). Данная схема является концептуальной для визуализации установки

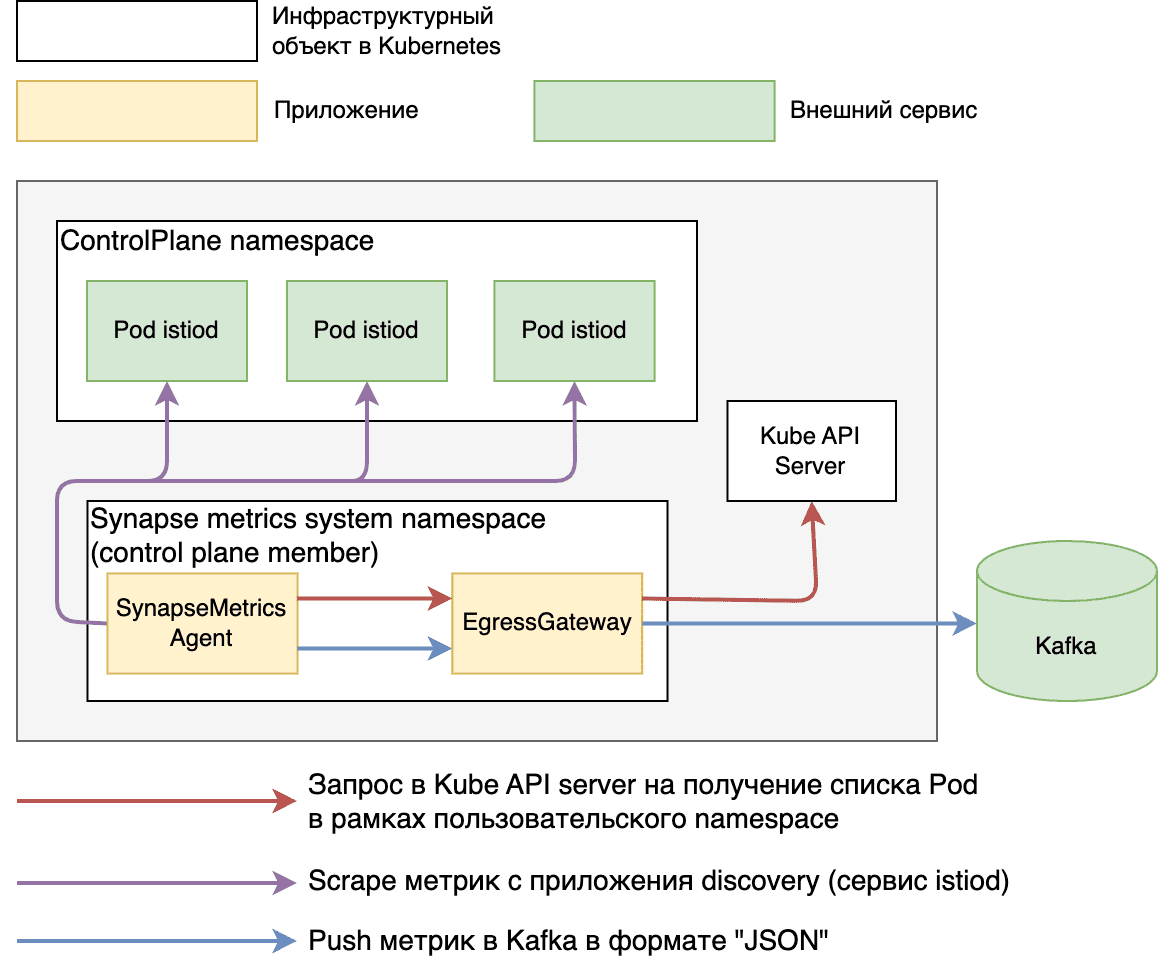

Схема. Схема развертывания сбора метрик из контрольной панели RHSM. Данная схема является концептуальной для визуализации установки

Схема. Схема развертывания сбора метрик из контрольной панели RHSM. Данная схема является концептуальной для визуализации установки

Схема. Схема развертывания сбора метрик из контрольной панели. Данная схема является концептуальной для визуализации установки

Схема. Схема развертывания сбора метрик из контрольной панели. Данная схема является концептуальной для визуализации установки

Используется аналогичная схема при реализации сбора метрик с namespace «istio-operator», для успешного сбора необходимо реализовать сетевую доступность из проекта GATM к проекту «istio-operator», также убедиться что при установке «istio-operator» был реализован command «- „–monitoring-port=15014“» в рамках «kind: Deployment».

Трассировки и логи.

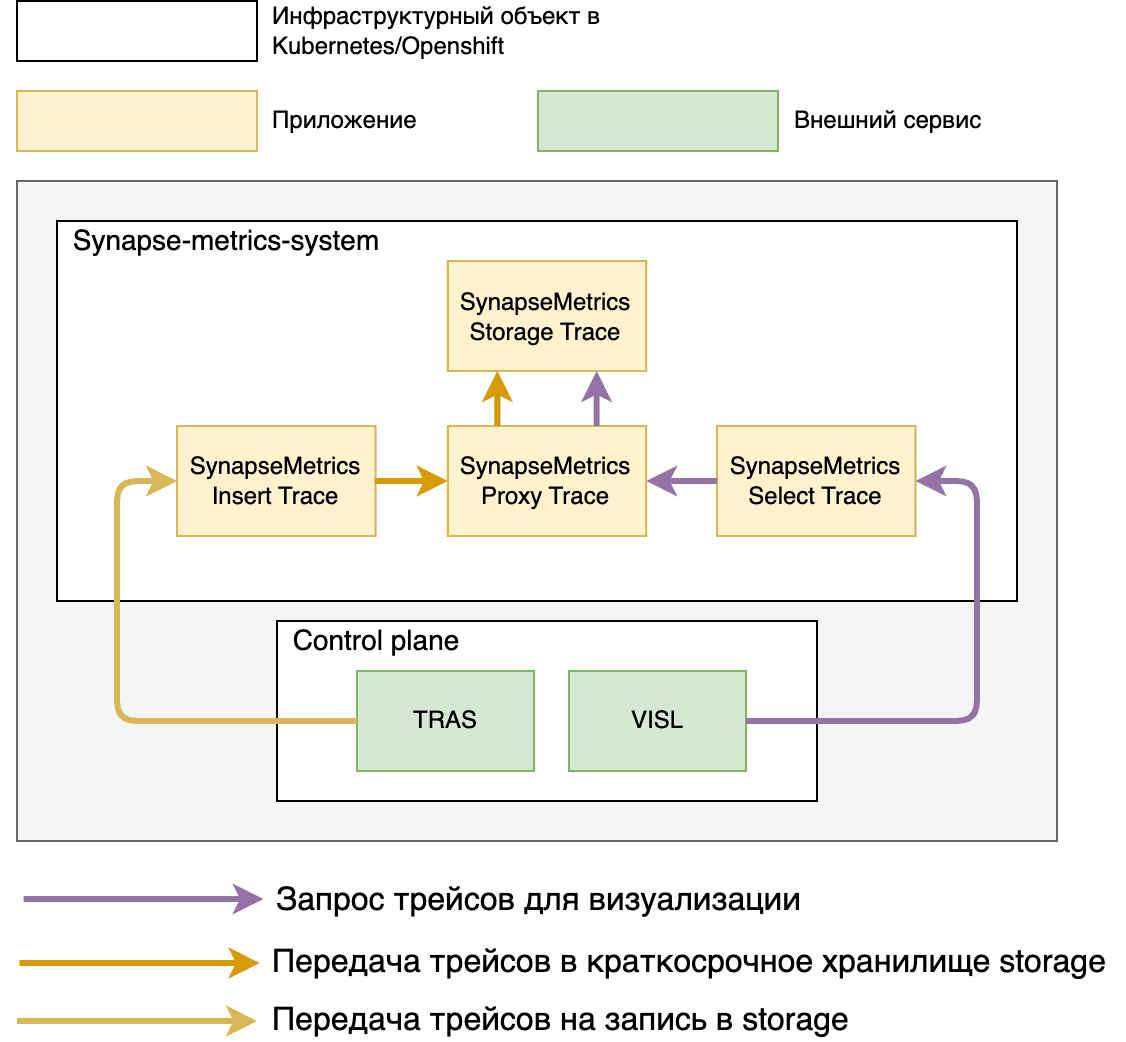

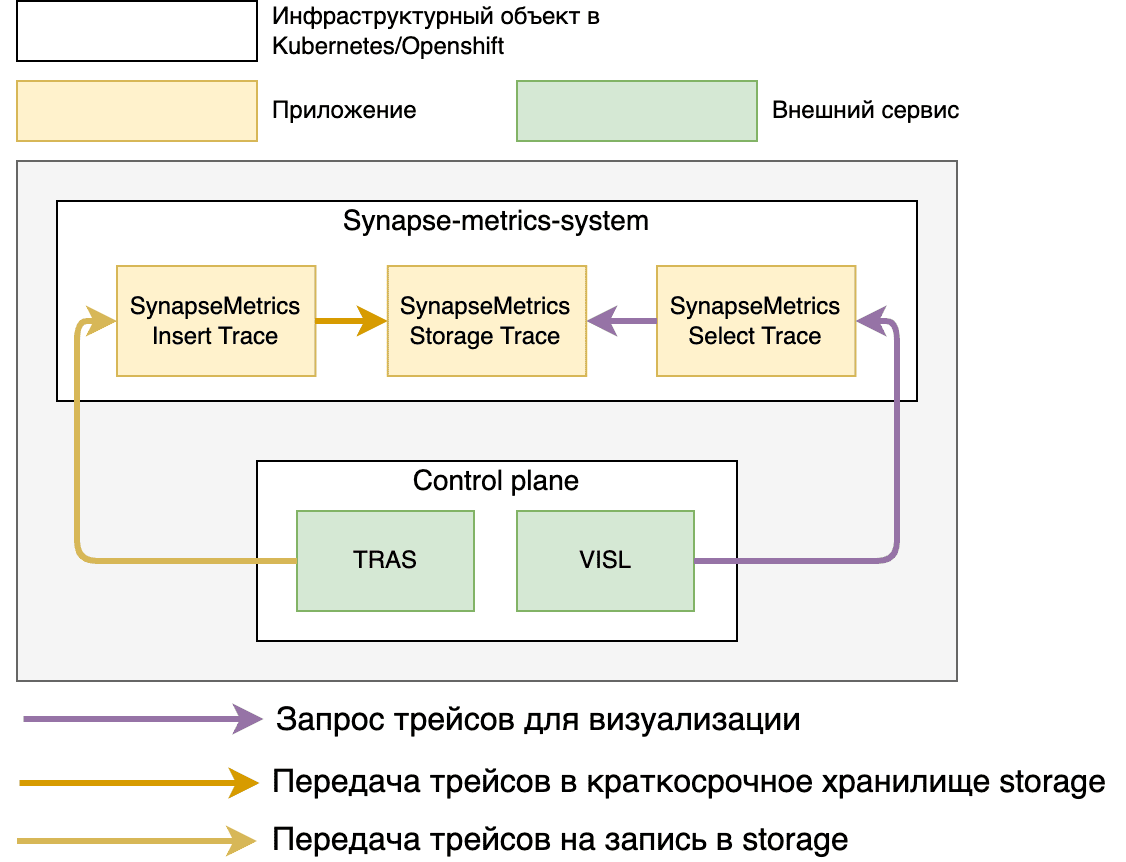

Схема. Схема развертывания сбора трассировок, устарела (проект synapse-metrics-system). Данная схема является концептуальной для визуализации установки

Схема. Схема развертывания сбора трассировок, устарела (проект synapse-metrics-system). Данная схема является концептуальной для визуализации установки

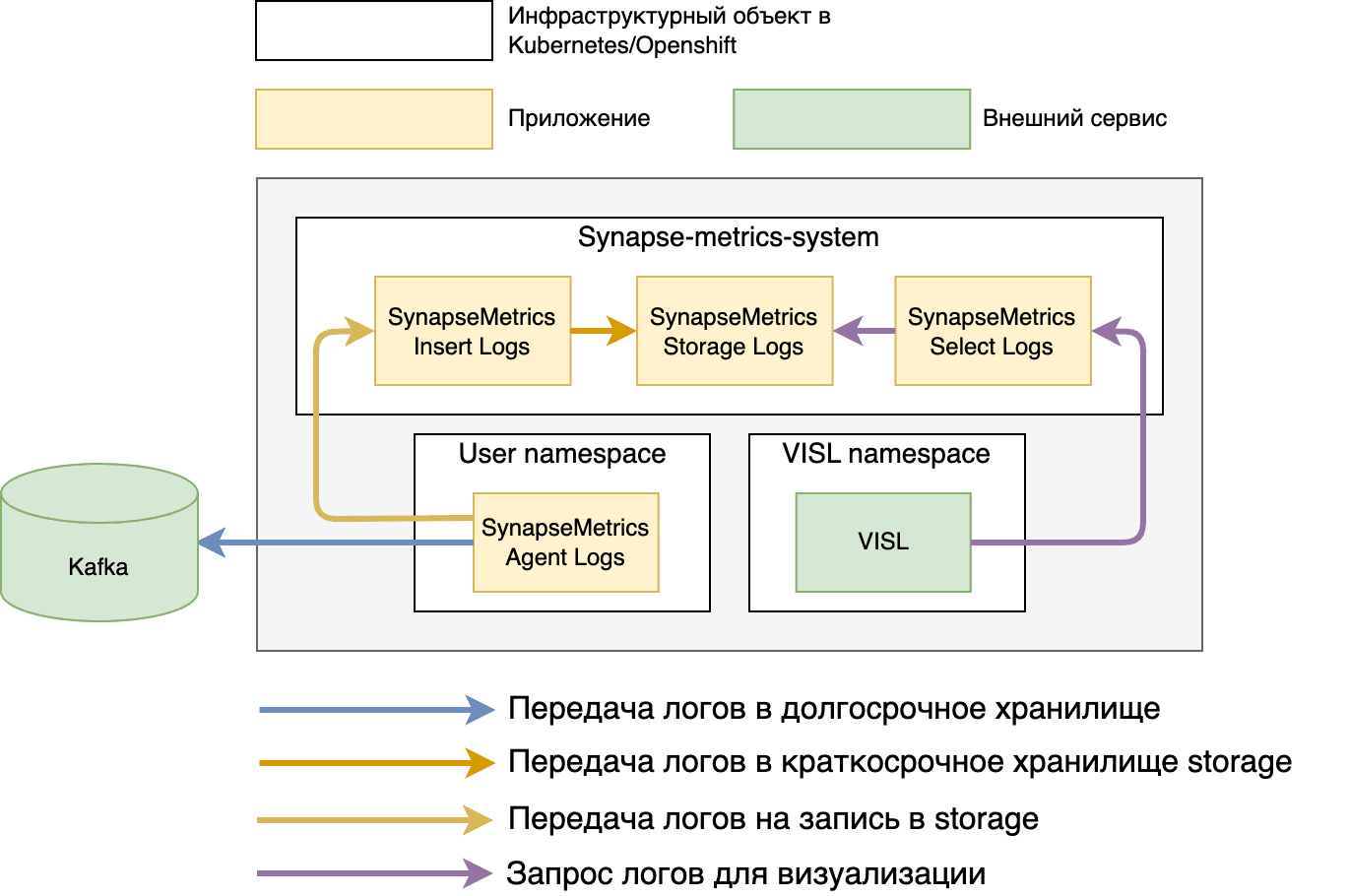

Схема. Схема развертывания сбора логов (проект synapse-metrics-system). Данная схема является концептуальной для визуализации установки

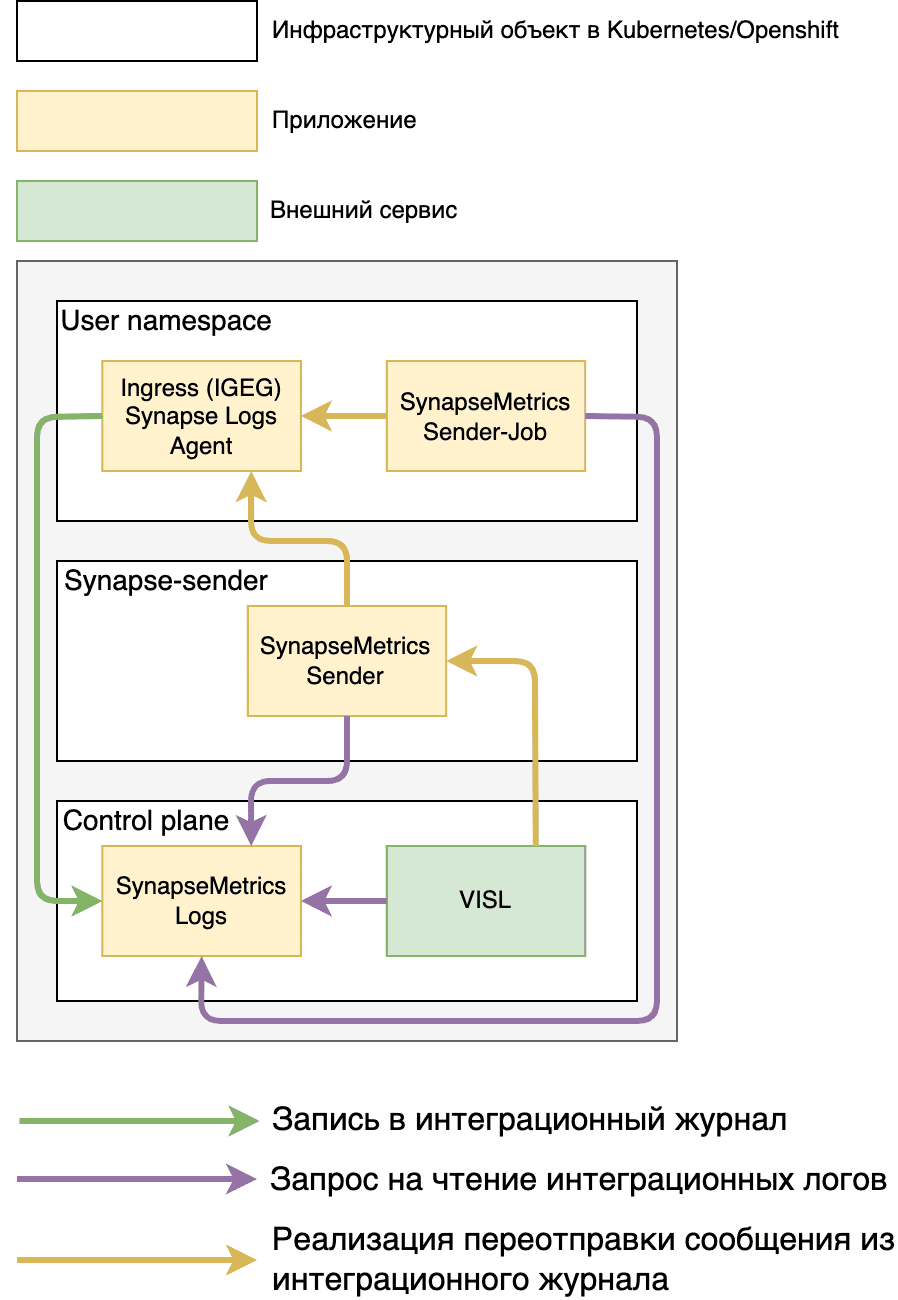

Реализация интеграционного журнала, при использовании конфигураций развертывания «ext-gatm-sender» и «ext-gatm-sender-job».

Схема. Интеграционный журнал с функцией переотправки сообщений

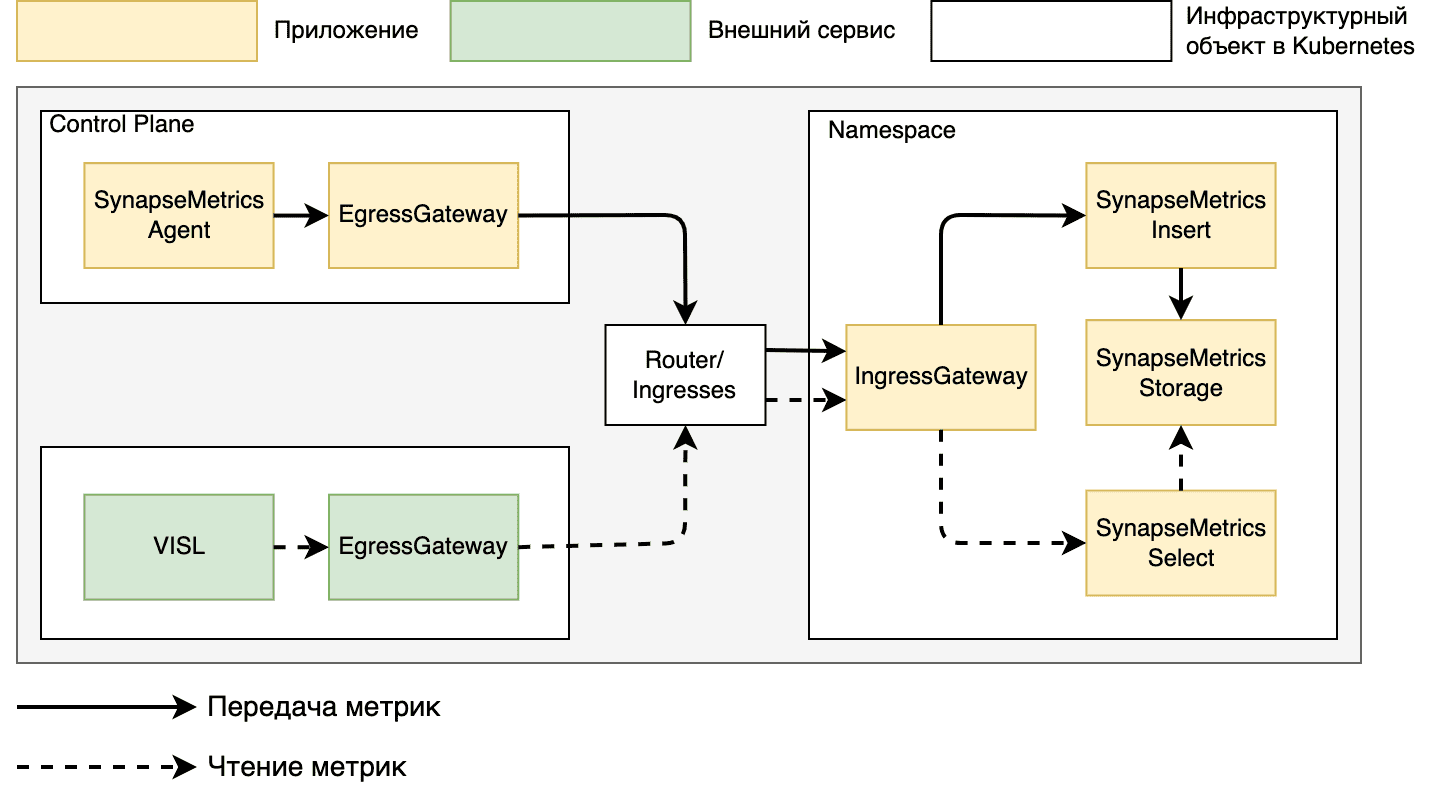

Серверные части по метрикам, трассировкам и логам могут быть установлены в рамках одного проекта и опционально настроено входящее взаимодействие через Ingressgateway.

При использовании средства визуализации VISL необходимо учесть серверные части GATM при установке, более подробно описано в рамках документации компонента VISL, документ «Руководство по установке», раздел «Установка».

При использовании приложения TRAS как источник трассировок, необходимо указать адрес серверной части GATM по сбору трассировок, при установке компонента TRAS, более подробно описано в рамках документации компонента TRAS, документ «Руководство по установке», раздел «Состав дистрибутива» (Пример и описание параметров файла values).

Установка приложения „Agent“ (logs) производится пользователем.

Использование сертификатов с приложением «vault»#

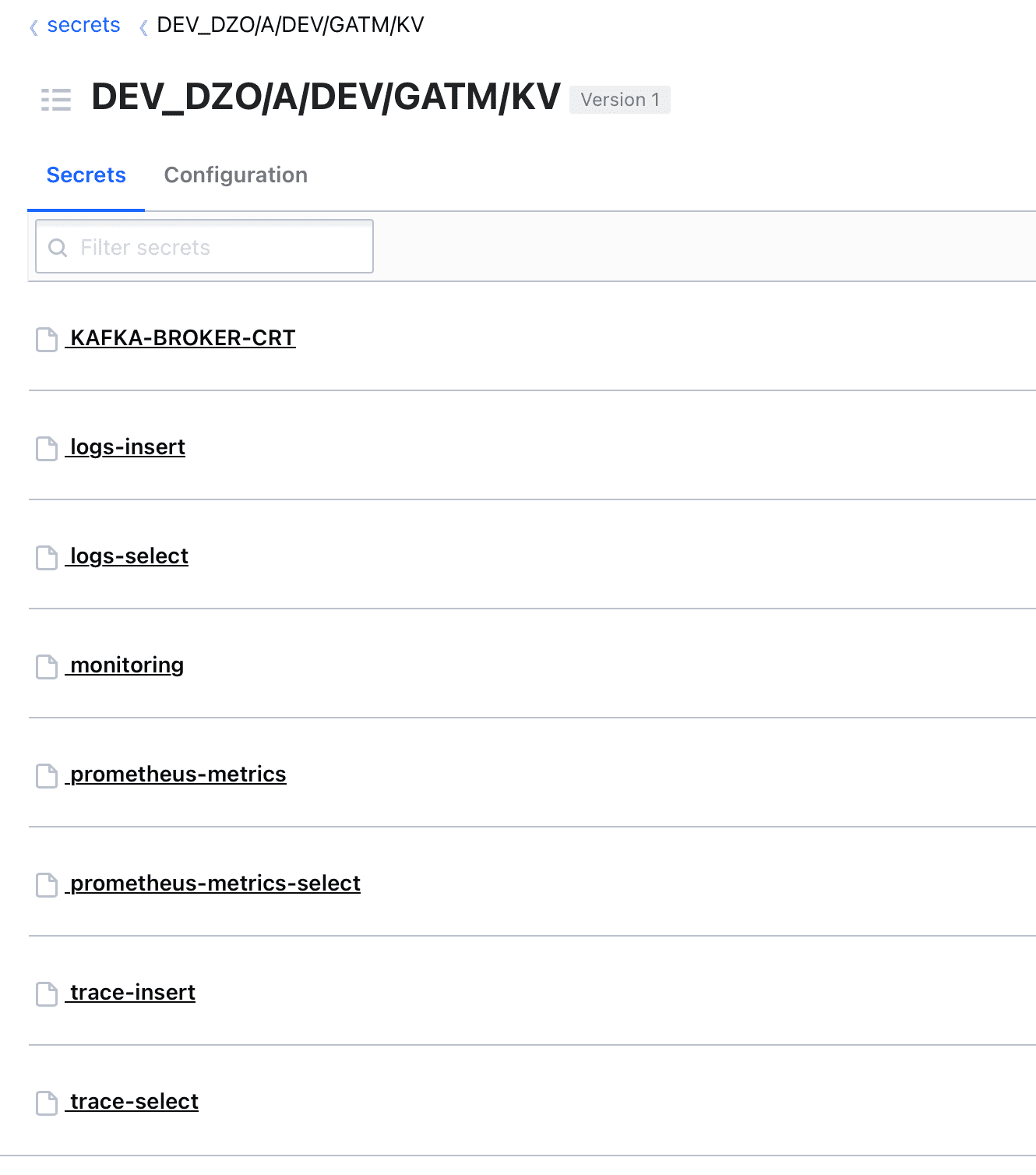

Использование KV (key value) хранилища для сертификатов

Необходимо предварительно реализовать ряд работ по настройке интеграционных взаимодействий vault:

Реализовать хранилище секретов (vault), где предварительно создать сертификаты и ключи:

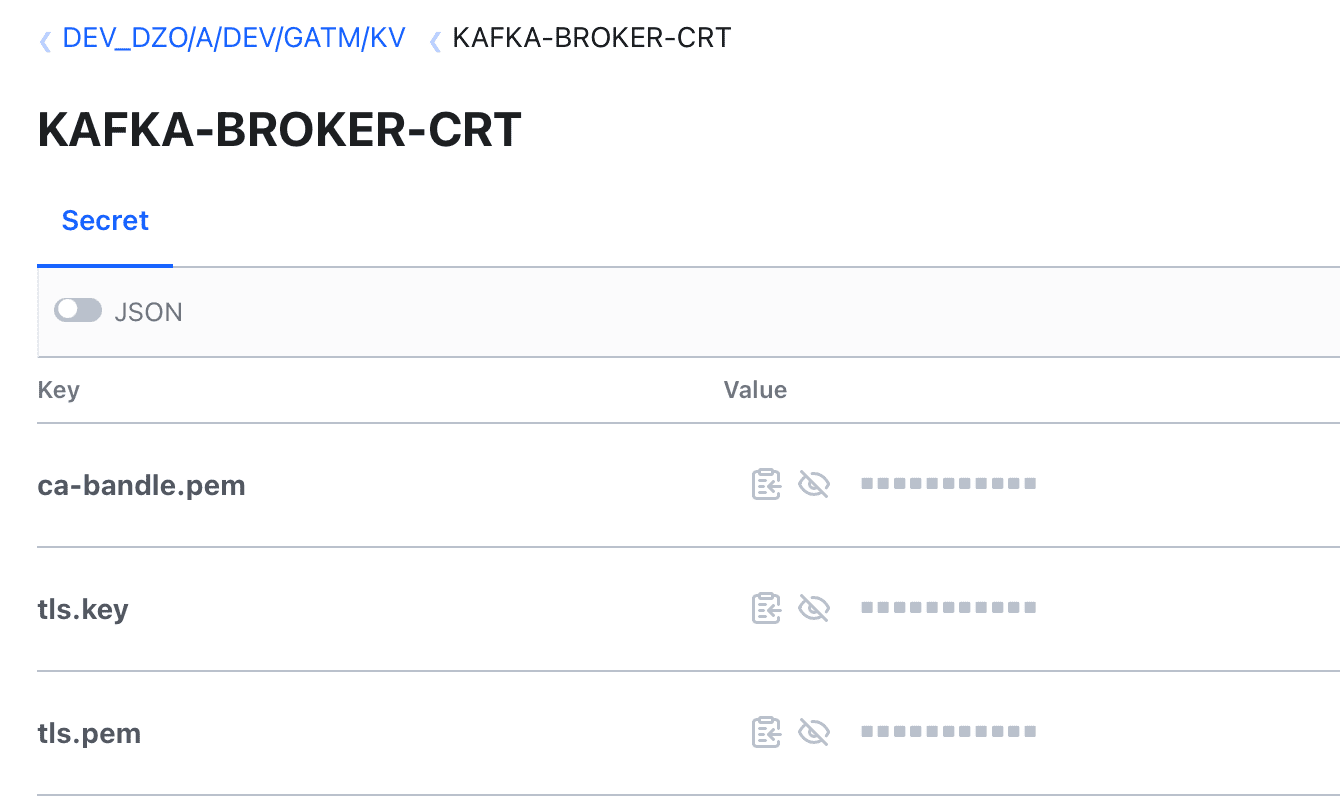

KAFKA-BROKER-CRT - опциональные сертификаты и ключ для успешного взаимодействия c Kafka (ca-bandle.pem/tls.pem/tls.key), про правила формирования необходимо уточнить в документации используемой Kafka

monitoring - опциональный сертификат при организации шифрования на egressgateway по сбору системных метрик (tls.crt - клиентский сертификат для обращения в сервис системных метрик, tls.key - приватный ключ)

prometheus-metrics - опциональный сертификата для организации входящего трафика (запись) по записи метрик или записи метрик в хранилище типа Prometheus (metrics-ca-chain.pem/metrics.crt/metrics.key)

prometheus-metrics-select - опциональный сертификата для организации входящего трафика (чтение) метрик (metrics-select-ca-chain.pem/metrics-select.crt/metrics-select.key)

logs-insert - опциональный сертификата для организации входящего трафика (запись) по записи логов в хранилище GATM (logs-insert-ca-chain.pem/logs-insert.crt/logs-insert.key)

logs-select - опциональный сертификата для организации входящего трафика (чтение) логов (logs-select-ca-chain.pem/logs-select.crt/logs-select.key)

trace-insert - опциональный сертификата для организации входящего трафика (запись) по записи трассировок в хранилище GATM (trace-insert-ca-chain.pem/trace-insert.crt/trace-insert.key)

trace-select - опциональный сертификата для организации входящего трафика (чтение) трассировок (trace-select-ca-chain.pem/trace-select.crt/trace-select.key)

Пример реализации секретов в системе vault.

Пример реализации секретов в системе vault.

Обращаем внимание, что используется «version: 1», в рамках создания хранилища секретов (kv).

Пример секрета для интеграции с Kafka.

Пример секрета для интеграции с Kafka.

Использование PKI engine хранилища для сертификатов

При использовании функции PKI engine приложения vault, необходимо реализовать хранилище указанного формата, более подробно можно ознакомиться на сайте vault.

ВАЖНО! При реализации директории, в рамках которой будет организовано хранилище PKI engine, необходимо придерживаться следующего пути /, где:

- значение аннотации vault в рамках приложения «vault.hashicorp.com/namespace»

- путь к каталогу, где будет реализован PKI engine, также необходимо указывать метод запроса, например «issue» и наименование роли, в рамках которой будет реализован сертификат

Пример итогового пути к PKI engine будет выглядеть следующим образом - «DEV/PKI/issue/role».

Реализация в рамках конфигурационных файлов, на примере генерации сертификата для Kafka:

{{`{{- with secret`}} "{{ .Values.vault.secmanNamespace }}/{{ .Values.vault.pki_engine.egress.kafka.pki_path }}" "common_name={{ .Values.vault.pki_engine.egress.kafka.common_name }}" {{`-}} {{ .Data.certificate }} {{- end }}`}}

При выпуске сертификатов идет обращение в рамках «.Data» PKI engine:

Корневой сертификат - параметризуется в рамках стендозависимых параметров vault.pki_engine.(egress/ingress).*.data.ca.name, с опцией проводить работу с цепочкой сертификатов.

Клиентский, либо серверный сертификат -

Приватный ключ -

Использование указанной функции производится при установке приложения и активации стендозависимых параметров:

vault:

pki_engine:

enabled: 'false' # флаг, указывающий на использование PKI engine в рамках хранения сертификатов (общий, при указании 'false' все сертификаты будут использоваться из KV version 1)

egress: # группа сертификатов использующиеся для исходящего трафика

kafka: # группа параметров для сертификата по интеграции с Kafka

pki_enabled: 'false' # локальный флаг использования PKI engine

pki_path: PKI/issue/pki # частичный пусть к PKI engine путь формируется по структуре ({{ .Values.vault.secmanNamespace }}/{{ .Values.vault.pki_engine.egress.kafka.pki_path }}), также необходимо указывать метод запроса, например «issue» и наименование роли в рамках которой будет реализован сертификат

common_name: kafka.host # параметр в рамках указывающий «common_name» выпускаемого сертификата

data: # группа параметров для возможности изменения параметров по корневому сертификату

ca:

name: ca_chain # имя корневого сертификата в рамках PKI engine, пример реализации по умолчанию «{{ .Data.ca_chain }}»

range: 'false' # флаг использования «range» для реализации цепочки сертификатов ({{ range $k, $v := .Data.ca_chain }} {{- $v }} {{- end -}})

prometheus: # группа параметров для сертификата по интеграции с Prometheus (при использовании)

pki_enabled: 'false'

pki_path: PKI/issue/pki

common_name: prometheus.host

data:

ca:

name: ca_chain

range: 'false'

monitoring: # группа параметров для сертификата по интеграции с сервером системных метрик (при использовании сертификатов из vault)

pki_enabled: 'false'

pki_path: PKI/issue/pki

common_name: federate.host

data:

ca:

name: issuing_ca

range: 'false'

ingress: # группа сертификатов использующиеся для входящего трафика (при использовании)

metrics: # группа сертификатов для реализации входящего трафика по метрикам (при использовании)

insert: # сертификаты для реализации входящего трафика для записи метрик (при использовании)

pki_enabled: 'false'

pki_path: PKI/issue/pki

common_name: synapse-metrics-insert.host

data:

ca:

name: ca_chain

range: 'false'

select: # сертификаты для реализации входящего трафика для чтения метрик (при использовании)

pki_enabled: 'false'

pki_path: PKI/issue/pki

common_name: synapse-metrics-select.host

data:

ca:

name: ca_chain

range: 'false'

traces: # группа сертификатов для реализации входящего трафика по трассировкам (при использовании)

insert: # сертификаты для реализации входящего трафика для записи трассировок (при использовании)

pki_enabled: 'false'

pki_path: PKI/issue/pki

common_name: synapse-trace-insert.host

data:

ca:

name: ca_chain

range: 'false'

select: # сертификаты для реализации входящего трафика для чтения трассировок (при использовании)

pki_enabled: 'false'

pki_path: PKI/issue/pki

common_name: synapse-trace-select.host

data:

ca:

name: ca_chain

range: 'false'

logs: # группа сертификатов для реализации входящего трафика по логам (при использовании)

insert: # сертификаты для реализации входящего трафика для записи логов (при использовании)

pki_enabled: 'false'

pki_path: PKI/issue/pki

common_name: synapse-logs-insert.host

data:

ca:

name: ca_chain

range: 'false'

select: # сертификаты для реализации входящего трафика для чтения логов (при использовании)

pki_enabled: 'false'

pki_path: PKI/issue/pki

common_name: synapse-logs-select.host

data:

ca:

name: ca_chain

range: 'false'

Реализация сертификатов

Сертификаты должны быть сформированы по уникальному адресу для организации входящего трафика:

наименование сертификата

prometheus-metrics- synapse-metrics-insert.наименование сертификата

prometheus-metrics-select- synapse-metrics-select.наименование сертификата

logs-insert- synapse-logs-insert.наименование сертификата

logs-select- synapse-logs-select.наименование сертификата

trace-insert- synapse-trace-insert.наименование сертификата

trace-select- synapse-trace-select.

Где:

- стендозависимый параметр, который унифицирует адрес (если предусматривается одна установка в рамках кластера, то параметр устанавливается пустым)

- стендозависимый параметр, конкретизирует домен кластера для организации внешнего запроса

Пример адреса - synapse-logs-insert.apps.ocp.cluster.solution.ru

Использование сертификатов с использованием «kind: Secret»#

Актуально в рамках использования чарта «gatm».

Если отсутствует возможность использовать внешнюю систему хранения секретов vault, то необходимо будет реализовать ряд действий после установки компонентов, а именно, реализовать конфигурации «kind: Secret» и произвести процедуру монтирования сертификатов в рамках «kind: Deployment» приложений Ingressgateway/Egressgateway.

Примеры реализации «kind: Secret» для Egressgateway:

kind: Secret

apiVersion: v1

metadata:

name: kafka

data:

tengri_ca.cer: *

tengri.pem: *

tengri.key: *

type: Opaque

---

kind: Secret

apiVersion: v1

metadata:

name: system-metrics

data:

tls.key: *

tls.pem: *

type: Opaque

Пример реализации монтирования сертификатов в рамках «kind: Deployment» Egressgateway:

kind: Deployment

apiVersion: apps/v1

metadata:

name: egw-syn-metrics-{{ .Release.Namespace }}

spec:

...

template:

spec:

containers:

- name: istio-proxy

volumeMounts:

- name: system-metrics

mountPath: /secret/config/system-metrics

- name: kafka

mountPath: /secret/config/ssl

...

volumes:

- name: system-metrics

secret:

secretName: system-metrics

defaultMode: 256

optional: true

- name: kafka

secret:

secretName: kafka

defaultMode: 256

optional: true

Примеры реализации «kind: Secret» для Ingressgateway:

kind: Secret

apiVersion: v1

metadata:

name: prometheus-metrics

data:

metrics-ca-chain.pem: *

metrics.crt: *

metrics.key: *

type: Opaque

---

kind: Secret

apiVersion: v1

metadata:

name: prometheus-metrics-select

data:

metrics-select-ca-chain.pem: *

metrics-select.crt: *

metrics-select.key: *

type: Opaque

---

kind: Secret

apiVersion: v1

metadata:

name: logs-insert

data:

logs-insert-ca-chain.pem: *

logs-insert.crt: *

logs-insert.key: *

type: Opaque

---

kind: Secret

apiVersion: v1

metadata:

name: logs-select

data:

logs-select-ca-chain.pem: *

logs-select.crt: *

logs-select.key: *

type: Opaque

---

kind: Secret

apiVersion: v1

metadata:

name: trace-insert

data:

trace-insert-ca-chain.pem: *

trace-insert.crt: *

trace-insert.key: *

type: Opaque

---

kind: Secret

apiVersion: v1

metadata:

name: trace-select

data:

trace-select-ca-chain.pem: *

trace-select.crt: *

trace-select.key: *

type: Opaque

Пример реализации монтирования сертификатов в рамках «kind: Deployment» Ingressgateway:

kind: Deployment

apiVersion: apps/v1

metadata:

name: igw-syn-metrics-{{ .Release.Namespace }}

spec:

...

template:

spec:

containers:

- name: istio-proxy

- name: trace-insert

mountPath: /secret/config/trace-insert

- name: prometheus-metrics

mountPath: /secret/config/prometheus-metrics

- name: trace-select

mountPath: /secret/config/trace-select

- name: prometheus-metrics-select

mountPath: /secret/config/prometheus-metrics-select

- name: logs-insert

mountPath: /secret/config/logs-insert

- name: logs-select

mountPath: /secret/config/logs-select

...

volumes:

- name: trace-insert

secret:

secretName: trace-insert

defaultMode: 256

optional: true

- name: trace-select

secret:

secretName: trace-select

defaultMode: 256

optional: true

- name: prometheus-metrics

secret:

secretName: prometheus-metrics

defaultMode: 256

optional: true

- name: prometheus-metrics-select

secret:

secretName: prometheus-metrics-select

defaultMode: 256

optional: true

- name: logs-insert

secret:

secretName: logs-insert

defaultMode: 256

optional: true

- name: logs-select

secret:

secretName: logs-select

defaultMode: 256

optional: true

При автоматической установке сервиса необходимо убедиться, что выполнены шаги разделов «1. Создать директорию установки» и «3. Установить необходимый перечень ресурсов».

Автоматическая установка сервиса#

Пример в рамках использования чарта «gatm».

Автоматическая установка подразумевает использование компонента SMDL, при использовании Job «SynapseInstaller».

Первым шагом определяем месторасположение Git репозитория, в рамках которого, в дальнейшем, будет применяться файл со стендозависимыми параметрами (указанную информацию необходимо уточнить у администратора, который производил установку и настройку SMDL).

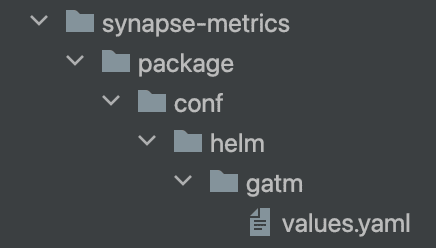

Создаем файл с наименованием «values.yaml» для компонента GATM по пути Git репозитория - synapse-config-dev-gen/${имя проекта для установки}/package/conf/helm/gatm/values.yaml

Рисунок. Пример расположения стендозависимого файла с параметрами

Далее заполняем файл «values.yaml» по примерам, которые указаны в рамках указанного документа в разделе «Примеры стендозависимых параметров для установки», также для более детальной установки можно ознакомиться с разделом «Описание всех стендозависимых параметров».

Запустить job, компонента SMDL, «SynapseInstaller» (более подробно о настройке и запуске можно ознакомиться в документации компонента «SMDL», «Руководство оператора» раздел «SynapseInstaller»).

Ручная установка сервиса#

Необходимо убедиться, что в рамках персонального компьютера установлен Helm версии не ниже 3.0.

Для ручной установки сервиса выполните следующие действия (пример в рамках использования чарта «gatm»):

Загрузить артефакт компонента GATM с конфигурациями для установки (gatm-cfg-*) в рамках дистрибутива продукта

При необходимости провести корректировку конфигураций, располагаемых в каталоге «./package/conf/helm/application/gatm/templates/*» (например, провести подстановку image приложений, либо задать свои правила по сбору метрик)

Перейти в рамках терминала в каталог «./package/conf/helm/application/»

Провести авторизацию через терминал в кластер, где планируется установка компонента GATM (пример для Openshift «oc login –token=$ТОКЕН –server=$АДРЕС_КЛАСТЕРА»)

Пройти в namespace, где планируется установка компонента GATM (пример для Openshift «oc project synapse-metrics»)

Создать файл с произвольным наименованием, например «values-cluster.yaml» в рамках пути «./package/conf/helm/application/gatm/»

Провести заполнение файла «./package/conf/helm/application/gatm/values-cluster.yaml» (описание параметров описано в указанном документе, раздел «Примеры стендозависимых параметров для установки», также для более детальной установки можно ознакомиться с разделом «Описание всех стендозависимых параметров»)

Провести установку компонента GATM - «helm install gatm gatm/ –values gatm/values-cluster.yaml»; При необходимости удалить компонент GATM - «helm delete gatm».

Примеры стендозависимых параметров для установки#

Примеры в рамках использования чарта «gatm».

В данном разделе будет представлен минимальный набор стендозависимых параметров для установки GATM.

Вариант установки приложений „agent“ и „adapter“ для сбора сетевых метрик с пользовательского проекта и дальнейшей передачи в Kafka.

Платформа Openshift.

global:

registry: moi.space

clusterName: moi.cluster

#registry: moi.space # используется, если не произведена автоматическая сборка и не произведена замена на .Values.global.registry

registry_path: PATH/ # Docker path, где расположены образы приложения GATM

projectedKubeAPI_openshift_cm: 'true' # монтирование сертификата («kind: ConfigMap» с наименованием «openshift-service-ca.crt»)

kubeAPIIP: XXX.XXX.X.X # IP-адрес сервиса KubeAPI (kubernetes.default.svc.cluster.local), можно уточнить у администраторов кластера

useControl: ose-se # используемая версия Istio и платформа, при использовании версии 1.6 (в рамках платформы Openshift) необходимо указать значение «ose», а при использовании контрольной панели POLM реализовать значение «ose-se», при установке в рамках платформы Kubernetes «k8s»

seccompProfile: 'false' # использование параметра seccompProfile в рамках секции Deployment «securityContext», применимо для платформы Kubernetes 1.25 и выше

image_pull_secret: default-secret # наименование imagePullSecrets для успешного обращения в docker registry

deploy: user # стратегия сбора метрик, параметр «user» - сбор сетевых метрик с пользовательского namespace

system_metrics: 'false' # организация сбора системных метрик (для платформы Openshift это federate.openshift-monitoring.svc.cluster.local), при условии использования указанного сервиса для сбора системных метрик

use_storage_sm: 'false' # установка серверной части приложений GATM по хранению метрик (опционально проведение агрегации метрик, при установке приложения alert)

enabled_metric_relabel_configs: 'false' # флаг активации фильтра по передаче метрик

agent:

scrapeCluster: cluster1 # идентификатор кластера

adapter:

kafkaBrokersList: kafka.apps.ocp.cluster.solution.ru:9093 # любое значение

kafkaTopic: topic1 # используемый топик Kafka

install_event_exporter: 'false' # необходимость в установке приложения event-exporter (по умолчанию true)

# по умолчанию будет использоваться порт 9093

kafkaPort: 443 # внешний порт брокера

kafka:

- host: kafka.apps.ocp.cluster.solution.ru # хост брокера

kafka_mesh_virtual_port: 19093 # порт брокера kafka mesh, по умолчанию используется функционал IGEG bootstrap-cервер через egress

kafka_mesh_virtual_host: kafka.host # хост брокера kafka mesh

egress:

serviceIstiod: istiod-istio-system # наименование сервиса контрольной панели, компонента «istiod»

istioControlPlane: istio-system # наименование namespace контрольной панели, к которой подключен namespace компонента GATM

vault:

kv: DEV_DZO/A/DEV/GATM/KV # путь к секретам vault во внешнем хранилище (KV version 1)

secmanNamespace: DEV # namespace vault во внешнем хранилище

secmanRole: role-ga-secman-gatm # роль vault во внешнем хранилище с доступом на чтение секретов

auth_path_enabled: 'true' # флаг использования аннотации «vault.hashicorp.com/auth-path» в рамках доступа к хранилищу vault

auth_path: auth/gatm # значение аннотации «vault.hashicorp.com/auth-path» в рамках доступа к хранилищу vault

scrape_srls_pods: # сбор метрик с приложения SRLS

scrape: "false"

При реализации указанных параметров в рамках кластера будет установлено 3 приложения: „agent“, „adapter“ и Egressgateway.

Сбор сетевых метрик (с контейнеров Istio-proxy) будет производиться в проекте, где реализована установка GATM.

Вариант развертывания приложений „agent“ и „adapter“ в рамках одной Pod, а также установка приложения event-exporter для сбора событий в рамках проекта.

Платформа Openshift.

global:

registry: moi.space

clusterName: moi.cluster

#registry: moi.space

registry_path: PATH/

projectedKubeAPI_openshift_cm: 'true'

kubeAPIIP: XXX.XXX.X.X

useControl: ose-se

seccompProfile: 'false'

image_pull_secret: default-secret

deploy: user

system_metrics: 'false'

use_storage_sm: 'false'

enabled_metric_relabel_configs: 'false'

agent:

scrapeCluster: cluster1

adapter:

kafkaBrokersList: kafka.apps.ocp.cluster.solution.ru:9093

kafkaTopic: topic1

# по умолчанию будет использоваться порт 9093

kafkaPort: 443

kafka:

- host: kafka.apps.ocp.cluster.solution.ru

kafka_mesh_virtual_port: 19093

kafka_mesh_virtual_host: kafka.host

egress:

serviceIstiod: istiod-istio-system

istioControlPlane: istio-system

vault:

kv: DEV_DZO/A/DEV/GATM/KV

secmanNamespace: DEV

secmanRole: role-ga-secman-gatm

scrape_srls_pods:

scrape: "false"

singlePodAdapter: 'false' # установка приложения kafka_adapter в рамках отдельного Pod

event_exporter:

get_events_namespaces: 'gatm-ns' # имена проектов, с которых будет производитьcя сбор event (пример с указанием нескольких namespace - 'synapse-metrics-system,istio-system')

При реализации указанных параметров в рамках кластера будет установлено 4 приложения „agent“, „adapter“ (в рамках одной Pod), event exporter и Egressgateway.

Сбор сетевых метрик (с контейнеров Istio-proxy) и событий («kind: Event»), будет производиться в проекте, где реализована установка GATM.

Вариант развертывания приложений „agent“, серверная часть (insert, select, „storage“), настройка сбора системных метрик и запись собранных метрик в рамках локального хранилища GATM.

Платформа Openshift.

Также использование фильтра при сборе метрик.

global:

registry: moi.space

clusterName: moi.cluster

#registry: moi.space

registry_path: PATH/

projectedKubeAPI_openshift_cm: 'true' # монтирование сертификата («kind: ConfigMap» с наименованием «openshift-service-ca.crt»)

kubeAPIIP: XXX.XXX.X.X

useControl: ose-se

seccompProfile: 'false'

deploy: user

system_metrics: 'true' # организация сбора системных метрик (для платформы Openshift это federate.openshift-monitoring.svc.cluster.local)

federateIP: ZZ.ZZZ.ZZZ.ZZ # опциональный, IP-адрес сервиса federate (пример для Openshift - federate.openshift-monitoring.svc.cluster.local), при условии использования указанного сервиса для сбора системных метрик

enabled_metric_relabel_configs: 'true' # флаг активации фильтра по передаче метрик

system_metrics_targets: # сбор системных метрик (/federate) по списку

- name: own # уникальное имя для идентификации job по scrape

namespace: smdemo1 # namespace для сбора системных метрик

relabel_regex: "('|kube_pod_container_resource_requests|node_namespace_pod_container:container_cpu_usage_seconds_total:sum_rate|kube_pod_container_resource_limits|container_memory_working_set_bytes|kube_pod_container_resource_requests|kube_pod_container_resource_limits|kube_deployment_status_replicas_available|kube_deployment_status_replicas|container_memory_usage_bytes|')" # регулярное выражение по фильтру передаваемых метрик в kafka, по системным метрикам (указывается при установке флага enabled_metric_relabel_configs: 'true')

add_serviceaccount: 'true'

agent:

scrapeCluster: cluster1

remoteWrite:

kafka: 'false' # флаг передачи метрик в рамках kafka (будет использоваться интеграция с приложением GATM kafka adapter)

kafka_egress_config_apply: 'false' # флаг установки конфигураций Istio для организации сетевого взаимодействия через egressgateway

use_storage_sm: 'true' # установка серверной части приложений GATM по хранению метрик (опционально проведение агрегации метрик, при установке приложения alert)

install_alert: "false"

install_kafka_adapter: 'false' # необходимость в установке приложения kafka adapter

scrape_srls_pods:

scrape: "false"

egress:

serviceIstiod: istiod-istio-system

istioControlPlane: istio-system

system_metrics_ca_crt_name: service-ca.crt # наименование сертификата по обращению к сервису сбора системных метрик

При реализации указанных параметров в рамках кластера будет установлено 5 приложений „agent“, select, insert, „storage“ и Egressgateway.

Сбор сетевых метрик (с контейнеров Istio-proxy) будет производиться в проекте, где реализована установка GATM, также организован сбор системных метрик из указанного проекта в параметрах.

Вариант развертывания приложений „agent“, серверная часть (insert, select, „storage“), реализации агрегации метрик (alert), запись собранных метрик в рамках локального хранилища GATM.

Платформа Kubernetes.

Также будет организован сбор метрик с контрольной панели.

global:

registry: moi.space

clusterName: moi.cluster

#registry: moi.space

kubeAPIIP: XXX.XXX.X.X

deploy: all # стратегия сбора метрик, параметр «all» - сбор сетевых метрик с пользовательского namespace

system_metrics_ca_crt_name: ca.crt # наименование сертификата по обращению к сервису сбора системных метрик (service-ca.crt при установке в Openshift (по умолчанию) и ca.crt при установке в Kubernetes)

projectedKubeAPI_openshift_cm: 'false' # монтирование сертификата («kind: ConfigMap» с наименованием «openshift-service-ca.crt»)

affinityMatchKey: 'kubernetes.io/arch' # актуализация affinityMatchKey в рамках IGEG

system_metrics: 'true'

federateIP: ZZ.ZZZ.ZZZ.ZZ

system_metrics_targets:

- name: own

namespace: gatm

k8s_system_metrics: # при установке на Kubernetes (useControl: k8s) указание endpoint по предоставлению системных метрик

host: prometheus-service.kube-system.svc.cluster.local

port: 8443

add_serviceaccount: 'true'

image_pull_secret: default-secret

agent_alert:

labelAdd: 'cluster=cluster1.ru' # идентификатор кластера, указанный параметр будет добавлен в метки (label) собранных метрик

agent:

scrapeCluster: cluster1.ru

remoteWrite:

kafka: 'false'

kafka_egress_config_apply: 'false'

scrape_srls_pods:

scrape: "false"

use_storage_sm: 'true'

install_kafka_adapter: 'false'

podDisruptionBudget:

apiVersion: policy/v1

egress:

serviceIstiod: istiod-istio-system

istioControlPlane: istio-system

При реализации указанных параметров в рамках кластера будет установлено 6 приложений „agent“, select, insert, „storage“, alert и Egressgateway.

Сбор сетевых метрик (с контейнеров Istio-proxy) будет производиться в проекте, где реализована установка GATM, организован сбор системных метрик из указанного проекта в параметрах и сбор метрик с контрольной панели.

Агрегация метрик производиться в рамках системных метрик.

Вариант развертывания приложения

tenant-agentдля сбора системных метрик в рамках локального хранилища GATM.

В данном примере мы обогащаем сбор текущих метрик из примера номер 4 и производим установку еще одного приложения „agent“, для сбора сетевых и системных метрик пользовательского проекта, указанная механика позволяет планировать ресурсы на список проектов, которые уже добавлены в мониторинг и масштабировать приложения в рамках конкретного тенанта.

Также есть возможность устанавливать приложения event-exporter, egress, „adapter“ в рамках тенанта, для обеспечения независимой нагрузки при сборе и передаче данных.

Платформа Kubernetes.

global:

registry: moi.space

clusterName: moi.cluster

#registry: moi.space

kubeAPIIP: XXX.XXX.X.X

deploy: all

system_metrics_ca_crt_name: ca.crt

projectedKubeAPI_openshift_cm: 'false'

affinityMatchKey: 'kubernetes.io/arch'

system_metrics: 'true'

federateIP: ZZ.ZZZ.ZZZ.ZZ

system_metrics_targets:

- name: own

namespace: gatm

k8s_system_metrics:

host: prometheus-service.kube-system.svc.cluster.local

port: 8443

add_serviceaccount: 'true'

image_pull_secret: default-secret

agent_alert:

labelAdd: 'cluster=cluster1.ru'

agent:

scrapeCluster: cluster1.ru

remoteWrite:

kafka: 'false'

kafka_egress_config_apply: 'false'

scrape_srls_pods:

scrape: "false"

use_storage_sm: 'true'

install_kafka_adapter: 'false'

podDisruptionBudget:

apiVersion: policy/v1

egress:

serviceIstiod: istiod-istio-system

istioControlPlane: istio-system

# минимальный набор параметров в рамках тенанта (параметры идентичны в рамках параметризации основного тенанта, который параметризуется в корне стендозависимых параметров)

tenant_agent:

- index: 'user' # уникальный идентификатор тенанта, префикс которого будет указываться в рамках установки приложений

use_storage_sm: 'true'

install_agent: 'true'

agent:

tenant: '0'

replicas: 1

remoteWrite:

kafka: "false"

externalPrometheus:

integration: 'false'

createConfig: 'false'

maxScrapeSize: 1Gib

maxDiskUsagePerURL: 1Gib

use_sa_prometheus: 'false'

scrapeInterval: 1m

scrapeTimeOut: 1m

scrapeCluster: 'moi.cluster.tenant'

queues: 8

svpx:

resources:

limits:

cpu: 300m

memory: 300Mi

requests:

cpu: 300m

memory: 300Mi

livenessProbe:

failureThreshold: 30

initialDelaySeconds: 5

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 5

readinessProbe:

failureThreshold: 30

initialDelaySeconds: 5

periodSeconds: 10

successThreshold: 1

timeoutSeconds: 5

resources:

limits:

cpu: 300m

ephemeral_storage: 500Mi

memory: 300Mi

requests:

cpu: 300m

ephemeral_storage: 500Mi

memory: 300Mi

istio_control: # необходимость сбора метрик из контрольной панели

scrape: "false"

scrape_srls_pods: # необходимость сбора метрик из приложений SRLS

scrape: "false"

istio_pods: # необходимость сбора сетевых метрик с istio-proxy

scrape: "true"

scrape_interval: 30s

scrape_timeout: 30s

relabel_get_label:

stats: 'false'

namespace: 'true'

pod_name: 'true'

enabled_metric_relabel_configs: 'false'

scrape_own_namespace: 'false'

scrape_all_namespace: 'false'

scrape_namespaces:

- name: srls

system_metrics_targets: # сбор системных метрик

- name: srls

scrape: "true"

enabled_metric_relabel_configs: "true"

relabel_regex: "('|container_memory_working_set_bytes|kube_pod_info|container_cpu_usage_seconds_total|kube_pod_container_resource_requests|kube_pod_container_resource_limitkube_deployment_status_replicas_unavailable|kube_deployment_status_replicas_available|kube_statefulset_status_replicas_ready|kube_statefulset_status_replicakube_deployment_status_replicas|container_memory_usage_bytes|kube_daemonset_status_number_unavailable|version|label_platformv_sber_ru_release_version|kube_resourcequotkube_pod_labels|container_sockets|kube_daemonset_status_updated_number_scheduled|kube_pod_container_status_restarts_total|')"

namespace: synapse-custom-namespace

install_adapter: 'false'

adapter:

kafka_egress_config_apply: 'false'

install_egress: 'false' # необходимость установки дополнительного egress

install_event_exporter: 'false' # необходимость установки дополнительного event-exporter

event_exporter:

scrape_interval: 1s # обязательно указывается для корректного подсчета hash конфигураций для сбора

scrape_timeout: 1m

check_config:

jobs:

- name_metric: istiod_readiness_tenant3

Рассмотрим опциональные параметры по организации проекта GATM.

Организация входящего трафика в рамках проекта, поддерживается настройка nginx.

При реализации установки Ingressgateway необходимо реализовать сертификаты для организации входящего трафика, более подробно описано в рамках раздела «Предусловия».

# установка Ingressgateway для организации входящего трафика в рамках проекта (mTLS)

install_ingress: 'true' # флаг установки Ingressgateway, при установке будут реализованы конфигурации на запись («kind: Route»/«kind: Ingress» в зависимости от выбранной платформы) метрик и опционально логов и трассировок

ingress:

route_select: 'true' # реализация входящего трафика по запросам на сбор метрик

route_select_trace: 'true' # реализация входящего трафика по запросам на сбор трассировок

route_select_logs: 'true' # реализация входящего трафика по запросам на сбор логов

version: '1.17'

serviceIstiod: istiod-istio-system

istioControlPlane: istio-system

Установка серверной части логов и трассировок.

# установка 4-х приложений по организации серверной части по краткосрочному хранению трассировок

synapse_trace:

install: 'true'

maxTraces: 10000

# установка 3-х приложений по организации серверной части по краткосрочному хранению логов

synapse_logs:

install: 'true'

Описание всех возможных стендозависимых параметров представлено в следующем разделе документации.

Описание всех стендозависимых параметров#

Чарт «gatm».

values.yaml

#global:

# registry: moi.space # registry, в рамках которого реализован образ приложений

# clusterName: moi.cluster # опциональный параметр для конкретизации клаcтера, будет использоваться в рамках label передаваемых метрик

release_version: "1.9.0" # указать версию релиза

config_version: "1.9.0" # указать версию конфигурации

component_type: service

#registry: # при использовании указанного параметра, используется если не произведена автоматическая сборка и не произведена замена на .Values.global.registry

#registry_path_igegose: # при использовании выделенного path для istio 1.6

#registry_path_igegse117: # при использовании выделенного path для istio 1.17

#registry_path_igegse119: # при использовании выделенного path для istio 1.19

#registry_path_igegse: # при использовании выделенного path для istio 1.20

replicas: 1 # количество реплик приложения GATM (agent)

#registry_path: / # Docker path, где расположены образ приложения GATM

#cluster: app.cluster.ru # домен кластера, для организации входящего трафика в проект GATM, используется при реализации url

indexInstall: "" # префикс в рамках формирования URL для внешнего запроса (реализуется при установке Ingressgateway), например, при реализации этого параметра внешний адрес для реализации запроса будет формироваться по следующей структуре «synapse-logs-insert{{ .Values.indexInstall }}.{{ .Values.cluster }}»

kubeAPIIP: '*.*.*.*' # IP-адрес сервиса KubeAPI (kubernetes.default.svc.cluster.local) можно уточнить у администраторов кластера

kubePort: 443 # port сервиса KubeAPI (kubernetes.default.svc.cluster.local) можно уточнить у администраторов кластера

kubeAPIResolution: DNS # используемый resolution в рамках конфигурации «kind: ServiceEntry» для KubeAPI (kubernetes.default.svc.cluster.local)

kubeEgressRouting: TLS # реализация конфигураций Istio (TLS - перехват трафика в рамках tls, TCP - перехват трафика по tcp, DISABLE - инициация по HTTP протоколу и реализация сертификата на egress)

federateIP: '*.*.*.*' # опциональный, IP-адрес сервиса federate (пример для Openshift - federate.openshift-monitoring.svc.cluster.local), при условии использования указанного сервиса для сбора системных метрик

federateResolution: DNS # используемый resolution в рамках конфигурации «kind: ServiceEntry» для federate (пример для Openshift - federate.openshift-monitoring.svc.cluster.local)

deploy: control # стратегия сбора метрик, параметр «all» - сбор сетевых метрик с пользовательского namespace, с контейнеров «istio-proxy» и метрик контрольной панели приложения «istiod», параметр «user» - сбор сетевых метрик с пользовательского namespace, параметр «control» - сбор метрик контрольной панели приложения «istiod»

add_drs_scrape: 'true' # установка конфигурации «kind: DestinationRule в рамках используемых адресов по сбору метрик с istio-proxy, istiod и istio-operator

useControl: k8s # используемая версия Istio и платформа, при использовании версии 1.6 (в рамках платформы Openshift) необходимо указать значение «ose», а при использовании контрольной панели POLM реализовать значение «ose-se», при установке в рамках платформы Kubernetes «k8s»

system_metrics: 'true' # организация сбора системных метрик (для платформы Openshift это federate.openshift-monitoring.svc.cluster.local, для Kubernetes указывается в рамках «k8s_system_metrics»), при условии использования указанного сервиса для сбора системных метрик

system_metrics_ca_crt_name: ca.crt # наименование сертификата по обращению к сервису сбора системных метрик (service-ca.crt при установке в Openshift и ca.crt при установке в Kubernetes)

projectedKubeAPI: 'false' # флаг монтирования токена для работы с KubeAPI, если стоит значение false, то токен будет примонтирован автоматически, если true, то токен будет примонтирован в рамках «kind: Deployment»

projectedKubeAPI_openshift_cm: 'false' # монтирование сертификата («kind: ConfigMap» с наименованием «openshift-service-ca.crt»)

projectedKubeAPI_k8s_cm: 'true' # монтирование сертификата («kind: ConfigMap» с наименованием «kube-root-ca.crt»)

seccompProfile: 'true' # использование параметра seccompProfile в рамках секции Deployment «securityContext», применимо для платформы Kubernetes 1.25 и выше

generate_ephemeral_storage: 'false' # указание ephemeral-storage в контейнерах в рамках секций «kind: Deployment»/«kind: StatufulSet» resources

affinity: 'false' # реализация affinity, необходим для корректного распределение «kind: Pod» по нодам кластера

affinityMatchKey: 'kubernetes.io/arch' # реализация affinityMatchKey в рамках IGEG

affinityMatchValues: # реализация affinityMatchValues в рамках IGEG

- amd64

- ppc64le

- s390x

enabledPriorityClassName: 'false' # указание секции PriorityClassName в рамках конфигураций «kind: Deployment»/«kind: StatefulSet»

priorityClassName: system-cluster-critical # priorityClassName (при указании enabledPriorityClassName: 'true')

poddistruptionbudget: 'false' # флаг установки конфигурации «kind: PodDistruptionBudget»

use_storage_sm: 'true' # установка серверной части приложений GATM по хранению метрик (опционально проведение агрегации метрик, при установке приложения alert)