Руководство по установке#

О документе#

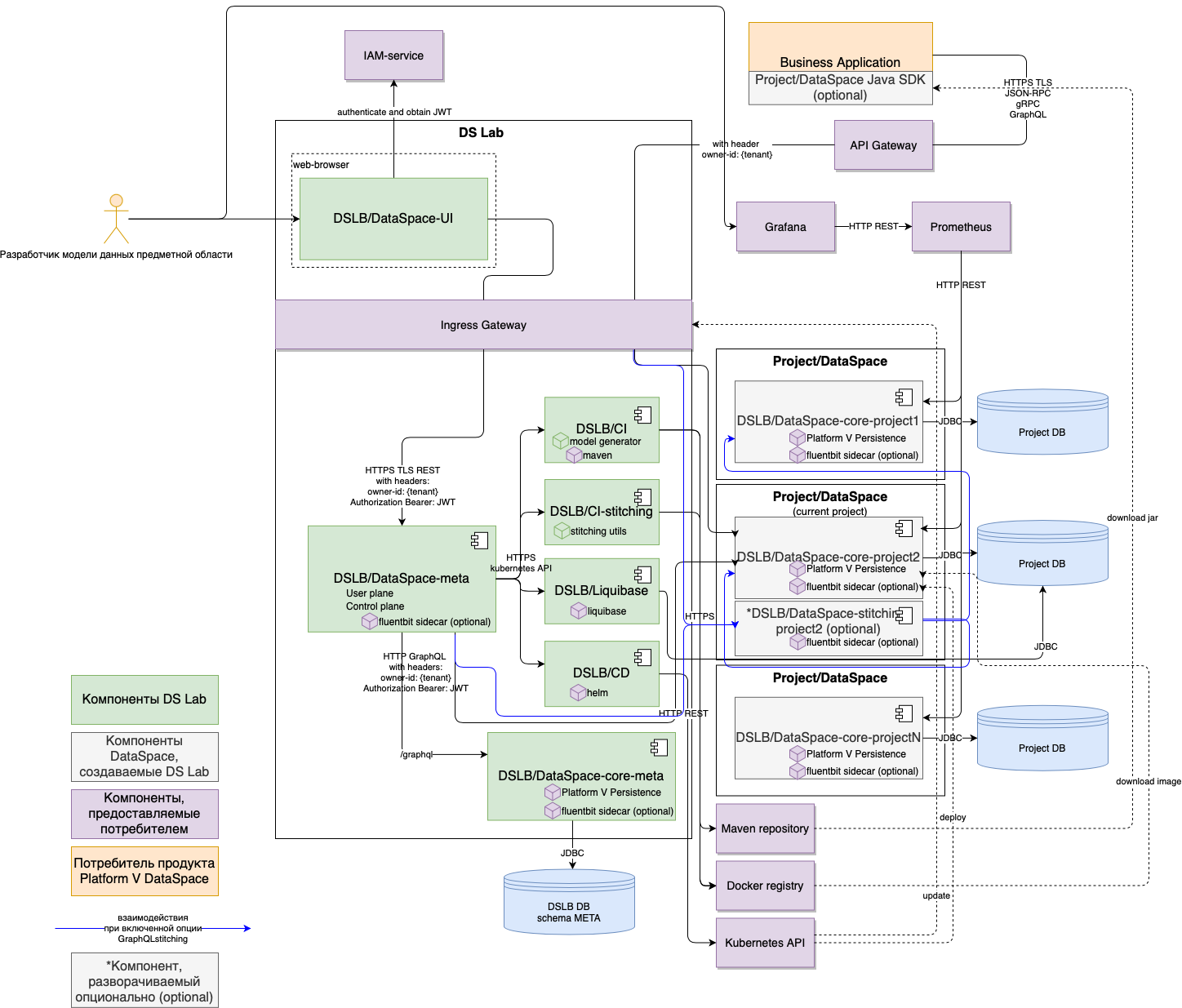

В руководстве приведены инструкции по установке компонента DS Lab (DSLB) (далее — DS Lab или компонент) продукта Platform V DataSpace (APT).

DS Lab — компонент, предоставляющий возможность описывать модель данных предметной области через UI и разворачивать модель в виде сервиса Platform V Dataspace для работы с этими данными: создание, изменение, удаление, объединение в транзакционные группы, гибкие возможности поиска и получения данных.

Расшифровку основных понятий см. в документе "Термины и определения".

Системные требования#

Настройки безопасности окружения и перечень платформенных (дополнительных внешних) продуктов, используемых для установки, настройки и контроля в конечной информационной системе (далее — ИС), выбираются клиентом при разработке конечной ИС, исходя из характера обрабатываемой в ней информации и иных требований информационной безопасности (далее — ИБ), предъявляемых к ней.

Системное программное обеспечение#

Имеются следующие требования к ПО:

На серверы приложений, использующих DataSpace, должна быть установлена среда контейнеризации Kubernetes, Red Hat OpenShift или аналогичная среда контейнеризации приложений.

Наличие БД для модуля dataspace-core-meta в режиме Standby.

Созданы и настроены два namespace в Kubernetes (или OpenShift):

namespace для клиентских сервисов;

namespace для остальных сервисов (nginx-controller или аналог(Istio)/dslab/prometheus).

Наличие Kubectl (CLI) на ПК, с которого производится установка.

Наличие пакетного менеджера Helm на ПК, с которого производится установка.

Наличие docker на машине для сборки images dataspace-core-meta/dataspace-meta/dslab-builder.

Наличие пакета Liquibase.

Опционально наличие jdbc-драйвера Oracle версии не ниже 21.5.0.0 в случае использования БД Oracle.

Доступ к частному или публичному registry image.

Доступ к частному или публичному package repository.

Доступ к следующим общим образам (в скобках приведены ссылки на hub.docker.com):

Ниже представлены категории системного программного обеспечения (далее — ПО), которые обязательны или опциональны для установки, настройки, контроля и функционирования компонента. В каждой категории перечислены все поддерживаемые продукты сторонних правообладателей. Отдельно обозначены варианты, которые рекомендует АО «СберТех» (маркировка «Рекомендовано» в столбце «Продукт, функциональная совместимость с которым подтверждена»). Клиенту необходимо выбрать один из продуктов в каждой категории, исходя из условий использования конечной ИС.

Категория ПО | Обязательность установки | Наименование ПО | Версия | Продукт, функциональная совместимость с которым подтверждена | Описание |

|---|---|---|---|---|---|

Операционная система | Да | Альт 8 СП | 10 и выше | Рекомендовано. Правообладателем АО «СберТех» также рекомендована операционная система, основанная на Linux — Platform V SberLinux OS Server (SLO), см. раздел «Платформенные зависимости» | Возможность функционирования продукта |

Среда контейнеризации | Да | 1.25 и выше | Рекомендовано. Правообладателем АО «СберТех» также рекомендована среда контейнеризации, основанная на Kubernetes — Platform V DropApp, см. раздел «Платформенные зависимости» | Область среды контейнеризации, выделенная под компоненты DataSpace Core и/или приложения потребителя | |

Red Hat OpenShift | 4 и выше | Опционально | |||

Командная строка | Да | Kubectl | Версия, соответствующая версии Kubernetes | Рекомендовано | Интерфейс командной строки для управления средой контейнеризации, являющийся его составной частью, устанавливаемой на рабочей станции |

OpenShift CLI | Версия, соответствующая версии OpenShift | Опционально | |||

Инструмент сборки, тестирования, развертывания контейнеризированных приложений | Нет | Любая актуальная версия | Рекомендовано | Сервер автоматизации, используемый для внедрения непрерывной интеграции и непрерывной доставки (CI/CD) для проектов программного обеспечения | |

Пакетный менеджер | Да | 3.4.1 и выше | Рекомендовано | Используется для установки компонента DataSpace Core в Kubernetes | |

Система сбора логов | Нет | 1.4.5 | Рекомендовано. Правообладателем АО «СберТех» также рекомендован компонент Журналирование (LOGA) Platform V Monitor (OPM), см. раздел «Платформенные зависимости» | Подготовка и публикация журналов приложения | |

Java-машина | Да | 11.0.16 и более высокая минорная версия | Рекомендовано | Возможность функционирования продукта | |

Система управления базами данных (СУБД) | Да | 12 и выше | Рекомендовано. Правообладателем АО «СберТех» также рекомендована СУБД, основанная на PostgreSQL, — Platform V Pangolin SE (PSQ), см. раздел «Платформенные зависимости» | Для хранения данных компонента DataSpace Core | |

Oracle Database | 12.2 и выше | Опционально | |||

1.4.200 | Опционально | ||||

Инструмент управления проектом | Да | 3.6.3 | Рекомендовано | Фреймворк для автоматизации сборки проектов на основе описания их структуры в файлах на языке POM | |

Сервис централизованного хранения репозиториев артефактов (хранилище артефактов) | Да | 2.5.1 и выше | Рекомендовано | Интегрированная платформа для проксирования, хранения и управления зависимостями Java (Maven), образами, а также распространения ПО | |

Nexus Repository Manager PRO | Любая актуальная версия | Опционально | |||

Nexus Repository Manager OSS | Любая актуальная версия | Опционально | |||

Сервис интеграции и оркестрации микросервисов в облаке | Да | 1.12 и выше | Рекомендовано. Правообладателем АО «СберТех» также рекомендован сервис интеграции и оркестрации микросервисов в облаке, основанный на Istio — Platform V Synapse Service Mesh (SSM), см. раздел «Платформенные зависимости» | Маршрутизация и защита межсервисных взаимодействий | |

1.3.2 | Опционально. Правообладателем АО «СберТех» также рекомендован сервис интеграции и орекстрации микросервисов в облаке, основанный на Istio — Platform V Synapse Service Mesh (SSM), см. раздел «Платформенные зависимости» | ||||

Система мониторинга (сбор и хранение метрик) | Нет | 2.22.2 и выше | Рекомендовано. Правообладателем АО «СберТех» также рекомендован Сервис для сбора прикладных и инфраструктурных метрик и отправки их в целевую систему хранения — Объединенный мониторинг Unimon (MONA) Platform V Monitor (OPM), см. раздел «Платформенные зависимости» | Сбор и хранение метрик мониторинга работы приложения | |

Система мониторинга (визуализация) | Нет | 7.3 и выше | Рекомендовано | Мониторинг работы приложения | |

IAM-система | Нет | 17.0.1 и выше | Рекомендовано. Правообладателем АО «СберТех» в качестве провайдера аутентификации OIDC также рекомендован компонент KeyCloak.SE (KCSE) продукта Platform V IAM SE (IAM), см. раздел «Платформенные зависимости» | Сервис аутентификации и управления доступом, предоставляющий JWT | |

Система для управления изменениями баз данных | Да | 4.9.1 | Рекомендовано | Управление БД | |

Средство контейнеризации | Да | Любая актуальная версия | Рекомендовано | Инструмент для автоматизации работы с контейнерами | |

Браузер | Да | Яндекс.Браузер | 19 и выше | Рекомендовано | Работа пользователя с продуктом |

Google Chrome | 90 и выше | Опционально | Работа пользователя с продуктом | ||

Cистема управления конфигурациями | Нет | 2.15.4 и выше | Рекомендовано | Cистема управления конфигурациями (SCM) | |

Интерпретатор языка программирования Groovy | Да | не выше версии 3 | Рекомендовано | Интерпретатор языка Groovy |

Примечание:

*

Да — категория ПО обязательна для функционирования сервиса (это означает, что сервис не может выполнять свои основные функции без установки данной категории ПО).

Нет — категория ПО необязательна для функционирования сервиса (это означает, что сервис может выполнять свои основные функции без установки данной категории ПО).

**

Рекомендовано — рекомендованный правообладателем АО «СберТех» продукт.

Опционально — альтернативный по отношению к рекомендованному правообладателем АО «СберТех» продукт.

Платформенные зависимости#

Для настройки, контроля и функционирования компонента реализована интеграция с программными продуктами, правообладателем которых является АО «СберТех»:

Наименование продукта | Код | Версия продукта | Код и наименование компонента | Обязательность установки (да/нет) | Описание | Аналог других производителей |

|---|---|---|---|---|---|---|

Platform V Pangolin SE | PSQ | 5.2.0 и выше | PSQL Pangolin | Да | Система управления базами данных, основанная на PostgreSQL | |

Platform V Synapse Service Mesh | SSM | 2.10 и выше | POLM Управление политиками | Да | Панель управления с открытым исходным кодом, служащая для взаимодействия, мониторинга и обеспечения безопасности контейнеров в среде контейнеризации Kubernetes | Istio control plane — Istio |

IGEG Граничный прокси | Да | Сервис для обеспечения управляемого вызова интеграционных сервисов прикладной части | Istio proxy — Istio | |||

Platform V Monitor | OPM | 4.1 и выше | LOGA Журналирование | Нет | Сервис для хранения лог-файлов | Любой сервис сбора записей о событиях, совместимый с технологией Fluent Вit |

MONA Объединенный мониторинг Unimon | Нет | Сервис для cбора и хранения метрик мониторинга | Любой сервис сбора и хранения метрик мониторинга, например, Prometheus | |||

Platform V DevOps Tools | DOT | 1.3 и выше | CDJE Deploy tools | Нет | Сервис для развертывания и обновления компонентов Платформы и приложений потребителей, для настройки и обслуживания инфраструктуры Платформы | Ручное развертывание |

CIJE Build tools | Нет | Сервис для сборки компонентов Платформы и приложений потребителей | Ручное развертывание | |||

Platform V IAM SE | IAM | 1.5 и выше | KCSE Keycloak.SE | Нет | Провайдер аутентификации OIDC | |

Platform V DropApp | K8S | 1.1 и выше | K8SС K8S Core | Да | Область среды контейнеризации, выделенная под компоненты DataSpace Core и/или приложения потребителя | Kubernetes, Red Hat OpenShift |

Platform V SberLinux OS Server | SLO | 8.8.2 и выше | INST Операционная система | Да | ОС контейнеров для запуска модулей компонента | Альт 8 СП, Red Hat Enterprise Linux |

Примечание:

***

Да — компонент или продукт необходим для функционирования сервиса (это означает, что сервис не может выполнять свои основные функции без установки данного компонента).

Нет — необязательный для функционирования сервиса компонент или продукт (это означает, что сервис может выполнять свои основные функции без установки данного компонента).

****Рекомендуется установка программного продукта, правообладателем которого является АО «СберТех», при этом не исключена возможность (допускается правообладателем) использования аналога других производителей. Аналоги, в отношении которых продукт успешно прошел испытания и подтвердил свою работоспособность, указаны в разделе «Системное программное обеспечение».

Для компонента обязательна интеграция со следующими компонентами из состава продукта Platform V DataSpace (APT):

Наименование компонента | Код | Описание |

|---|---|---|

DataSpace Core | DSPC | Разворачивание модели данных |

Аппаратные требования#

Минимальные требования для работы модулей DS Lab:

Для модуля dataspace-core-meta:

Процессор: 2 x CPU.

Оперативная память: 2 ГБ или больше.

Для модуля dataspace-meta:

Процессор: 1 x CPU.

Оперативная память: 1 ГБ или больше.

Минимальные требования для каждого разворачиваемого клиентского сервиса:

Процессор: 0.25 x CPU.

Оперативная память: 512 МБ.

Минимальные требования для вспомогательных модулей, запускаемых dataspace-meta:

Процессор: 2 x CPU.

Оперативная память: 2 ГБ или больше.

Типовые требования к серверу БД для модуля dataspace-core-meta:

СУБД на базе PostgreSQL;

CPU — 2 шт.;

RAM — 4 ГБ;

HDD — 40 ГБ;

IOPS — 1000.

Требования к кластеру среды контейнеризации приложений: должно быть не менее двух Node.

Состав дистрибутива#

Дистрибутив компонента DSLB представляет собой набор ZIP-архивов:

*dslb-bin-<номер дистрибутива>-distrib.zip, содержащий папки:

package/docker— папка с содержимым для формирования образов сервисов DataSpace;package/db— папка с архивом для проливки Liquibase-скриптов;package/ext— папка с model-jpa-артефактами для формирования образов.

*dslb-cfg-<номер дистрибутива>-distrib.zip, содержащий папку package/conf/helm — папка с Helm-манифестами для установки сервисов в среду контейнеризации.

Подготовка окружения#

Настройка namespace#

Namespace Kubernetes (OpenShift) будет считаться готовым к развертыванию компонента DS Lab после выполнения всех следующих требований:

Для namespace создан secret типа Dockersecret с логином и паролем ТУЗ для image pull.

Созданный secret прописан в service accounts:

default.Для namespace, в котором разворачивается ControlPlane и клиентские сервисы, создан ServiceAccount.

Для namespace, в котором разворачивается ControlPlane, создан secret с параметрами подключения к БД.

Для namespace клиентских сервисов создан секрет с kubeconfig.

Для namespace клиентских сервисов создан секрет с settings.xml.

Создание pull image secret#

Pull image secret создается в namespace:

kubectl create secret docker-registry <secret-name> --docker-server=<your-registry-server> --docker-username=<your-name> --docker-password=<your-pword> --docker-email=<your-email>

Создание ServiceAccount и выдача прав#

Необходимо выполнить следующие действия:

Создать ServiceAccount в namespace, в котором разворачивается ControlPlane и клиентские dataspace:

kubectl apply -f - <<EOF

apiVersion: v1

kind: ServiceAccount

metadata:

name: sa-dataspace

EOF

Для созданных ServiceAccount сгенерировать токен:

kubectl apply -f - <<EOF

apiVersion: v1

kind: Secret

metadata:

name: sa-dataspace-secret

annotations:

kubernetes.io/service-account.name: sa-dataspace

type: kubernetes.io/service-account-token

EOF

Примечание

Если используется Kubernetes версии 1.22 и ниже, данный шаг не обязателен, токен будет сгенерирован автоматически.

Создать RoleBinding для ServiceAccount в namespace ControlPlane:

kubectl create rolebinding sa-dataspace-admin --clusterrole=admin --serviceaccount=<ns_controlPlane>:sa-dataspace --namespace=<ns_controlPlane>

Создать RoleBinding для ServiceAccount в namespace клиентских dataspace:

kubectl create rolebinding sa-dataspace-admin --clusterrole=admin --serviceaccount=<ns_clients>:sa-dataspace --serviceaccount=<ns_controlPlane>:sa-dataspace --namespace=<ns_clients>

Примечание

Если для ControlPlane и клиентских dataspace используется общий namespace, данный шаг можно пропустить.

Создать RoleBinding для ServiceAccount в namespace клиентских dataspace:

kubectl create rolebinding sa-dataspace-admin --clusterrole=admin --serviceaccount=<ns_clients>:sa-dataspace --serviceaccount=<ns_controlPlane>:sa-dataspace --namespace=<ns_clients>

Примечание

Если для ControlPlane и клиентских dataspace используется общий namespace, данный шаг можно пропустить.

Для созданных ServiceAccount привязать pull image secret, созданный на шаге Создание pull image secret:

kubectl patch serviceaccount sa-dataspace -p '{"imagePullSecrets": [{"name": "<secret-name>"}]}'

При установке сервисов dataspace-core-meta и dataspace-meta в values.yaml указать имя используемого ServiceAccount:

serviceAccount:

name: sa-dataspace

Создание secret для подключения к БД#

Пример команды:

kubectl create secret generic <secret-name> --from-file=<имя файла>

Пример файла:

apiVersion: v1

kind: Secret

metadata:

name: main-db-secret

stringData:

secret.properties: |-

spring.datasource.username=<имя пользователя для DML операций>

spring.datasource.password=<пароль пользователя>

spring.datasource.url=<jdbc строка для подключения к <БД>

dataspace.datasource.primary.dbschema=<имя схемы>

spring.datasource.driver-class-name=<java driver class>

Создание secret с settings.xml#

Пример команды:

kubectl apply -f <имя файла>

Пример файла:

apiVersion: v1

kind: Secret

metadata:

name: maven-settings

stringData:

settings.xml: |-

<settings xmlns="http://maven.apache.org/SETTINGS/1.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/SETTINGS/1.0.0

http://maven.apache.org/xsd/settings-1.0.0.xsd">

<servers>

<server>

<id>release.repo</id>

<username></username>

<password></password>

</server>

<server>

<id>internal</id>

<username></username>

<password></password>

</server>

</servers>

<profiles>

<profile>

<id>settings</id>

<repositories>

<repository>

<id>release.repo</id>

<url></url>

</repository>

</repositories>

<pluginRepositories>

<pluginRepository>

<id>release.repo</id>

<url></url>

</pluginRepository>

</pluginRepositories>

</profile>

</profiles>

<activeProfiles>

<activeProfile>settings</activeProfile>

</activeProfiles>

</settings>

Создание secret для работы DS Lab#

Подготовка базы данных#

Для работы DS Lab требуется развернуть БД. Поддерживается СУБД PostgreSQL (далее PostgreSQL или PG). Рекомендуется использовать продукт Platform V Pangolin SE, правообладателем которого является АО «СберТех» (см. раздел "Системные требования").

Примечание

Для именования объектов БД (учетных записей, ролей, схем, табличных пространств и т.д.) следует руководствоваться требованиями используемой СУБД в части имен без использования кавычек. Обычно в допустимый набор символов входят латинские буквы (a-z, A-Z), цифры (0-9) и символ подчеркивания (_), имена должны начинаться с буквы или символа подчеркивания.

Для подготовки БД ознакомьтесь с разделом "Подготовка базы данных" документа "Руководство по установке" компонента DSPC.

Внимание!

Для компонента DSLB необходимо использовать отличную от используемой в компоненте DSPC базу данных и иную роль для подключения к БД.

Пример скрипта для создания роли:

CREATE ROLE dsl_appl WITH PASSWORD <пароль> LOGIN CREATEDB CREATEROLE NOSUPERUSER; GRANT ALL PRIVILEGES ON SCHEMA dslb TO dsl_appl WITH GRANT OPTION; GRANT ALL PRIVILEGES ON TABLESPACE dslb_t TO dsl_appl WITH GRANT OPTION; GRANT ALL PRIVILEGES ON database dslb_db TO dsl_appl WITH GRANT OPTION;

Выбор способа установки#

В зависимости от способа развертывания продукта воспользуйтесь одной из инструкций:

опциональная ручная установка сервиса;

рекомендованная автоматизированная установка.

Установка#

Подготовка параметров для установки#

Параметры для dataspace-core-meta#

Пример заполнения файла конфигурации для dataspace-core-meta:

```yaml

releaseName: ds-core-meta

values:

replicaCount: 2 # количество поднимаемых pods

appConfig:

packagesToScan: "com.sbt.meta.model" # groupId модели DS Lab

fluentBit:

enabled: false

db:

main:

secret: "ds-db-main-secret" # имя секрета, созданного в разделе "Создание secret для подключения к БД"

overrideProperties:

graphiql:

endpoint:

graphql: /ds-core-meta/graphql

subscriptions: /ds-core-meta/subscriptions

basePath: /ds-core-meta/

dataspace:

endpoint:

graphiql:

enabled: true

graphql:

enabled: true

server:

tomcat:

general-thread-analytics: true

threadstatistics: false

spring:

jpa:

database-platform: org.hibernate.dialect.H2Dialect

show-sql: false

service:

port: 8080

type: NodePort

unsecPort: 9999

ingress:

enabled: true

annotations:

kubernetes.io/ingress.class: nginx

nginx.ingress.kubernetes.io/rewrite-target: /$2

tls:

- secretName: ds-tls-secret

hosts:

- dsmeta.ddns.net

hosts:

- host: 'dsmeta.ddns.net'

paths:

- path: /ds-core-meta(/|$)(.*)

- host: ''

paths:

- path: /ds-core-meta(/|$)(.*)

resources:

limits:

cpu: 2000m

memory: 2048Mi

requests:

cpu: 2000m

memory: 2048Mi

image:

registryUrl: <адрес registry>

registryProject: "pprb/ci00682829_cdm"

imagePullSecrets:

- name: default-secret

- name: nexusbasesw # имя секрета, созданного в разделе "Создание pull image secret"

```

Параметры для dataspace-meta#

Список параметров для установки Helm Charts:

Переменная | Значение по умолчанию | Обязательно | Описание | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

replicaCount | 1 | Количество реплик | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

mavenSettings.existingSecret | "" | Существующий секрет, содержащий maven settings.xml | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

mavenSettings.username | "" | Логин для maven settings.xml. Заполняется, если mavenSettings.existingSecret="" | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

mavenSettings.password | "" | Пароль для maven settings.xml. Заполняется, если mavenSettings.existingSecret="" | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

mavenSettings.nexusUrl | "" | URL Nexus для Maven settings.xml. Заполняется, если mavenSettings.existingSecret="" | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.runDebug | false | Запуск сервиса в debug | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.dsLabSecret.name | ds-lab-secret | Имя секрета с чувствительными параметрами для сервиса dataspace-meta | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.dsLabSecret.secret | false | Флаг создания секрета из helm charts | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.dsLabSecret.values.grafana.username | "" | Пользователь-администратор для создания дашбордов в Grafana | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.dsLabSecret.values.grafana.password | "" | Пароль для пользователя Grafana | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.dsLabSecret.values.nexus.username | "" | Пользователь с правами read/write в Nexus | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.dsLabSecret.values.nexus.password | "" | Пароль для пользователя Nexus | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.dsLabSecret.values.check | {} | Параметры для настройки разграничения прав в IAM-системе. Подробнее см. документ "Руководство по системному администрированию" | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.dsLabSecret.values.rds | {} | "Чувствительные" параметры для интеграции с RDS. Подробнее см. в разделе "Использование RDS SberCloud для клиентских dataspace-core" | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.overrideProperties | {} | Да | Переопределение параметров сервиса. Подробнее см. в разделе "Параметры приложения" | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.fluentBit.enabled | false | Флаг использования sidecar Fluentbit | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.fluentBit.image | "" | Ссылка на образ Fluentbit. Пример: fluent/fluent-bit:1.4.5 | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.fluentBit.secret | "fluentBitSecret" | Имя секрета для сертификатов fluentbit | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

appConfig.fluentBit.env | [] | Массив env для контейнера Fluentbit | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

image.registryUrl | "" | URL registry образа dataspace-meta | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

image.registryProject | "" | Path в registry образа dataspace-meta | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||