Руководство по установке#

В руководстве приведены инструкции по установке компонента DataSpace Core (DSPC) продукта Platform V DataSpace (APT).

О документе#

Настоящий документ содержит описание процесса установки и настройки компонента DataSpace Core продукта Platform V DataSpace (далее — DataSpace или компонент).

DataSpace Core предоставляет возможность описывать модель данных предметной области и формировать набор сервисов для работы с этими данными: создание, изменение, удаление, объединение в транзакционные группы, гибкие возможности поиска и получения данных.

DataSpace не имеет собственной модели данных предметной области, а ожидает ее от потребителя. Именно сочетание DataSpace и модели потребителя образует полноценный сервис платформы.

Расшифровку основных понятий см. в документе "Термины и определения".

Системные требования#

Настройки безопасности окружения и перечень платформенных (дополнительных внешних) продуктов, используемых для установки, настройки и контроля в конечной информационной системе (далее — ИС), выбираются клиентом при разработке конечной ИС, исходя из характера обрабатываемой в ней информации и иных требований информационной безопасности (далее — ИБ), предъявляемых к ней.

Системное программное обеспечение#

Имеются следующие требования к ПО:

На серверы приложений, использующих DataSpace, должна быть установлена технологическая платформа Kubernetes или Red Hat OpenShift или аналогичная среда контейнеризации приложений.

Для создания проекта с помощью архетипа необходим доступ к репозиторию Maven Central или его зеркалу.

Наличие БД (PostgreSQL, H2 или Oracle). Для возможности репликации в StandIn при использовании DataSpace необходимо наличие второй БД (StandIn БД).

Создан и настроен namespace Kubernetes (см. раздел "Чек-лист по настройке namespace Kubernetes").

Наличие Kubectl на компьютере, с которого производится установка.

Наличие пакетного менеджера Helm на ПК, с которого производится установка.

При построении кластера серверов приложений сервиса DataSpace в случае использования алгоритма SNOWFLAKE для обеспечения уникальности генерации прикладных идентификаторов необходимо соблюсти уникальность IPv4-адресов узлов кластера. Детали см. в разделе "Генерация идентификатора алгоритмом SNOWFLAKE" в документе "Руководство по ведению модели данных".

Ниже представлены категории системного программного обеспечения (далее — ПО), которые обязательны или опциональны для установки, настройки, контроля и функционирования компонента. В каждой категории перечислены все поддерживаемые продукты сторонних правообладателей. Отдельно обозначены варианты, которые рекомендует АО «СберТех» (маркировка «Рекомендовано» в столбце «Продукт, функциональная совместимость с которым подтверждена»). Потребителю DataSpace необходимо выбрать один из продуктов в каждой категории, исходя из условий использования конечной ИС.

Категория ПО |

Обязательность установки |

Наименование ПО |

Версия |

Продукт, функциональная совместимость с которым подтверждена |

Описание |

|---|---|---|---|---|---|

Операционная система |

Да |

Альт 8 СП |

10 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендована операционная система, основанная на Linux — Platform V SberLinux OS Server (SLO), см. раздел «Платформенные зависимости» |

Возможность функционирования продукта |

Red Hat Enterprise Linux |

7.6 и выше |

Опционально |

ОС контейнеров для запуска модулей компонента |

||

Среда контейнеризации |

Да |

1.25 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендована среда контейнеризации, основанная на Kubernetes — Platform V DropApp, см. раздел «Платформенные зависимости» |

Область среды контейнеризации, выделенная под компоненты DataSpace Core и/или приложения потребителя |

|

Red Hat OpenShift |

4 и выше |

Опционально |

|||

Командная строка |

Да |

Kubectl |

Версия, соответствующая версии Kubernetes |

Рекомендовано |

Интерфейс командной строки для управления средой контейнеризации, являющийся его составной частью, устанавливаемой на рабочей станции |

OpenShift CLI |

Версия, соответствующая версии OpenShift |

Опционально |

|||

Инструмент сборки, тестирования, развертывания контейнеризированных приложений |

Нет |

Любая актуальная версия |

Рекомендовано |

Сервер автоматизации, используемый для внедрения непрерывной интеграции и непрерывной доставки (CI/CD) для проектов программного обеспечения |

|

Пакетный менеджер |

Да |

3.4.1 и выше |

Рекомендовано |

Используется для установки компонента DataSpace Core в Kubernetes |

|

Система сбора лог-файлов |

Нет |

1.4.5 |

Рекомендовано |

Подготовка и публикация журналов приложения |

|

Java-машина |

Да |

11.0.16 и более высокая минорная версия |

Рекомендовано |

Возможность функционирования продукта |

|

Система управления базами данных (СУБД) |

Да |

12 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендована СУБД, основанная на PostgreSQL, — Platform V Pangolin SE, см. раздел «Платформенные зависимости» |

Для хранения данных компонента DataSpace Core |

|

Oracle Database |

12.2 и выше |

Опционально |

|||

1.4.200 |

Опционально |

||||

Инструмент управления проектом |

Да |

3.6.3 |

Рекомендовано |

Фреймворк для автоматизации сборки проектов на основе описания их структуры в файлах на языке POM |

|

Сервис централизованного хранения репозиториев артефактов (хранилище артефактов) |

Да |

2.5.1 и выше |

Рекомендовано |

Интегрированная платформа для проксирования, хранения и управления зависимостями Java (Maven), образами, а также распространения ПО |

|

Nexus Repository Manager PRO |

Любая актуальная версия |

Опционально |

|||

Nexus Repository Manager OSS |

Любая актуальная версия |

Опционально |

|||

Сервис интеграции и оркестрации микросервисов в облаке |

Да |

1.12 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендован сервис интеграции и оркестрации микросервисов в облаке, основанный на Istio Service Mesh, — Platform V Synapse Service Mesh, см. раздел «Платформенные зависимости» |

Маршрутизация и защита межсервисных взаимодействий |

|

1.3.2 |

Опционально. Правообладателем АО «СберТех» также рекомендован сервис интеграции и орекстрации микросервисов в облаке, основанный на Istio — Platform V Synapse Service Mesh (SSM), см. раздел «Платформенные зависимости» |

||||

Система мониторинга (сбор и хранение метрик) |

Нет |

2.22.2 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендован Сервис для сбора прикладных и инфраструктурных метрик и отправки их в целевую систему хранения — компонент Объединенный мониторинг Unimon (MONA), см. раздел «Платформенные зависимости» |

Сбор и хранение метрик мониторинга работы приложения |

|

1.8 и выше |

Опционально |

||||

Система мониторинга (визуализация) |

Нет |

7.3 и выше |

Рекомендовано |

Мониторинг работы приложения |

|

Брокер сообщений |

Да |

2.7.0 и выше |

Рекомендовано. Правообладателем АО «СберТех» также рекомендован брокер сообщений, основанный на Kafka, — Platform V Corax, см. раздел «Платформенные зависимости» |

Событийный обмен сообщениями между модулями компонента |

|

Система создания, хранения и распространения секретов |

Нет |

1.5.0 и выше |

Рекомендовано |

Система, обеспечивающая безопасный и надежный способ создания, хранения и распространения секретов |

|

Secret Management System (SecMan) |

1.7.0 и выше |

Опционально |

|||

Средство контейнеризации |

Да |

Любая актуальная версия |

Рекомендовано |

Инструмент для автоматизации работы с контейнерами |

|

Браузер |

Нет |

Яндекс.Браузер |

19 и выше |

Рекомендовано |

Работа пользователя с GraphQL-редактором |

Google Chrome |

90 и выше |

Опционально |

|||

Интегрированная среда разработки |

Нет |

Intellij IDEA Community Edition |

Любая актуальная версия |

Рекомендовано |

Cреда разработки программного обеспечения |

Примечание:

*

Да — категория ПО обязательна для функционирования сервиса (это означает, что сервис не может выполнять свои основные функции без установки данной категории ПО).

Нет — категория ПО необязательна для функционирования сервиса (это означает, что сервис может выполнять свои основные функции без установки данной категории ПО).

**

Рекомендовано — рекомендованный правообладателем АО «СберТех» продукт.

Опционально — альтернативный по отношению к рекомендованному правообладателем АО «СберТех» продукт.

Платформенные зависимости#

Для настройки, контроля и функционирования компонента реализована интеграция с программными продуктами, правообладателем которых является АО «СберТех»:

Наименование продукта |

Код |

Версия продукта |

Код и наименование компонента |

Обязательность установки (да/нет) |

Описание |

Аналог других производителей |

|---|---|---|---|---|---|---|

Platform V Audit SE |

AUD |

2.3 и выше |

AUDT Аудит |

Нет |

Сервис для аудирования событий |

С аналогами других производителей не тестировался |

Platform V Monitor |

OPM |

4.1 и выше |

LOGA Журналирование |

Нет |

Сервис для хранения лог-файлов |

Любой сервис сбора записей о событиях, совместимый с fluent-bit, например, InfluxDB |

MONA Объединенный мониторинг Unimon |

Нет |

Сервис для сбора прикладных и инфраструктурных метрик и отправки их в целевую систему хранения |

||||

Platform V Backend |

#BD |

4.3.1 и выше |

APLJ Прикладной журнал |

Нет |

Сервис для обеспечения отказоустойчивости приложения на уровне базы данных |

С аналогами других производителей не тестировался |

OTTS One-Time Password (OTP) / OTT |

Нет |

Сервис для аутентификации и авторизации межсервисных взаимодействий |

С аналогами других производителей не тестировался |

|||

CCIX Сервис межкластерной индексации |

Нет |

Публикация информации о размещении данных в шардах для поддержки прикладного шардирования |

С аналогами других производителей не тестировался |

|||

Platform V Pangolin SE |

PSQ |

5.2.0 и выше |

PSQL Pangolin |

Да |

Система управления базами данных, основанная на PostgreSQL |

|

Platform V DevOps Tools |

DOT |

1.3 и выше |

CDJE Deploy tools |

Нет |

Сервис для развертывания и обновления компонентов Платформы и приложений потребителей, для настройки и обслуживания инфраструктуры Платформы |

Ручное развертывание |

CIJE Build tools |

Нет |

Сервис для сборки компонентов Платформы и приложений потребителей |

Ручное развертывание |

|||

Platform V Synapse Service Mesh |

SSM |

2.10 и выше |

POLM Управление политиками |

Нет |

Панель управления с открытым исходным кодом, служащая для взаимодействия, мониторинга и обеспечения безопасности контейнеров в среде контейнеризации Kubernetes |

Istio control plane — Istio |

IGEG Граничный и сервисный прокси |

Нет |

Сервис для обеспечения управляемого вызова интеграционных сервисов прикладной части |

Istio proxy — Istio |

|||

Platform V Corax |

KFK |

5.1.7 и выше |

KFKA Corax |

Нет |

Программный брокер сообщений, представляющий собой распределенную, отказоустойчивую, реплицированную и легко масштабируемую систему передачи сообщений, рассчитанную на высокую пропускную способность |

|

Platform V Archiving |

ARC |

4.7.0 и выше |

ARCH Архивирование |

Нет |

Сервис архивирования данных для корпоративной аналитической платформы |

С аналогами других производителей не тестировался |

Platform V DropApp |

K8S |

1.1 и выше |

K8SС K8S Core |

Да |

Область среды контейнеризации, выделенная под компоненты DataSpace Core и/или приложения потребителя |

Kubernetes, Red Hat OpenShift |

Platform V SberLinux OS Server |

SLO |

8.8.2 и выше |

INST Операционная система |

Да |

ОС контейнеров для запуска модулей компонента |

Альт 8 СП, Red Hat Enterprise Linux |

Примечание:

***

Да — компонент или продукт необходим для функционирования сервиса (это означает, что сервис не может выполнять свои основные функции без установки данного компонента).

Нет — необязательный для функционирования сервиса компонент или продукт (это означает, что сервис может выполнять свои основные функции без установки данного компонента).

**** Рекомендуется установка программного продукта, правообладателем которого является АО «СберТех», при этом не исключена возможность (допускается правообладателем) использования аналога других производителей. Аналоги, в отношении которых продукт успешно прошел испытания и подтвердил свою работоспособность, указаны в разделе «Системное программное обеспечение».

Аппаратные требования#

Приведенные в разделе требования для запуска приложений необходимо выполнять для каждого разворачиваемого модуля DataSpace.

Требования для запуска приложений DataSpace расчете на 1 pod:

Тип |

Минимально |

Рекомендовано |

|---|---|---|

Процессор (CPU) |

1 ядро |

2 ядра |

Оперативная память (RAM) |

1 ГБ |

2 Гб и больше |

Примечание

Количество pod DataSpace определяется исходя из требований надежности и производительности (рекомендуется предварительное проведение нагрузочного тестирования).

По умолчанию число pod для каждого разворачиваемого приложения DataSpace равно

1.

В дополнение к этому серверы приложений, использующих DataSpace, должны отвечать требованиям к остальным компонентам реализуемых приложений.

Типовые требования к dev КТС для БД PostgreSQL:

Тип |

Минимально |

Рекомендовано |

|---|---|---|

Процессор (CPU) |

4 ядра |

8 ядер |

Оперативная память (RAM) |

8 ГБ |

16 Гб |

Дисковое пространство (HDD/SSD) |

20 ГБ |

150 Гб |

IOPS |

>50 |

2000 |

При использовании опции функционального StandIn необходимо иметь две БД на разных КТС.

Чек-лист по настройке namespace Kubernetes#

Пространство Kubernetes будет считаться готовым к развертыванию сервисов DataSpace после выполнения всех следующих требований:

В namespace Kubernetes создан secret типа Dockersecret с логином и паролем ТУЗ.

Созданный secret прописан в service accounts:

defaultиdataspace-core.Произведена настройка Ingress Gateway (опционально).

Произведена настройка Egress Gateway (опционально).

Подготовка окружения#

Подготовка базы данных#

Для работы DataSpace требуется развернуть БД. Поддерживаются СУБД PostgreSQL 12.x+, а также Oracle Database 12.2+ (далее Oracle). Для dev-тестов может использоваться H2 версии не ниже 1.4.200.

Рекомендуется использовать продукт Platform V Pangolin SE.

Примечание

Для именования объектов БД (учетных записей, ролей, схем, табличных пространств и т.д.) следует руководствоваться требованиями используемой СУБД для имен без использования кавычек. Обычно в допустимый набор символов входят латинские буквы (a-z, A-Z), цифры (0-9) и символ подчеркивания ( _ ), имена должны начинаться с буквы или символа подчеркивания.

Создание учетных записей#

Для работы модулей DataSpace и для работы скриптов развертывания в БД необходимо создать технологические учетные записи (ТУЗ):

Имя ТУЗ PG |

Имя ТУЗ Oracle |

Назначение |

Условия использования |

|---|---|---|---|

as_admin |

DSPC |

Владелец схемы БД. Для работы скриптов развертывания DataSpace — создание объектов схемы БД средствами Liquibase |

ТУЗ обязательна. При использовании Platform V Pangolin SE в роль as_admin включается заранее созданная доменная ТУЗ владельца схемы БД. Доменная ТУЗ с ролью as_admin, as_admin должна являться владельцем объектов БД, для этого перед выполнением DDL-команд должна выполняться команда |

dsc_appl |

DSC_APPL |

Подключение к БД модуля dataspace-core, чтение и запись |

ТУЗ обязательна. Исключение — локальная БД разработчика для целей тестирования DataSpace |

dsa_appl |

DSA_APPL |

Подключение к БД модуля dataspace-applier, чтение и запись |

ТУЗ опциональна — определяется потребителем. Нужна только при использовании функционального StandIn для возможности раздельного мониторинга основной и вспомогательной нагрузки и управления ресурсами на уровне БД |

dss_appl |

DSS_APPL |

Подключение к БД модуля dataspace-search, чтение |

ТУЗ опциональна — определяется потребителем. Нужна только при использовании отдельной конфигурации DataSpace в режиме search для возможности раздельного мониторинга основной и поисковой нагрузки и управления ресурсами на уровне БД |

Создание схемы при использовании PostgreSQL#

Необходимо создать:

Кластер PostgreSQL.

Роли as_admin, as_TUZ (valid until указать в соответствии с требованиями). Роль as_admin будет являться владельцем схемы, как и в случае использования БД Platform V Pangolin SE.

-- Скрипт выполняет DB admin c привилегией на создание ролей и пользователей

CREATE USER as_admin WITH PASSWORD <пароль> LOGIN NOCREATEROLE NOCREATEDB NOSUPERUSER NOINHERIT NOREPLICATION NOBYPASSRLS VALID UNTIL '2099.12.31';

CREATE USER "as_TUZ" WITH PASSWORD <пароль> LOGIN NOCREATEROLE NOCREATEDB NOSUPERUSER NOINHERIT NOREPLICATION NOBYPASSRLS VALID UNTIL '2099.12.31';

Каталоги Linuх для табличных пространств. Пользователь Linux Postgres должен иметь для них все права (mkdir /pgdata/11/ts/dspc_t; chown postgres /pgdata/11/ts/dspc_t; chmod u+rwx /pgdata/11/ts/dspc_t).

Табличные пространства необходимого размера, БД и схему. Необходимо выдать права владельца.

-- Названия объектов БД и пути даны в качестве примера (обычно они подходят для типовой установки) -- Их необходимо проверить и заменить на актуальные -- 1) Создание табличного пространства. Выполняет DB admin. CREATE TABLESPACE dspc_t OWNER as_admin LOCATION '/pgdata/11/ts/dspc_t'; GRANT CREATE ON TABLESPACE dspc_t TO as_admin; -- 1.1) Следующие 2 команды в случае, если для индексов используется отдельное табличное пространство. CREATE TABLESPACE dspc_i OWNER as_admin LOCATION '/pgdata/11/ts/dspc_i'; GRANT CREATE ON TABLESPACE dspc_i TO as_admin; -- 2) Создаем БД. Выполняет DB admin CREATE DATABASE dspc_db OWNER as_admin ENCODING 'UTF-8' LC_COLLATE 'en_US.UTF-8' LC_CTYPE 'en_US.UTF-8' TABLESPACE dspc_t; -- в зависимости от локали в системе параметры LC_COLLATE и LC_CTYPE могут быть указаны с прописной utf-8. Команда для проверки: -- SELECT datname, datcollate, datctype FROM pg_database WHERE datname LIKE 'template%'; GRANT ALL PRIVILEGES ON DATABASE dspc_db TO as_admin; -- 3) Создаем схему. Выполняет DB admin или as_admin CREATE SCHEMA dspc AUTHORIZATION as_admin; REVOKE ALL ON SCHEMA public FROM public; GRANT ALL PRIVILEGES ON SCHEMA dspc TO as_admin; ALTER DEFAULT PRIVILEGES IN SCHEMA dspc GRANT ALL PRIVILEGES ON TABLES TO as_admin; GRANT USAGE ON SCHEMA dspc TO "as_TUZ"; GRANT SELECT, UPDATE, INSERT, DELETE ON ALL TABLES IN SCHEMA dspc TO "as_TUZ"; ALTER DEFAULT PRIVILEGES IN SCHEMA dspc GRANT SELECT, INSERT, UPDATE, DELETE ON TABLES TO "as_TUZ"; ALTER ROLE as_admin SET search_path to 'dspc'; -- 4) Назначаем as_admin владельцем схемы (опционально, если схему создавала УЗ с ролью as_admin) ALTER SCHEMA dspc OWNER TO as_admin;ТУЗ владельца схемы — dspc. ТУЗ приложения — dsc_appl, dsa_appl, dss_appl. Выдать ТУЗ права DML на таблицы схемы DML.

-- Выполняет DB admin с привилегиями на создание ролей -- ТУЗ для Liquibase CREATE USER dspc WITH ENCRYPTED PASSWORD <пароль> NOINHERIT; ALTER ROLE dspc SET search_path to 'dspc'; GRANT as_admin TO dspc; ALTER ROLE dspc SET ROLE TO as_admin; -- as_admin является владельцем схемы -- ТУЗ для модуля dataspace-core CREATE USER dsc_appl WITH ENCRYPTED PASSWORD <пароль> INHERIT; GRANT "as_TUZ" TO dsc_appl; ALTER ROLE dsc_appl SET search_path to 'dspc'; -- ТУЗ для модуля dataspace-applier — если необходимо CREATE USER dsa_appl WITH ENCRYPTED PASSWORD <пароль> INHERIT; GRANT "as_TUZ" TO dsa_appl; ALTER ROLE dsa_appl SET search_path to 'dspc'; -- ТУЗ для модуля dataspace-search — если необходимо CREATE USER dss_appl WITH ENCRYPTED PASSWORD <пароль> INHERIT; GRANT USAGE ON SCHEMA dspc TO dss_appl; ALTER ROLE dss_appl SET search_path to 'dspc'; GRANT SELECT ON ALL TABLES IN SCHEMA dspc TO dss_appl; ALTER DEFAULT PRIVILEGES IN SCHEMA dspc GRANT SELECT ON TABLES TO dss_appl;

Создание схемы при использовании Oracle#

Необходимо выполнить следующие действия:

Создать экземпляр БД Oracle.

Создать табличные пространства DSPC_T, DSPC_I необходимого размера (при использовании LOB-типов данных — также табличное пространство DSPC_L).

Создать ТУЗ владельца схемы — DSPC (схема будет называться также).

Дать ТУЗ DSPC QUOTA UNLIMITED на оба табличных пространства.

Дать ТУЗ DSPC привилегии на создание объектов схемы grant CREATE TABLE, CREATE VIEW, CREATE TRIGGER to DSPC.

Создать роли DSPC_ROLE, DSPC_READ_ROLE.

Создать ТУЗ приложения — DSC_APPL, DSA_APPL, DSS_APPL.

Дать ТУЗ права на таблицы схемы DML.

При необходимости создать logon-триггеры для выбора в качестве рабочей схемы DSPC.

Для выполнения вышеуказанных пунктов 2-7 можно использовать скрипт инициализации: схема и ТУЗ (подставить необходимые параметры tablespace, имена схем и ТУЗ):

-- replace placeholder ${default_password} with actual value

-- create tablespace — assign real names and locations and size

CREATE TABLESPACE dspc_t DATAFILE 'dspc_t' SIZE 10G AUTOEXTEND ON ONLINE;

CREATE TABLESPACE dspc_i DATAFILE 'dspc_i' SIZE 10G AUTOEXTEND ON ONLINE;

-- create schema owner

CREATE USER dspc

IDENTIFIED BY ${default_password}

DEFAULT TABLESPACE dspc_t

TEMPORARY TABLESPACE TEMP;

-- assign quota

alter user dspc QUOTA UNLIMITED ON dspc_t;

alter user dspc QUOTA UNLIMITED ON dspc_i;

-- allow login

grant CREATE SESSION, ALTER SESSION to dspc;

-- allow object creation

grant CREATE TABLE, CREATE VIEW, CREATE TRIGGER to dspc;

-- create role for TUZ

create role dspc_role;

create role dspc_read_role;

-- create dsc_appl TUZ

CREATE USER dsc_appl

IDENTIFIED BY ${default_password}

PASSWORD EXPIRE

DEFAULT TABLESPACE dspc_t

TEMPORARY TABLESPACE TEMP;

grant dspc_role to dsc_appl;

alter user dsc_appl default role ALL;

grant CREATE SESSION, ALTER SESSION to dsc_appl;

-- create dsa_appl TUZ

CREATE USER dsa_appl -- если необходимо

IDENTIFIED BY ${default_password}

PASSWORD EXPIRE

DEFAULT TABLESPACE dspc_t

TEMPORARY TABLESPACE TEMP;

grant dspc_role to dsa_appl;

alter user dsa_appl default role ALL;

grant CREATE SESSION, ALTER SESSION to dsa_appl;

-- create dss_appl TUZ — если необходимо

CREATE USER dss_appl

IDENTIFIED BY ${default_password}

PASSWORD EXPIRE

DEFAULT TABLESPACE dspc_t

TEMPORARY TABLESPACE TEMP;

grant dspc_read_role to dss_appl;

alter user dss_appl default role ALL;

grant CREATE SESSION, ALTER SESSION to dss_appl;

Для выполнения пункта 9 можно использовать скрипт создания logon-триггеров:

create or replace trigger dsc_appl.set_default_schema_dsc_appl

after logon on dsc_appl.schema

begin

execute immediate 'alter session set current_schema=dspc';

end;

/

create or replace trigger dsa_appl.set_default_schema_dsa_appl

after logon on dsa_appl.schema

begin

execute immediate 'alter session set current_schema=dspc';

end;

/

create or replace trigger dss_appl.set_default_schema_dss_appl

after logon on dss_appl.schema

begin

execute immediate 'alter session set current_schema=dspc';

end;

/

Для выполнения пункта 8 после каждого выполнения job создания/обновления схемы необходимо выполнять скрипт по грантованию доступов для ролей dspc_role и dspc_read_role:

declare

granttorole varchar2(254);

granttoreadrole varchar2(254);

begin

granttorole := 'dspc_role';

granttoreadrole := 'dspc_read_role';

for i in (select t.table_name

from sys.all_tables t

where t.owner = USER

and NOT (t.table_name like ('DATABASECHANGE%')))

loop

execute immediate 'grant SELECT, INSERT, UPDATE, DELETE ON ' || i.table_name || ' to ' || granttorole;

execute immediate 'grant SELECT ON ' || i.table_name || ' to ' || granttoreadrole;

end loop;

end;

/

Для создания ролей/схемы Postgres/Oracle для случаев вне Динамической инфраструктуры необходимо перечисленные скрипты выполнять отдельными шагами с возможностью выбора УЗ, под которой их выполнять.

Примечание

Использование второго табличного пространства (под индексы) является необязательным. В этом случае в параметрах, где требуется второе табличное пространство, можно указывать первое (dspc_t).

При развертывании на БД Oracle при использовании Binary или Text-атрибутов (BLOB/CLOB полей) целесообразно создать третье табличное пространство dspc_l, в котором будут создаваться LOB-объекты.

В job развертывания DataSpace указывается ТУЗ dpsc и его пароль в качестве владельца схемы БД. Также указывается ТУЗ приложений dsc_appl, dsa_appl, dss_appl, табличные пространства dspc_t, dspc_i, dspc_l и имя схемы dspc.

Настройка соединения с БД в сервисах DataSpace#

В данном разделе описаны шаги настройки сервисов DataSpace и пространства Kubernetes (или OpenShift) для подключения БД (PostgreSQL или Oracle).

Шаги настройки на Kubernetes (или OpenShift)#

Необходимо выполнить следующие действия:

Получить и настроить базу(ы) данных (см. раздел "Подготовка базы данных").

Создать secret(s) с параметрами подключения к базе(-ам) данных в Kubernetes (или OpenShift). Смотрите раздел "Создание secret для базы данных в Kubernetes (или OpenShift)".

Обеспечить доступ из пространства Kubernetes (или OpenShift) к базе(-ам) данных.

Передать в параметры названия созданных secrets в сервисы DataSpace при развертывании в Kubernetes (или OpenShift). Названия параметров:

helm:

appConfig: db: main: secret: "main-db-secret" # имя созданного секрета базы данных main standin: secret: "standin-db-secret" # имя созданного секрета базы данных функционального standinPlatform V DevOps Tools: Секреты создаются автоматически по информации из пункта Проливка Liquibase-скриптов на базу данных

Создание secret для базы данных в Kubernetes (или OpenShift)#

Есть разные варианты хранения секретов: обычные секреты k8s/OpenShift и хранение в системе создания, хранения и распространения секретов HashiCorp Vault.

Для конфигурирования на стендах Kubernetes (или OpenShift) используются объекты secret, содержащие stringData c параметрами подключения. Создать secret можно через cli-приложение (OpenShift cli или kube_ctl).

Внимание!

Secrets для Main и StandIn базы данных отличаются по своему содержимому.

Примечание

В случае использования HashiCorp Vault конфигурация подключения к БД прописывается в ConfigMap приложения (в рамках использования pipeline от продукта Platform V DevOps Tools см. раздел "Настройка параметров подключения к БД").

Пример secret для основной (Main) базы данных PostgreSQL#

apiVersion: v1

kind: Secret

metadata:

name: main-db-secret

data:

stringData:

secret.properties: |-

spring.datasource.username=dsc_appl

spring.datasource.password=<пароль>

spring.datasource.url=jdbc:postgresql://dataspace-core-deposit-16923100-pgdb:5432/dataspace

dataspace.datasource.primary.dbschema=dspc

spring.datasource.driver-class-name=org.postgresql.Driver

spring.jpa.database-platform=org.hibernate.dialect.PostgreSQLDialect

spring.jpa.hibernate.dialect=org.hibernate.dialect.PostgreSQLDialect

Пример secret для StandIn базы данных PostgreSQL#

apiVersion: v1

kind: Secret

metadata:

name: standin-db-secret

data:

stringData:

secret.properties: |-

standin.datasource.username=dsc_appl

standin.datasource.password=<пароль>

standin.datasource.url=jdbc:postgresql://dataspace-core-deals-17731375-standin-pgdb:5432/dataspace

dataspace.datasource.standin.dbschema=dspc

standin.datasource.driver-class-name=org.postgresql.Driver

standin.jpa.database-platform=org.hibernate.dialect.PostgreSQLDialect

standin.jpa.hibernate.dialect=org.hibernate.dialect.PostgreSQLDialect

Пример secret для основной (main) базы данных Oracle#

apiVersion: v1

kind: Secret

metadata:

name: main-db-secret

data:

stringData:

secret.properties: |-

spring.datasource.username=dsc_appl

spring.datasource.password=dsc_appl_password

spring.datasource.url=jdbc:oracle:thin:@<ip-адрес>:1521:pprb

dataspace.datasource.primary.dbschema=dspc

spring.datasource.driver-class-name=oracle.jdbc.OracleDriver

spring.jpa.database-platform=org.hibernate.dialect.Oracle12cDialect

spring.jpa.hibernate.dialect=org.hibernate.dialect.Oracle12cDialect

Пример secret для StandIn базы данных Oracle#

apiVersion: v1

kind: Secret

metadata:

name: standin-db-secret

data:

stringData:

secret.properties: |-

standin.datasource.username=dsc_appl

standin.datasource.password=dsc_appl_password

standin.datasource.url=jdbc:oracle:thin:@<ip-адрес>:1521:pprbsi

dataspace.datasource.standin.dbschema=dspc

standin.datasource.driver-class-name=oracle.jdbc.OracleDriver

standin.jpa.database-platform=org.hibernate.dialect.Oracle12cDialect

standin.jpa.hibernate.dialect=org.hibernate.dialect.Oracle12cDialect

Описание параметров, используемых в secrets#

Используются следующие параметры:

datasource.username— имя пользователя;datasource.password— пароль пользователя;datasource.url— jdbc-строка соединения с базой данных;dbschema— имя схемы;datasource.driver-class-name— имя драйвера для соединения с БД;database-platform— имя диалекта БД;hibernate.dialect— имя диалекта БД, аналогично значениюdatabase-platform.

Выбор способа установки#

В зависимости от способа развертывания продукта воспользуйтесь одной из инструкций:

опциональная ручная установка сервиса;

рекомендованная автоматизированная установка.

Установка#

Примечание

Установка в DropApp полностью аналогична установке в Kubernetes.

Ручная установка сервиса#

Раздел содержит описание сборки дистрибутива и образов сервисов DataSpace.

Ручная проливка Liquibase скриптов на СУБД#

Примечание

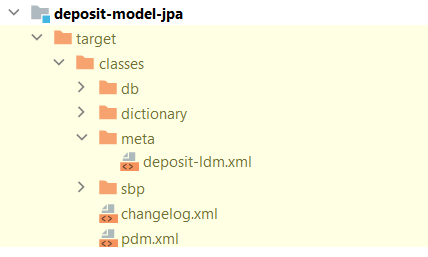

В шаблонном проекте, сформированном на базе архетипа (см. "Быстрый старт") существуют профили

dbScriptsWithOracleиdbScriptsWithoutOracle, по которым формируется архив по пути*-model-jpa/target/db/db-scripts.zip.

dbScriptsWithOracle - добавляется JDBC драйвер для проливки Liquibase скриптов на СУБД Postgres и Oracle;

dbScriptsWithoutOracle - добавляется JDBC драйвер для проливки Liquibase скриптов только на СУБД Postgres.

Все необходимое для проливки liquibase скриптов лежит в полученном архиве.

Описанные ниже параметры и команды базируются на официальной документации Liquibase.

Определение Liquibase параметров запуска (LIQUIBASE_OPTS):

Параметр |

Пример |

Комментарий |

|---|---|---|

|

|

ТУЗ владельца схемы БД для выполнения Liquibase |

|

Пароль dbUser |

|

|

|

JDBC строка подключения к СУБД |

|

|

драйвер, используемый для подключения к СУБД |

|

|

|

|

|

|

|

|

для совместимости с pipeline Platform V DevOps Tools |

|

|

для совместимости с pipeline Platform V DevOps Tools |

|

|

Определение Java параметров запуска (JAVA_OPTS):

Параметр |

Пример |

Комментарий |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

Степень параллелизма при создании индексов (количество параллельных процессов Oracle или максимальное число параллельных процессов PostgreSQL). Для Oracle значение по умолчанию — 1, для PostgreSQL — в соответствии с настройками сервера БД |

|

|

|

для использования опции |

|

|

для использования опции |

|

|

имя роли для сессии, под которой произойдет создание таблиц в change.log (применимо к PostgreSQL) |

|

|

дублирование параметра |

|

|

выполнять удаление, создание и перестроение индексов, предусмотренные changelog |

|

|

включает выполнение grant create session, alter session. Требуется поскольку OWNER_ROLE не имеет admin option для этих грантов |

export JAVA_OPTS="<JAVA_OPTS>"

export LIQUIBASE_OPTS="<LIQUIBASE_OPTS>"

export LIQUIBASE_HOME=`pwd` # Абсолютный путь до директории исполнения команды

java ${JAVA_OPTS} -classpath './*' liquibase.integration.commandline.Main ${LIQUIBASE_OPTS} update

Сборка базового образа#

В составе дистрибутива компонента DSPC (см. документ "Быстрый старт") в папке package/docker лежит все необходимое для сборки базовых образов сервисов DataSpace.

Основной передаваемый при сборке аргумент — ARG BASE_IMAGE — URL образа операционной системы c OpenJDK, на основе которой будет собираться базовый образ DataSpace.

Сборка производится следующим образом:

Выполняется команда сборки образа из каталога package дистрибутива:

export BASE_IMAGE=<url образа> docker build -f ./docker/<имя сервиса>/Dockerfile -t <имя:тэг> ./ --build-arg BASE_IMAGE

Ручная сборка образов сервисов DataSpace с моделью потребителя#

В данном разделе описаны шаги сборки образов сервисов DataSpace с целью их дальнейшей инсталляции в Kubernetes (или OpenShift).

Для сборки образов сервисов DataSpace необходимо выполнить следующие шаги:

Выбрать версию базового дистрибутива сервиса DataSpace.

Скачать базовый дистрибутив.

Разработать модель согласно инструкциям, описанным в документе "Руководство по ведению модели данных".

Осуществить генерацию артефактов согласно инструкциям, описанным в разделе "Генерация артефактов серверного компонента" документа "Структура артефактов DataSpace".

Примечание

dataspace-core.model.packagesToScan - в этом параметре должно фигурировать значение пакета ранее созданной модели.

Создать следующую структуру папок и файлов:

package

bh/

ext/ — папка с JPA-классами, сгенерированными в шаге 4.

lib/ — папка, в которую можно добавить дополнительные библиотеки. Эти библиотеки будут добавлены в classpath сервиса DataSpace (например,

oracleJdbcDriver).

Скопировать сгенерированные на шаге 4 JPA-классы в формате jar (например, quickstart-model-jpa-1.0.0.jar) в созданную папку ./bh/ext.

В случае необходимости работы с Oracle, добавить в созданную папку ./bh/lib артефакт OJDBC. Пример maven-зависимости OJDBC:

<artifactItem> <groupId>com.oracle.jdbc</groupId> <artifactId>ojdbc8</artifactId> <version>18.3.0.0</version> </artifactItem>Создать в папке ./package/docker файл Dockerfile со следующим ниже содержимым:

urlToDataspaceService — ссылка на базовый образ интересующего сервиса DataSpace.

serviceVersion — версия данного сервиса DataSpace.

ARG BASE_IMAGE=urlToDataspaceService:serviceVersion FROM ${BASE_IMAGE}Должна получиться следующая структура файлов:

package (папка)

bh (папка)

ext

model-jpa.jar

lib

ojdbc8.jar (опционально, в дистрибутиве не поставляется)

docker (папка)

Dockerfile

В корне папки package выполнить команду сборки docker образа, где

yourServiceName:tag— имя и тег результирующего образа. Обычно присваивают наименование по следующему шаблону:{областьDockerRegistry}/{имяСервиса}-{имяМодели}(например,docker.registry/project/dataspace-core-deposit:1.0.0).docker build -f ./docker/Dockerfile -t yourServiceName:tag ./Произвести загрузку собранного образа в хранилище образов:

docker push yourServiceName:tag

После осуществления всех шагов ручной сборки необходимо выполнить следующие шаги:

Произвести загрузку Liquibase-скриптов на базу данных, к которой будет подключен сервис DataSpace. Описано в пункте "Ручная проливка Liquibase скриптов на СУБД".

Произвести установку сервиса при помощи HelmChart или OpenShift Template, хранящихся в базовом дистрибутиве.

Внимание!

Базовый дистрибутив не содержит ссылки на образ. Ссылку на образ необходимо передать при установке шаблона HelmChart или OpenShift, как параметр шаблона, или указать в секцию

image: ***в сущностиDeployment.Дополнительные сведения можно найти в разделе "Ручная установка сервиса".

Возможность использования объединенного модуля#

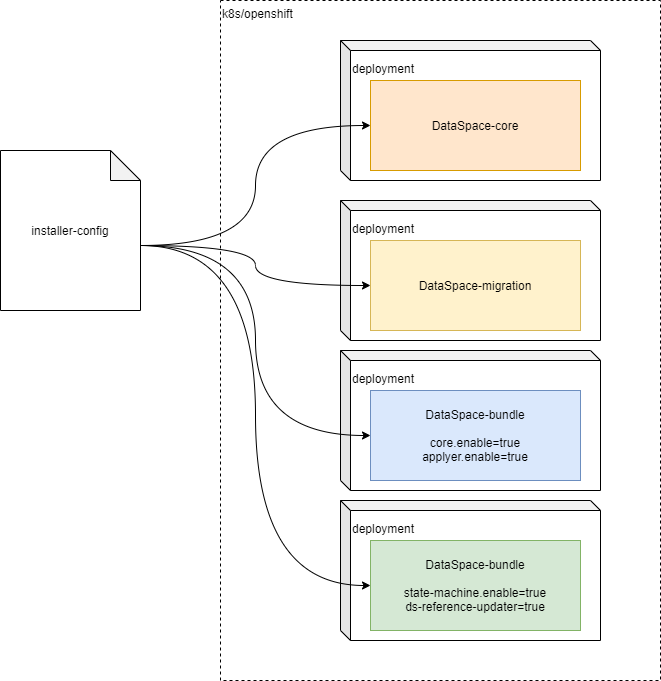

DataSpace поставляет сервис, который включает несколько компонентов: dataspace-core, dataspace-applier (dataspace-gigabas), dataspace-state-machine, dataspace-migration, dataspace-reference-updater (dataspace-duplication). Пользователи, для которых развертывание всех модулей является затратной операцией, а также избыточной в части ознакомления с функциональностью, могут воспользоваться развертыванием объединенного модуля dataspace-bundle.

Конфигурирование требуемых к включению модулей осуществляется через параметры в ConfigMap сервиса dataspace-bundle:

bundle-configuration: |-

-Ddataspace.core.enable=true

-Ddataspace.applier.enable=true

-Ddataspace.state-machine.enable=true

-Ddataspace.migration.enable=true

-Ddataspace.reference-updater.enable=true

В зависимости от потребности можно включить один или несколько функциональных модулей DataSpace в единый deployment.

Примечание

Разные модули могут требовать доступность разных систем, соответственно при включении компонента с зависимостью на работу другой системы накладывается требование на весь dataspace-bundle. Например, при включении

dataspace.applier.enable=trueтребуется настройка StandIn (Прикладной журнал (APLJ)).Для более гибкого контроля потребления ресурсов рекомендуется использование раздельных модулей.

Пример развертывания deployment:

Установка DataSpace с помощью Helm в Kubernetes (или OpenShift)#

Внимание!

Предварительно необходимо выполнить авторизацию через cli

kubectl/ocв среде контейнеризации.

Примечание

Необходимо наличие Helm на компьютере, с которого производится установка.

Реализована возможность установки DataSpace с помощью Helm — пакетного менеджера Kubernetes. Для данного вида установки нужен специально подготовленный установочный пакет helm chart.

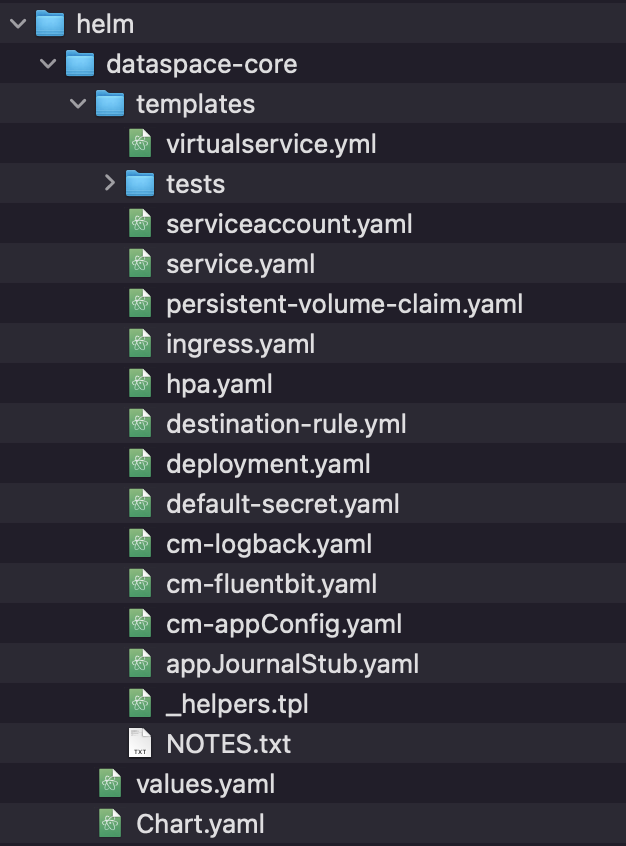

Пакет helm chart#

Структура пакета helm chart DataSpace:

Внутри дистрибутива находится папка helm, содержащая:

Chart.yaml — файл со служебной информацией о chart и приложении, который он разворачивает.

values.yaml — содержит свойства chart с их значениями.

templates/.yaml* — файлы с шаблонами объектов Kubernetes.

templates/tests/.yaml* — файлы с шаблонами для тестов Helm.

Для базовой установки дистрибутива DataSpace необходимо заполнить следующие значения в values.yaml:

appConfig:

packagesToScan: ru.sbt.platformv.dev.duser1 # GroupID Maven артефакта - имя пакета генерируемых JPA-классов, разработанных ранее

fluentBit:

enabled: true # включить/выключить использование Fluent Bit

image: '' # URL образа Fluent Bit

Примечание

Описание

defaultSecretв разделе "Опциональные настройки".

defaultSecret:

create: true # создавать/не создавать (false) дефолтный secret, задается в default-secret.yaml

image:

registryUrl: '' # URL Nexus

registryProject: '' # Project ID

name: "dataspace-core-m7107684626437177346:0.0.1" # имя образа

istio:

enabled: true # использовать/не использовать

appConfig:

jvmArguments: "<преднастроенные JVM-опции для сервиса DataSpace>"

Проверка пакета helm chart:

helm install --dry-run --debug <имя> <путь к папке с chart на локальной машине>

Процесс установки#

Для установки необходимо выполнить команду вида:

helm install <имя> <путь к папке с chart на локальной машине>

В случае успешной установки, в консоль выводится сообщение вида:

NAME: <имя развертывания>

LAST DEPLOYED: <дата последнего успешного развертывания>

NAMESPACE: <namecpace, в котором осуществлено развертывание>

STATUS: deployed

REVISION: 1

NOTES:

You have installed dataspace-core app with model

1.Get the application URL in namespace

http://svc-dataspace-core:8080

2. Get the application URL by running these commands:

Откат при установке с помощью Helm#

Если по какой-то причине установка не прошла или есть необходимость удаления существующего развертывания, следует выполнить команду:

helm uninstall <имя>

Это делается для того, что бы избежать ошибок следующего вида:

helm install dataspace-core dataspace-core-123

Error: INSTALLATION FAILED: cannot re-use a name that is still in use

Опциональные настройки#

Опционально настраиваются следующие файлы:

appJournalStub.yaml — пример настройки подключения к Прикладному журналу (по умолчанию ведет на "заглушку").

apiVersion: v1 kind: Secret metadata: name: {{ include "dataspace-core.appJournalSetting" . }} data: stringData: appJournal.properties: |- standin.cloud.client.stub=true standin.cloud.client.zoneId=test standin.cloud.client.kafka.bootstrapServers=localhostcm-appConfig.yaml — основной ConfigMap модуля DataSpace, в котором задаются override.properties, переопределяющие стандартные значения application.properties, например:

kind: ConfigMap apiVersion: v1 metadata: name: {{ include "dataspace-core.appConfigName" . }} data: override.properties: |- #------------------- Static application properties start Don't change this properties after build ds with model----------------------- dataspace-core.model.packagesToScan={{ .Values.appConfig.packagesToScan }} #------------------- Application Mode end ----------------------- # Активация бинарных файлов для работы с пакетом dataspace.packet.enable={{ .Values.appConfig.dataspace.packet.enabled }} # Активация бинарных файлов для работы с поиском dataspace.search.enable={{ .Values.appConfig.dataspace.packet.enabled }} dataspace.endpoint.jsonrpc.enabled=true

Примечание

dataspace-core.model.packagesToScan - в этом параметре должно фигурировать значение пакета ранее созданной модели.

В этом же файле имеется секция standOverride.yml:

```yaml

standOverride.yml: |-

{{- with .Values.appConfig.overrideProperties }}

```

В standOverride.yml дописываются параметры, определенные в overrideProperties из values.yaml. Это полезно в том случае, когда нужно переопределить стандартные значения override.properties, добавить свои параметры приложений DataSpace, а так же добавить или изменить параметры, общие для SpringBoot приложений.

Кроме того в cm-appConfig.yaml прописываются JVM-аргументы, задаваемые values.yaml (представлен вариант по умолчанию):

```yaml

jvmArguments: "-XX:+AlwaysPreTouch -server -XX:InitialRAMPercentage=50.0 -XX:MaxRAMPercentage=70.0 -XX:+UseG1GC -XX:MaxGCPauseMillis=20 -XX:HeapDumpPath=./ -XX:+UnlockDiagnosticVMOptions -XX:+HeapDumpOnOutOfMemoryError -XX:+DisableExplicitGC -XX:+ScavengeBeforeFullGC -XX:PrintSafepointStatisticsCount=1 -XX:+ParallelRefProcEnabled -XX:+PrintClassHistogram -XX:+PrintFlagsFinal -XX:+LogVMOutput -Xlog:gc*=debug:file=/tmp/gc_log_memory.log:time,uptime,level,tags -Xlog:safepoint=debug:/tmp/gc_log_memory.log:time,uptime,level,tags -Dcom.sun.management.jmxremote.port=5000 -Dcom.sun.management.jmxremote.authenticate=false -Dcom.sun.management.jmxremote.ssl=false -Djdk.attach.allowAttachSelf=true --add-exports java.base/jdk.internal.perf=ALL-UNNAMED --add-exports java.management/com.sun.jmx=ALL-UNNAMED"

```

cm-fluentbit.yaml — дефолтный ConfigMap Fluent Bit, включается в deployment.yaml через значения из values.yaml:

fluentBit: enabled: true # включить/выключить image: '' # путь к образу Fluent Bit secret: fluentBitSecret config: '' # если здесь пусто, создается ConfigMap по умолчанию. Если здесь указан собственный ConfigMap Fluent Bit, то дефолтный не создается, а используется указанный в данном полеcm-logback.yaml — дефолтный ConfigMap для логбэка, его использование задается значением customLogback: '' в values.yaml.

default-secret.yaml — дефолтный secret для подключения main-db. Пример:

kind: Secret apiVersion: v1 metadata: name: {{ include "dataspace-core.mainDataBaseSecret" . }} stringData: secret.properties: |- dataspace.replication.enabled=false spring.datasource.url=jdbc:h2:mem:test spring.datasource.username=sa spring.datasource.password= spring.datasource.driver-class-name=org.h2.Driver spring.jpa.database-platform=org.hibernate.dialect.H2Dialect spring.jpa.show-sql=true spring.jpa.properties.hibernate.format_sql=true spring.jpa.hibernate.ddl-auto=none spring.liquibase.enabled=true spring.liquibase.change-log=classpath:db/changelog.xml spring.liquibase.parameters.role=sa spring.liquibase.parameters.tablespace_t=sc_t spring.liquibase.parameters.tablespace_i=sc_i spring.liquibase.parameters.tablespace_l=sc_l dataspace.warmup.enable=falseПо умолчанию создается при развертывании с локальной базой данных H2, если в values.yaml не указан иной secret для подключения к базе данных.

db: ... main: secret: ''Аналогичным образом можно создать свои secrets для Kubernetes (или OpenShift).

destination-rule.yml — сетевые правила для Istio. Задействуется в том случае, если в values.yaml "включены" значения.

istio: enabled: trueи

destinationRule: enabled: true # по умолчанию установлено значение falsehpa.yaml — правила горизонтального масштабирования, берет из values.yaml следующие параметры:

autoscaling: enabled: true # включено/выключено minReplicas: 1 # минимальное количество одновременно запущенных реплик maxReplicas: 3 # максимальное количество одновременно запущенных реплик targetCPUUtilizationPercentage: 80 # процент утилизации CPUНеобходимо для того, чтобы при увеличении нагрузки на приложение, автоматически создавались новые pods (реплики) с приложением и распределяли нагрузку между собой. Когда нагрузка уменьшается, "лишние" реплики удаляются. В базовом варианте указано минимальное значение — "1", максимальное — "3" и утилизация по CPU. Это значит, что в случае повышения нагрузки на pod более 80% процессорного времени, создается вторая реплика приложения и нагрузка распределяется между ними. Когда нагрузка уменьшается, "лишняя" реплика удаляется.

ingress.yaml — настройки Ingress, заполняется параметрами из values.yaml.

ingress: enabled: false # По умолчанию отключено, для использования поменять на true servicePort: '' # Порт сервиса, с которого ожидается входящий трафик. Если одного порта недостаточно, то для других портов прописываются правила маршрутизации annotations: {} rules: {} # Здесь указываются правила маршрутизации для Ingress hosts: # Хосты, с которых ожидается входящий трафик - host: chart-example.local paths: [] tls: [] (Путь к файлам сертификатов, при использовании sslNOTES.txt — параметры сообщения, выдаваемого в консоли после успешного запуска DataSpace. Если включен и настроен Ingress, также выводит в консоль ссылку для внешнего доступа к развернутому приложению.

service.yaml — настройка сетевого сервиса приложения.

serviceaccount.yaml — параметры для service account Kubernetes (или OpenShift), создаваемого если это было задано:

serviceAccount: create: false annotations: {} name: ''virtualservice.yml — параметры виртуального сервиса для Istio, заполняется следующими значениями из values.yaml:

virtualService: enabled: false # По умолчанию отключено, включить поставив в значение true gateways: [] # Имена шлюзов и sidecars для маршрутизации hosts: [] # Список хостов, на которые направляется трафик http: # Правила маршрутизации HTTP-трафика - name: reviews-v1-route route: - destination: host: reviews.prod.svc.cluster.local subset: v1

Альтернативный вариант установки DataSpace в OpenShift#

Обязательные параметры для передачи в OpenShift template при установке:

MODULE_NAME— имя модуля.МainDataBasesecretId— имя secret с конфигурацией подключения к Primary БД (см. раздел "Настройка соединения с БД в сервисах DataSpace").FLUENTBIT_IMAGE— ссылка на образ Fluent Bit.

С дополнительными возможностями конфигурации (ресурсами, readiness/liveness probe и прочим) можно ознакомиться в OpenShift template конкретного сервиса в секции parameters.

Примечание

Blue/green развертывание — это метод развертывания, который снижает время простоя и риски за счет запуска двух идентичных производственных сред, называемых

blueиgreen. В любой момент времени только одна из сред является активной (рабочая среда). Активная среда обслуживает весь производственный трафик.

Данное руководство содержит информацию о загрузке Liquibase-скриптов на базу данных, а также проведения blue/green развертывания средствами Istio в ручном режиме.

Необходимо выполнить следующие действия:

Сконфигурировать подключения к базам данных согласно разделу "Настройка соединения с БД в сервисах DataSpace".

Подключиться к OpenShift через OpenShift cli (oc):

oc loginСкачать дистрибутив, который необходимо установить, из Nexus.

Архив дистрибутива содержит:Манифесты (template) OpenShift с сервисами Data (параметры перечислены для Liquibase cli).

Скрипты Liquibase для создания физики в Базе данных (папка db)

Выполнить скрипты Liquibase. Описано в пункте "Ручная проливка Liquibase скриптов на СУБД"

Установку сервисов DataSpace необходимо производить в соответствии с приоритетом. Чтобы узнать приоритеты сервисов, необходимо открыть манифесты (template.yml) в дистрибутиве и найти следующие поля:

apiVersion: template.OpenShift.io/v1 kind: Template labels: app: ${MODULE_NAME} version: dataspace-release-snapshot type: application installPriority: "4" template: dataspace-core-template template_version: v1 deleteLabel: ${MODULE_NAME}Информация о приоритете хранится в labels.installPriority.

Порядок установки: первым устанавливается приложение с меньшим значением installPriority.Необходимо узнать, какая версия установлена на стенд в текущий момент, чтобы правильно переключать нагрузку средствами istio. Текущая версия хранится в yaml deployments в labels.version.

Выполнить команду, где MODULE_NAME: имя устанавливаемого модуля.oc describe deployments --selector app=MODULE_NAME | grep version% oc describe deployments --selector app=dataspace-core-deals-17724333 | grep version template_version=v1 version=develop-17724333-snapshot Selector: app=dataspace-core-deals-17724333,version=develop-17724333-snapshot version=develop-17724333-snapshotСоздать правило маршрутизации DestinationRule, где:

MODULE_NAME — имя устанавливаемого модуля;

blueVersion — версия в текущий момент установленного сервиса (если нет, то создать равным текущей устанавливаемой версии);

greenVersion — версия устанавливаемого сервиса.

apiVersion: networking.istio.io/v1alpha3 kind: DestinationRule metadata: name: dr-${MODULE_NAME} spec: host: svc-${MODULE_NAME} subsets: — name1: oldVersion labels: version: ${blueVersion} — name2: canaryVersion labels: version: ${greenVersion}Данное правило создает два subset, которыми мы сможем в будущем воспользоваться для маршрутизации трафика.

Создать правило маршрутизации VirtualService, где MODULE_NAME — имя устанавливаемого модуля.

apiVersion: networking.istio.io/v1alpha3 kind: VirtualService metadata: name: vs-${MODULE_NAME} spec: exportTo: — . hosts: — svc-${MODULE_NAME} http: — route: — destination1: host: svc-${MODULE_NAME} subset: oldVersion weight: 100 — destination2: host: svc-${MODULE_NAME} subset: canaryVersion weight: 0Данным правилом мы гарантируем, что весь трафик в текущий момент будет идти на blue (рабочую) версию (если она имеется).

Произвести установку сервиса из манифеста (template).

oc process -f имяФайла.yaml -p MODULE_NAME=имяМодуля -p ...(перечисляем все параметры, которые необходимо передать при установке) | oc apply -f -Дождаться успешного развертывания сервиса.

Deployment ready:oc get deployments --selector app=dataspace-core-dealsВывод команды:

NAME READY UP-TO-DATE AVAILABLE AGE dataspace-core-deals-4.0.0 1/1 1 1 3h16mREADY 1/1 означает, что Pods успешно поднялись.

В случае, если Pods долго не переходят в состояние READY необходимо зайти в лог-записи Pod, deployment или event, найти причину и устранить проблемы.

Если проблема не была устранена, произвести удаление установленных объектов deployment, configmap.В случае успешного поднятия всех Pods произвести переключение трафика на green-версию. Применить DestinationRule, где

MODULE_NAME — имя устанавливаемого модуля;

greenVersion — версия устанавливаемого сервиса.

apiVersion: networking.istio.io/v1alpha3 kind: DestinationRule metadata: name: dr-${MODULE_NAME} spec: host: svc-${MODULE_NAME} subsets: — name: oldVersion labels: version: ${greenVersion} — name: canaryVersion labels: version: ${greenVersion}Данная операция исключит из маршрутизации старую blue-версию, сделает рабочей новую установленную версию.

Повторить пункты 5-11 для всех template в поставке.

Автоматизированная сборка и установка сервиса#

Сборка с помощью компонента Build Tools (CIJE)#

Для сборки приложений DataSpace с помощью компонента Build tools (CIJE) продукта Platform V DevOps Tools (DOT) достаточно воспользоваться вложенным в архетип проекта файлом Jenkinsfile. Он будет находиться в корне проекта после его развертывания из архетипа.

Основные шаги для подготовки вашего проекта DataSpace к сборке#

Необходимо создать шаблонный проект одним из двух способов:

локально на машине разработчика;

с помощью задачи в Jenkins.

Создание шаблонного проекта на локальной машине#

При использовании данного способа создания шаблонного проекта предварительно необходимо ознакомиться с документом "Руководство прикладного разработчика" компонента Build tools (CIJE) продукта Platform V DevOps Tools (DOT).

Для создания проекта необходимо выполнить следующие действия:

Осуществить генерацию артефактов согласно инструкциям, описанным в документе "Быстрый старт".

Внимание!

После генерации в проекте необходимо:

подменить файлы модели (model.xml, status.xml (опционально)) в папке model/src/main/resources/model;

удалить модуль демонстрационных тестов model-local-test (в том числе удалить упоминание о нем среди модулей в корневом pom.xml проекта).

Заполнить конфигурационный файл pipeline.yml согласно документации продукта Platform V DevOps Tools (DOT), а также ориентируясь на комментарии в файле. При необходимости можно модифицировать данный файл, добавлять требуемые разделы, разрешенные документацией компонента Build tools (CIJE).

Внимание!

В корне проекта расположен Jenkinsfile, описывающий логику сборки. При необходимости можно модифицировать данный файл, добавлять требуемые разделы, разрешенные документацией компонента Build tools (CIJE).

Во избежание ошибки вида "cp: cannot stat ‘/target/*.jar’: No such file or directory", значение artifactId должно совпадать с именем репозитория, из которого берется jenkinsfile.

После заполнения файла pipeline.yml запустить сборку проекта.

Пример заполнения pipeline.yml#

# Свойства дистрибутива

fp:

groupId: # Область в Nexus

artifactId: "${artifactId}" # КЭ, для которого есть область в репозитории

version: "${version}" # К данному свойству будет добавляться номер сборки. Например, для сборки с номером 123 в Nexus артефакт будет выгружен с версией ${version}-123

# Настройки MAVEN

maven:

settings_id: "MavenSetting" # Id maven settings в Jenkins

jdk: "openjdk-11.0.2_linux" # JDK, настроенный в Jenkins (один на все проекты, меняться не должен)

home: "Maven 3.6.3" # Версия maven

# Использовать ли maven для загрузки дистрибутива в Nexus, по умолчанию — "false",

# Чтобы использовать этот параметр, требуется завести credentials в settings-файле и указать их serverId в Nexus_<...>

use_for_deploy: "true"

# Ссылки на сборочные Jenkins-файлы (берется Jenkinsfile из корня проекта)

jenkinsfiles:

- name: "${artifactId}" # Имя артефакта

repo: # URL без хоста, например, "DSPC/dataspace-client.git". Без .git в конце сборки проходить будут, но не получится пройти проверки sast/oss

branch: # Ветка сборки, например, "develop"

# Настройки NEXUS-central

nexus:

creds: # Id ТУЗ c доступом на чтение из root_url

root_url: "" # Адрес репозитория с артефактами для сборки

# Настройки NEXUS-sbrf

nexus_sbrf:

repository: "" # Имя репозитория

creds: # Id ТУЗ с доступом на запись в root_url

serverId: "" # Идентификатор адреса Nexus из settings.xml

root_url: "" # Корневой URL Nexus

upload_url: "" # URL репозитория в Nexus, в который выгружается дистрибутив

groupId: # Имя загрузочной области в Nexus

artifact: "${artifactId}"

# Настройки сборки Dockerfile

docker:

builder_token: # Id ТУЗ с доступом на запись в Nexus3

registry_address: "" # Имя docker репозитория

nexus_url: # Путь до области с образами

#Настройки dataspace

dataspace:

# Если добавлен параметр, то в dc.yaml будет прописан в явном виде

# Вида {{ registry }}{{ registry_path }}<component_code>/<deployment_unit>@sha256:<hash>

# ВАЖНО! docker.nexus_url должен заканчиваться на /<component_code>

component_code: dspc

# Не должно быть параметризаций образов, если эта секция не закомментирована, в dc.yaml будет прописан константой используемый образ

fluentbitSidecar:

component_code: loga

name: fluent-bit

sha: 2e430ac283dc6d09a5cc2de5eb49b3da42696bd71c272dbe4b4806c66e9e29ec

model:

jpaModelVersion: "" # Указать версию модели в semver, если не задано, то возьмется fp.version

build:

mvnArgs: "-P dbScriptsWithoutOracle" # Если требуется проливка liquibase-скриптов на Oracle, использовать dbScriptsWithOracle, также можно задавать дополнительные аргументы для сборки maven-проекта

# Опциональное добавление зависимостей из списка в дистрибутив

externalDependencies:

# - ucp-corp-events

# - ojdbc8

config:

version: "" # Версия dataspace-bom используемых конфигураций для установки сервисов на стенд, по умолчанию берется текущая версия bom

copyDisribYmlAsIs: false # Копирование distrib.yml из корня проекта без обработки

services: # Ниже перечислены доступные сервисы, которые попадут в дистрибутив, ненужные можно удалить или закомментировать

- dataspace-core

# - dataspace-gigabas

# - dataspace-cr-duplication-service

# - dataspace-cr-migration-service

# - dataspace-cr-state-machine

# - dataspace-subscription

# - dataspace-bundle

ownerId: #Параметр, идентифицирующий потребителя DataSpace. Это может быть, например, ТУЗ, КЭ, rn или какая-то другая строка

docker:

registry_address: "" # Корневой URL docker-registry

nexus_url: "" # Путь от корня к целевой папке

images:

version: "" # Версия, с которой будут браться базовые образы DataSpace, если "" — будут браться образы с версией сервисов из dataspace-bom

versionSuffix: "" # Суффикс версии образа, например, dataspace-bom версии 1.0.0. Если образы сервисов 1.0.0_alt — тогда суффикс будет "_alt"

Сборка шаблонного проекта с помощью Build tools (CIJE)#

Для сборки шаблонного проекта с помощью job Jenkins необходимо:

Осуществить генерацию артефактов согласно инструкциям, описанным в документе "Быстрый старт".

Внимание!

После генерации в проекте необходимо:

подменить файлы модели (model.xml, status.xml (опционально)) в папке model/src/main/resources/model;

удалить подмодуль демонстрационных тестов model-local-test (в том числе удалить упоминание о нем среди модулей в корневом pom.xml проекта).

Создать пустой git-репозиторий и выгрузить в него полученный проект.

Подготовить job Build tools (CIJE) (см. документ "Руководство прикладного разработчика" компонента Build tools (CIJE) продукта Platform V DevOps Tools (DOT)).

Заполнить конфигурационный файл pipeline.yml компонента Build tools (CIJE) (<корень_проекта>/config/ufs/pipeline.yml). При необходимости можно модифицировать данный файл, добавлять требуемые разделы, разрешенные документацией компонента Build tools (CIJE) (см. раздел "Пример заполнения pipeline.yml").

Запустить сборку проекта.

Внимание!

В корне проекта расположен Jenkinsfile, описывающий логику сборки. При необходимости можно модифицировать данный файл, добавлять требуемые разделы, разрешенные документацией компонента Build tools (CIJE).

В pom.xml, находящемся в корне проекта, необходимо изменить Url репозиториев в секции distributionManagement на свои. Данный блок используется на шаге mvn deploy для публикации артефактов.

<distributionManagement>

<repository>

<id>release.repo</id>

<url>url_to_maven_repo</url>

</repository>

<snapshotRepository>

<id>corp-snapshots</id>

<url>url_to_maven_repo</url>

</snapshotRepository>

</distributionManagement>

Обратите внимание, что id в repository должен совпадать с именем самого репозитория, а также для них должен быть прописан server в <корень_проекта>/config/settings.xml.

Важно, чтобы структура проекта соответствовала архетипу. Названия модулей с model-jpa, model-sdk обязательно должны быть следующего вида: имяМодели-model-jpa, имяМодели-model-sdk.

При сборке используются те версии артефактов, которые указаны в используемом dataspace-bom (версия dataspace-bom указывается в корневом pom.xml собираемого проекта).

Важно, чтобы имена модулей совпадали с именами артефактов в dataspace-bom.

Не рекомендуется указывать следующим образом:

имя модуля — "test-service";

artifactId в pom.xml — "mega-test-service";

имя модели в ее xml-описании — "mega-test-model".

Это может привести к ошибкам сборки, так как подключаемая библиотека DevOps может ориентироваться на имена модулей при анализе вашего проекта.

Добавление пользовательских параметров в дистрибутив#

При работе с Platform V DevOps Tools (DOT) может потребоваться дополнительно определить пользовательские параметры в рамках работы с модулями DataSpace. Для этого необходимо создать ConfigMap, например, customer-properties-core.yaml с ключом data customer.properties по пути conf/openshift/dataspace-${module}-${modelName} (например, dataspace-core-deposit) в вашем шаблонном проекте(в качестве примера в шаблонный проект добавлен configMap по пути ./dataspace-core-${modelName}/configmaps/customer-properties-core.yaml). Необходимо определить в нем параметры в формате:

kind: ConfigMap

apiVersion: v1

metadata:

name: customer-properties

data:

customer.properties: |-

dataspace.customer.param1=value1

dataspace.customer.param2={{ customer.value2 }}

Параметризацию параметров можно определить, например, в custom_property.conf.yml, после чего иметь доступ к этой конфигурации в репозитории FP на этапе работы Deploy tools (CDJE):

# custom_property.conf.yml

customer.value2=1000

# ...

Обновление конфигурации#

Примечание

Конфигурации выгружаются из репозитория артефактов (например, Nexus) на основе информации из файла

pom_dependencies.xmlв сформированном на базе архетипа шаблонном проекте.Существует возможность зафиксировать конфигурацию, явно указав в секции

pipeline.yml, какую версию конфигурации использовать:dataspace: config: version: "${CONFIG_BOM_VERSION}"где CONFIG_BOM_VERSION — версия dataspace-bom, для которой будут выгружаться инсталляционные манифесты. При

""по умолчанию будет браться текущая выбранная в pom.xml проекта версия dataspace-bom.

При обновлении версии dataspace-bom для корректной работы манифестов инсталляции необходимо сформировать шаблонный проект из архетипа соответствующей версии и актуализировать следующие папки и файлы:

/conf/**/**

/config/**/**

/Jenkinsfile

/distrib.yml

/modelName-model-jpa/assembly/**

В случае отсутствия из /*-model-jpa/pom.xml необходимо добавить профили dbScriptsWithOracle и dbScriptsWithoutOracle.

Установка с помощью Deploy tools (CDJE)#

При использовании данного способа развертывания по всем возникающим вопросам рекомендуется обращаться к документации компонента Deploy tools (CDJE). Ниже представлен краткий алгоритм действий, необходимых для разворачивания дистрибутива Platform V DataSpace.

Подготовка к установке#

Наличие у пользователя, производящего установку, возможности создания репозиториев в хранилище (например, Git) и доступов в целевые области хранилища дистрибутива (в Nexus).

Наличие технической учетной записи для работы с репозиториями и с целевыми областями в Nexus.

Созданы и проинициализированы следующие Git-репозитории в проектной области с основной веткой master:

Репозитории для работы с pipeline Build tools (CIJE):

pipeline — репозиторий с кодовой базой релизов pipeline (на каждый стенд формируется свой репозиторий (например, ci90000026_dspc_pipeline_ift / ci90000026_dspc_pipeline_lt));

common — репозиторий с глобальными (одинаковыми для всех компонент в рамках одного стенда) переменными среды (на каждый стенд формируется свой репозиторий (например, ci90000026_dspc_common_ift / ci90000026_dspc_common_lt)).

Репозитории с конфигурациями функциональных подсистем, для каждой ФП формируется свой репозиторий (например, для ФП dspc-deposit-client — ci90000026_dspc_dspc-deposit-client_ift / ci90000026_dspc_dspc-deposit-client_lt).

Должны быть сконфигурированы следующие инструменты развертывания:

JOB Service — job обновления (первичная загрузка кода JOB Deploy, обновление кода JOB Deploy при выпуске новых релизов JOB Deploy).

JOB Deploy — job для развертывания дистрибутивов.

После настройки репозиториев pipeline и common через JOB Service необходимо заполнить и зашифровать файл _passwords.conf в репозитории common по пути /ansible:

_passwords.conf — файл, содержащий пароли для баз данных, Kafka и т.д., которые будут использоваться для создания secrets в среде контейнеризации.

Необходимо добавить ФП для развертывания в конфигурационный файл subsystems.json в корне common проекта, например:

...

"DSPC_DEPOSIT_CLIENT": {

"fpi_name": "dspc-deposit-client",

"artifactId": "dspc-deposit-client",

"groupId": "nexusProject/dspc",

"versionFilter": "1.1",

"strict": "false",

"fpType": "fp",

}

...

Необходимо добавить стенд для развертывания в конфигурационный файл multiClusters.json в корне common проекта, например:

"Test1": {

"openshiftCluster" : "https://api.apps.example.com:6443",

"openshiftSATokenCred" : "jenkins_auth_stand_token",

"openshiftProjectName" : "project",

"openshiftAppsDomain" : "apps.example.com",

"openshiftWebConsole" : "https://console-openshift-console.apps.example.com/k8s/cluster/projects",

"openshiftRoutersFQDN" : "1.1.1.1",

"openshiftControlPlane" : "example-controlplanev20",

"openshiftControlPlaneIstiodService" : "istiod-common-install"

}

Где openshiftSATokenCred — созданные реквизиты для входа в Jenkins, содержащие токен подключения к среде контейнеризации (это может быть токен пользователя или ServiceAccount)

Подготовка параметров к установке#

После выполнения всех действий произвести миграцию конфигурационных файлов ФП через playbook MIGRATION_FP_CONF (миграция конфигурационных файлов ФП) в JOB Deploy.

Заполнить конфигурационные файлы по пути conf/config/parameters/ в репозитории ФП в соответствии с окружением стенда. Параметры сгруппированы, указаны комментарии в самих файлах.

Файлы:

model_name.all.conf — в файле собраны параметры из application.properties, общие для всех модулей DataSpace:

Внимание!

Для включения k8s совместимой конфигурации, необходимо указать

dataspace.k8s.configuration.enabled=true.

Название параметра |

Параметр application.properties |

Значение |

Описание |

|---|---|---|---|

common.registry.url |

SPECIFY_REGISTRY_DS_IMAGES_FP_CONF |

Название nexus репозитория |

|

common.registry.project |

SPECIFY_REGISTRY_PROJECT_FP_CONF |

Название nexus проекта с образами DataSpace |

|

common.logger.registry.project |

SPECIFY_REGISTRY_PROJECT_FP_CONF |

Название nexus проекта с образами для журналирования |

|

common.openshift.serviceAccount |

default |

Сервисный аккаунт в среде контейнеризации, под которым выкачиваются образы |

|

common.openshift.namespace |

Название проекта в среде контейнеризации |

||

common.openshift.defaultMode |

256 |

Задание прав доступа для подключаемых сущностей при развертывании приложения в среде контейнеризации |

|

common.model.packagesToScan |

${groupId} |

Определение пакета клиентской модели сервисами DataSpace. Задается автоматически при формировании шаблонного проекта |

|

dataspace.model.name |

${modelName} |

Имя клиентской модели. Задается автоматически при формировании шаблонного проекта |

|

dataspace.jvm-arguments.user.timezone |

Europe/Moscow |

Указание таймзоны контейнерам сервисов DataSpace |

|

dataspace.container.securityContext.runAsNonRoot |

true |

Флаг, при котором все процессы в контейнере не могут запуститься под root |

|

dataspace.container.securityContext.privileged |

false |

Флаг, контролирующий доступ к файловой системе хоста |

|

dataspace.container.securityContext.readOnlyRootFilesystem |

true |

Флаг, ограничивающий файловую систему только на чтение |

|

dataspace.k8s.configuration.enabled |

false |

Флаг, для включения совместимости конфигурации с Kubernetes |

|

dataspace.service.core.enabled |

true |

Флаг, переключающий установку dataspace-core |

|

dataspace.service.gigabas.enabled |

true |

Флаг, переключающий установку dataspace-gigabas |

|

dataspace.service.migration.enabled |

false |

Флаг, переключающий установку dataspace-migration |

|

dataspace.service.duplication.enabled |

false |

Флаг, переключающий установку dataspace-duplication |

|

dataspace.service.statemachine.enabled |

false |

Флаг, переключающий установку dataspace-state-machine |

|

dataspace.service.bundle.enabled |

false |

Флаг, переключающий установку dataspace-bundle |

|

dataspace.service.subscription.enabled |

false |

Флаг, переключающий установку dataspace-subscription |

|

dataspace.main.db.user |

spring.datasource.username |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.main.db.url |

spring.datasource.url |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.main.db.schema |

dataspace.datasource.primary.dbschem |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.main.db.driver |

spring.datasource.driver-class-name |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.main.db.dialect |

spring.jpa.database-platform |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.db.cert.keystore.path |

- |

См. пример в разделе "SSL-конфигурация для DB" |

|

dataspace.standin.db.user |

standin.datasource.username |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.standin.db.url |

standin.datasource.url |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.standin.db.schema |

dataspace.datasource.standin.dbschema |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.standin.db.driver |

standin.datasource.driver-class-name |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.standin.db.dialect |

standin.jpa.database-platform |

См. пример в разделе "Создание secret для базы данных в Kubernetes (или OpenShift)" |

|

dataspace.cci.clusterId |

SHARD-ID |

См. раздел "Настройки подключения к Cross Cluster Index" документа "Интеграция с Cервисом межкластерной индексации" |

|

dataspace.cci.host |

localhost |

См. раздел "Настройки подключения к Cross Cluster Index" документа "Интеграция с Cервисом межкластерной индексации" |

|

dataspace.cci.port |

8080 |

См. раздел "Настройки подключения к Cross Cluster Index" документа "Интеграция с Cервисом межкластерной индексации" |

|

dataspace.plugin.cci.useStubCCIServer |

true |

См. раздел "Настройки подключения к Cross Cluster Index" документа "Интеграция с Cервисом межкластерной индексации" |

|

dataspace.app.journal.stub |

standin.cloud.client.stu |

true |

См. описание в разделе "Отключение репликации и отправки векторов в ПЖ" |

dataspace.app.journal.replication.enabled |

dataspace.replication.enabled |

false |

См. описание в разделе "Отключение репликации и отправки векторов в ПЖ" |

dataspace.app.journal.zoneId |

ZONE-ID |

См. описание в разделе "Этап 3 — создание новой зоны ПЖ" |

|

dataspace.app.journal.bootstrapServers |

standin.cloud.client.kafka.bootstrapServers |

; |

Адреса kafka брокеров ПЖ |

dataspace.app.journal.subscriptionKafkaConcurrency |

standin.cloud.client.subscriptionKafkaConcurrency |

10 |

См. описание в разделе "Настройка параметров применения (DataSpace Applier)" |

dataspace.app.journal.heartBeatPeriod |

standin.cloud.client.heartBeatPeriod |

10000 |

См. описание в разделе "Настройка параметров применения (DataSpace Applier)" |

dataspace.app.journal.kafkaRetry |

standin.cloud.client.kafka-retry |

5 |

См. описание в разделе "Настройка параметров применения (DataSpace Applier)" |

dataspace.app.journal.retryTimeout |

standin.cloud.client.retry-timeout |

10000 |

См. описание в разделе "Настройка параметров применения (DataSpace Applier)" |

dataspace.app.journal.maxAggregatesPerTransaction |

dataspace.replication.max-aggregates-per-transaction |

1 |

См. раздел "Транзакционная граница пакета" документа "Руководство прикладного разработчика" |

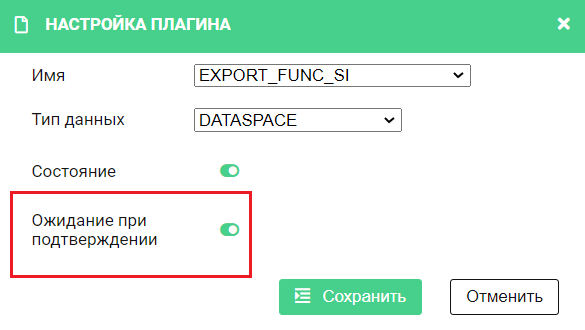

dataspace.app.journal.confirmationMode |

dataspace.replication.confirmation-mode |

confirmed |

См. описание в разделе "Поддержка режима ожидания подтверждения коммита во всех модулях DataSpace" |

dataspace.app.journal.replicator.dataTypeInfo.ORM_CV.serializerId |

dataspace.replicator.data-type-info.ORM_CV.serializer-i |

change_vector_json |

См. описание в разделе "Бинарная сериализация векторов" |

dataspace.app.journal.replicator.model.sendModelId |

dataspace.replicator.model.send-model-id |

true |

См. описание в разделе "Контроль векторов компонента Прикладной Журнал (APLJ) по имени и версии модели" |

dataspace.app.journal.replicator.model.sendModelVersion |

dataspace.replicator.model.send-model-version |

true |

См. описание в разделе "Контроль векторов компонента Прикладной Журнал (APLJ) по имени и версии модели" |

dataspace.app.journal.replicator.model.versioningEnabled |

dataspace.replicator.model.versioning-enabled |

true |

См. описание в разделе "Контроль векторов компонента Прикладной Журнал (APLJ) по имени и версии модели" |

dataspace.app.journal.mode |

dataspace.replication.appjournal-mode |

si |

См. описание в разделе "Настройка режима передачи векторов в ПЖ" |

dataspace.app.journal.ssl.enabled |

false |

См. описание в разделе "SSL-конфигурация для Kafka компонента APLJ" |

|

dataspace.aj.kafka.cert.keystore.path |

- |

См. описание в разделе "SSL-конфигурация для Kafka компонента APLJ" |

|

dataspace.aj.kafka.cert.truststore.path |

- |

См. описание в разделе "SSL-конфигурация для Kafka компонента APLJ" |

|

dataspace.app.journal.ssl.istio.egress.encryption.enabled |

false |

Флаг переключения шифрования на стороне приложения или egress |

|

dataspace.standin.kafka.producerConfig.security.protocol |

standin.cloud.client.kafka.producerConfig."[security.protocol]" |

SSL |

Протокол безопасности для шифрования на стороне приложения |

dataspace.standin.kafka.producerConfig.ssl.keystore.location |

standin.cloud.client.kafka.producerConfig."[ssl.keystore.location]" |

/opt/keystore/kafka/server.keystore_aj.jks |

Путь на pod к хранилищу сертификатов для шифрования на стороне приложения без Hashicorp Vault |

dataspace.standin.kafka.producerConfig.ssl.truststore.location |